说到爬虫,大家可能都知道requests、re、scrapy、selenium等等一些工具库。虽然它低调,但功能非常强大,用于抓取Table表格型数据时,简直是个神器,没有必要去F12研究HTML页面结构甚至写正则表达式解析字段。

#我的Python教程

#微信公众号:wdPython

- pandas.read_html爬虫的步骤:

读取网页:使用pandas的read_html函数读取网页。read_html函数可以从网页中读取多个表格,并将它们存储为DataFrame对象的列表。

解析表格:使用pandas的read_html函数解析表格数据。

2.适用范围:只能爬取,特定含有 Table 结构的网页数据,如下所示。

<table class="..." id="..."><thead><tr><th>...</th></tr></thead><tbody><tr><td>...</td></tr><tr>...</tr><tr>...</tr>...<tr>...</tr><tr>...</tr> </tbody>

</table>

3.pandas.read_html()函数是一个非常方便的函数,可以用于从HTML文件中提取表格数据。常用的参数用法:

io:url、html文本、本地文件等

header:标题行

flavor:解析器

skiprows:跳过的行

attrs:属性,例如:attrs = {‘id’:‘table’}

parse_dates:解析日期

需要注意的是,该函数返回的结果是DataFrame组成的list,需要最后加上一个索引。当网页中含有多个表格时,可以通过指定header参数来选择需要提取的表格。

4.示例源码1:选取百度百科中的世界500强企业表格

import pandas as pd

url = 'https://baike.baidu.com/item/%E4%B8%96%E7%95%8C500%E5%BC%BA?fromModule=lemma_search-box'

df = pd.read_html(io=url, header=0)[1]

print(df)

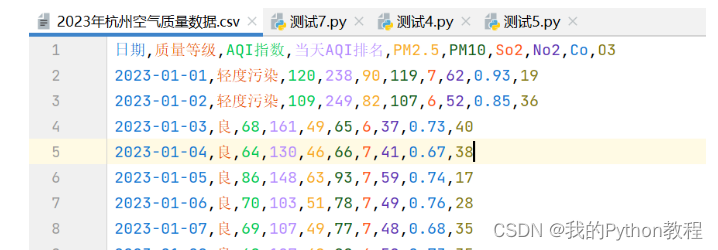

示例源码2:爬取2023年杭州空气质量数据

http://www.tianqihoubao.com/aqi/hangzhou-202301.html

import pandas as pdtime_lists = pd.date_range('20230101', '20231101', freq='MS').strftime('%Y%m') # 构造出日期序列 便于之后构造url

print(time_lists, len(time_lists))

for i in range(len(time_lists)):url = f'http://www.tianqihoubao.com/aqi/hangzhou-{time_lists[i]}.html'print(f'正在下载第{i+1}页数据,{url}'.center(80, '-'))tables = pd.read_html(url, encoding='gbk', header=0)[0]print(tables)# 保存数据,多页数据,避免重复写入header=Falseif i == 0:tables.to_csv('2023年杭州空气质量数据.csv', mode='a+', index=False)else:tables.to_csv('2023年杭州空气质量数据.csv', mode='a+', index=False, header=False)

完毕!!感谢您的收看

----------★★历史博文集合★★----------

我的零基础Python教程,Python入门篇 进阶篇 视频教程 Py安装py项目 Python模块 Python爬虫 Json Xpath 正则表达式 Selenium Etree CssGui程序开发 Tkinter Pyqt5 列表元组字典数据可视化 matplotlib 词云图 Pyecharts

海龟画图 Pandas Bug处理 电脑小知识office自动化办公 编程工具

函数,有什么用法区别)

)

)

)