前言

现实强化学习任务面临的状态空间往往是连续的,无穷多个。

这里主要针对这种连续的状态空间处理。后面DQN 也是这种处理思路。

目录:

1: 原理

2: 梯度更新

3: target 和 预测值

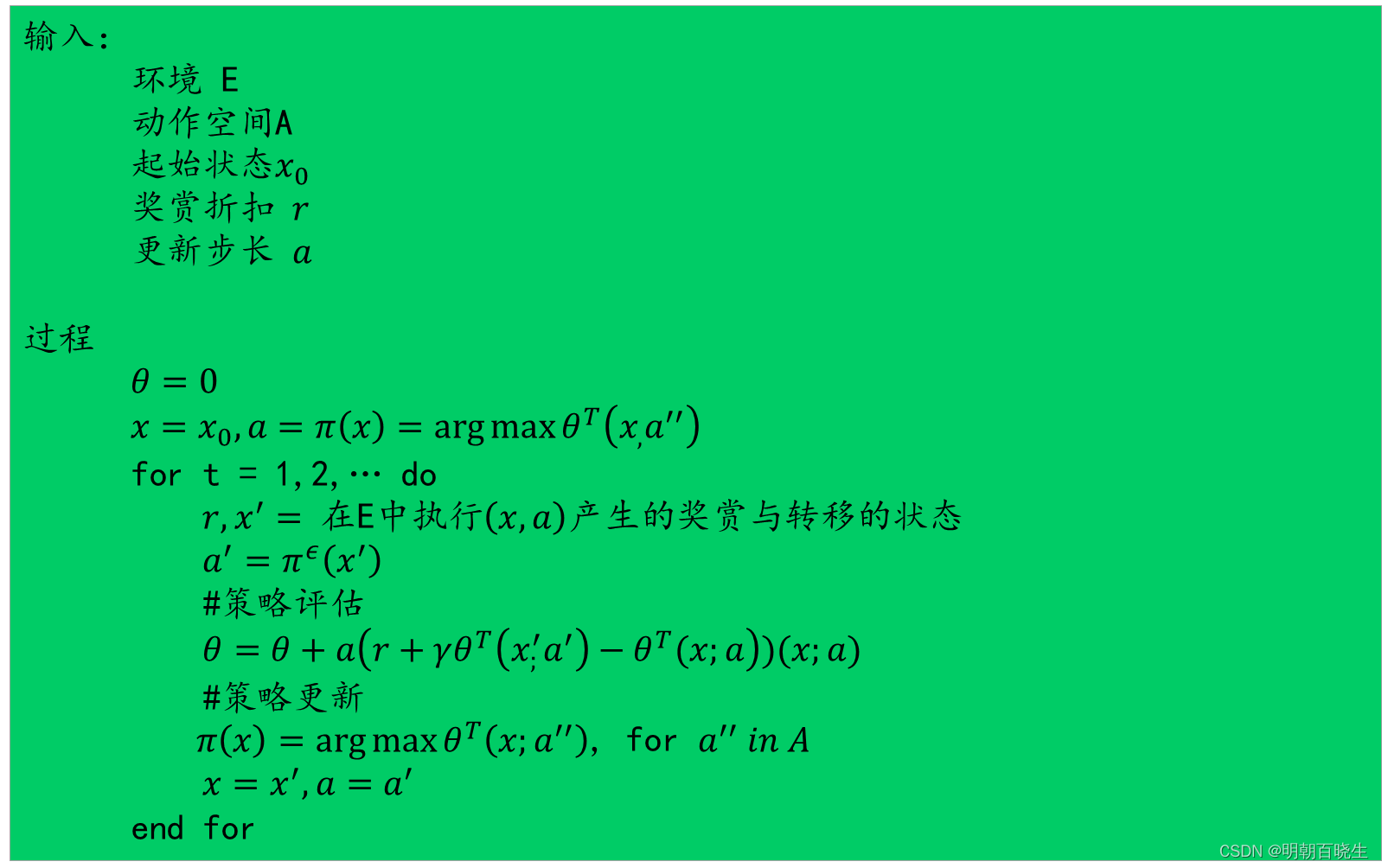

4 流程

一 原理

强化学习最重要的是得到 值函数,或者动作-状态值函数,

根据值函数可以得到最优策略。

当状态空间为连续的时候,表达为状态的线性函数

x:状态向量

: 向量参数

我们希望通过上面公式学得的值函数尽可能接近真实的,近似度经常用最小二乘误差度量

表示由策略采样得到的状态上的期望

二 梯度更新

为了使得误差最小,采用梯度下降法,对误差求梯度导数

于是可得到对于单个样本的更新规则

三 预测值 和 target

我们并不知道策略的真实值函数 ,可以借助时序差分学习,

基于 用当前估计的值函数替代真实的值函数,

则

在时序差分学习中,需要 状态-动作函数以获取策略,这里一种简单的做法

是令 作用于状态和动作的联合向量上,例如给状态向量增加一维用于存放

动作编号,,另一种做法是对动作变量a 进行one-hot 编码,再合并到x.

训练的时候:

预测值:

target:

四 流程

)

向下偏移)

销售出库审核-v))

Centos7下搭建Android开发环境及Android真机调试)

)

)