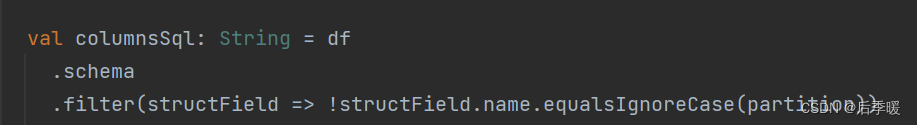

在翻阅一些代码的时候,schema算子好像没碰到过,比较好奇structField这个类型,为什么可以直接用name参数,就翻阅了下资料:

在 Apache Spark 中,DataFrame 是一种分布式的数据集,它是以类似于关系型数据库表的形式组织的分布式数据集合。schema 函数用于获取 DataFrame 的模式(Schema),也就是 DataFrame 中的列和它们的数据类型。

具体而言,schema 函数返回一个 StructType 对象,该对象描述了 DataFrame 的列名和每列的数据类型。StructType 是一个 Spark SQL 中的结构类型,由多个 StructField 组成,每个 StructField 表示 DataFrame 的一列。每个 StructField 包含列名、数据类型和一个标志,指示是否允许该列的值为空。

以下是使用 schema 函数的简单示例:

import org.apache.spark.sql.SparkSessionval spark = SparkSession.builder().appName("example").getOrCreate()// 创建一个简单的 DataFrame

val data = Seq(("Alice", 25), ("Bob", 30), ("Charlie", 22))

val df = spark.createDataFrame(data).toDF("name", "age")// 获取 DataFrame 的模式

val schema = df.schema// 打印模式信息

schema.printTreeString()

在上述示例中,df.schema 返回一个 StructType 对象,该对象描述了 DataFrame 的模式。通过调用 printTreeString() 方法,你可以看到模式的结构,包括列名和数据类型。示例中的输出可能类似于:

root|-- name: string (nullable = true)|-- age: integer (nullable = true)

这表示 DataFrame 有两列,一列名为 "name",数据类型为字符串,另一列名为 "age",数据类型为整数。nullable = true 表示这两列允许为空。

总体而言,schema 函数是了解和验证 DataFrame 结构的有用工具。你可以使用它来检查 DataFrame 中列的名称和数据类型,以确保它们符合预期。

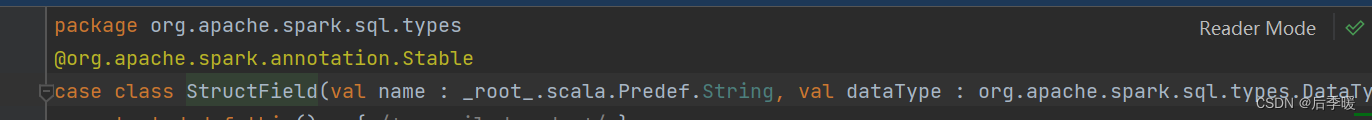

翻阅源码后:

也是发现了这个类的最主要的三个参数:name、dataType、nullable

这也解释了上面疑问的代码:直接可以调用这个(样例)类的name参数

)

)

![[笔记] 错排问题 #错排](http://pic.xiahunao.cn/[笔记] 错排问题 #错排)

)

)

)

)