| 导读 | 英伟达发布了 Windows 版本的 TensorRT-LLM 库,称其将大模型在 RTX 上的运行速度提升 4 倍。 |

GeForce RTX 和 NVIDIA RTX GPU 配备了名为 Tensor Core 的专用 AI 处理器,正在为超过 1 亿台 Windows PC 和工作站带来原生生成式 AI 的强大功能。

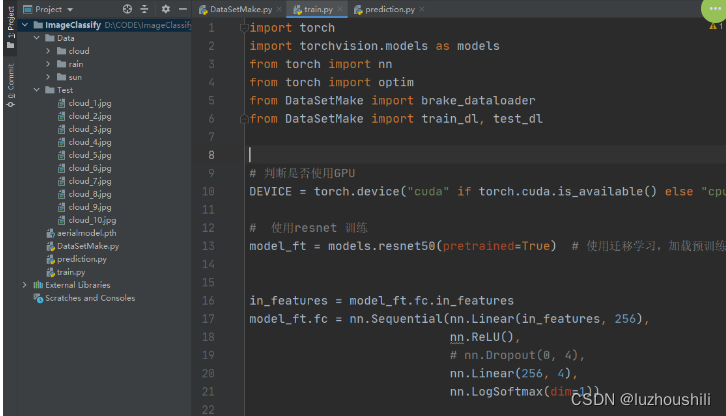

TensorRT-LLM 是一个开源库,用于提升上述 GPU 运行最新 AI 大模型(如 Llama 2 和 Code Llama)的推理性能。上个月英伟达发布了面向数据中心的 TensorRT-LLM,现在最新发布的 TensorRT-LLM for Windows 主要是面向家用电脑,将 PC 上运行 LLM 的速度提高了 4 倍。

英伟达还同时发布了帮助开发人员加速 LLM 的工具,包括使用 TensorRT-LLM 优化自定义模型的脚本、TensorRT 优化的开源模型以及展示 LLM 响应速度和质量的开发人员参考项目。