这是一篇来自Samaya AI的文章,主要介绍了其 CTO 在 Meta AI's FAIR labs 工作发表在 nature 上的一篇论文成果,用于验证和改进维基百科上的引用来源。我做了一些精选和整理,分享给大家:

研究背景

几千年来,人类一直在创造知识。计算机的出现把知识数字化了,而互联网的出现使其可以被更容易获取,从而促进了进一步的知识创造。

搜索引擎极大地增加了我们在日常决策中可以使用的信息的广度和可访问性,远远超出了纸质书籍和传统图书馆的限制。

然而,获得大量知识并不能让我们无所不知——理解这些知识仍然极其困难且耗时。

研究人员仍然需要阅读文献、写笔记、在头脑中将各个点联系起来。知识工作者需要多年的经验、研究和阅读才能发现新颖的关联。此外,由于不同的信息可能相互冲突,并且必须理解并追溯到其原始来源,因此该过程变得复杂。

论文

Improving Wikipedia verifiability with AI

研究表明,构建机器来帮助人类导航、解释和验证世界知识在今天是可以实现的。

维基百科是地球上使用最广泛的知识集合之一,在志愿者和专家编辑的支持下,这是一项令人难以置信的集体努力。

维基百科是可验证的,信息来源有大量的引用支持,以便“使用百科全书的人可以检查信息是否来自可靠的来源”。

然而,确保维基百科的可验证性的任务是艰巨的。专家编辑目前依靠志愿者的工作,截至目前,维基百科上有超过 500,000 条语句被标记为“需要引用”。

在论文中,作者展示了机器可以协助编辑完成引用的校对和建议——

发现有问题的引用并提高其可验证性。

SIDE

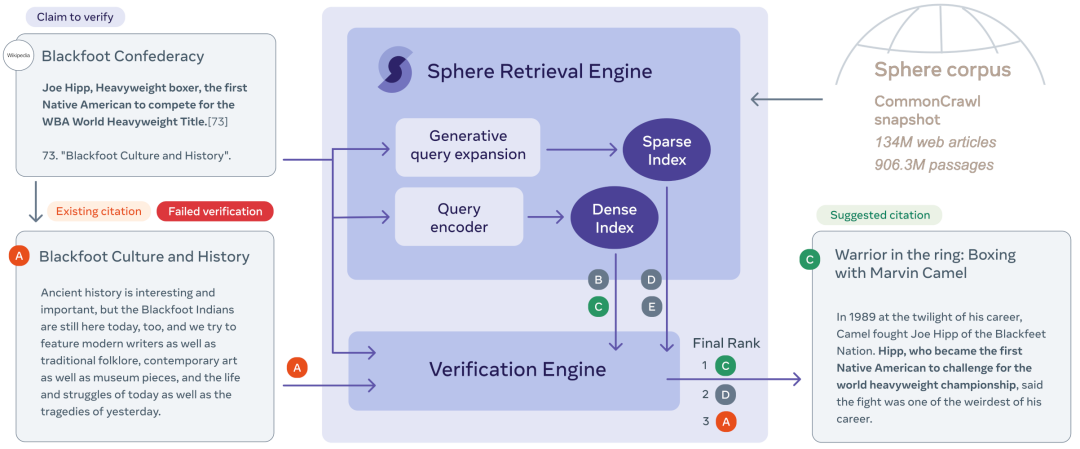

一种基于人工智能的系统,旨在提高Wikipedia引用的可验证性。通过使用信息检索系统和语言模型,SIDE可以识别Wikipedia引用中不太可能支持其主张的引用,并从网络中推荐更好的引用。

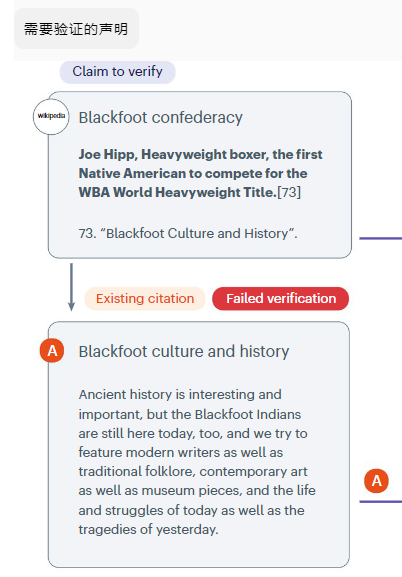

1/ 需要验证的引用

SIDE 利用专门的语言模型来评估维基百科的声明-引文对,分配可验证性分数并识别潜在的证据不足。

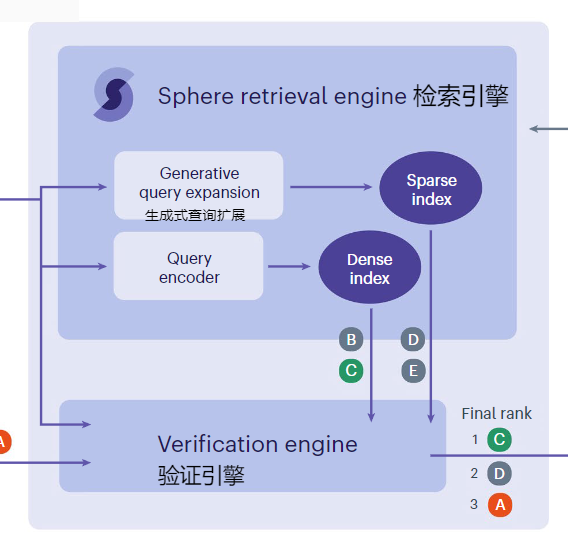

2/ 检索引擎

它配备了一个检索引擎,能够提取上下文中的维基百科声明,并在网络规模的“Sphere”语料库中搜索替代来源。

3/ 建议的引用

SIDE 会标记可验证性较低的声明,并建议替代来源,从而可能指导编辑的内容管理过程。

SIDE 展示了强大能力,它不仅可以识别这些差异,而且当声明被认为可能无法验证时,维基百科用户通常更喜欢系统建议的引用,而不是原始维基百科的引用。

社群交流通道:

原文:

https://samaya.ai/blog/

https://www.nature.com/articles/s42256-023-00726-1

https://github.com/facebookresearch/side/tree/main/projects/verify_wikipedia

)

)

-多段音频顺序播放的设置)

图形复制、移动、删除)

)