从2017年google brain提出transformer模型,到2018年基于transformer模型open ai推出了gpt1模型以及google推出了bert模型,到2019-2021年open ai陆续推出gpt2和gpt3,再到2022-2023年推出chat-gpt和gpt4,大语言模型已经发展成了一个具有3个大分支的参天大树[LLM:大语言模型]。在这里主要写写关于gpt的那些事。

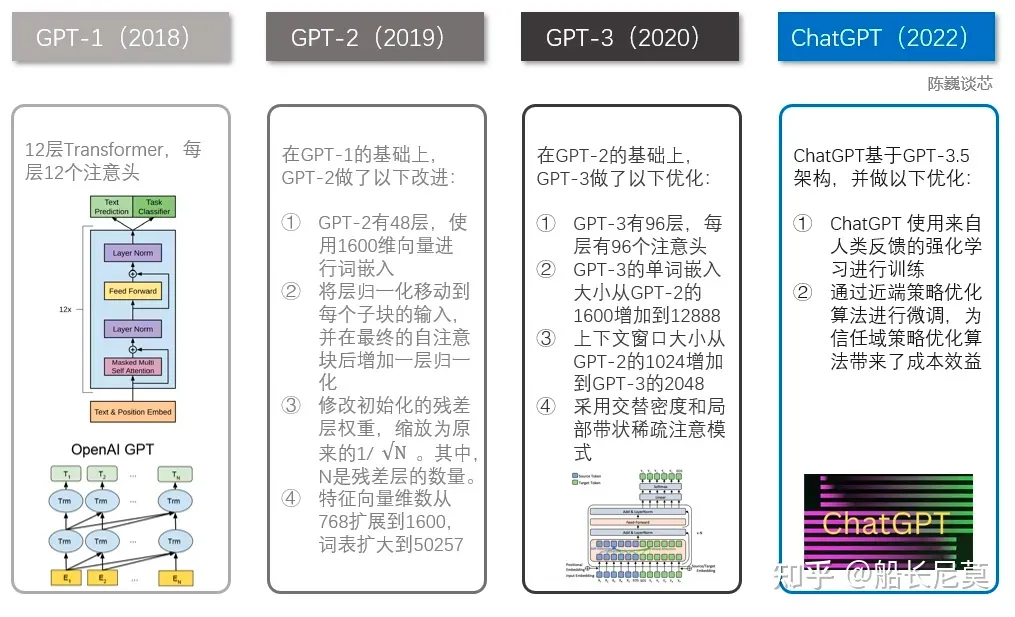

GPT-1到GPT-3到ChatGPT

各GPT的技术路线:

各GPT的模型大小:

| 模型 | 发布时间 | 参数量 | 预训练数据量 |

|---|---|---|---|

| GPT | 2018 年 6 月 | 1.17 亿 | 约 5GB |

| GPT-2 | 2019 年 2 月 | 15 亿 | 40GB |

| GPT-3 | 2020 年 5 月 | 1,750 亿 | 45TB |

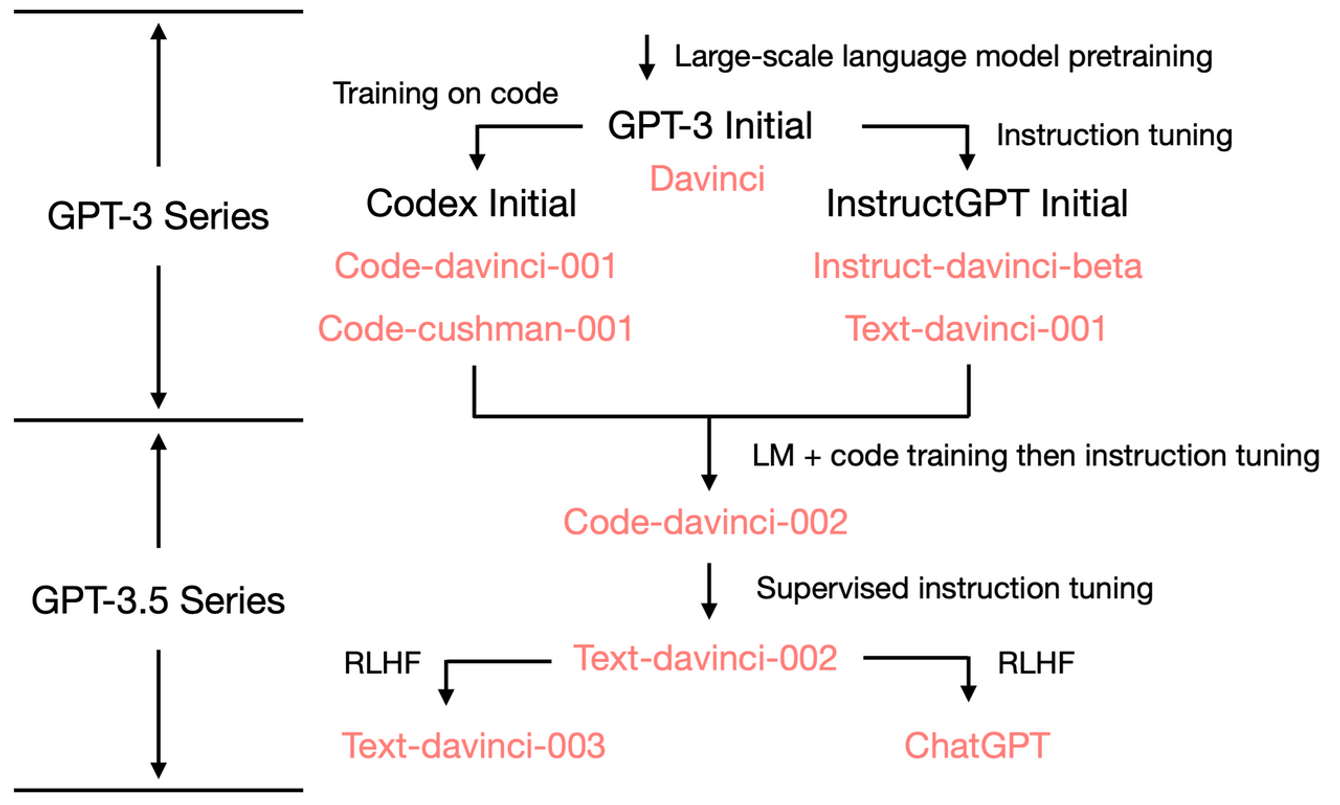

GPT-3.5 的进化树:

GPT-1、GPT-2和GPT-3模型

参考[GPT-1、GPT-2和GPT-3模型详解]

codex

[论文:Evaluating Large Language Models Trained on Code]

InstructGPT

[论文:Training language models to follow instructions with human feedback]

from:-柚子皮-

ref:

)

)

)

)

decoration)

官方文档下载)

:TileMap使用)