名人说:人生如逆旅,我亦是行人。 ——苏轼《临江仙·送钱穆父》

创作者:Code_流苏(CSDN)(一个喜欢古诗词和编程的Coder😊)

上一篇:AI知识补全(七):AI Agent 智能代理是什么?

目录

- 一、多模态大模型概述

- 1. 什么是多模态

- 2. 多模态大模型的定义

- 3. 多模态大模型与传统LLM的区别

- 二、多模态大模型的工作原理

- 1. 多模态数据的处理流程

- 2. 跨模态对齐技术

- 3. 多模态理解与生成

- 三、多模态大模型的架构

- 1. 常见架构类型

- 2. 代表性多模态大模型介绍

- 3. 模型训练方法与挑战

- 四、多模态大模型的应用场景

- 1. 图像理解与描述

- 2. 视频分析与处理

- 3. 多模态搜索与推荐

- 4. 辅助创作与内容生成

- 5. 医疗与健康

- 6. 3D与空间计算

- 五、多模态大模型性能对比

- 六、多模态大模型的发展趋势与挑战

- 1. 技术发展趋势

- 2. 面临的挑战

- 3. 未来研究方向

- 七、小结:多模态,百花齐放的时代

很高兴你打开了这篇博客,更多AI知识,请关注我、订阅专栏《AI大白话》,内容持续更新中…

一、多模态大模型概述

1. 什么是多模态

在人工智能领域,多模态(Multimodality)指的是同时处理和理解多种不同类型数据的能力。就像人类能够同时理解看到的图像、听到的声音和阅读的文字一样,多模态AI系统也能够处理多种感知输入。常见的模态包括:文本、图像、音频、视频和结构化数据。

2. 多模态大模型的定义

多模态大模型(Multimodal Large Language Models, MLLMs)是指能够同时处理、理解和生成多种模态数据的大规模深度学习模型。与仅处理单一模态(如纯文本)的传统大语言模型(LLMs)不同,多模态大模型能够接收图像、音频等多种输入,理解它们之间的联系,并生成跨模态的响应。

2024年最新的多模态大模型包括:GPT-4o、Claude 3.5 Sonnet、Gemini 1.5 Pro、LLAVA-Next和国产的腾讯混元视觉大模型等。这些模型不仅能够处理文本,还能分析图像内容,一些高级版本甚至可以理解视频、音频和3D空间数据 。

3. 多模态大模型与传统LLM的区别

| 特性 | 传统LLM | 多模态大模型 |

|---|---|---|

| 处理数据类型 | 主要处理文本 | 处理文本、图像、音频、视频等多种数据 |

| 输入形式 | 文本提示 | 文本提示、图像、音频等混合输入 |

| 应用范围 | 文本生成、问答、翻译等 | 图像理解、跨模态问答、视觉创作等 |

| 模型复杂度 | 相对简单 | 更为复杂,需要处理跨模态对齐 |

| 计算资源 | 较低 | 更高,需要处理多模态特征提取 |

| 训练数据 | 主要为文本 | 包括大量图文对、视频等多模态数据 |

| 上下文窗口 | 较小 | 部分模型支持超长上下文(如Gemini 1.5支持200万tokens)。 |

二、多模态大模型的工作原理

1. 多模态数据的处理流程

多模态大模型处理不同类型数据的流程大致可分为以下几个步骤:

基于最新的研究进展 ,多模态大模型的数据处理流程包含以下关键步骤:

-

特征提取:各模态通过专门的编码器(Encoder)提取特征

- 文本通过文本编码器(如Transformer)提取语义特征

- 图像通过视觉编码器(如ViT, Vision Transformer)提取视觉特征

- 音频通过音频编码器提取声学特征

- 视频通过视频编码器处理时序和空间特征

- 3D/空间数据通过空间编码器提取立体结构特征 。

-

跨模态对齐:将不同模态的特征投影到共享的语义空间,这可以通过以下方式实现:

- 令牌级对齐:将视觉、音频等特征转换为与文本token兼容的表示

- 特征级融合:在深层次上融合不同模态的特征表示

- 表示统一:构建统一的多模态表示空间

-

多模态理解与推理:基于融合后的表示进行理解和推理,包括:

- 多模态上下文学习(M-ICL):类似于文本模型的上下文学习能力

- 多模态思维链(M-CoT):引导模型进行逐步的推理

- 视觉辅助推理(LAVR):利用视觉信息辅助逻辑推理

-

输出生成:根据理解结果生成相应的输出(文本、图像等)

2. 跨模态对齐技术

跨模态对齐是多模态大模型的核心技术之一,目前主流的对齐方法包括 :

-

对比学习(Contrastive Learning):让相关的多模态数据表示相互靠近,不相关的数据表示相互远离,如CLIP(Contrastive Language-Image Pretraining)模型

-

联合嵌入(Joint Embedding):将不同模态的数据映射到同一向量空间

-

注意力机制(Attention Mechanism):使用注意力机制实现不同模态间的信息交互

-

预训练-微调范式(Pretrain-Finetune Paradigm):先在大规模多模态数据上预训练,再在下游任务上微调

-

部分LoRA微调(PLoRA):如InternLM-XComposer2模型提出的对齐方法,将额外的LoRA参数应用于图像token,以保持预训练语言知识的完整性 。

3. 多模态理解与生成

多模态大模型不仅能理解多种模态的输入,还能生成相应的输出:

-

多模态理解:模型能够理解图像内容并回答关于图像的问题,识别图像中的物体、场景和活动

-

跨模态生成:根据一种模态生成另一种模态的内容,如根据文本描述生成图像、根据图像生成文本描述等

-

多模态对话:在对话中同时处理文本和图像,实现更自然的人机交互

-

多模态空间推理:最新的研究如CAD-GPT实现了空间推理增强,能够理解和生成3D空间中的内容 。

三、多模态大模型的架构

1. 常见架构类型

多模态大模型主要有以下几种架构类型 :

- 双塔架构(Dual-Encoder Architecture,CLIP-style)

- 分别使用独立的编码器处理不同模态

- 适合对比学习任务,如CLIP模型

- 优点:模型结构简单,训练高效

- 缺点:模态间交互有限

- 融合架构(Fusion Architecture,LLaVA-style)

- 先分别编码各模态,再进行特征融合

- 融合方式包括:早期融合、晚期融合和混合融合

- 代表模型:ViLBERT, LXMERT, LLaVA

- 优点:能够有效捕捉跨模态信息

-

端到端架构(End-to-End Architecture,Flamingo-style)

- 将不同模态的输入统一处理,如将图像转化为"视觉词元"

- 代表模型:Flamingo, GPT-4V

- 优点:能够处理更复杂的跨模态任务

-

专家架构(Mixture-of-Experts Architecture,MoE-style)

- 使用专门的"专家"子网络处理不同类型的模态或任务

- 代表模型:MM1, MoE-LLaVA

- 优点:在不增加计算成本的情况下扩大总参数量,提高性能 。

2. 代表性多模态大模型介绍

目前主流的多模态大模型包括(2024年最新):

- GPT-4o(OpenAI):2024年5月发布,支持实时视觉、音频和文本交互,多模态能力全面提升 。

- Claude 3.5 Sonnet(Anthropic):2024年6月发布,在多项基准测试中表现优于GPT-4o和Gemini 1.5 Pro 。

- Gemini 1.5 Pro(Google):支持200万token的超长上下文,能够处理长视频和大量文档 。

-

LLaVA-Next(开源):基于Vicuna/Mistral大语言模型的高性能开源视觉语言模型

-

CogVLM(智源):中文开源视觉语言模型,擅长视觉理解和生成

-

腾讯混元视觉:在SuperCLUE-V中文多模态榜单中排名第一,超越一些国际大模型 。

-

百度文心一言:支持多模态理解与生成的中文大模型

3. 模型训练方法与挑战

多模态大模型的训练通常分为三个阶段 :

-

预训练(Pretraining):

- 在大规模多模态数据上进行预训练

- 训练目标通常是自回归的下一个token预测

-

指令微调(Instruction Tuning):

- 使模型理解和执行用户的指令

- 多模态指令数据包括指令、输入和输出

- 数据收集方法包括:人工标注、模型合成和数据增强

-

对齐微调(Alignment Tuning):

- 减少模型生成内容中的"幻觉"现象

- 常用方法包括:强化学习与人类反馈(RLHF)和直接偏好优化(DPO)

主要挑战:

- 多模态幻觉问题:模型生成与输入不一致的内容

- 跨模态对齐难题:不同模态数据具有不同结构特性,难以精确对齐

- 高质量多模态数据稀缺:获取高质量配对数据困难

- 计算资源需求巨大:训练成本比纯文本模型高出数倍

四、多模态大模型的应用场景

1. 图像理解与描述

- 图像问答(Visual Question Answering, VQA):回答关于图像内容的问题

- 图像描述生成(Image Captioning):自动生成描述图像内容的文本

- 视觉推理(Visual Reasoning):分析图像中物体之间的关系和逻辑

应用示例:

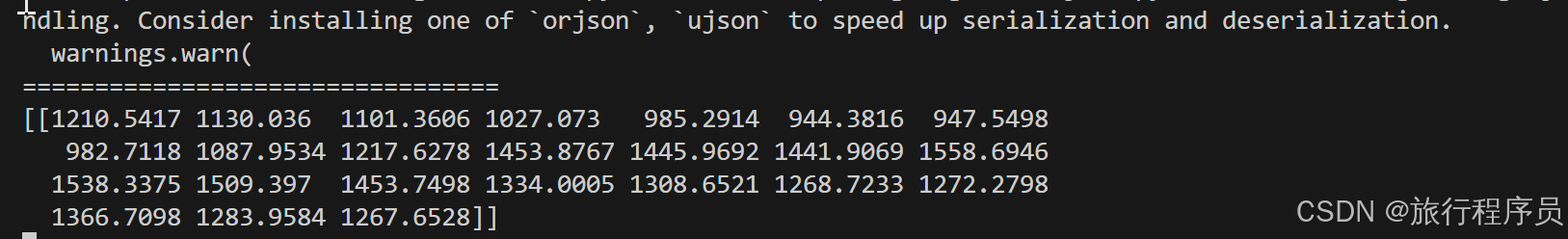

# 使用多模态模型进行图像描述生成

from transformers import AutoProcessor, AutoModelForCausalLM

import torch

from PIL import Image# 加载模型和处理器

processor = AutoProcessor.from_pretrained("microsoft/git-base")

model = AutoModelForCausalLM.from_pretrained("microsoft/git-base")# 加载图像

image = Image.open("example_image.jpg")# 处理图像

pixel_values = processor(images=image, return_tensors="pt").pixel_values# 生成图像描述

generated_ids = model.generate(pixel_values=pixel_values, max_length=50)

generated_caption = processor.batch_decode(generated_ids, skip_special_tokens=True)[0]

print(generated_caption)

2. 视频分析与处理

- 视频内容理解:理解视频中的场景、活动和事件

- 视频问答:回答关于视频内容的问题

- 行为识别:识别视频中人物的行为和动作

- 视频摘要生成:自动生成视频内容的文字摘要

现代多模态大模型如Gemini 1.5能够分析长达数小时的视频,并且能够从视频中"捞针"找出特定的帧和内容 。

3. 多模态搜索与推荐

- 图像搜索:根据文本描述搜索相关图像

- 跨模态检索:使用一种模态搜索另一种模态的内容

- 多模态推荐系统:基于用户的多模态交互行为进行个性化推荐

4. 辅助创作与内容生成

- 文字创作辅助:基于图像生成相关的文本内容

- 图像编辑与生成:根据文本描述生成或编辑图像

- 多媒体内容创作:协助创作者生成多种形式的内容

5. 医疗与健康

- 医学影像分析:辅助医生分析X光片、CT、MRI等医学影像

- 健康记录理解:整合患者的多模态数据进行全面分析

- 医患沟通辅助:通过分析语音、图像等多种模态提升医患沟通

6. 3D与空间计算

- CAD模型生成:如CAD-GPT可以根据文本描述或图像生成3D模型 。

- 空间规划设计:帮助设计师进行空间规划和设计

- AR/VR内容创建:为增强现实和虚拟现实应用创建内容

五、多模态大模型性能对比

2024年主流多模态大模型能力对比表

| 模型名称 | 视觉理解能力 | 推理能力 | 编程能力 | 上下文窗口 | 特殊能力 |

|---|---|---|---|---|---|

| GPT-4o | 通用视觉理解方面表现出色 | 在数学和计算机科学等科目表现突出,具有较强的复杂推理能力 | 在多步骤编程任务中表现出色 | 未公开具体数值 | 多模态交互能力强 |

| Claude 3.5 Sonnet | 在细粒度视觉分析上有优势 | 在GPQA和MMLU Pro等推理基准测试上超越Gemini 1.5 Pro | - | 支持200K token上下文窗口,接受超过100万token输入 | 高质量多模态响应 |

| Claude 3.5 Haiku | - | - | 在SWE-bench Verified上得分率达40.6%,超过Claude 3.5 Sonnet和GPT-4 Turbo | 支持200K token上下文窗口 | 小型模型中的高性能表现 |

| Gemini 1.5 Pro | - | 在比较数字大小等基础数学任务上表现更稳定 | - | 支持长达200万token的上下文窗口,远超其他模型 | 处理长视频和从视频中找出特定帧表现突出 |

| 腾讯混元视觉 | 在中文视觉理解方面表现突出,在SuperCLUE-V榜单上超越一些国际大模型 | - | - | - | 中文多模态理解优势明显 |

| CAD-GPT | - | - | - | - | 在3D建模和空间推理方面有特殊优势 |

2024年,各大厂商竞相发布和更新多模态大模型,不同模型在各个方面表现各有特色 :

-

视觉理解能力:

- GPT-4o在通用视觉理解方面表现出色

- Claude 3.5 Sonnet在细粒度视觉分析上有优势

- 腾讯混元视觉在中文视觉理解方面表现突出,在SuperCLUE-V榜单上超越一些国际大模型

-

推理能力:

- GPT-4o在数学和计算机科学等科目表现突出,具有较强的复杂推理能力

- Claude 3.5 Sonnet在GPQA和MMLU Pro等推理基准测试上超越Gemini 1.5 Pro

- Gemini 1.5 Pro实验版本(0801)在比较数字大小等基础数学任务上表现更稳定

-

编程能力:

- Claude 3.5 Haiku在SWE-bench Verified上的得分率达到40.6%,超过原来的Claude 3.5 Sonnet和GPT-4 Turbo

- GPT-4o在多步骤编程任务中表现出色

-

上下文窗口:

- Gemini 1.5系列支持长达200万token的上下文窗口,远超过其他模型

- Claude 3.5系列支持200k token的上下文窗口,并接受超过100万token的输入

-

特殊能力:

- CAD-GPT等专业模型在3D建模和空间推理方面有特殊优势

- Gemini 1.5在处理长视频和从视频中找出特定帧方面表现突出

这种百花齐放的发展态势正推动多模态AI技术在各个应用场景中的落地和优化,用户可以根据具体需求选择最适合的模型。

六、多模态大模型的发展趋势与挑战

1. 技术发展趋势

-

更广泛的模态支持:扩展到更多模态,如触觉、3D数据等

-

更深层次的模态融合:实现更深入的跨模态理解和关联

-

多模态预训练方法创新:开发更有效的预训练方法和任务

-

小样本/零样本学习能力增强:提高模型在新任务上的快速适应能力

-

超长上下文理解:模型上下文长度持续增长,Gemini 1.5已支持200万tokens,未来有望进一步扩展 。

-

降低算力成本:如DeepSeek V3展示了高效训练方法,大幅降低了训练成本 。

2. 面临的挑战

-

多模态幻觉问题:模型可能生成与输入不一致的内容或产生"幻觉"

-

模态对齐难题:不同模态的数据具有不同的结构和特性,实现精确对齐仍然具有挑战

-

计算资源需求:多模态模型需要更多的计算资源进行训练和推理

-

多模态数据获取:高质量、大规模的多模态配对数据相对稀缺

-

模型评估标准:缺乏统一的多模态模型评估标准和基准

3. 未来研究方向

七、小结:多模态,百花齐放的时代

多模态大模型作为AI领域的前沿技术,正在迅速发展并改变我们与智能系统交互的方式。2024年已成为多模态AI真正爆发的元年,各大厂商纷纷推出或更新自己的多模态大模型,如GPT-4o、Claude 3.5 Sonnet、Gemini 1.5 Pro等,国内的腾讯混元视觉也在某些中文测评中表现出色。

从技术角度看,多模态大模型的核心挑战在于如何有效地实现跨模态对齐和融合,以及如何在有限的计算资源条件下处理大规模多模态数据。未来,随着计算能力的提升和算法的优化,多模态大模型将在更多领域展现出强大的应用潜力。

多模态能力是通往通用人工智能的重要路径。通过同时处理文本、图像、音频、视频等多种模态数据,这些模型能够提供更接近人类认知方式的交互体验。

对于开发者和研究者来说,掌握多模态大模型的基本原理和应用方法,将有助于开发更智能、更自然的人机交互系统,推动人工智能向着更通用、更全面的方向发展。

希望本文对您了解多模态大模型有所帮助!欢迎在评论区留言讨论,也欢迎关注本系列的后续内容。

创作者:Code_流苏(CSDN)(一个喜欢古诗词和编程的Coder😊)