查询增强

1.假设性问题

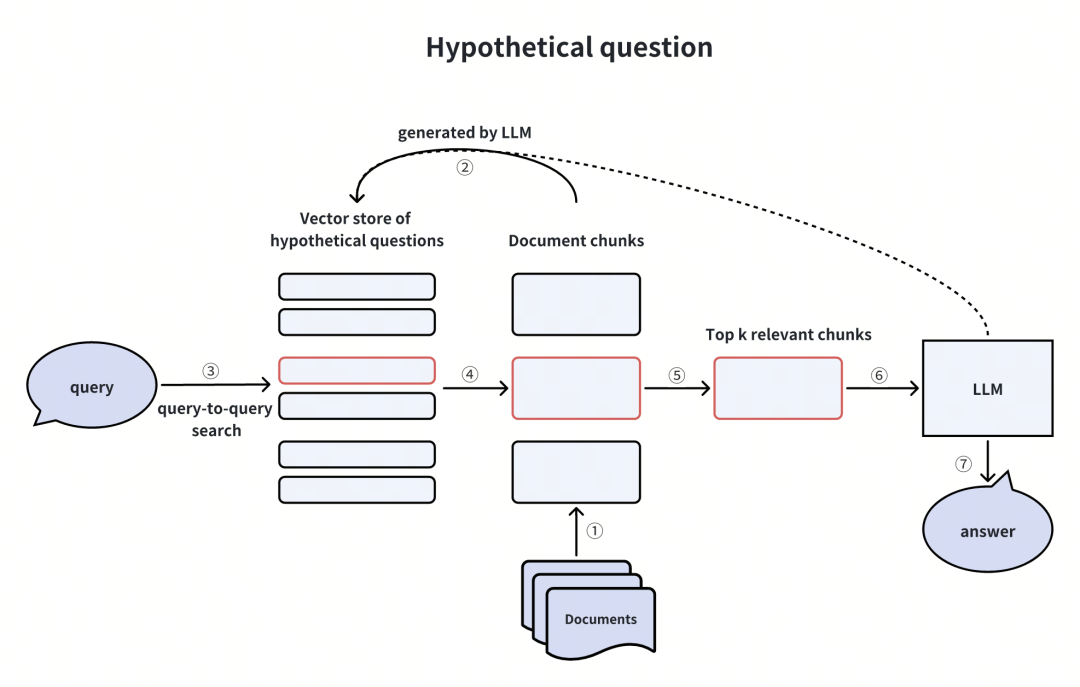

这一方法首先使用LLM为每一条文档块生成一些假设问题,这些文档块可以回答与之对应的假设问题。在RAG阶段,进行一个query-to-query的搜索,先搜索到相关的假设问题,然后找到对应的文档块,再通过它们生成最后的回答。

这里的query-to-query指的是embedding模型的训练方式,训练一个query-to-query模型实际就是训练比较句子的相似性,而不是训练Q-A pair的相似性。所以它是一种对称的“域内(in-domain)”的训练模式,这种方式比不对称的“跨域(out-of-domain)”训练方式会稍微容易且直观一点。

这一方法绕过了在embedding搜索过程中的跨域不对称性,使用query-to-query的直接搜索,减轻了对embedding搜索的要求。但也引入了额外的生成假设问题的开销和不确定性。

额外的开销包括LLM生成假设问题的经济成本,时间成本。不确定性就是和可能的生成的不匹配的问题,或LLM的幻觉导致不懂装懂生成了错误的问题,或系统问题(如LLM网络访问出错)。

)

(JAVA语法))

)