大型语言模型(LLM)在自然语言处理(NLP)任务中展现出了前所未有的能力,但它们对计算资源的巨大需求限制了其在资源受限环境中的应用。SparQ Attention算法提出了一种创新的方法,通过减少注意力机制中的内存带宽需求,显著提高了LLM的推理效率。本文将介绍SparQ Attention的原理、实现和评估,并探讨其在实际应用中的潜力。

SparQ Attention算法通过优化注意力机制,减少了内存带宽的使用,同时保持了模型的性能。

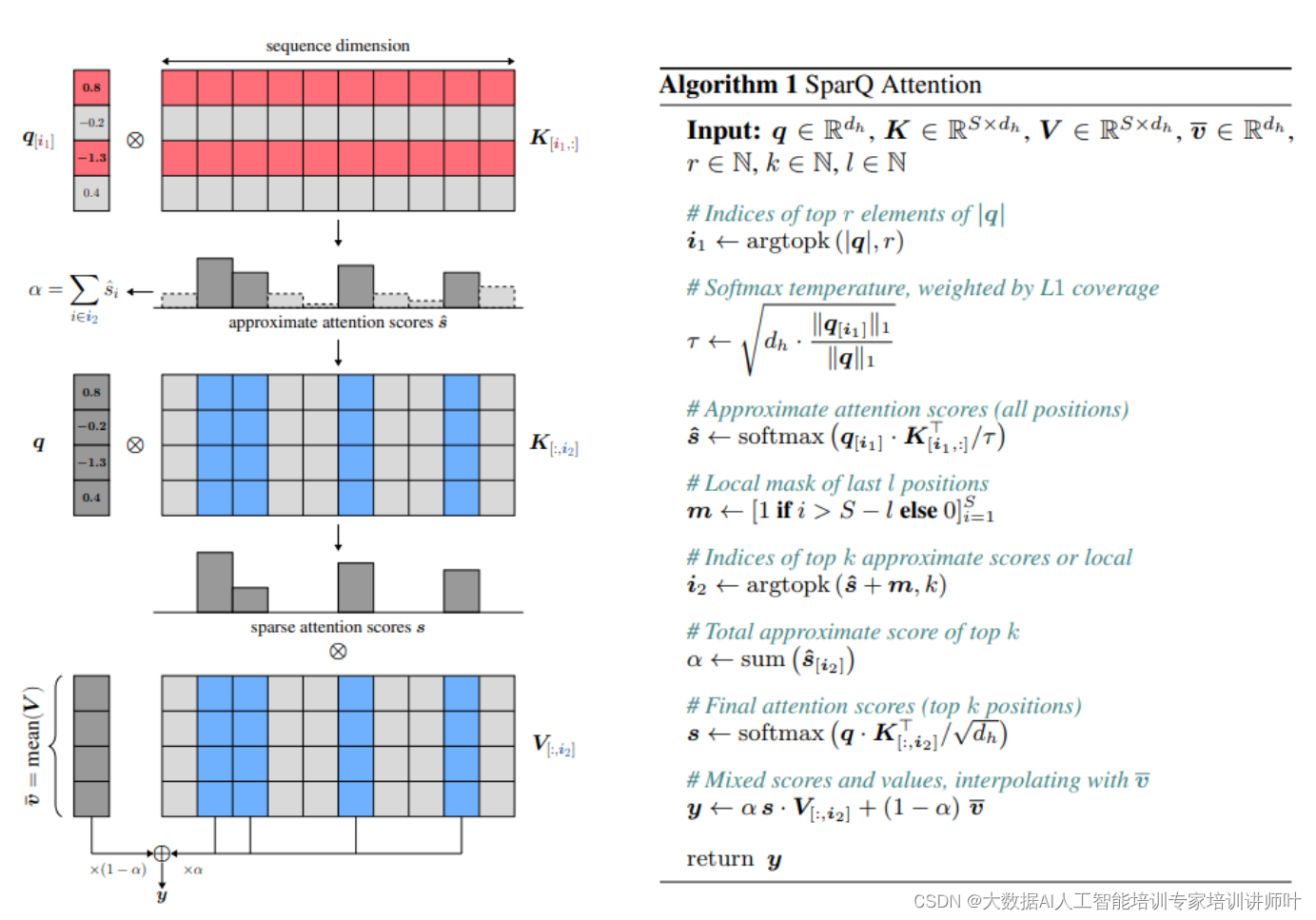

1、SparQ Attention算法原理:

SparQ Attention算法是一种针对大型语言模型(LLM)推理过程中内存带宽需求高的问题提出的优化方法。该算法的核心原理基于注意力机制中的两个关键观察:首先,softmax函数的输出通常由少数几个分量主导,而大多数分量的值接近于零;其次,通过稀疏化查询向量,可以预测出具有最高注意力分数的tokens,从而减少对完整key矩阵的访问需求。

以下是SparQ Attention算法原理的详细阐述:

1. 注意力机制与Softmax函数的特性

在传统的注意力机制中,计算注意力分数通常涉及以下步骤:

- 使用查询(Query, Q)、键(Key, K)和值(Value, V)矩阵计算注意力分数。

- 通过softmax函数对注意力分数进行归一化处理,以获得每个位置的注意力权重。

- 使用归一化的注意力权重加权求和对应的值(V)矩阵,得到最终的输出。

Softmax函数的输出特性表明,对于大多数输入,其输出主要集中在少数几个元素上,而其他元素的输出接近于零。这一特性为SparQ Attention算法提供了优化的切入点。

2. SparQ Attention算法的三个步骤

SparQ Attention算法通过以下三个步骤实现内存带宽需求的减少:

步骤1:近似注意力分数的计算

- 稀疏化查询向量:算法首先对查询向量Q进行稀疏化处理,仅保留其r个最大幅度分量。这一过程通过选择Q中绝对值最大的r个元素来实现。

- 选择性获取key矩阵:根据稀疏化的查询向量,算法仅获取key矩阵K中与这些最大幅度分量对应的行,而不是获取完整的K矩阵。

- 计算近似注意力分数:使用稀疏化的查询向量和选择性获取的key矩阵计算近似注意力分数。

步骤2:获取top-k注意力位置

- 确定top-k位置:在计算得到的近似注意力分数中,找到前k个具有最高注意力分数的位置。

- 获取完整的key和value:对于这k个位置,算法会获取对应的完整key和value向量,以便进行精确的注意力计算。

步骤3:插值与输出

- 计算精确的注意力输出:使用步骤2中获取的完整key和value向量,通过传统的注意力计算方法计算精确的注意力输出。

- 估计总分数并插值:算法估计分配给前k个位置的总分数α,并使用这个总分数在近似注意力输出和平均值向量之间进行插值,以平衡近似精度和推理速度。

3. 算法实现

SparQ Attention算法的实现涉及到几个关键的函数,包括topk用于找到最大的r个分量,gather用于根据索引选择性地获取矩阵中的行或列,以及softmax和attn函数用于计算注意力分数和最终的输出。

4. 参数调整

算法中的参数r和k允许在近似精度和推理速度之间进行权衡。通过调整这些参数,可以针对不同的应用场景和性能要求,优化模型的推理效率。

SparQ Attention算法的提出,为大型语言模型在资源受限或对实时性要求高的环境中的部署提供了可能,同时也为未来在更大规模数据集上的应用奠定了基础。

2、实验与评估

在SparQ Attention算法的实验与评估部分,研究者通常会进行一系列的实验来验证算法的有效性、效率以及在不同条件下的性能表现。以下是实验与评估部分可能包含的几个关键方面:

1. 实验设置

- 模型选择:选择一个或多个大型语言模型(LLM)作为实验的基础,例如Llama 2和Pythia模型。

- 任务类型:确定用于评估的下游任务,如文本分类、机器翻译、问答系统等。

- 数据集:选择适合所选任务的公开数据集,确保数据集的多样性和代表性。

2. 性能指标

- 内存带宽需求:测量使用SparQ Attention前后模型的内存带宽需求,以评估算法在减少内存使用方面的有效性。

- 推理速度:比较使用SparQ Attention前后模型的推理速度,以评估算法对提高计算效率的影响。

- 任务性能:使用准确率、F1分数、BLEU分数等指标来衡量模型在特定任务上的性能,确保算法在减少内存需求的同时不会显著降低任务性能。

3. 实验过程

- 基线模型:首先,训练或使用预训练的基线模型,并在测试集上评估其性能。

- SparQ Attention应用:将SparQ Attention算法应用于基线模型,并调整参数r和k以探索不同的近似精度和推理速度的组合。

- 性能比较:在相同的测试集上评估应用了SparQ Attention的模型,并与基线模型进行比较。

4. 结果分析

- 内存带宽需求的减少:展示SparQ Attention在减少内存带宽需求方面的效果,通常以减少的百分比表示。

- 推理速度的提升:分析SparQ Attention对模型推理速度的影响,并与基线模型进行对比。

- 任务性能的保持:评估SparQ Attention算法对模型在特定任务上性能的影响,确保性能下降在可接受的范围内。

5. 参数调优

- 参数影响:研究参数r和k对算法性能的影响,包括内存带宽需求、推理速度和任务性能。

- 最优参数选择:确定在不同任务和模型规模下,能够平衡内存带宽需求减少和任务性能保持的最优参数设置。

6. 讨论

- 优势分析:讨论SparQ Attention算法的优势,特别是在内存受限或对实时性要求高的应用场景中。

- 局限性:指出实验中发现的任何局限性或算法可能不适用的情况。

- 改进方向:提出可能的改进方向,如算法的扩展、与其他优化技术的结合等。

7. 结论

- 实验总结:总结实验结果,强调SparQ Attention在减少内存带宽需求和提高推理效率方面的贡献。

- 实际应用:讨论SparQ Attention在实际应用中的潜力,以及如何将其集成到现有的系统中。

8. 附录或额外信息

- 实验细节:提供实验的具体细节,如模型架构、训练过程、超参数设置等。

- 复现信息:提供足够的信息以便其他研究者复现实验结果。

通过上述步骤,实验与评估部分将全面展示SparQ Attention算法的性能,并为读者提供关于其实际应用价值的深入理解。

3、实际应用中的潜力

在实际应用中,SparQ Attention算法的潜力主要体现在以下几个方面:

1. 资源受限的环境

SparQ Attention算法通过减少内存带宽需求,使得大型语言模型(LLM)能够在资源受限的设备上运行,如移动设备、嵌入式系统或低端服务器。这为开发轻量级、高效的NLP应用提供了可能,尤其是在发展中国家或偏远地区,那里的硬件资源可能相对有限。

2. 实时应用

在需要快速响应的应用场景中,如实时语音识别、在线翻译或交互式对话系统,SparQ Attention算法的高推理速度可以显著提升用户体验。减少的计算延迟使得这些系统能够更快地处理输入并提供反馈。

3. 大规模数据处理

SparQ Attention算法的内存效率提升使得LLM能够处理更大规模的数据集,这对于需要处理海量数据的企业和研究机构来说非常有价值。例如,在金融分析、市场研究或科学研究中,能够快速分析大量文本数据可以带来显著的竞争优势。

4. 成本效益

减少内存带宽需求和提高计算效率可以降低运行大型语言模型的硬件成本和能源消耗。这不仅有助于降低企业的运营成本,也符合全球对于可持续发展和减少碳足迹的要求。

5. 边缘计算

在边缘计算场景中,数据通常在产生地点附近进行处理,以减少对中心数据中心的依赖。SparQ Attention算法的优化使得LLM可以在边缘设备上运行,这对于需要低延迟和高隐私保护的应用至关重要。

6. 跨领域应用

SparQ Attention算法的高效性可以推动LLM在更多领域的应用,如医疗健康、法律咨询、教育和娱乐等。在这些领域,准确的语言理解和生成能力可以带来创新的服务和产品。

7. 模型部署的灵活性

由于SparQ Attention算法无需重新训练或修改预训练设置,它为模型部署提供了更大的灵活性。企业和开发者可以快速地将优化后的模型部署到不同的平台和环境中。

8. 研究和创新

SparQ Attention算法的提出可能会激发新的研究方向,如探索更高效的注意力机制、开发新的模型压缩和加速技术,或者研究如何将这些技术应用于特定的NLP任务。

9. 伦理和社会影响

在推广SparQ Attention算法的同时,也需要考虑其可能带来的伦理和社会影响。例如,提高LLM的可访问性可能会加剧信息过载和假信息的传播,因此需要相应的策略来确保算法的正面影响。

10. 长期发展

从长期来看,SparQ Attention算法可能会成为推动自然语言处理技术发展的关键因素之一。随着算法的不断优化和改进,它可能会成为未来NLP系统的标准组成部分。

综上所述,SparQ Attention算法在实际应用中具有巨大的潜力,可以推动自然语言处理技术在多个领域的发展和创新。然而,同时也需要考虑其在实际部署中可能遇到的挑战,如参数调优、特定任务的适应性以及伦理和社会问题等。

参考文献: https://arxiv.org/pdf/2312.04985.pdf [2] Efficient Attention: Attention with Linear Complexities. https://arxiv.org/abs/1812.01243 [3] Lin, M., Teng, S., Qi, D., & Wang, J. (2020). Structured Pruning for Efficient BERT. arXiv preprint arXiv:2004.02984.

)

)

)

![[MySQL数据库] 索引与事务](http://pic.xiahunao.cn/[MySQL数据库] 索引与事务)

的友好介绍。)