一、说明

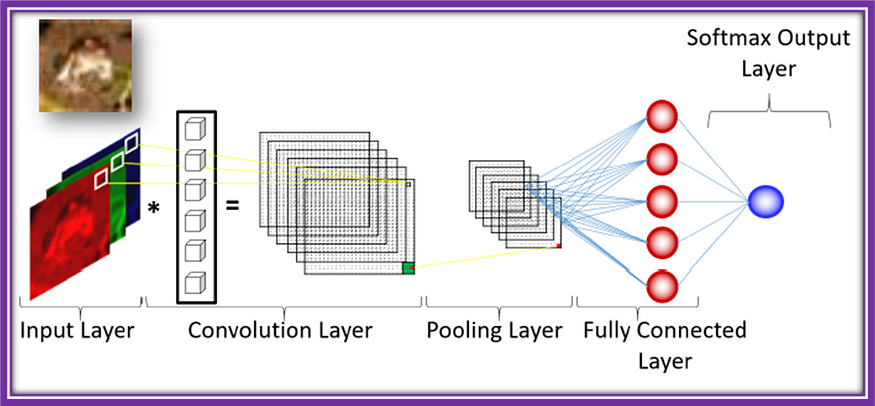

二、卷积神经网络 (CNN)

卷积神经网络 (CNN) 是一种人工神经网络,旨在处理和分析具有网格状拓扑结构的数据,例如图像和视频。将 CNN 想象成一个多层过滤器,它处理图像以提取有意义的特征并做出预测。

想象一下,你有一张手写数字的照片,你希望计算机能够识别这个数字。CNN 的工作原理是在图像上应用一系列滤镜,逐渐提取越来越复杂的特征。第一个过滤器检测简单的特征,如边缘和线条,而后面的过滤器检测更复杂的图案,如形状和数字。

卷积神经网络

CNN 的层可分为三种主要类型:卷积层、池化层和全连接层。

- 卷积层:这些层将过滤器(也称为内核)应用于图像。每个滤镜在图像上滑动,计算滤镜和它所覆盖的像素之间的点积。此过程将生成一个新的特征图,该特征图突出显示了图像中的特定模式。使用不同的滤镜多次重复该过程,创建一组捕获图像不同方面的特征图。

- 池化图层:池化图层对特征图执行下采样操作,在保留重要要素的同时减小数据的空间维度。这有助于降低计算复杂性并防止过拟合。最常见的池化类型是最大池化,它从一小块像素邻域中选择最大值。

- 全连接层:这些层类似于传统神经网络中的层。它们将一层中的每个神经元连接到下一层中的每个神经元。卷积层和池化层的输出被展平化并通过一个或多个完全连接的层,允许网络做出最终预测,例如识别图像中的数字。

总之,CNN 是一种神经网络,旨在处理类似网格的数据,例如图像。它的工作原理是将一系列过滤器或内核应用于图像,逐渐提取更复杂的特征。然后,输出通过池化层传递,以减小空间维度并防止过拟合。最后,输出通过全连接层进行最终预测。

三、递归神经网络 (RNN)

递归神经网络 (RNN) 是一种人工神经网络,旨在处理顺序数据,例如时间序列、语音和自然语言。将RNN想象成一条传送带,一次处理一个元素的信息,使其能够“记住”来自先前元素的信息,从而对下一个元素进行预测。

想象一下,你有一个单词序列,你希望计算机生成序列中的下一个单词。RNN 的工作原理是处理序列中的每个单词,一次一个,并使用来自前一个单词的信息来预测下一个单词。

RNN 的关键组件是循环连接,它允许信息从一个时间步流向下一个时间步。递归连接是神经元内的一种连接,它“记住”了前一个时间步的信息。

RNN系列

RNN 可分为三个主要部分:输入层、循环层和输出层。

- 输入层:输入层在每个时间步长接收信息,例如序列中的一个单词。

- 递归层:递归层处理来自输入层的信息,使用递归连接来“记住”以前时间步长中的信息。循环层包含一组神经元,每个神经元都与自身建立循环连接,并在当前时间步长与输入建立连接。

- 输出层:输出层根据循环层处理的信息生成预测。在生成序列中的下一个单词的情况下,输出层将预测最有可能跟随序列中前一个单词的单词。

总之,RNN 是一种旨在处理顺序数据的神经网络。它的工作原理是一次处理一个元素的信息,使用循环连接来“记住”来自先前元素的信息。递归层允许网络处理整个序列,使其非常适合语言翻译、语音识别和时间序列预测等任务。

四、生成对抗网络 (GAN)

生成对抗网络 (GAN) 是一种深度学习架构,它使用两个神经网络(一个生成器和一个鉴别器)来创建新的、真实的数据。将 GAN 想象成两个对立的艺术家,一个创作假艺术,另一个试图区分真假。

GAN 的目标是在各个领域(例如图像、音频和文本)生成高质量、逼真的数据样本。生成器网络创建新样本,而鉴别器网络评估生成样本的真实性。这两个网络以对抗的方式同时进行训练,生成器试图产生更真实的样本,而鉴别器则在检测假货方面变得更好。

赣语

GAN的两个主要组成部分是:

- 发电机: 发电机网络负责创建新样本。它以随机噪声向量作为输入并生成输出样本,例如图像或句子。生成器经过训练,通过最小化损失函数来生成更真实的样本,该损失函数测量生成的样本与真实数据之间的差异。

- 鉴别器:鉴别器网络评估生成样本的真实性。它以样本作为输入并输出一个概率,指示样本是真的还是假的。鉴别器经过训练,通过最大化损失函数来区分真实样本和虚假样本,该损失函数测量真实样本和生成样本之间的概率差异。

GAN的对抗性源于生成器和鉴别器之间的竞争。生成器试图生成更真实的样本来欺骗鉴别器,而鉴别器则试图提高其区分真实样本和假样本的能力。这个过程一直持续到生成器生成高质量、逼真的数据,这些数据不容易与真实数据区分开来。

总之,GAN是一种深度学习架构,它使用两个神经网络(一个生成器和一个判别器)来创建新的、真实的数据。生成器创建新样本,鉴别器评估其真实性。这两个网络以对抗方式进行训练,生成器产生更真实的样本,鉴别器提高其检测假货的能力。GAN 在各个领域都有应用,例如图像和视频生成、音乐合成和文本到图像合成。

五、变形金刚

Transformer 是一种神经网络架构,广泛用于自然语言处理 (NLP) 任务,例如翻译、文本分类和问答。它们在 2017 年由 Vaswani 等人发表的开创性论文“Attention Is All You Need”中介绍。

将转换器想象成一种复杂的语言模型,它通过将文本分解成更小的部分并分析它们之间的关系来处理文本。然后,该模型可以对各种查询生成连贯且流畅的响应。

变压器由几个重复模块组成,称为层。每层包含两个主要组件:

- 自注意力机制:自注意力机制允许模型分析输入文本不同部分之间的关系。它的工作原理是为输入序列中的每个单词分配一个权重,表明其与当前上下文的相关性。这使得模型能够专注于重要的单词,而淡化不太相关的单词的重要性。

- 前馈神经网络:前馈神经网络是处理自注意力机制输出的多层感知器。他们负责学习输入文本中单词之间的复杂关系。

变压器

转换器的关键创新是使用自注意力机制,它允许模型有效地处理长序列的文本,而无需昂贵的循环或卷积操作。这使得转换器在计算上高效且适用于各种 NLP 任务。

简单来说,转换器是一种强大的神经网络架构,专为自然语言处理任务而设计。他们通过将文本分解成更小的部分并通过自我注意力机制分析它们之间的关系来处理文本。这允许模型对各种查询生成连贯且流畅的响应。

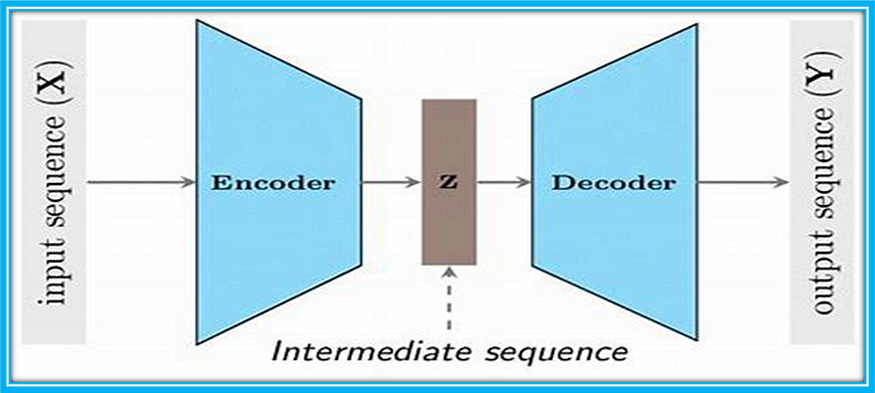

六、编码器-解码器体系结构

编码器-解码器架构在自然语言处理 (NLP) 任务中很受欢迎。它们通常用于序列到序列问题,例如机器翻译,其目标是将一种语言(源)的输入文本转换为另一种语言(目标)的相应文本。

想象一下,编码器-解码器架构就像一个翻译器,他听一个用外语说话的人,同时将其翻译成听众的母语。

编码器-解码器架构

该体系结构由两个主要组件组成:

- 编码器:编码器获取输入序列(源文本)并按顺序进行处理,生成紧凑的表示形式,通常称为“上下文向量”或“上下文嵌入”。此表示形式汇总了输入序列,并包含有关其语法、语义和上下文的信息。编码器可以是递归神经网络 (RNN) 或转换器,具体取决于特定任务和实现。

- 译码器:解码器获取编码器生成的上下文向量,并一次生成一个元素的输出序列(目标文本)。解码器通常是循环神经网络或转换器,类似于编码器。它通过根据前一个单词和上下文向量中包含的信息预测目标序列中的下一个单词来生成输出序列。

在训练过程中,解码器接收真正的目标序列,其目标是预测序列中的下一个单词。在推理期间(当模型生成响应时),解码器接收到该点之前生成的文本,并使用它来预测下一个单词。

总之,编码器-解码器架构是自然语言处理任务中的一种流行方法,特别是对于机器翻译等序列到序列问题。该体系结构由一个编码器和一个解码器组成,前者处理输入序列并生成紧凑的表示,后者基于此表示生成输出序列。这允许模型将一种语言的输入文本转换为另一种语言的相应文本。

【计算机网络基础(由一根网线连接两个电脑开始)】)

)