Challenge:

之前网络架构的设计假设数据流是一致的,即出现在一个模态中的对象也出现在另一个模态中。然而,在恶劣的天气条件下,如雾、雨、雪或极端照明条件,多模态传感器配置中的信息可能不对称。不同传感器在特征提取阶段单独处理,在存在不对称测量失真的情况下,融合性能比单传感器差。

Contribution:

1.第一个恶劣天气下的大型多模态驾驶数据集,激光雷达、相机、雷达、门控近红外传感器和FIR传感器的100k标签

2.提出了由测量熵驱动的自适应特征融合而非proposals级别的融合(无需为这些场景提供大型带注释的训练数据集)

Method:

STF数据集,详见恶劣数据集总结

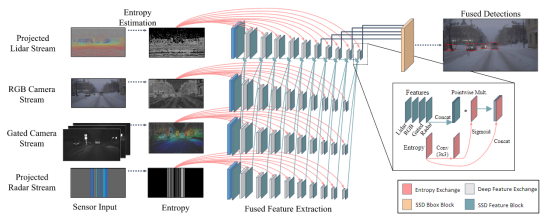

自适应深度融合:允许在非对称的传感器信息的情况下进行多模态融合。

-

偏离了最近的BEV投影方案或原始点云输入,因为BeV投影或点云输入不允许深度早期融合,因为他们在早期层中的特征表示本质上与相机特征不同。

-

使用修改后的VGG网络,conv4-10作为RPN网络输入

-

为每个特征交换块提供传感器熵,根据可用信息单独缩放每个传感器的连接特征。熵低的区域可以衰减,而熵丰富的区域可以在特征提取中被放大。这样做可以自适应地融合特征提取堆栈本身中的特征

Entropy-steered Fusion

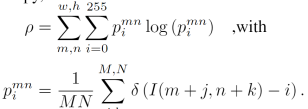

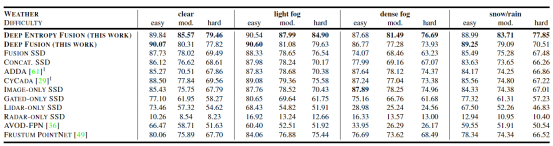

将投影分为16x16的patch,计算每个patch的local measurement entropy(理解为图像熵),pmni理解为第(m,n)个patch灰度为i的概率。pmn理解为第(m,n)个patch的信息熵,所有patch的信息熵和即为该投影的信息熵。

不同模态数据熵在不同情况下的变化:

RGB相机和LiDAR受到后向散射和衰减的影响,雾能见度降低数据熵显著降低。

门控和Radar则没有明显变化。光照情况下,随着亮度降低,RGB和门控数据信息熵明显减少,LiDAR和Radar则变化较少。

Experiments:

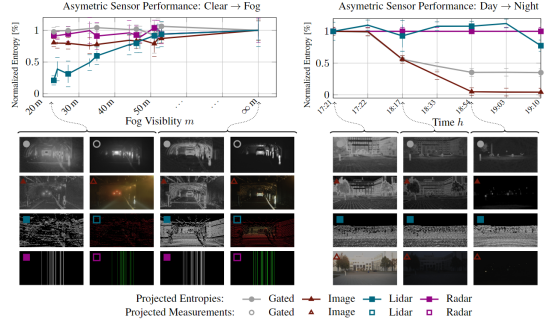

由于训练数据获取的天气偏差,只使用所提出数据集的晴朗天气部分进行训练(雾化数据增强),使用多模态天气数据集作为测试集来评估检测性能

)

)

无约束优化问题——共轭梯度法背景介绍)