- 💂 个人网站:【 摸鱼游戏】【神级代码资源网站】【工具大全】

- 🤟 一站式轻松构建小程序、Web网站、移动应用:👉注册地址

- 🤟 基于Web端打造的:👉轻量化工具创作平台

- 💅 想寻找共同学习交流,摸鱼划水的小伙伴,请点击【全栈技术交流群】

随着深度学习技术的发展,自然语言处理(NLP)领域取得了显著的进步。其中,基于Transformer架构的预训练模型,如ChatGPT和GPT-4,已经成为了解决各种NLP任务的主流方法。本文将介绍如何使用这些大模型来解决自然语言处理问题,并提供相应的代码示例。

- 安装所需库

首先,我们需要安装一些必要的库,如PyTorch、Transformers等。可以通过以下命令进行安装:

pip install torch transformers

- 导入所需模块

接下来,我们需要导入所需的模块:

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

- 加载预训练模型和分词器

我们可以使用Hugging Face提供的预训练模型和分词器。例如,加载ChatGPT模型:

model_name = "chatgpt"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

- 准备输入数据

我们需要将文本数据转换为模型可以接受的格式。这包括对文本进行分词、添加特殊标记等:

text = "今天天气真好,我们去公园玩吧。"

inputs = tokenizer(text, return_tensors="pt")

- 生成输出

使用模型生成输出:

outputs = model.generate(**inputs)

generated_text = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(generated_text)

以上代码将输出与输入文本相关的回答。通过这种方式,我们可以利用大模型解决自然语言处理问题,如文本生成、问答系统等。

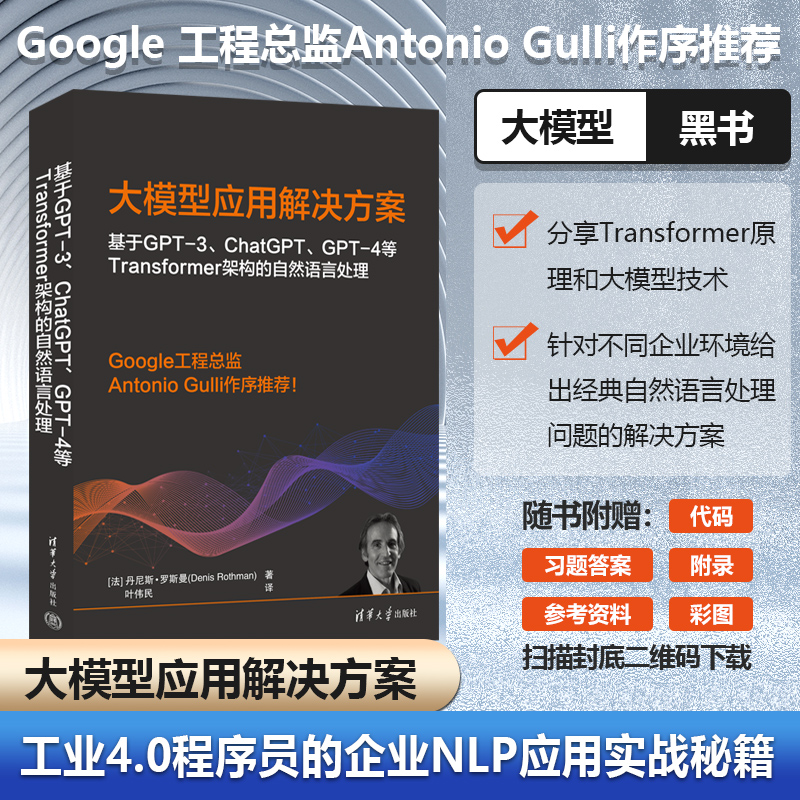

⭐️ 好书推荐

《大模型应用解决方案 基于ChatGPT和GPT-4等Transformer架构的自然语言处理》

【内容简介】

《基于GPT-3、ChatGPT、GPT-4等Transformer架构的自然语言处理》分步展示如何微调GPT-3等预训练模型。研究机器翻译、语音转文本、文本转语音、问答等NLP任务,并介绍解决NLP难题的技术,甚至帮助你应对假新闻焦虑(详见第13章)。

从书中可了解到,诸如OpenAI的高级平台将Transformer扩展到语言领域、计算机视觉领域,并允许使用DALL-E 2、ChatGPT和GPT-4生成代码。通过本书,你将了解到Transformer的工作原理以及如何实施Transformer来决NLP问题。

📚 京东购买链接:《大模型应用解决方案 基于ChatGPT和GPT-4等Transformer架构的自然语言处理 》

)

之搭建源码环境)

![[STL-list]介绍、与vector的对比、模拟实现的迭代器问题](http://pic.xiahunao.cn/[STL-list]介绍、与vector的对比、模拟实现的迭代器问题)

)