实验二 HDFS操作实验

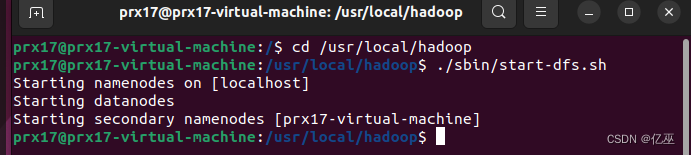

- 启动Hadoop,执行jps,检查Hadoop相关进程是否启动成功

启动hadoop

执行jps,可以看到名称节点和数据节点,第二名称节点都打开了,则hadoop相关进程启动成功

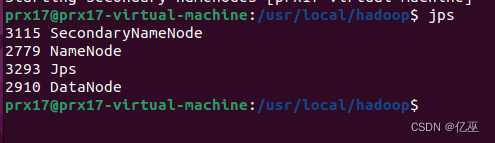

- 在本地文件系统“/home”下新建两个文件夹,分别命名为“local1”和“local2”

Cd进入/home文件夹

![]()

创建文件夹

sudo mkdir local1 local2

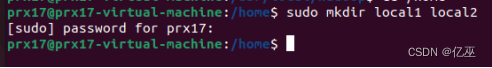

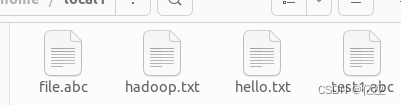

- 在“local1”下新建4个文本文件“hello.txt”、“hadoop.txt”、“test1.abc”、“file.abc”,文件里输入任意内容

![]()

创建成功

- 在HDFS根目录下创建目录“h1”、“h2”

Cd 进入hadoop根目录

hdfs dfs -mkdir h1

![]()

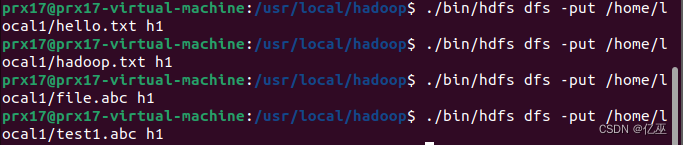

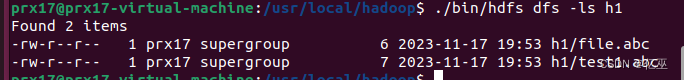

- 将“local1”下所有文件上传至“/h1”中

hdfs dfs -put /home/local1/* h1

查看已创建成功

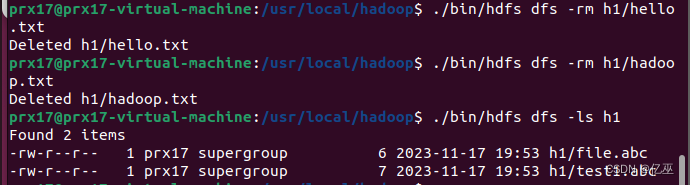

- 删除“/h1”下后缀为“txt”的文件

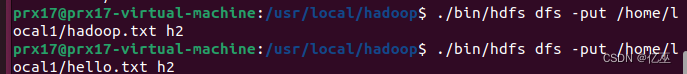

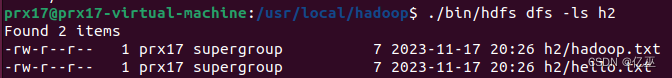

- 将“local1”下以“h”开头的所有文件上传至“/h2”中

查找h开头的文件

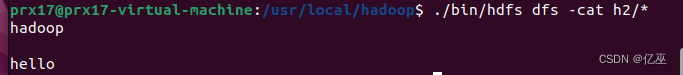

- 输出“/h1”和“/h2”下所有文件内容

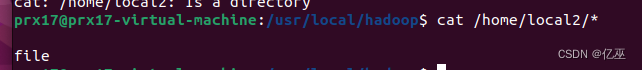

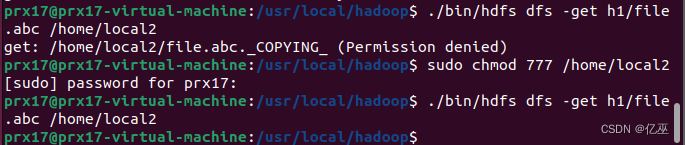

- 将“/h1”下“f”开头且后缀为“abc”的文件下载至“local2”中

hdfs dfs -get h1/hello.txt /home/local2

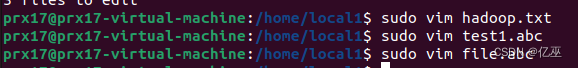

- 输出“local2”中所有文件内容

![]()

- 删除“h1”目录

![]()

- 在浏览器中查看HDFS中文件

- 关闭Hadoop

心得体会:

Hdfs内是一个虚拟的文件环境,无法直接查看,只能通过shell命令查看,出现错误

时通过赋予权限得到解决

基于云原生了解Dapr)

Docker的基本操作)

)