一、Docker Swarm核心概念

1、什么是Docker Swarm

GitHub地址

Docker Swarm 是 Docker 官方推出的容器集群管理工具,基于 Go 语言实现。使用它可以将多个 Docker 主机封装为单个大型的虚拟 Docker 主机,快速打造一套容器云平台。

Docker Swarm 是生产环境中运行 Docker 应用程序最简单的方法。作为容器集群管理器,Swarm 最大的优势之一就是 100% 支持标准的 Docker API。各种基于标准 API 的工具比如 Compose、docker-py、各种管理软件,甚至 Docker 本身等都可以很容易的与 Swarm 进行集成。大大方便了用户将原先基于单节点的系统移植到 Swarm 上,同时 Swarm 内置了对 Docker 网络插件的支持,用户可以很容易地部署跨主机的容器集群服务。

Docker Swarm 和 Docker Compose 一样,都是 Docker 官方容器编排工具,但不同的是,Docker Compose 是一个在单个服务器或主机上创建多个容器的工具,而 Docker Swarm 则可以在多个服务器或主机上创建容器集群服务,对于微服务的部署,显然 Docker Swarm 会更加适合。

2、Swarm 核心概念

Docker Engine 1.12 引入了 Swarm 模式,一个 Swarm 由多个 Docker 主机组成,它们以 Swarm 集群模式运行。Swarm 集群由 Manager 节点(管理者角色,管理成员和委托任务)和 Worker 节点(工作者角色,运行 Swarm 服务)组成。这些 Docker 主机有些是 Manager 节点,有些是 Worker 节点,或者同时扮演这两种角色。

Swarm 创建服务时,需要指定要使用的镜像、在运行的容器中执行的命令、定义其副本的数量、可用的网络和数据卷、将服务公开给外部的端口等等。与独立容器相比,集群服务的主要优势之一是,你可以修改服务的配置,包括它所连接的网络和数据卷等,而不需要手动重启服务。还有就是,如果一个 Worker Node 不可用了,Docker 会调度不可用 Node 的 Task 任务到其他 Nodes 上。

3、Node概念

Swarm 集群由 Manager 节点(管理者角色,管理成员和委托任务)和 Worker 节点(工作者角色,运行 Swarm 服务)组成。一个节点就是 Swarm 集群中的一个实例,也就是一个 Docker 主机。你可以运行一个或多个节点在单台物理机或云服务器上,但是生产环境上,典型的部署方式是:Docker 节点交叉分布式部署在多台物理机或云主机上。节点名称默认为机器的 hostname。

-

Manager:负责整个集群的管理工作包括集群配置、服务管理、容器编排等所有跟集群有关的工作,它会选举出一个 leader 来指挥编排任务;

-

Worker:工作节点接收和执行从管理节点分派的任务(Tasks)运行在相应的服务(Services)上。

4、Services and Tasks

服务(Service)是一个抽象的概念,是对要在管理节点或工作节点上执行的任务的定义。它是集群系统的中心结构,是用户与集群交互的主要根源。Swarm 创建服务时,可以为服务定义以下信息:

- 服务名称;

- 使用哪个镜像来创建容器;

- 要运行多少个副本;

- 服务的容器要连接到哪个网络上;

- 要映射哪些端口。

任务(Task)包括一个 Docker 容器和在容器中运行的命令。任务是一个集群的最小单元,任务与容器是一对一的关系。管理节点根据服务规模中设置的副本数量将任务分配给工作节点。一旦任务被分配到一个节点,便无法移动到另一个节点。它只能在分配的节点上运行或失败。

5、Replicated and global services

Swarm 不只是提供了优秀的高可用性,同时也提供了节点的弹性扩容和缩容的功能。可以通过以下两种类型的 Services 部署实现:

-

Replicated Services:当服务需要动态扩缩容时,只需通过 scale 参数或者 --replicas n 参数指定运行相同任务的数量,即可复制出新的副本,将一系列复制任务分发至各节点当中,这种操作便称之为副本服务(Replicate)。

-

Global Services:我们也可以通过 --mode global 参数将服务分发至全部节点之上,这种操作我们称之为全局服务(Global)。在每个节点上运行一个相同的任务,不需要预先指定任务的数量,每增加一个节点到 Swarm 中,协调器就会创建一个任务,然后调度器把任务分配给新节点。

二、Docker Swarm工作流程

Swarm Manager:

1、API:接受命令并创建 service 对象(创建对象)

2、orchestrator:为 service 对象创建的 task 进行编排工作(服务编排)

3、allocater:为各个 task 分配 IP 地址(分配 IP)

4、dispatcher:将 task 分发到 nodes(分发任务)

5、scheduler:安排一个 worker 节点运行 task(运行任务)

Worker Node:

1、worker:连接到调度器,检查分配的 task(检查任务)

2、executor:执行分配给 worker 节点的 task(执行任务)

三、Docker Swarm中的网络模式介绍

不过,Docker Swarm 集群模式下却默认使用的是 Overlay 网络(覆盖网络),这里简单介绍一下什么是 Overlay 网络。

Overlay 网络其实并不是一门新技术,它是指构建在另一个网络上的计算机网络,这是一种网络虚拟化技术的形式,近年来云计算虚拟化技术的演进促进了网络虚拟化技术的应用。所以 Overlay 网络就是建立在另一个计算机网络之上的虚拟网络,它是不能独立出现的,Overlay 底层依赖的网络就是 Underlay 网络。

Underlay 网络是专门用来承载用户 IP 流量的基础架构层,它与 Overlay 网络之间的关系有点类似物理机和虚拟机。Underlay 网络和物理机都是真正存在的实体,它们分别对应着真实存在的网络设备和计算设备,而 Overlay 网络和虚拟机都是依托在下层实体的基础之上,使用软件虚拟出来的层级

在 Docker 版本 1.12 以后 Swarm 模式原生已支持覆盖网络(Overlay Network),只要是这个覆盖网络内的容器,不管在不在同一个宿主机上都能相互通信,即跨主机通信。不同覆盖网络内的容器之间是相互隔离的(相互 ping 不通)。

Overlay 网络是目前主流的容器跨节点数据传输和路由方案。当然,容器在跨主机进行通信的时候,除了可以使用 overlay 网络模式进行通信之外,还可以使用 host 网络模式,直接使用物理机的 IP 地址就可以进行通信

四、Docker Swarm实践之服务部署

1、机器分布

| 主机名 | IP |

|---|---|

| swarm-1 | 192.168.1.204 |

| swarm-2 | 192.168.1.205 |

| swarm-3 | 192.168.1.206 |

| swarm-4 | 192.168.1.207 |

2、环境准备

1、修改主机名

hostnamectl set-hostname swarm-1 ; bash

hostnamectl set-hostname swarm-2 ; bash

hostnamectl set-hostname swarm-3 ; bash

hostnamectl set-hostname swarm-4 ; bash

3、 关闭防火墙

systemctl stop firewalld ; systemctl disable firewalld

4、安装dokcer

wget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -O /etc/yum.repos.d/docker-ce.repoyum makecache

yum -y install yum-utils

yum -y install docker-ce docker-cli containerd.io

##配置镜像下载加速器:

cat > /etc/docker/daemon.json << EOF

{"registry-mirrors": ["https://b9pmyelo.mirror.aliyuncs.com"],"exec-opts": ["native.cgroupdriver=systemd"]

}

EOF

systemctl start docker ; systemctl enable docker

docker info## docker 网络环境查看

docker network ls3、创建集群

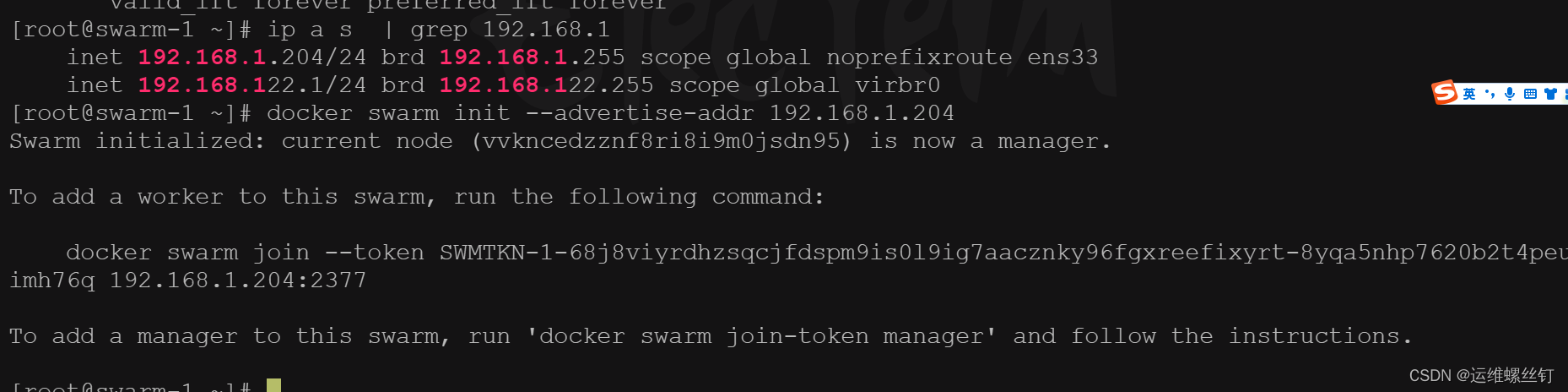

docker swarm init --advertise-addr 192.168.1.204

4、加入集群

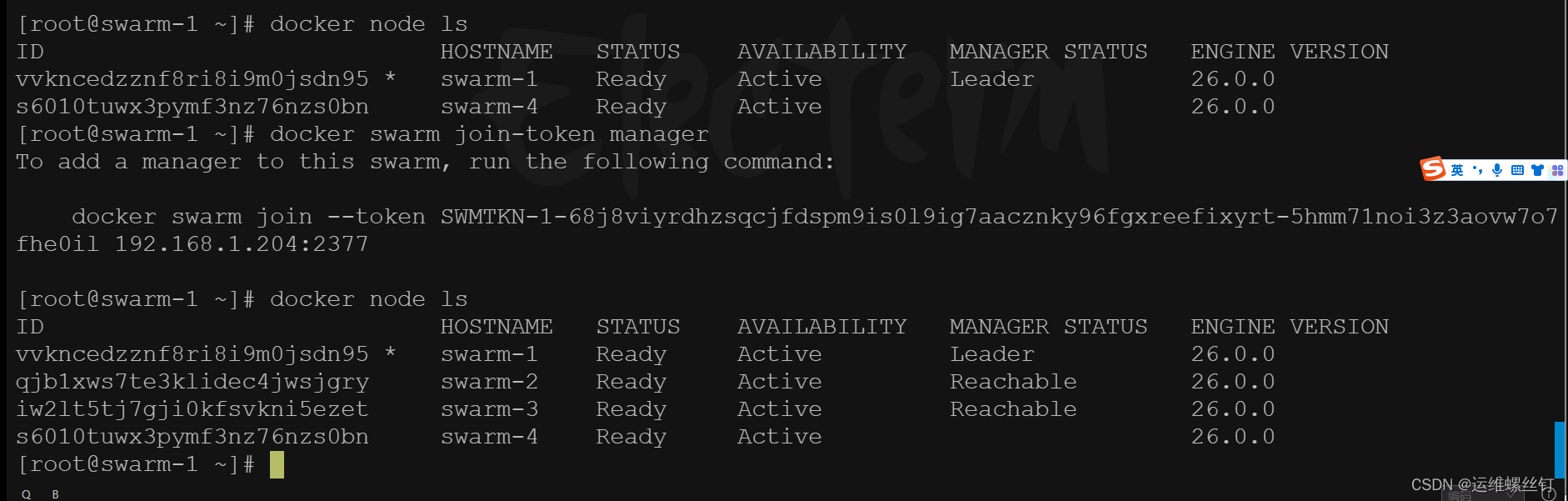

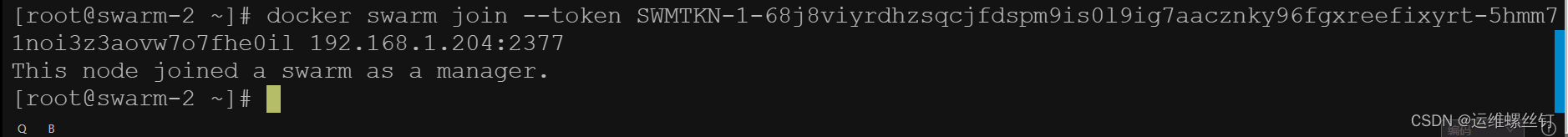

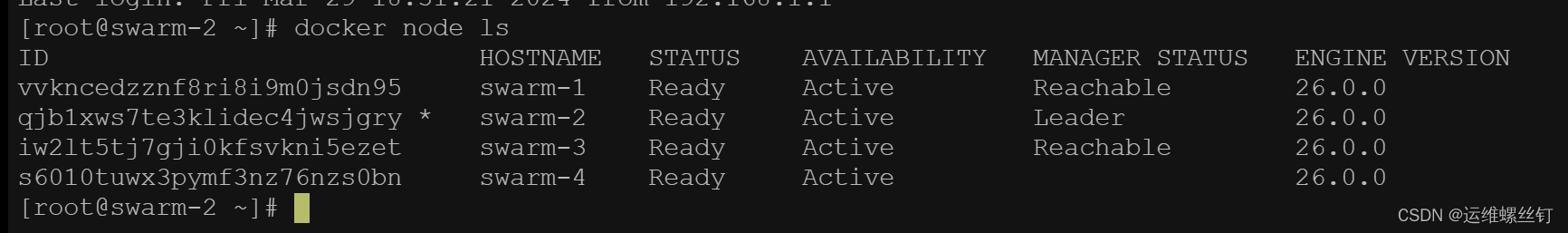

5、Manager加入集群

- 1、先在Leader 生成token docker swarm join-token manager

- 2、 在swarm-2 swarm-3 执行命令,变成Manager

- 3、查看集群 docker node ls

如果在次启动机器,leader会发生变化

在Docker Swarm中,如果主机上的leader节点发生变化,这可能是由于以下几种原因引起的:

Leader节点失效: 如果当前的leader节点由于某种原因(例如网络问题、节点故障等)不可用了,Swarm会自动选举一个新的leader节点来替代。这可能会导致Leader节点发生变化。

手动干预: 如果管理员手动干预并进行了重新配置、重新启动等操作,也可能导致Leader节点的变化。

重新加入集群: 如果一个节点从Swarm集群中断开,然后重新加入,它可能会影响Leader节点的状态。

无论是什么原因导致了Leader节点的变化,Swarm通常都会在发生故障时自动处理,并确保集群的正常运行。你可以通过监控Swarm集群的日志或事件来了解Leader节点变化的原因,并确保集群的健康状态。

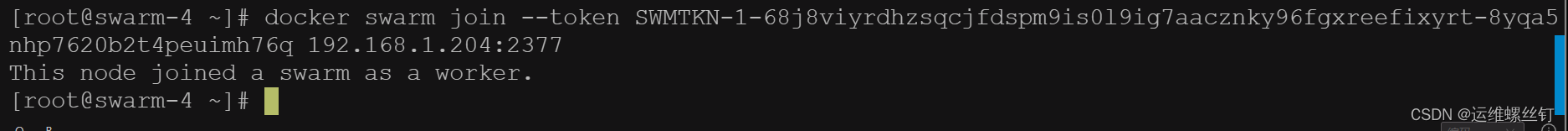

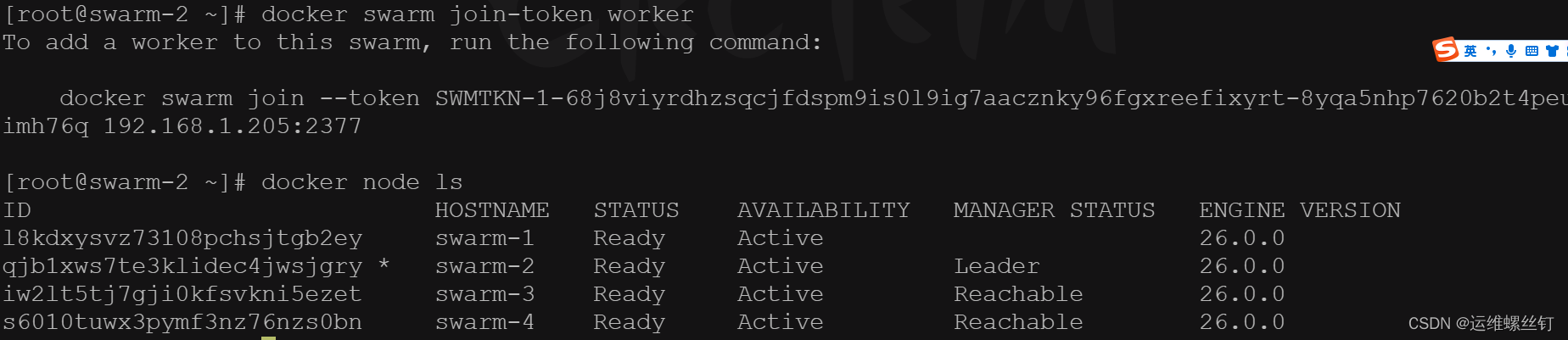

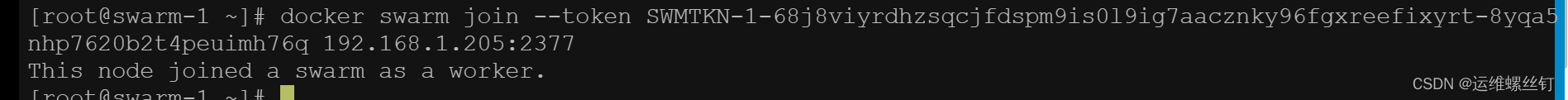

6、Worker加入集群

在swarm-4 作为work节点

- 假如集群不够用,需要新增节点

## 在manager 节点生成token

docker swarm join-token worker

## 在需要加入集群的机器下执行下面命令

docker swarm join --token SWMTKN-1-68j8viyrdhzsqcjfdspm9is0l9ig7aacznky96fgxreefixyrt-8yqa5nhp7620b2t4peuimh76q 192.168.1.205:2377

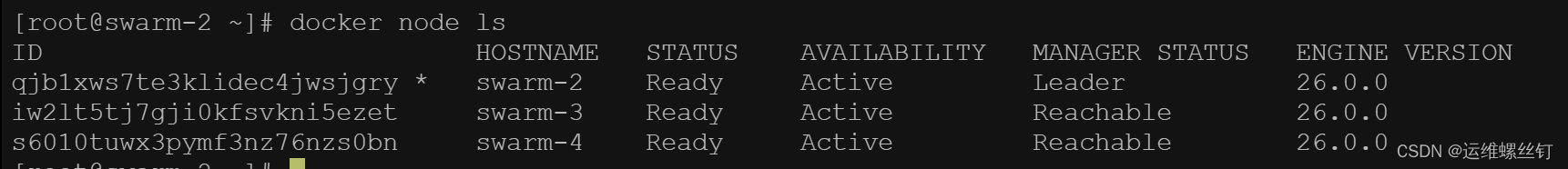

## 查看集群明显

docker node ls

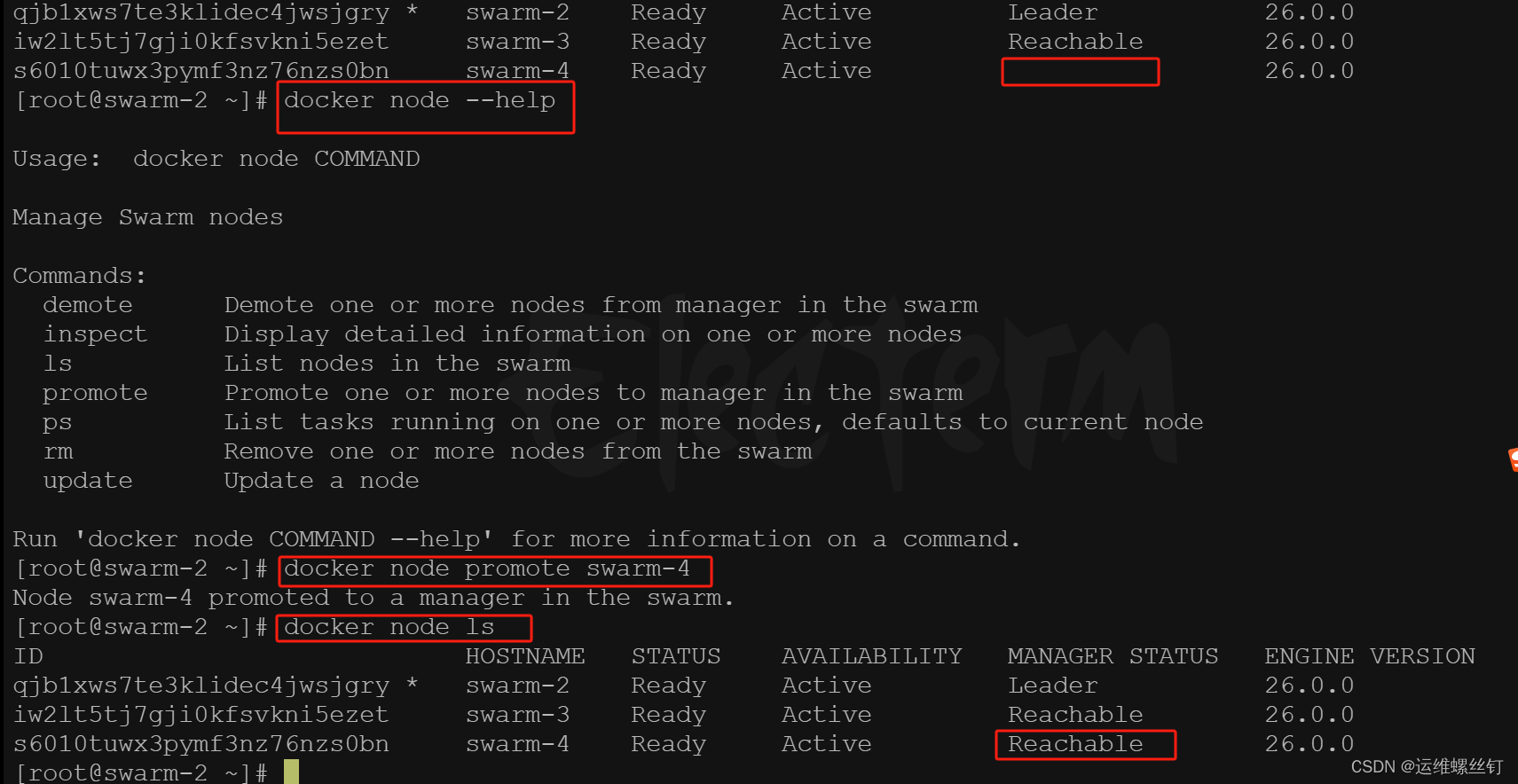

work节点升级为Manager节点

docker node promote 节点名称|节点ID

7、查看集群信息

8、查看集群节点

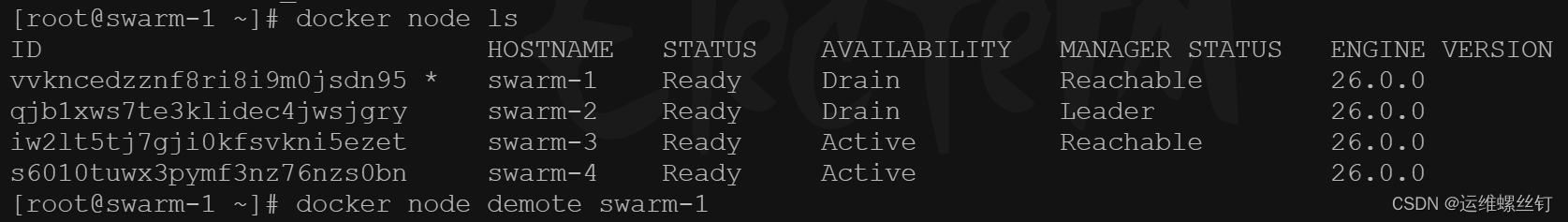

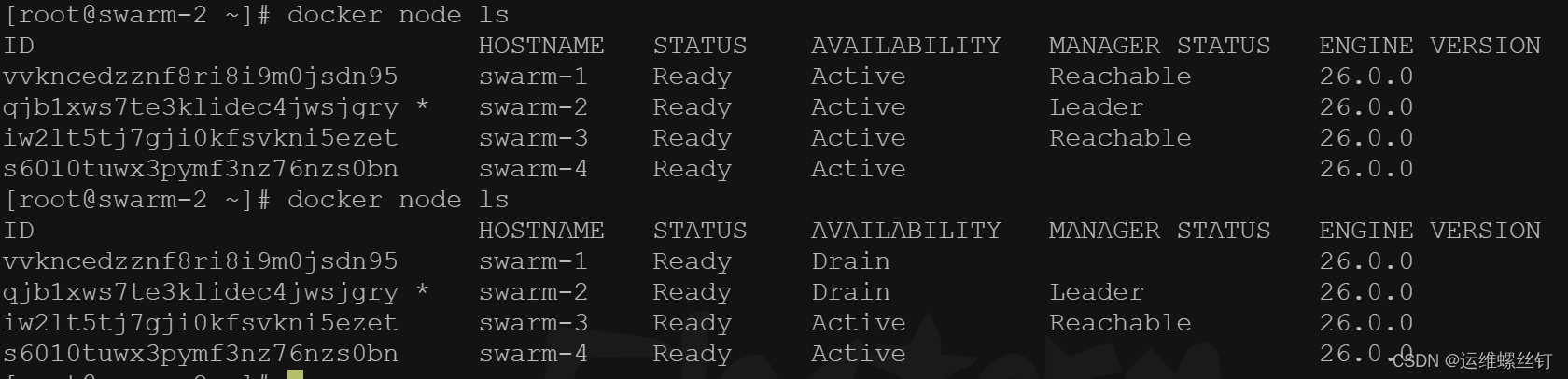

9、删除Manager节点

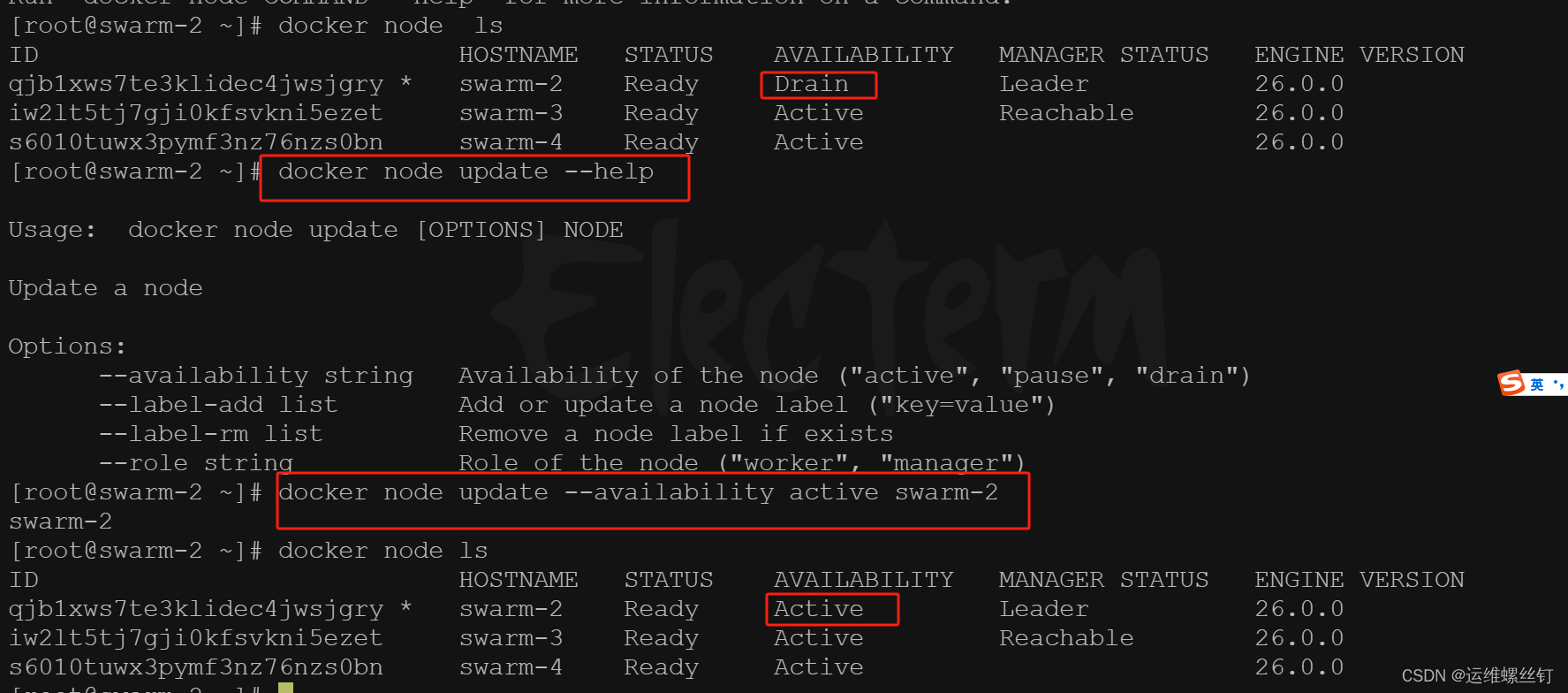

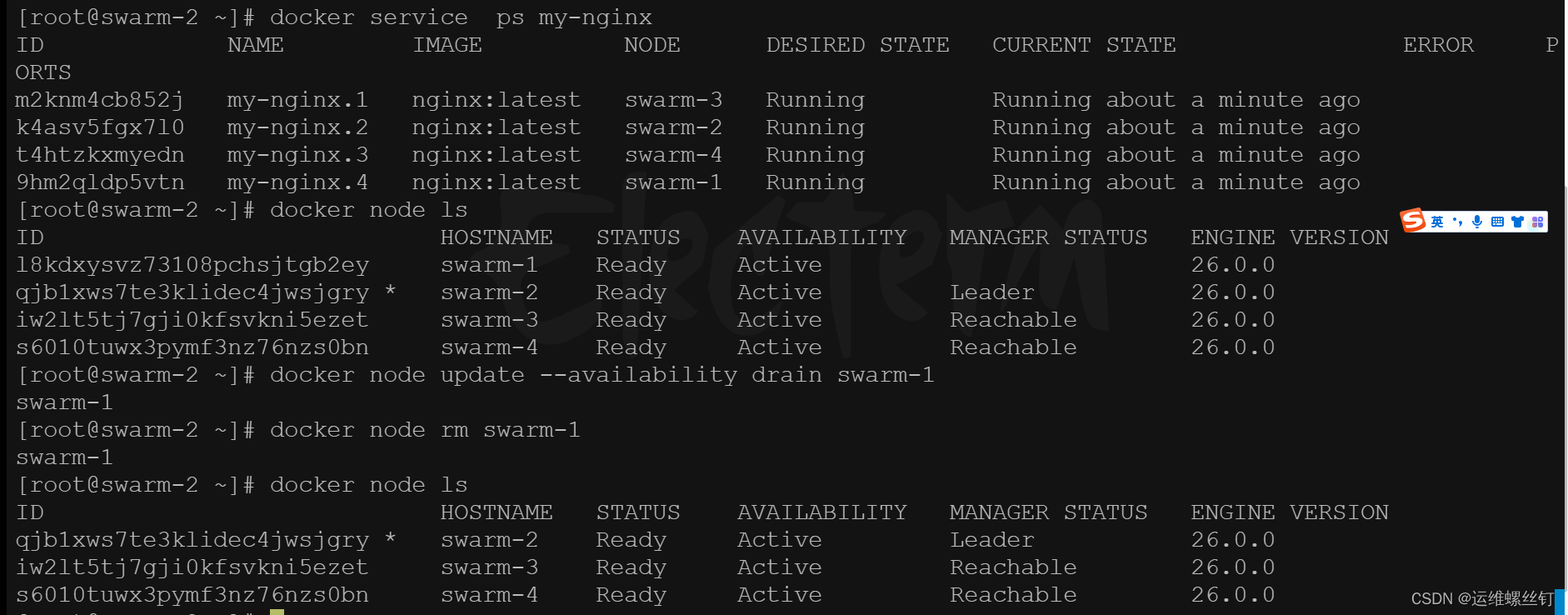

删除节点之前需要先将该节点的 AVAILABILITY 改为 Drain。其目的是为了将该节点的服务迁移到其他可用节点上,确保服务正常。最好检查一下容器迁移情况,确保这一步已经处理完成再继续往下。

docker node update --availability drain 节点名称|节点ID

docker node demote 节点名称|节点ID

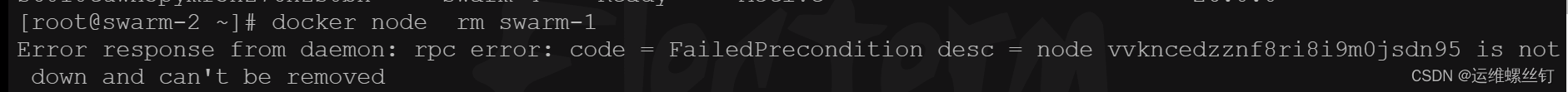

- 移除节点,出现的报错的解决方法

- 登陆被移动节点

docker swarm leave

## 如果不能清除,则需要删除空闲的容器

docker container prune

## 重启docker服务

systemctl restart docker

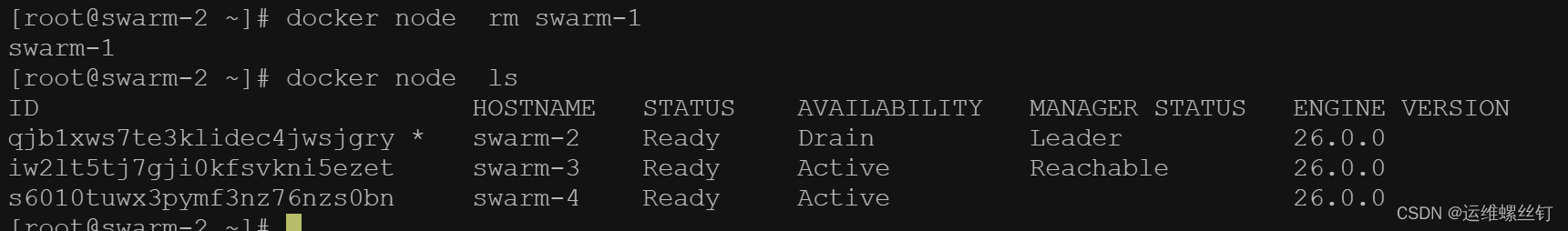

- 再登陆Manager节点

docker node rm 节点名称

docker node ls

- 将驱赶的节点,变为可用性

docker node update --availability active 节点名称

10、删除Worker节点

驱赶服务

docker node update --availability drain 节点名称|节点ID

然后,在准备删除的 Worker 节点中运行以下命令,离开集群

docker swarm leave

最后,在管理节点中对刚才离开的节点进行删除。

docker node rm 节点名称|节点ID

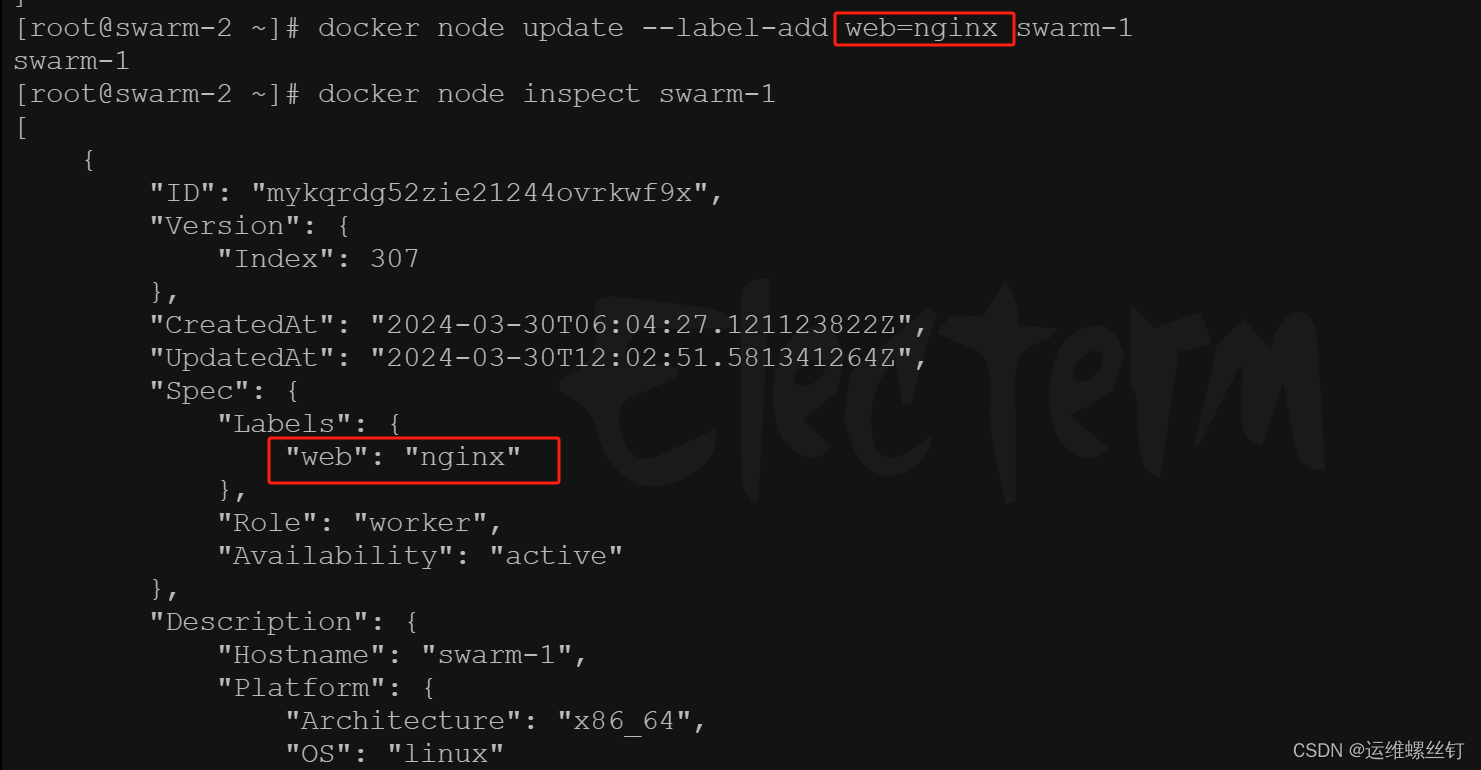

11、查看节点标签,给节点打标签

要给 Docker Swarm 节点打标签,您可以使用 docker node update 命令,并通过 --label-add 参数指定要添加的标签。以下是具体的步骤:

确定节点名称或 ID:首先,您需要确定要给哪个节点添加标签。您可以使用以下命令列出 Swarm 集群中的所有节点:

docker node ls

添加标签:一旦确定了要给哪个节点添加标签,您可以使用 docker node update 命令添加标签。例如,假设要给节点 node1 添加 env=production 和 role=web 两个标签,可以使用以下命令:

docker node update --label-add env=production --label-add role=web node1

这个命令将向节点 node1 添加两个标签,一个是 env,值为 production,另一个是 role,值为 web。

验证标签:您可以再次运行 docker node inspect 命令来验证节点的标签是否已添加成功。

docker node inspect node1

这将显示有关节点 node1 的详细信息,其中应该包含了您添加的标签信息。

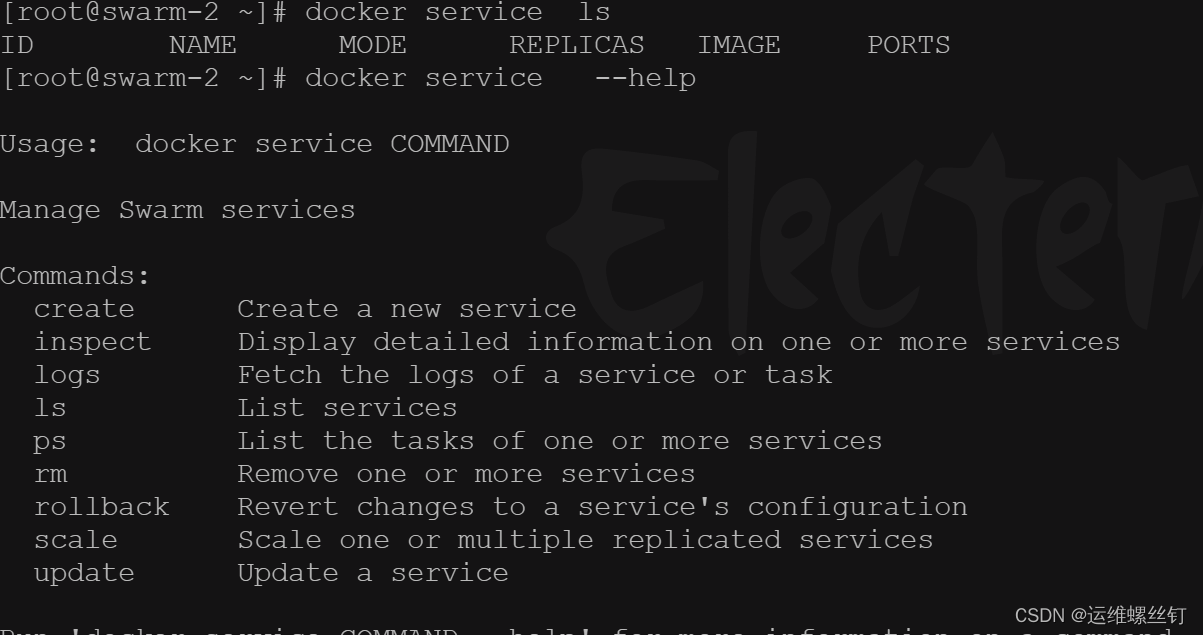

五、Docker Swarm部署应用服务

1、服务部署

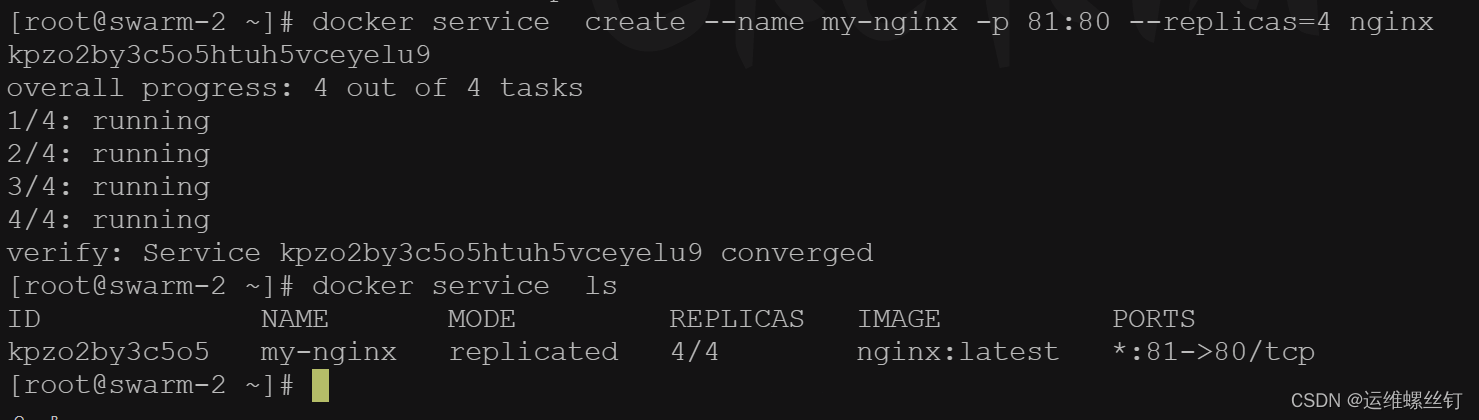

2、创建服务

## 创建Nginx服务

docker service create --name my-nginx -p 81:80 --replicas=4 nginx

## 查看服务

docker service ls

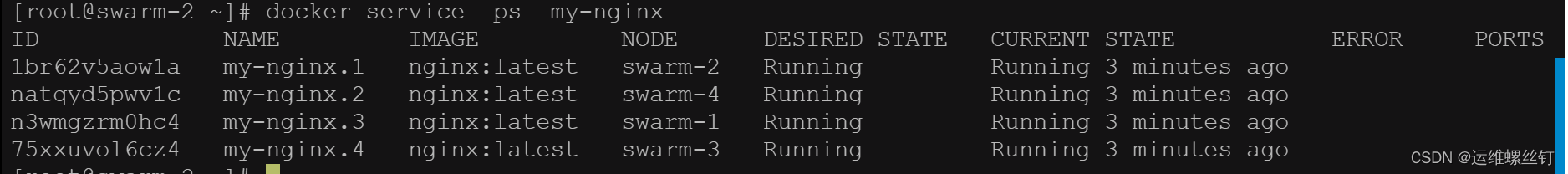

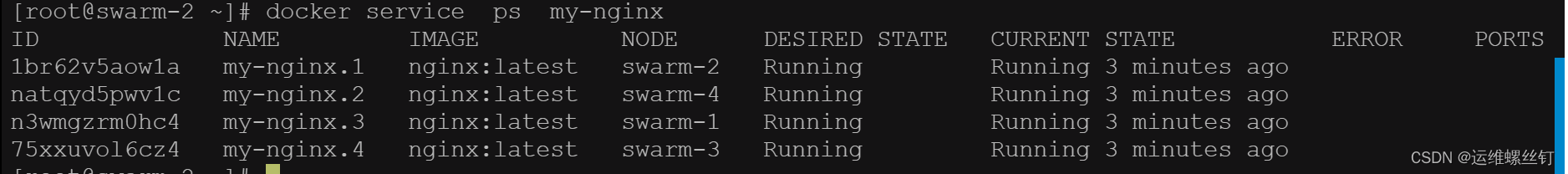

## 查看服务分别

docker service ps my-nginx

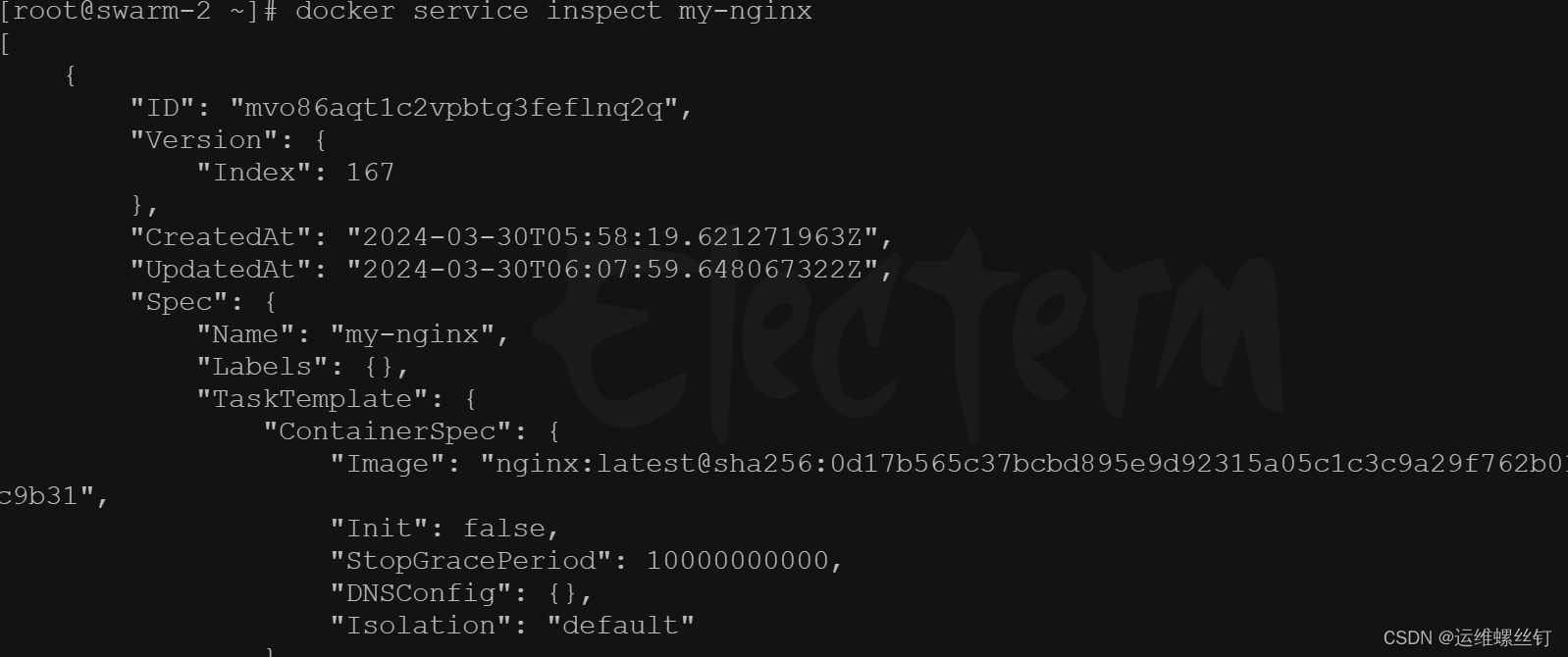

3、查看服务

- 查看服务详情

docker service inspect my-nginx

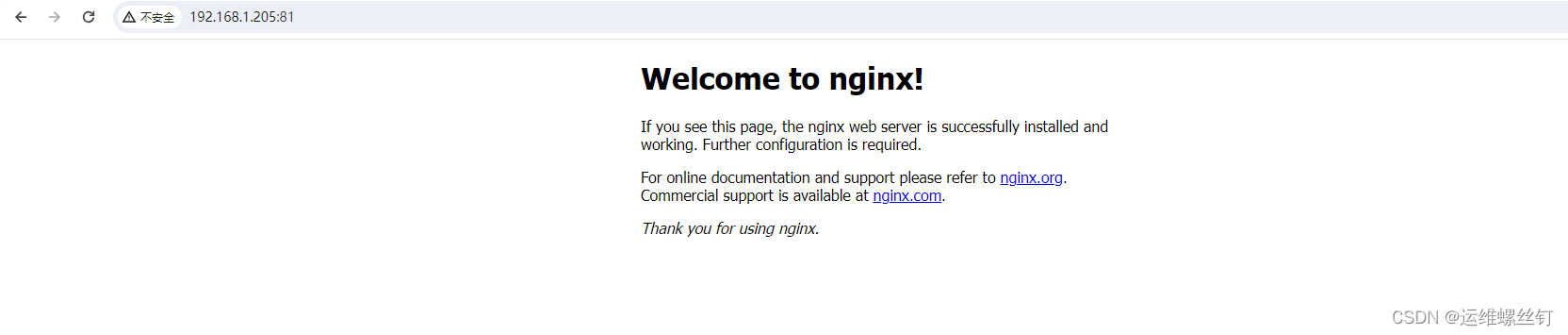

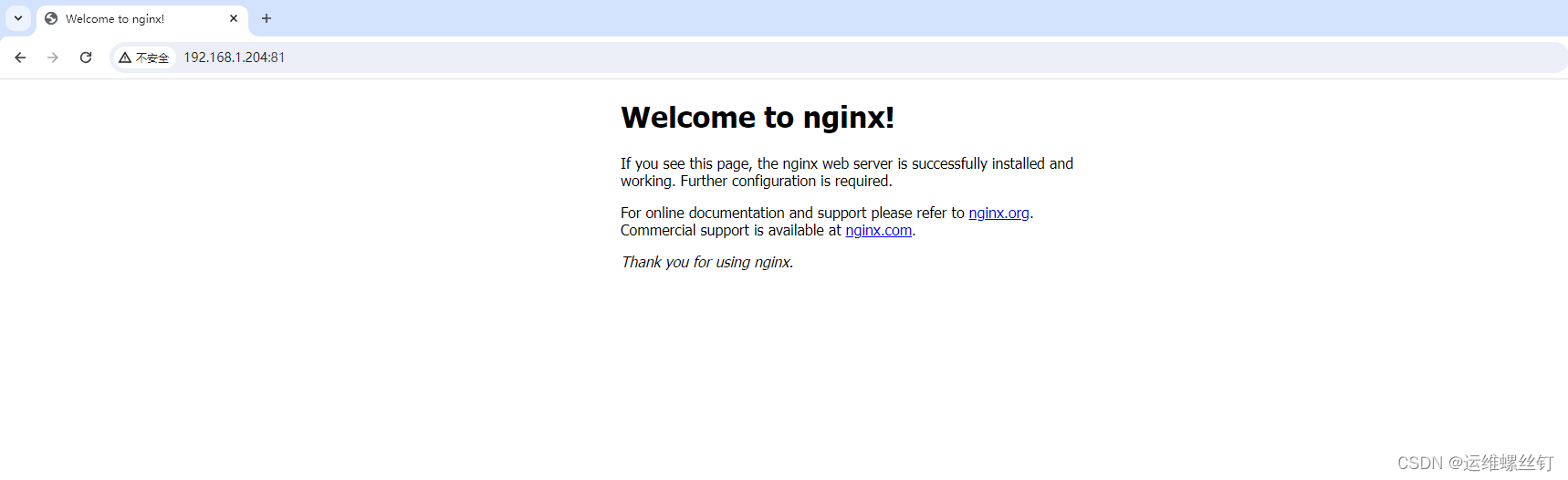

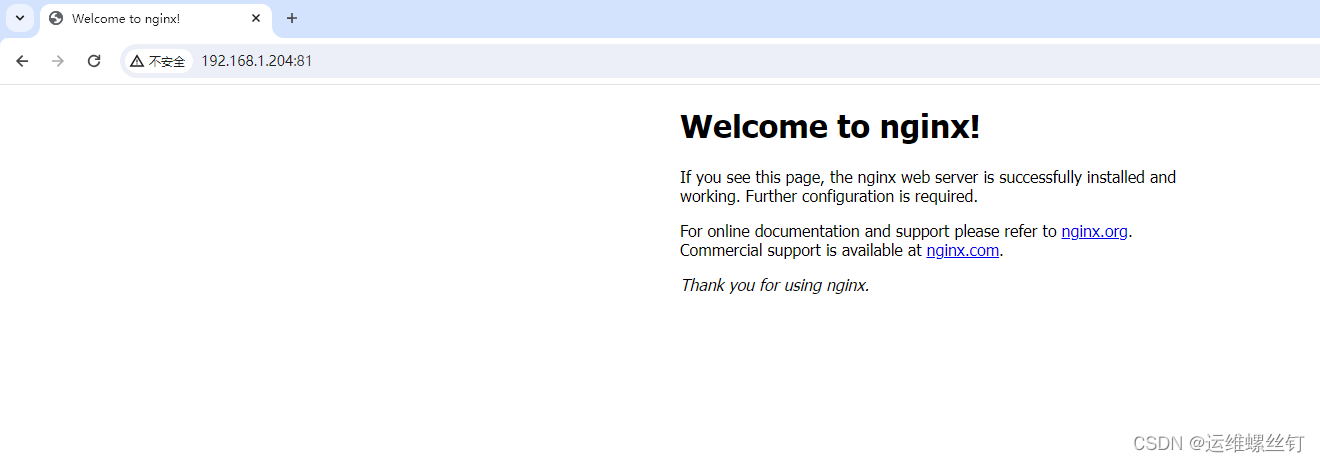

4、调用服务

- 集群的任意节点IP都可以进行访问

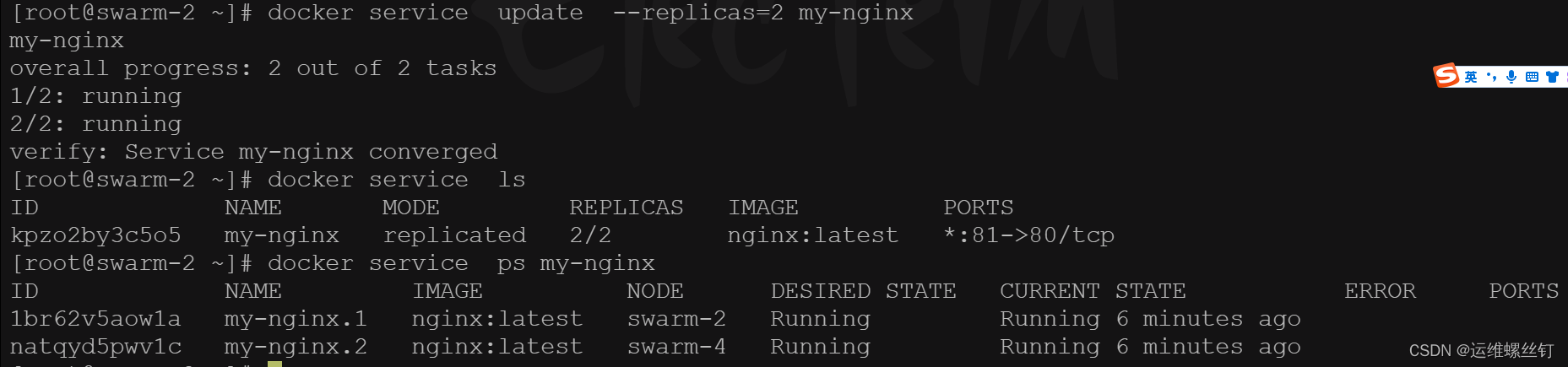

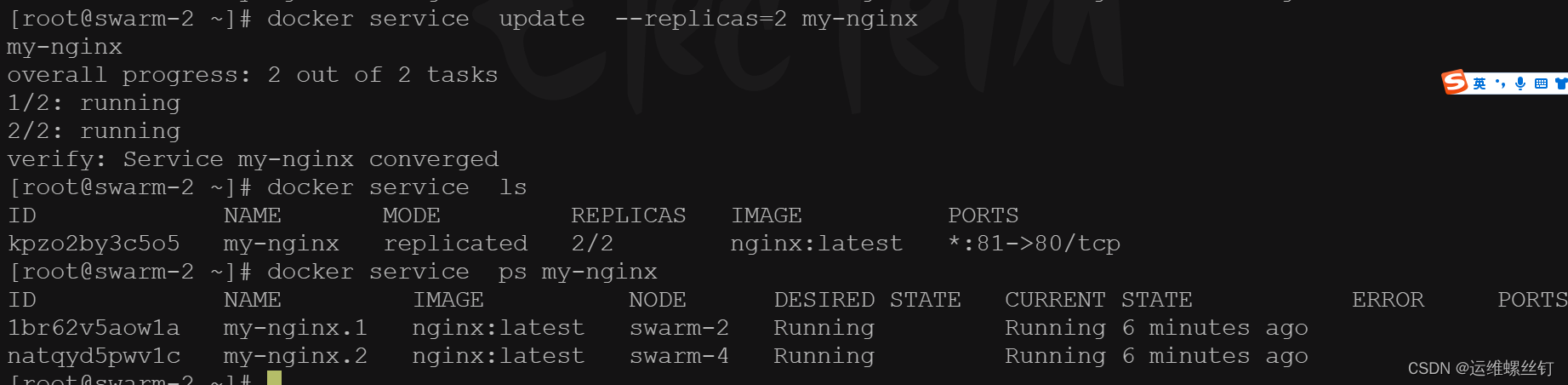

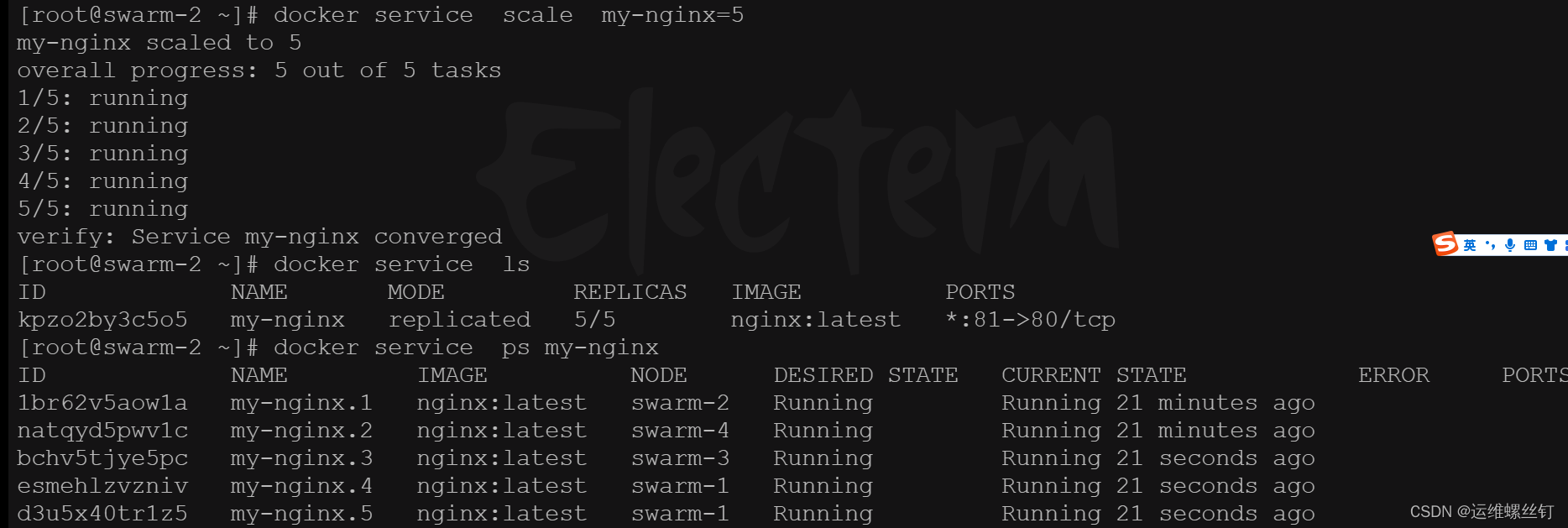

5、弹性服务

使用 updata 和scale 都可以进行容器扩缩容

docker service update --replicas=2 my-nginx

docker service scale my-nginx=5

缩减为两个副本,依旧可以在任何节点进行访问

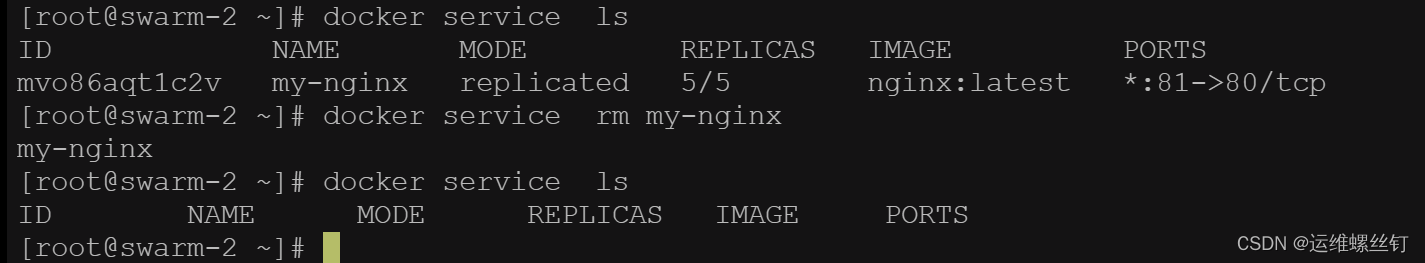

6、删除服务

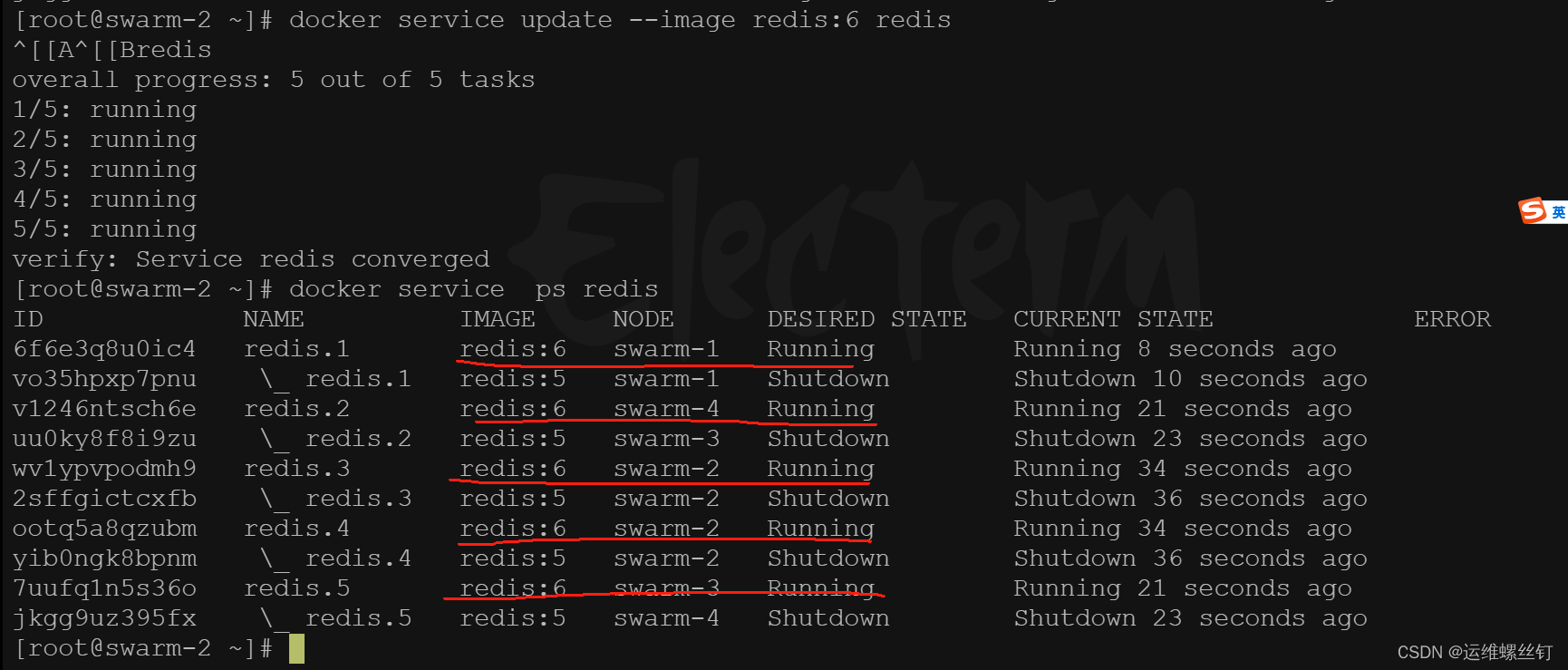

六、Docker Swarm实践之滚动更新

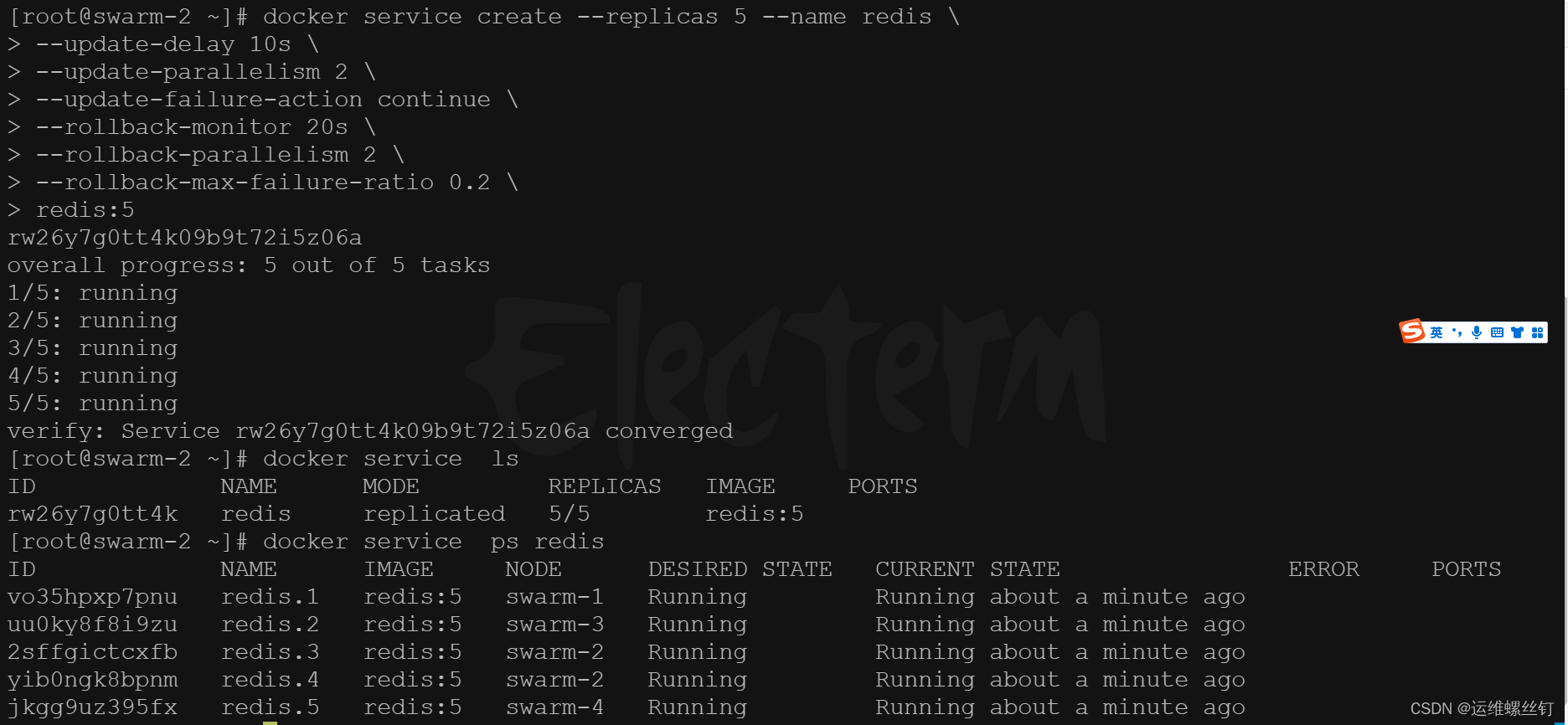

以下案例将演示 Redis 版本如何滚动升级至更高版本再回滚至上一次的操作。

首先,创建 5 个 Redis 服务副本,版本为 5,详细命令如下:

# 创建 5 个副本,每次更新 2 个,更新间隔 10s,20% 任务失败继续执行,超出 20% 执行回滚,每次回滚 2 个

docker service create --replicas 5 --name redis \

--update-delay 10s \

--update-parallelism 2 \

--update-failure-action continue \

--rollback-monitor 20s \

--rollback-parallelism 2 \

--rollback-max-failure-ratio 0.2 \

redis:5

–update-delay:定义滚动更新的时间间隔;

–update-parallelism:定义并行更新的副本数量,默认为 1;

–update-failure-action:定义容器启动失败之后所执行的动作;

–rollback-monitor:定义回滚的监控时间;

–rollback-parallelism:定义并行回滚的副本数量;

–rollback-max-failure-ratio:任务失败回滚比率,超过该比率执行回滚操作,0.2 表示 20%。

然后通过以下命令实现服务的滚动更新

docker service update --image redis:6 redis

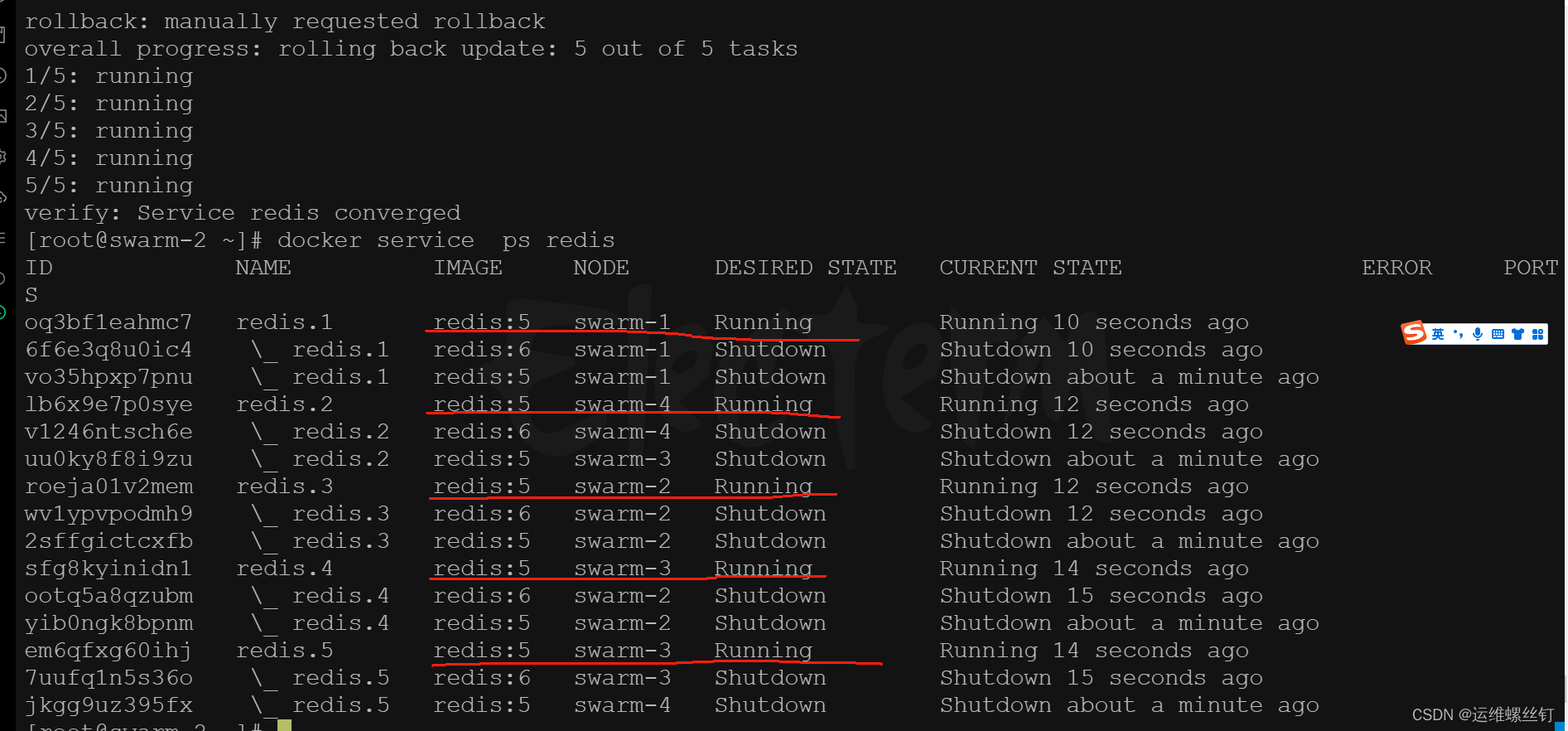

回滚服务,只能回滚到上一次操作的状态,并不能连续回滚到指定操作。

docker service update --rollback redis

七、Docker Swarm常用命令

1、 docker swarm常用命令

| 命令 | 说明 |

|---|---|

| docker swarm init | 初始化集群 |

| docker swarm join-token worker | 查看工作节点的 token |

| docker swarm join-token manager | 查看管理节点的 token |

| docker swarm join | 加入集群 |

2、docker node常用命令

| 命令 | 说明 |

|---|---|

| docker node ls | 查看集群所有节点 |

| docker node ps | 查看当前节点所有任务 |

| docker node rm | 节点名称节点 删除节点(-f强制删除) |

| docker node inspect 节点名称 | 节点ID 查看节点详情 |

| docker node demote 节点名称 | 节点ID 节点降级,由管理节点降级为工作节点 |

| docker node promote 节点名称 | 节点ID 节点升级,由工作节点升级为管理节点 |

| docker node update 节点名称 | 节点ID 更新节点 |

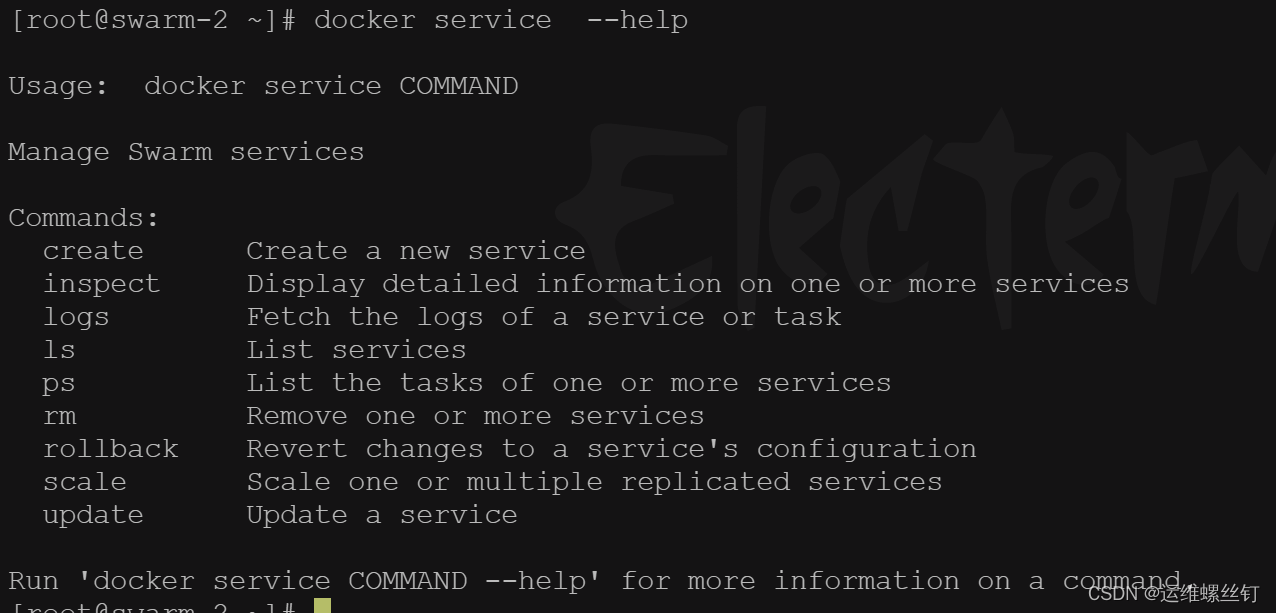

3、docker service常用命令

| 命令 | 说明 |

|---|---|

| docker service create | 创建服务 |

| docker service ls | 查看所有服务 |

| docker service inspect 服务名称 | 服务ID 查看服务详情 |

| docker service logs 服务名称 | 服务ID 查看服务日志 |

| docker service rm 服务名称 | 服务ID 删除服务(-f强制删除) |

| docker service scale 服务名称 | 服务ID=n 设置服务数量 |

| docker service update 服务名称 | 服务ID 更新服务 |

八、docker stack 部署docker-compose集群

docker-compose官网文档

stack deploy命令

工具文档

1.Stack 是基于 Docker Swarm 之上来完成应用的部署。

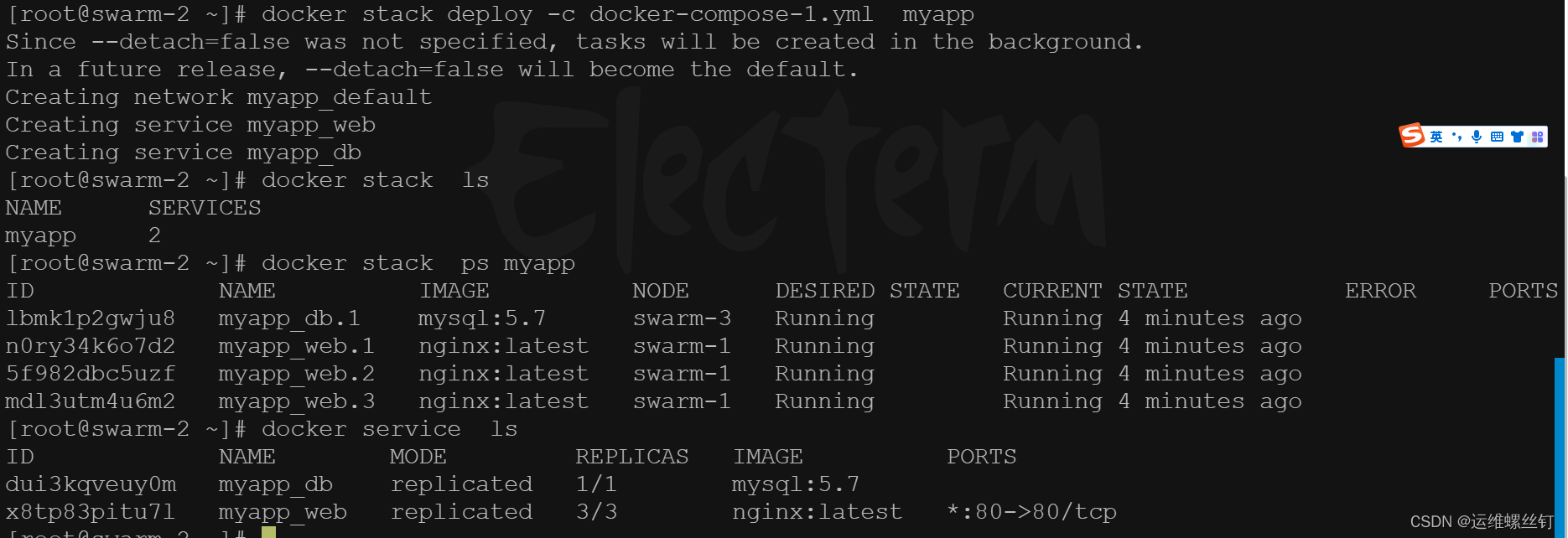

2.步骤很简单。在 Compose 文件中定义应用,然后通过 docker stack deploy 命令完成部署和管理。

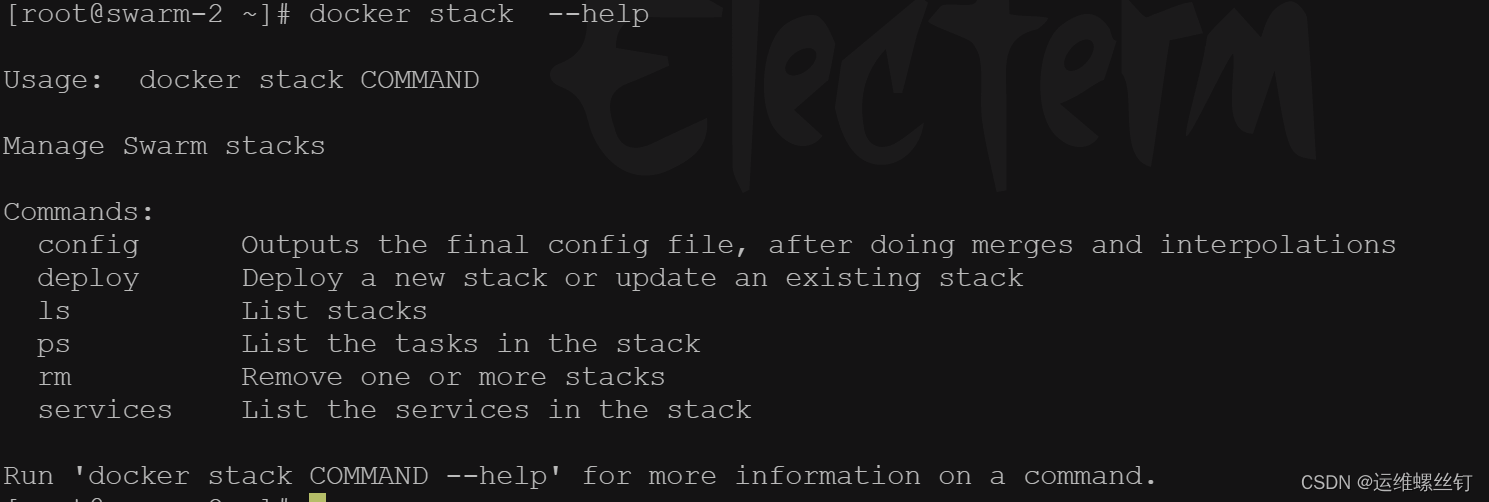

1、docker stack 命令

- yaml资源清单

version: '3.8'services:web:image: nginx:latestports:- "80:80"deploy:replicas: 3restart_policy:condition: anyplacement:constraints:- node.role == workerdb:image: mysql:5.7environment:MYSQL_ROOT_PASSWORD: exampleMYSQL_DATABASE: myappdeploy:replicas: 1restart_policy:condition: on-failureplacement:constraints:- node.role == manager