2024年3月18日,马斯克的AI创企xAI兑现承诺,正式发布了此前备受期待大模型Grok-1。

代码和模型权重已上线GitHub: https://github.com/xai-org/grok-1

截止目前,Grok已经在GitHub上获得了35.2k颗Star,还在不断上升中。

Grok官方博客介绍:https://x.ai/blog/grok-os

遵照Apache 2.0协议开放了Grok-1混合专家模型的权重与架构,Grok-1其参数量达到了3140亿,远超OpenAI GPT-3.5的1750亿,这是迄今为止参数量最大的开源大语言模型。

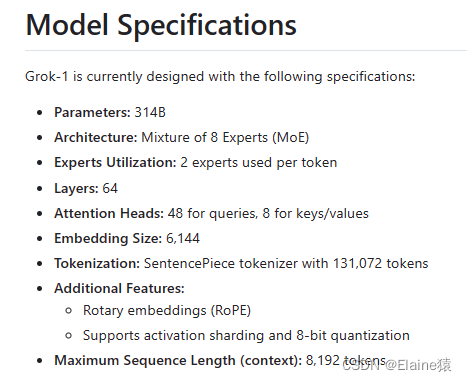

Grok-1模型的技术细节和设计规格如下:

- 基于大量文本数据上训练的基础模型,没有针对任何特定任务进行微调。

- 混合专家模型(MoE):采用混合专家系统设计,每个token从8个专家中选择2个进行处理。

- 参数数量:拥有3140亿个参数,激活权重占25%。也就是有860亿激活参数,显示出模型处理语言任务的潜力。

- 包含64个Transformer层,每层都有多头注意力块和密集块,注意力头数为查询48个,键/值8个。

- 使用旋转位置嵌入 (RoPE)处理序列数据,Tokenization词汇量为131072,嵌入大小为6144。

- 提供8位量化的权重,有助于减少模型的存储和计算需求,适合资源有限的环境。

- 运行要求:模型规模巨大(314B参数),需要具有足够GPU内存的机器运行,以每参数2字节来算,大概需要628GB的GPU内存(一张性价比最高的4090有24G显存,大概二三十张4090)。

- xAI 于 2023 年 10 月在 JAX 和 Rust 上使用自定义训练堆栈从头开始训练。

使用指南

当前,Grok-1 面向所有人开放,而要开始使用该模型,可以先确保下载 checkpoint 并将 ckpt-0 目录放入 checkpoint。然后,运行:

pip install -r requirements.txt

python run.py

进而测试代码。

脚本在测试输入上加载检查点和模型样本。

值得注意的事,Grok-1 参数量高达 314B 个参数,其模型体积庞大,需要配备足够 GPU 内存的机器才能使用示例代码测试模型。

xAI 团队在 GitHub 项目仓库里面也直言道:该资源库中 MoE 层的实现并不高效。选择这种实现方式是为了避免需要定制内核来验证模型的正确性。

你可以使用 torrent 客户端和下面磁铁链接下载权重:

magnet:xt=urn:btih:5f96d43576e3d386c9ba65b883210a393b68210e&tr=https%3A%2F%2Facademictorrents.com%2Fannounce.php&tr=udp%3A%2F%2Ftracker.coppersurfer.tk%3A6969&tr=udp%3A%2F%2Ftracker.opentrackr.org%3A1337%2Fannounce

既然用户可以免费将Grok用于商业用途,进行修改和分发,而且没有附加条款,

那Grok的开源无疑将为人工智能技术的发展和应用带来新的机遇,并为互联网创作者提供新的舞台。

)

)

)

![[AIGC] 在Spring Boot中指定请求体格式](http://pic.xiahunao.cn/[AIGC] 在Spring Boot中指定请求体格式)