基本概念

统计学是一门研究数据收集、分析、解释和展示的科学,它提供了一套方法论,用于理解数据并从数据中得出结论。统计学在各个领域都有应用,包括经济学、医学、工程学、社会科学等。以下是统计学的一些基本概念:

描述性统计(Descriptive Statistics)

描述性统计涉及数据的组织、汇总和展示。这些方法使我们能够以简洁的方式理解和描述数据集的主要特征,而无需对每个数据点进行单独考察。

- 中心趋势的度量:包括平均值(mean)、中位数(median)、众数(mode),用于描述数据集的中心点或典型值。

- 变异性的度量:包括方差(variance)、标准差(standard deviation)、范围(range)等,用于衡量数据点之间的差异或离散程度。

- 分布的形状:偏态(skewness)和峰度(kurtosis)描述了数据分布的形状,包括对称性和数据分布的尾部厚度。

推断性统计(Inferential Statistics)

推断性统计使用从样本中收集的数据来推断或做出结论关于更大的总体。这包括估计总体参数和假设检验。

- 参数估计:利用样本统计量(如样本均值)来估计总体参数(如总体均值)。置信区间(confidence intervals)为参数估计提供了一个可能的范围。

- 假设检验:用于测试关于总体参数的假设是否成立。常见的假设检验方法包括t检验、卡方检验、ANOVA等。

- 概率分布:在推断性统计中,概率分布(如正态分布、t分布)是核心概念,它们用于建模和推断数据生成过程。

概率论(Probability)

概率论是统计学的基础,提供了量化不确定性的数学语言和工具。概率可以用于描述和预测随机事件的结果。

- 随机变量:一个随机过程的结果,可以是离散的(如抛硬币的结果)或连续的(如测量的身高)。

- 概率分布:描述了一个随机变量取各种可能值的概率。离散随机变量的概率分布称为概率质量函数(PMF),而连续随机变量的概率分布称为概率密度函数(PDF)。

数据收集与实验设计(Data Collection and Experimental Design)

- 数据类型:根据测量级别不同,数据可以分类为定类(nominal)、定序(ordinal)、等距(interval)和等比(ratio)数据。

- 采样方法:如简单随机抽样、分层抽样、系统抽样等,是从总体中选取样本的方法。

- 实验设计:为了确保收集的数据能够有效地回答研究问题,需要精心设计实验和观察研究。

统计学提供的方法和原则帮助我们有效地从数据中提取信息,进行合理的推断和做出科学的决策。在AI领域,统计学方法被广泛应用于数据分析、模型评估和结果解释中。

在AI中的应用

假设检验和置信区间

在人工智能(AI)和机器学习领域,假设检验和置信区间是两种重要的统计工具,它们用于评估和比较不同模型或算法的性能。这些工具帮助研究者量化模型性能的不确定性,从而做出更加科学和客观的决策。

假设检验

假设检验是一种统计方法,用于检验关于总体参数的假设是否成立。在AI中,假设检验常用于比较两个或多个模型的性能,判断性能差异是否显著,或者验证模型改进是否有效。

- 两样本t检验:比较两个独立模型在同一数据集上的性能(例如,准确率、召回率等指标)是否有显著差异。假设两组性能数据分别来自两个正态分布,且方差相等。

- 配对样本t检验:当在相同的数据集上比较两个模型,并且每个数据点对应的性能指标都成对出现时,使用配对样本t检验可以考虑数据点间的配对关系,从而减少变异性对检验结果的影响。

- ANOVA(方差分析):当需要比较多个模型的性能时,ANOVA能够帮助判断至少一个模型的性能是否显著不同。

置信区间

置信区间是一种表示参数估计不确定性的方法。在模型评估中,通过为模型性能指标计算置信区间,可以量化估计的准确性和稳定性。

- 模型性能的置信区间:例如,计算一个模型准确率的95%置信区间,可以告诉我们,在95%的情况下,模型的真实准确率落在该区间内。这有助于我们理解模型性能的变异性和可靠性。

- 比较不同模型:通过比较不同模型性能指标的置信区间,可以更加直观地判断它们之间是否存在显著差异。如果两个模型的置信区间没有重叠,通常意味着它们的性能存在显著差异。

在AI中的应用

- 模型选择:在选择最佳模型时,除了考虑模型的平均性能,还应考虑模型性能的不确定性和稳定性。假设检验和置信区间为此提供了量化的方法。

- 算法改进验证:当对现有算法进行改进时,通过假设检验可以验证改进是否导致了性能的显著提升。

- 报告研究结果:在撰写科学论文或报告时,提供模型性能指标的置信区间和通过假设检验得出的显著性结果,可以增加研究的可信度和透明度。

总之,假设检验和置信区间是评估和比较机器学习模型性能的重要工具。它们帮助研究人员在存在数据变异性和不确定性的情况下,做出更加客观和科学的决策。

回归分析

回归分析是统计学中一种重要的预测和关系量化方法,它通过建立一个或多个自变量(解释变量)与因变量(目标变量)之间的数学关系模型来预测目标变量的值或趋势。在人工智能(AI)和机器学习领域,回归分析被广泛应用于从历史数据中学习,以预测未来事件或量化变量之间的关系。

回归分析的主要类型

-

线性回归(Linear Regression):

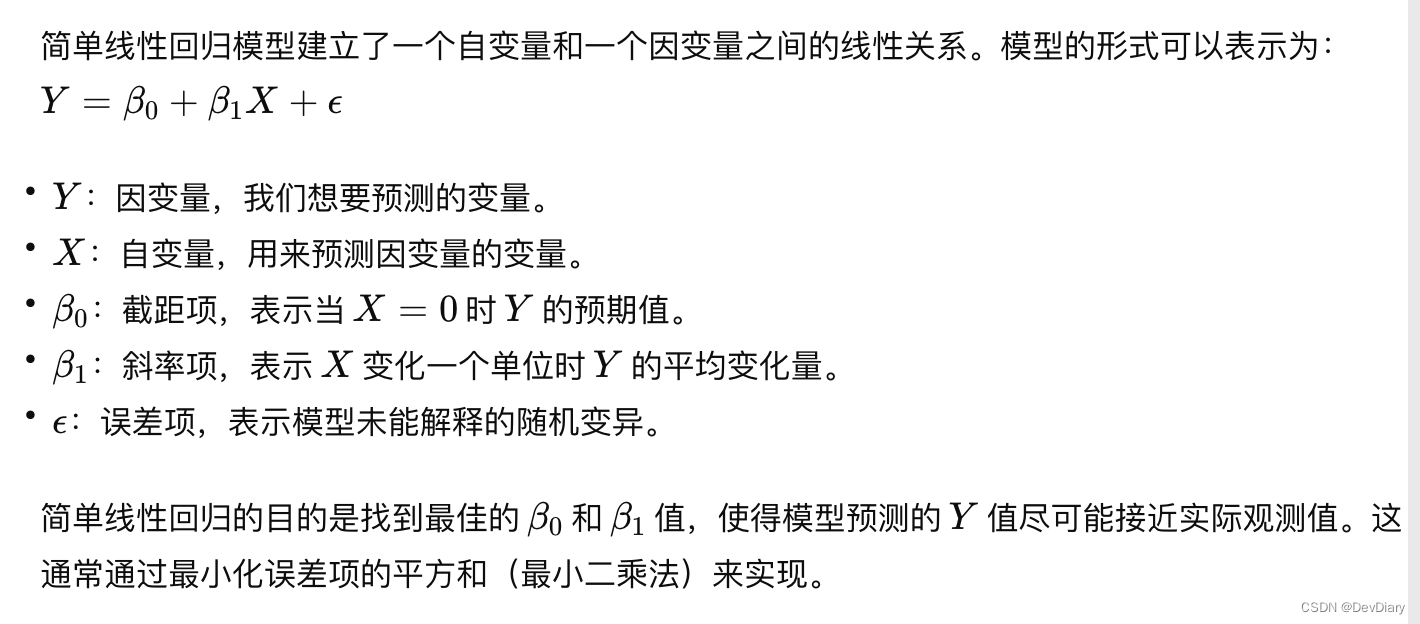

- 简单线性回归:

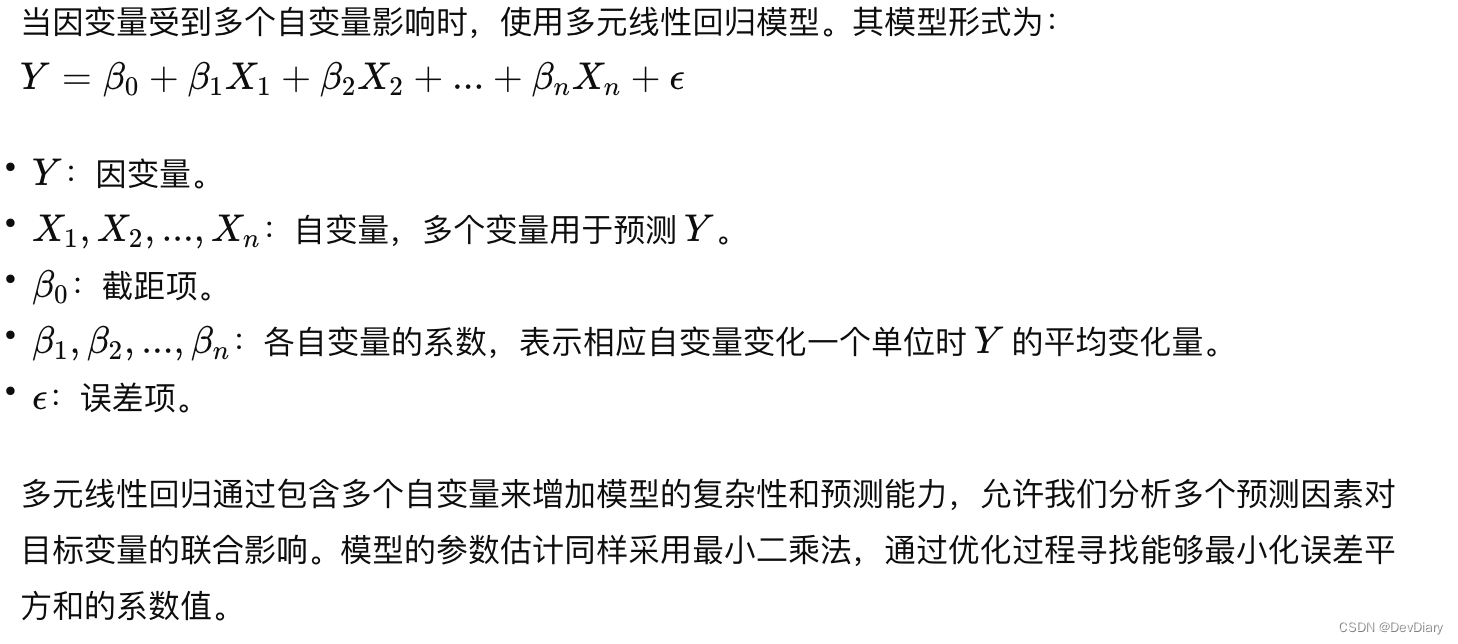

2.多元线性回归:

-

逻辑回归(Logistic Regression):

- 尽管名为“回归”,但逻辑回归实际上是用于分类问题,特别是二分类问题。它通过对数几率(logit)函数将线性回归模型的输出映射到0和1之间,从而预测事件发生的概率。

-

多项式回归(Polynomial Regression):

- 当数据与自变量之间的关系不是线性的,而更适合于多项式时,可以使用多项式回归。模型形式类似于多元线性回归,但会包含自变量的高次项。

-

岭回归(Ridge Regression)和套索回归(Lasso Regression):

- 这两种回归技术通过在损失函数中添加正则化项来减少模型的复杂度,从而防止过拟合。岭回归添加的是L2正则化项,而套索回归添加的是L1正则化项。

在AI中的应用

- 预测分析:回归分析是进行预测分析的基础工具,比如预测房价、销售额、股票价格等。

- 特征关系的量化:通过回归模型,可以量化自变量对因变量的影响程度,了解哪些因素对结果有显著影响。

- 决策支持:回归分析为决策提供了数据支持,帮助企业和组织制定基于数据的策略。

- 评估算法性能:在机器学习中,回归分析常用于评估和比较不同算法的性能。

总之,回归分析在数据科学、AI和机器学习中扮演着核心角色,它不仅用于预测,也是理解和量化变量之间关系的强大工具。通过构建和分析回归模型,研究人员和数据科学家可以从数据中提取有价值的洞察,并应用这些洞察来解决实际问题。

】二叉树的顺序结构--堆的实现/堆排序/topk问题详解---二叉树学习日记②1)

ffmpeg的相关命令,以及JAVA操作ffmpeg)

pulsar可视化消息管理工具)

![[Qt学习笔记]Qt下使用Halcon实现采图时自动对焦的功能(Brenner梯度法)](http://pic.xiahunao.cn/[Qt学习笔记]Qt下使用Halcon实现采图时自动对焦的功能(Brenner梯度法))

安装教程)