Principled Instructions Are All You Need for Questioning LLaMA-1/2, GPT-3.5/4

相关链接:arxiv

关键字:Questioning LLaMA、GPT-3.5/4、guiding principles、prompting、large language models

摘要

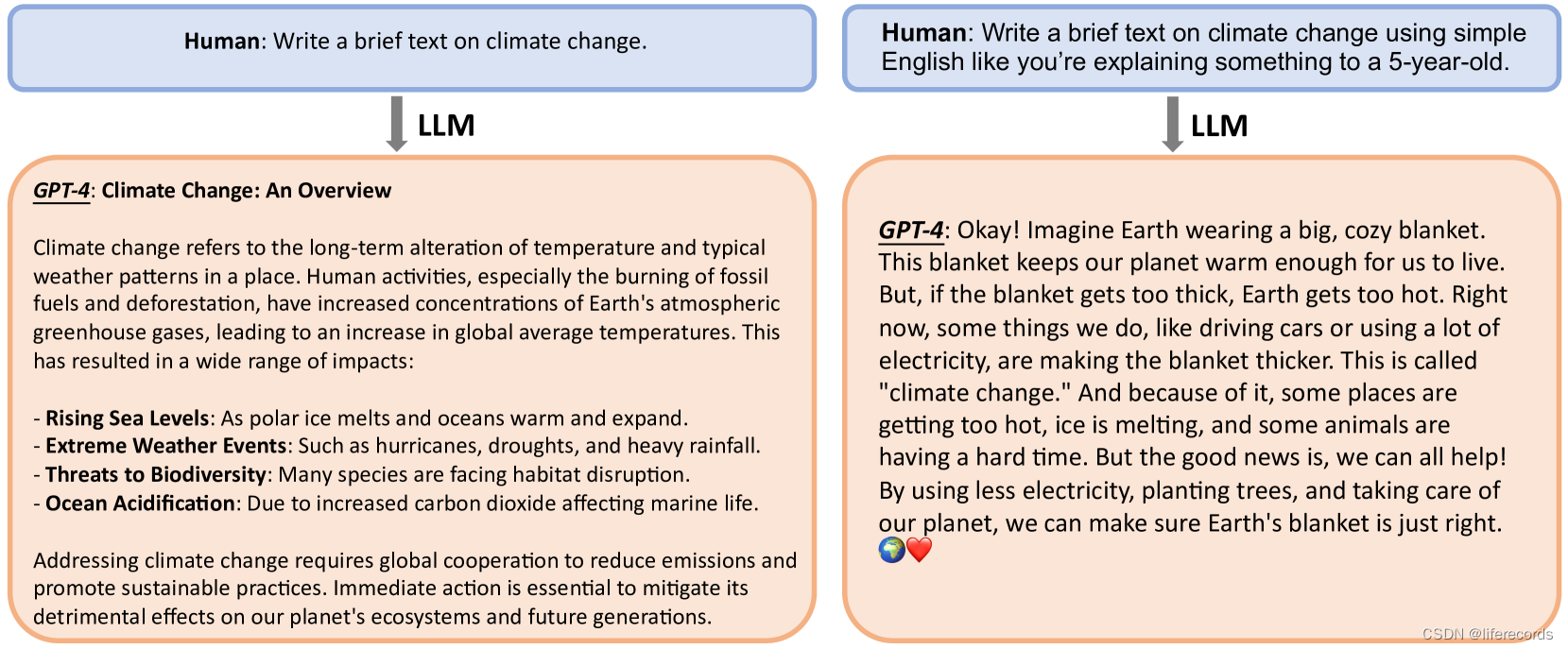

本文介绍了26个旨在简化查询和提示大型语言模型(Large Language Models, LLMs)过程的指导原则。我们的目标是简化为各种规模的大型语言模型制定问题、检验它们的能力并增强用户对于输入不同提示时不同规模的大型语言模型行为的理解的概念。我们在LLaMA-1/2(7B、13B和70B)、GPT-3.5/4上进行了广泛的实验,以验证所提出原则在指令和提示设计上的有效性。我们希望这项工作能为从事大型语言模型提示的研究人员提供更好的指导。项目页面位于GitHub。

核心方法

- 简洁性和清晰性:避免过度冗长或含糊不清的提示,以免让模型混淆或导致不相关的回应。

- 语境相关性:提示必须提供有助于模型理解任务背景和领域的相关语境。

- 任务对齐:提示应与手头任务紧密对齐,使用清晰指示任务性质的语言和结构。

- 示例演示:对于更复杂的任务,在提示中包含示例,展示期望的回应格式或类型。

- 避免偏见:设计提示以减少激活模型由于其训练数据而固有的偏见。

- 渐进式提示:对于需要一系列步骤的任务,提示可以逐步引导模型。

实验说明

- 实验设置:评估是在ATLAS基准上进行的,这是一个手工制作的实验,用于评估原则提示。

- 模型和指标:我们使用训练有素的LLaMA-1-{7,13},LLaMA-2-{7,13},LLaMA-2-70B-chat,GPT-3.5 (ChatGPT) 和 GPT-4 作为基础模型。我们将这些模型分为不同规模:小规模(7B模型),中等规模(13B)和大规模(70B,GPT-3.5/4)。

提升

- 提升结果显示,纳入所引入的原则后所有原则都能显著改善三个规模LLMs的表现力。特别是对于原则14,在所有它适用的问题上表现出改进。

正确性

- 绝对准确率:检验各种规模模型在应用原则后的绝对性能。普遍来说,这些模型在平均性能上达到了20%-40%的准确性。特别是对于小规模和中等规模模型来说,准确性通常可以达到10%-40%,对于大型模型,准确性可以超过40%。

结论

我们通过详尽的分析展示了26个原则,这些原则提高了LLM关注输入上下文的关键要素的能力,从而生成高质量的回应。通过在处理输入之前用精心制作的原则引导LLM,可以鼓励模型产生更优质的回应。我们的经验结果证明,这一策略可以有效地重塑可能损害输出质量的上下文,从而增加回应的相关性、简洁性和客观性。

未来的研究方向众多。在我们的实验中,我们使用了限制性提示方法来应用这些原则。有潜力进一步校准我们的基础模型,以与我们的原则说明更加吻合,例如通过微调、强化学习、直接偏好优化或使用我们生成的数据集进行不同的提示方法。此外,证明成功的策略可以被集成到标准的LLM操作中,例如通过微调具有原始/原则提示为输入和擦亮、原则回应为训练目标。

丨从SDRAM到DDR3的IP核设计)

(35))

![[linux]信号处理:信号编码、基本API、自定义函数和集合操作的详解](http://pic.xiahunao.cn/[linux]信号处理:信号编码、基本API、自定义函数和集合操作的详解)

)