Q学习是一种强化学习算法,用于指导代理(Agent)在给定环境中如何采取最优行动。它通过学习状态中的行动价值来实现,属于从与环境的交互中学习,通过尝试和错误,以实现目标的机器学习算法。

下面是Q学习工作原理的概述:

-

目标:Q学习的主要目标是学习一个策略,告诉代理在什么情况下采取什么行动。它不需要环境的模型(使其成为一种无模型方法),并且能够处理具有随机转移和奖励的问题,无需调整。

-

Q值(动作值)函数:Q学习的核心是Q值函数,记为Q(s,a)。这个函数给出在状态s下采取行动a的价值,考虑到长期回报。目标是在每个状态的所有可能行动中最大化这个函数。

-

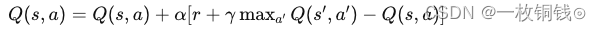

Q学习公式:算法的核心基于贝尔曼方程,使用以下方程更新状态-行动对的Q值:

其中:

其中:- s 是当前状态,

- a 是当前行动,

- ′s′ 是采取行动a后的新状态,

- ′a′ 是从状态′s′可能采取的行动,

- r 是从s移动到′s′后收到的立即奖励,

- α 是学习率(0 < α ≤ 1),

- γ 是折现因子(0 ≤ γ < 1),模型化未来奖励的重要性。

-

学习过程:代理在一系列的事件中与环境交互。在每一步中,代理:

- 观察当前状态,

- 根据当前Q值派生的策略选择一个行动(例如,ϵ-贪婪策略),

- 执行行动并接收奖励,

- 观察新状态,

- 根据收到的奖励和最大未来奖励,使用Q学习公式更新之前的状态-行动对的Q值,

- 重复这个过程,直到达到终止状态。

-

策略:一旦Q值被充分学习,可以通过为每个状态选择最高Q值的行动来派生策略。

)

,批量改成“宋体小四、1.5倍行距、蓝色字体”)

深度解析!)

返回的fig和ax是什么?)