ETL:数据转换与集成的关键过程

在现代数据驱动的世界中,有效地管理和处理数据对于企业的成功至关重要。ETL(提取、转换、加载)是一种关键的数据处理过程,有助于将数据从源系统提取、清洗、转换并加载到目标系统中,以供进一步分析和应用。本文将详细介绍ETL的基本概念、工作流程以及它在数据集成领域的重要性。

一、ETL的基本概念

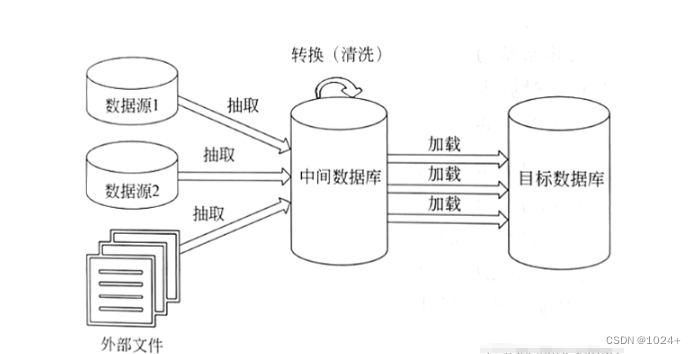

ETL代表提取(Extraction)、转换(Transformation)和加载(Loading)。它是一种数据预处理过程,用于将原始数据从各种源系统(如数据库、文件、API等)中提取出来,进行清洗、转换和格式化,然后加载到目标系统(如数据仓库、数据湖等)中。ETL过程确保了数据的准确性、一致性和可用性,为后续的数据分析和决策提供了有力支持。

二、ETL的工作流程

- 提取(Extraction)

提取阶段涉及从源系统中获取原始数据。这些数据可能来自关系型数据库、NoSQL数据库、API、平面文件(如CSV、Excel)等。提取过程需要确保数据的完整性和准确性,以便在后续阶段进行正确处理。

- 转换(Transformation)

转换阶段是ETL过程中最具挑战性的部分。在这一阶段,原始数据将经过清洗、验证、合并、计算、重新格式化等一系列操作,以满足目标系统的要求。数据清洗可以消除重复值、处理缺失值、纠正错误等。数据验证则确保数据的质量和准确性。此外,转换阶段还可能涉及数据类型的转换、数据编码的统一等操作。

- 加载(Loading)

加载阶段将转换后的数据加载到目标系统中。目标系统可能是一个数据仓库、数据湖或其他存储解决方案。在加载过程中,需要确保数据的完整性和一致性,以便后续的数据分析和挖掘。此外,加载阶段还需要考虑数据的性能优化和存储策略。

三、ETL在数据集成领域的重要性

- 提高数据质量

通过ETL过程,企业可以清洗和验证原始数据,消除重复值和错误,从而提高数据的质量和准确性。高质量的数据为企业提供了更可靠的决策支持。

- 实现数据一致性

ETL过程将数据从各种源系统转换并加载到目标系统中,确保了数据在不同系统之间的一致性和可比性。这有助于消除信息孤岛,提高企业内部各部门之间的协作效率。

- 提升数据分析效率

通过ETL处理后的数据更加规范化和结构化,便于后续的数据分析和挖掘。此外,加载到目标系统的数据已经过优化处理,可以更快地响应查询和报表生成等操作。

- 降低运营成本

ETL过程可以自动化地完成数据提取、转换和加载任务,减少了手动操作的需求和人力成本。同时,通过优化数据存储和访问策略,还可以降低硬件和存储成本。

四、总结

总之,ETL作为一种关键的数据处理过程,在数据集成领域发挥着重要作用。通过提取、转换和加载原始数据,ETL确保了数据的准确性、一致性和可用性,为企业提供了有力支持。在未来的数据驱动时代中,掌握ETL技术将成为企业成功的关键之一。

)

| @Prop装饰器)

)

)

)