NVIDIA在2月13日发布了Chat With RTX,这是一款类似于ChatGPT的免费个性化 AI 聊天机器人,可以在配备 Nvidia RTX 显卡的 PC 上本地运行。它使用Mistral或Llama开放权重LLM,可以搜索本地文件并回答有关它们的问题。本文中我们一起来了解一下Chat with RTX并搭建demo实际体验一下它的能力。

什么是Chat with RTX

Chat With RTX 是一款演示应用程序,可让您个性化连接到自己的内容(文档、笔记、视频或其他数据)的 GPT 大语言模型 (LLM)。利用检索增强生成 (RAG)、TensorRT-LLM和 RTX 加速,您可以查询自定义聊天机器人以快速获得上下文相关的答案。由于它全部在自己本地的 Windows RTX PC 或工作站上本地运行,因此您将获得快速、安全的结果。

系统要求

正常运行Chat with RTX需要满足如下的系统要求:

| 平台 | Windows |

| 图形处理器 | NVIDIA GeForce™ RTX 30 或 40 系列 GPU 或 NVIDIA RTX™ Ampere 或 Ada Generation GPU,具有至少 8GB VRAM |

| 内存 | 16GB 或更大 |

| 操作系统 | Windows 11 |

| 驱动 | 535.11 或更高版本 |

安装与设置

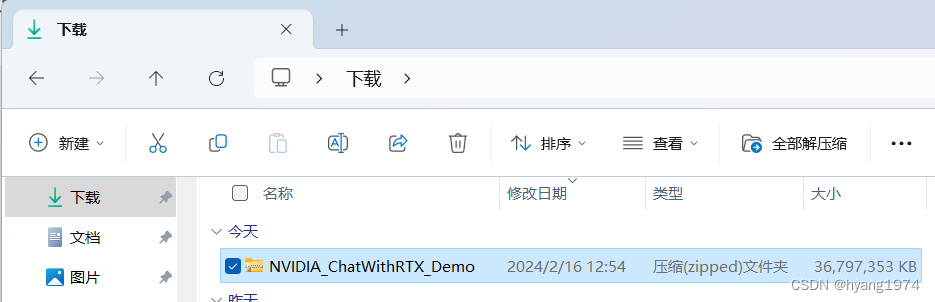

Chat with RTX测试版 0.2 于2 月 13 日发布。目前,它仅提供对 NVIDIA GeForce RTX 30 系列和 RTX 40 系列显卡的支持。可以通过NVIDIA官方链接直接下载。

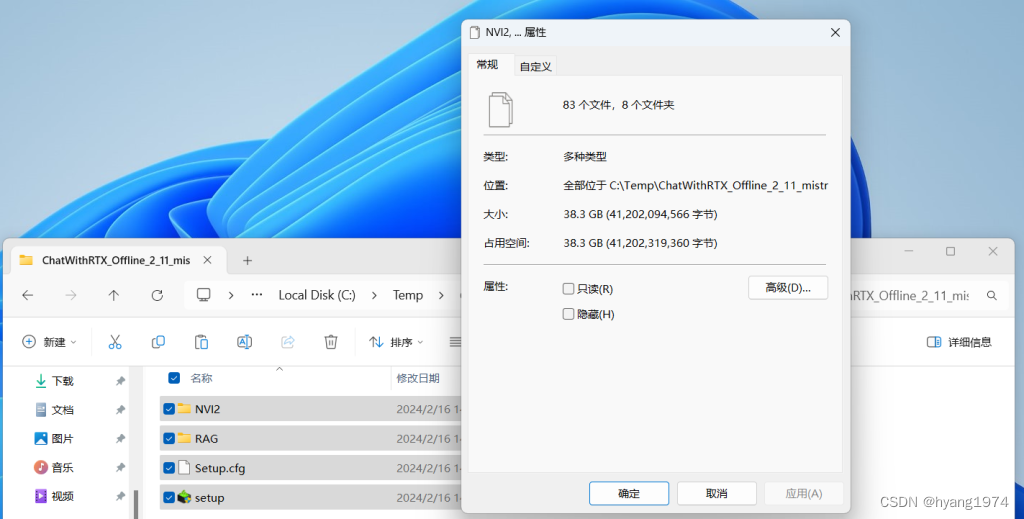

Chat with RTX的安装过程很简单,但需要一些时间;安装程序很大。安装过程看起来与安装 NVIDIA 显卡驱动程序时看到的相同,并包含执行全新安装的选项。安装文件压缩包大小约为35GB,解压缩后在38G左右。

安装两种语言模型(Mistral 7B 和 LLaMA 2)需要一个小时,而且它们占用的空间不到 70GB。安装后,命令提示符窗口将启动,并带有活动会话,您可以通过基于浏览器的界面提出查询。

实操体验Chat with RTX

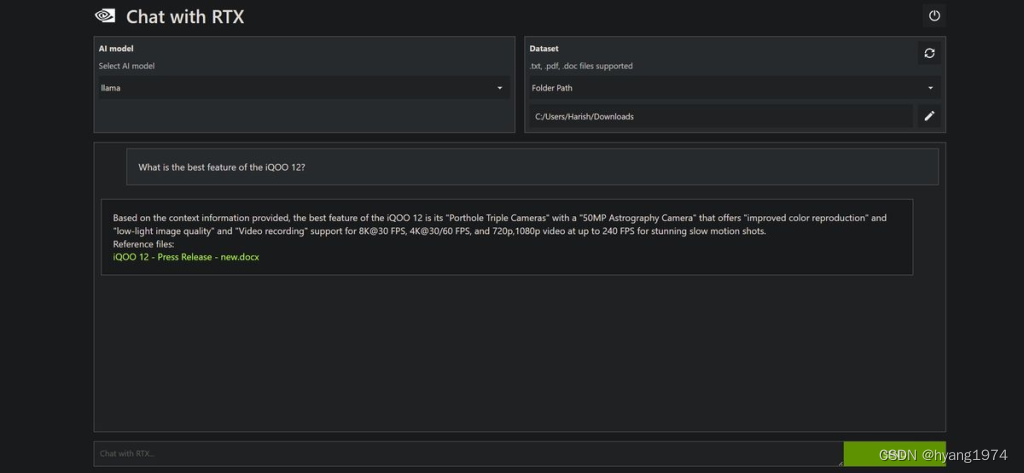

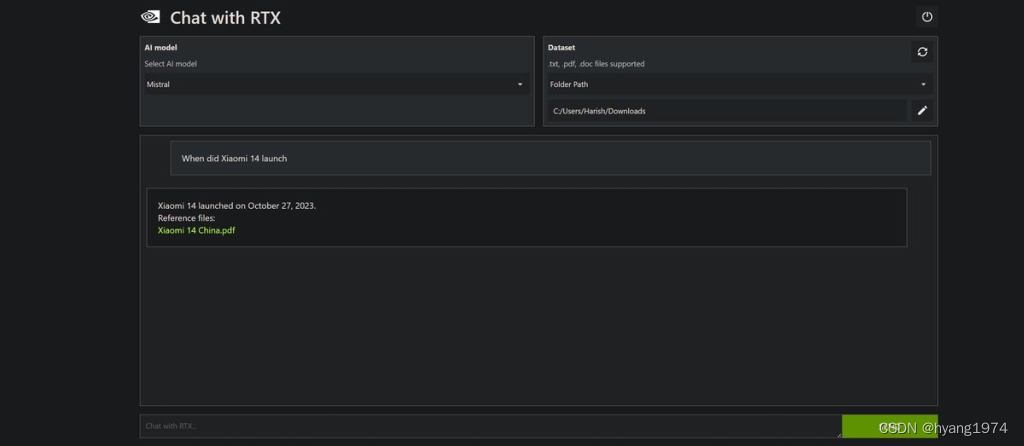

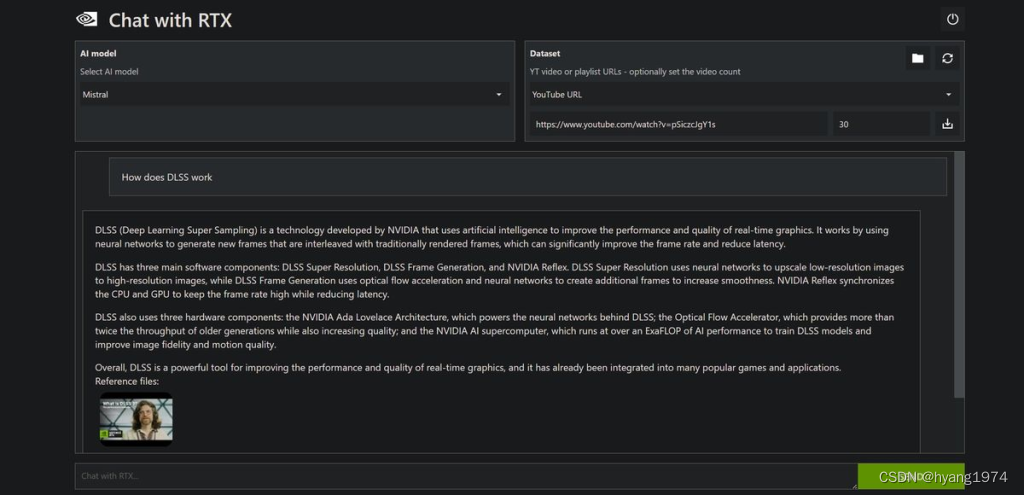

NVIDIA 提供了一个默认数据集来测试 Chat with RTX,但我将该实用程序指向了我的“下载”文件夹,其中包含数百篇新闻稿、审阅指南以及我的所有文本 (.txt) 格式的文章。该聊天机器人能够解析 PDF、Word 文档和纯文本,并且如前所述,您可以链接 YouTube 视频并提出疑问。

Chat with RTX 在总结细节方面做得很好,而且它对于有针对性的问题(例如手机的发布日期)非常有效。目前没有提出后续问题的规定,但这可能会在后续版本中发生变化。

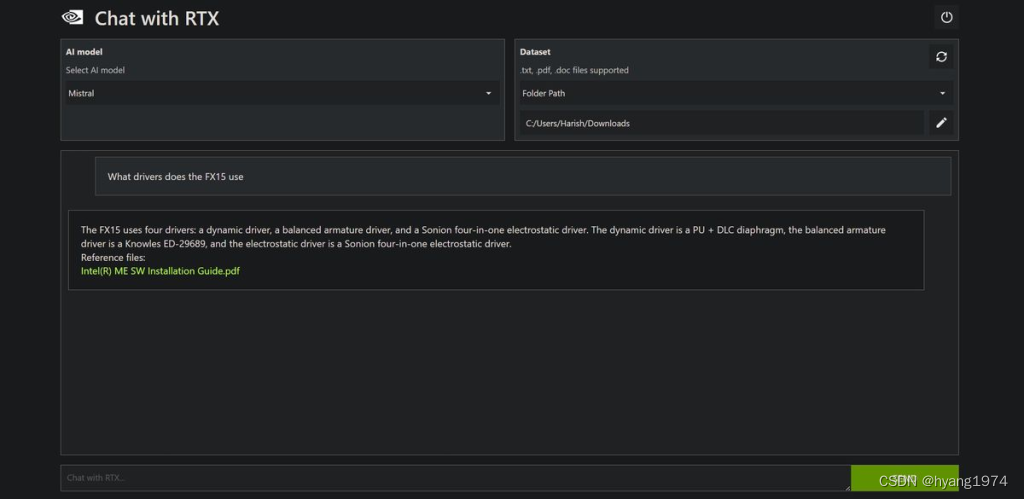

虽然它在显示相关信息方面做得很好,但也存在一些问题。我询问聊天机器人我在 Android Central 上查看过的Fiio FX15 IEM使用了哪些驱动程序。FX15 使用三种不同驱动程序的组合,虽然聊天机器人正确回答了查询,但它链接到英特尔管理引擎安装文档,而不是包含该信息的 Fiio驱动程序。

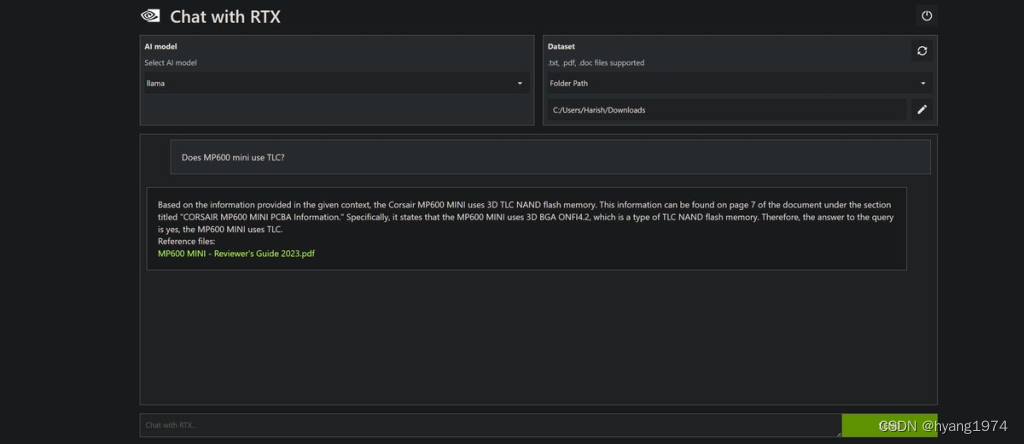

同样,我询问聊天机器人 Corsair 的 MP600 mini 是否使用 TLC 存储,它第一次的回答错误,在第二次提供正确答案。

Chat with RTX目前仍处于测试阶段,但显然有很大的潜力。在本地运行人工智能聊天机器人的能力非常重要,并且它可以很好地从您提供的数据中显示信息。就我自己的用例而言,拥有一个可以总结文档内容并突出显示有用细节的本地聊天机器人非常酷,这就是我今后将使用 Chat with RTX 实现的目的。

如果对 NVIDIA 提供的功能感兴趣,您可以轻松地在自己的计算机上安装 Chat with RTX 并尝试一下 — 它可能不如 ChatGPT 强大,但使用您自己的数据的能力是一个很好的差异化因素。

)

—— 特征工程+xgboost股票预测)

,并编写makefile进行编)

![PaddleSeg分割框架解读[01] 核心设计解析](http://pic.xiahunao.cn/PaddleSeg分割框架解读[01] 核心设计解析)