神经网络不需要弄明白原理,只要会应用就行,这是真的吗?

具体情况具体分析。如果你是论文要求不高,那么就不需要搞太清楚,如果你的毕业要求高,或者想要更高的提升,尤其是想申博、进大厂,那么还是懂一下吧。

不过我也知道有很多人可能会学的比较迷茫,所以我建议大家可以从注意力机制、CNN、transformer这三个比较热门的方向入手。我这边已经整理好了268篇神经网络必读的顶会论文,开源代码可复现,希望可以帮助大家更快掌握神经网络。

需要268篇神经网络论文以及代码的同学看文末

那么神经网络到底需要掌握到什么程度?

首先,我们需要搞清楚这个原理具体指的是什么:

-

从狭义上说,神经网络的基本原理涉及神经元模型、结构层次、激活函数、学习算法、前向传播、反向传播。

-

从广义上说,指的就是“神经网络为什么能生效”。

前者显然是必须要掌握的,不然你可能连调参侠都做不好,过不了面试咋在工作上应用呢。至于后者,如果你没有带领别人发顶会的志向,那就没必要搞得太清楚。

其次,是否需要深入理解神经网络的原理取决于我们自己的具体需求和目标。

如果你的目标是成为一个能够独立开发和优化神经网络模型的专家,理解其背后的原理是必不可少的。

如果你是以工作业务为导向,只希望使用现有的模型,那么只需要做到下面几点:

1.将神经网络视为万能函数拟合器

核心在于能够通过学习数据中的模式来自动调整参数,从而逼近复杂的输入-输出关系。这是一种非常广泛适用的曲线拟合方法。

2.将卷积操作视为针对图像的滤波技术

通过卷积操作,可以实现图像的线性滤波,这是一种邻域操作,意味着每个输出像素值是由其相邻输入像素的加权和决定的。

3.将全连接层视为加权求和运算

在理解全连接层时,可以将其看作是对前层特征空间的一个线性变换,这个变换通过学习得到的权重参数来调整每个特征的重要性。

4.反向传播理解为从最后一层逐步调整权重参数

通过计算损失函数对网络中每个权重的梯度来实现权重的更新。

5.模型设计可以看作一门积木艺术

通过最优的模块选择和搭配方式,构建一个既简洁高效又极具表达能力的模型架构。

6.多看论文多思考,发篇论文自己感受

这里我推荐几篇前沿论文给大家参考:

推荐阅读论文

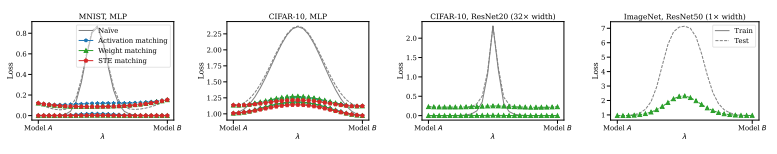

Git re-basin: Merging models modulo permutation symmetries

不同初始化方法对模型的训练/泛化性能的影响

方法:论文提出了一种权重匹配算法,可以将独立训练的模型之间的权重进行匹配,从而实现线性模式连接。实验结果表明,该算法可以在几秒钟内完成匹配,并且在性能上优于其他方法。此外,论文还探讨了模型宽度对线性模式连接的影响,并提出了一种基于权重匹配的模型合并算法,可以在测试损失上优于独立模型。

创新点:

-

作者引入了三种匹配单元的方法,包括激活匹配、权重匹配和直通估计器匹配,用于将两个模型的权重进行对齐,从而在权重空间中合并这两个模型。

-

作者提出了一种新的算法,称为Algorithm 1,用于解决权重匹配问题。

-

作者发现,线性模式连接是训练的一个新现象,它在训练后期才会出现。他们通过实验证明了线性模式连接在一些模型架构和数据集上的存在,并提出了一种方法来实现零障碍的线性模式连接。

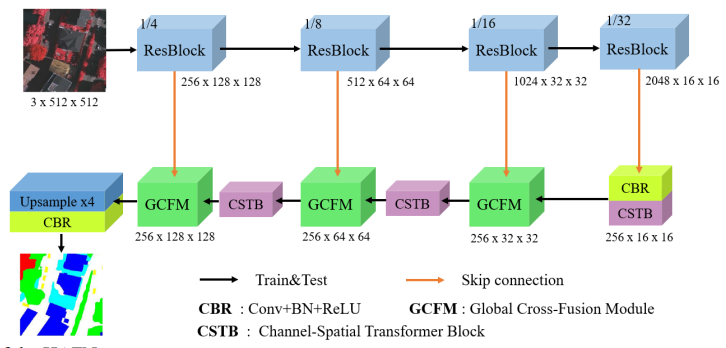

Hybrid Attention Fusion Embedded in Transformer for Remote Sensing Image Semantic Segmentation

混合注意力融合的Transformer

方法:将混合注意力机制嵌入Transformer中,提出了一种基于Transformer的解码器。CSTB通过将编码器提取的局部特征图与其相关的全局依赖进行集成,进一步聚合特征。同时,采用自适应方法对相互依赖的通道图进行重新加权,增强特征融合。GCFM将提取的互补特征组合起来,获得更全面的语义信息。

创新点:

-

引入了Transformer和混合注意力机制:将Transformer和混合注意力机制嵌入到卷积神经网络中,以提取全局上下文信息,从而促进了语义分割任务的发展。

-

提出了CSTB和GCFM:CSTB通过将编码器提取的局部特征图与其相关的全局依赖进行集成,进一步聚合特征;GCFM通过组合提取的互补特征来获取更全面的语义信息。这两个模块的引入有效地提高了语义分割的性能。

Conformer: Convolution-augmented Transformer for Speech Recognition

卷积与Attention的融合

方法:本研究探讨了如何在ASR模型中有机地结合卷积和自注意力。作者假设全局和局部交互对于参数效率很重要。为了实现这一点,作者提出了一种新颖的自注意力和卷积的组合Conformer,这是一种将CNN和Transformer的组件整合到端到端语音识别中的架构,既能学习全局交互,又能高效地捕捉基于相对偏移的局部相关性。

创新点:

-

Conformer模型在LibriSpeech数据集上取得了最先进的结果,优于之前发表的最佳Transformer Transducer模型。

-

该研究提出了一种将卷积和自注意力有机结合的方法,以实现参数效率。通过在自注意力和卷积之间引入新颖的组合,模型能够同时学习全局交互和相对偏移的局部相关性。

-

研究者还仔细研究了注意力头数、卷积核大小、激活函数、前馈层的放置位置以及向Transformer网络添加卷积模块的不同策略对准确性的影响,并阐明了每个组件对准确性改进的贡献。

最后,虽然我们都知道算法工程师的真正价值在于理解业务,为公司带来实际的收益增长,搞清楚原理也只是为了将算法和业务更好地结合。但即使是在应用层面,对原理有一定的理解也会有助于更好地使用和调整模型,以帮助我们适应不断变化的需求。

关注下方《学姐带你玩AI》🚀🚀🚀

回复“神经网络268”获取全部论文+代码

码字不易,欢迎大家点赞评论收藏

)

在工业控制中的应用)

)