在深度学习中,epoch和学习率的取值确实会根据不同的任务、数据集和模型架构有所不同。然而,您提到的范围是一些常见的经验性取值,这些取值在很多情况下都能工作得相当好。

1. 对于epoch的取值范围:

在很多研究论文和实际应用中,训练周期(epoch)通常设置在100-200次之间。这个范围是基于经验观察的,它足够让大多数模型在中等规模的数据集上进行充分的训练,同时也不会浪费过多的计算资源。当然,对于一些非常小的数据集或者非常简单的任务,可能不需要这么多epoch;而对于超大规模的数据集或者极其复杂的任务,则可能需要更多的epoch。

对于学习率:

2. 对于学习率的取值范围

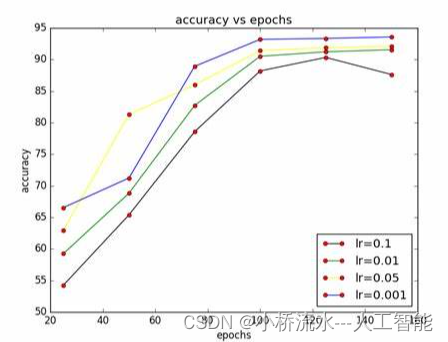

学习率通常设置在0.001到0.005之间,这也是一个经验性的范围。这个范围内的学习率通常足够小,可以避免模型在训练初期就因为步长过大而跳过最优解,同时也不会因为太小而导致训练过于缓慢。当然,随着训练的进行,很多算法会使用学习率衰减策略来逐渐减小学习率,以帮助模型在训练的后期更加精细地调整参数。

总结

需要注意的是,这些取值范围并不是绝对的,它们只是根据大量实验和论文统计得出的一个大致的、经验性的指导。在实际应用中,最好的做法是根据自己的具体任务和数据集进行多次实验,通过观察模型的训练动态(如损失函数的下降情况、验证集上的性能变化等)来调整这些参数。

)

![Android 数据恢复电脑版免费下载使用方法 [2024 更新]](http://pic.xiahunao.cn/Android 数据恢复电脑版免费下载使用方法 [2024 更新])

)

![[word] word艺术字体如何设置? #知识分享#职场发展#媒体](http://pic.xiahunao.cn/[word] word艺术字体如何设置? #知识分享#职场发展#媒体)

)

相互跳转、传参)