Label Refinement via Contrastive Learning for Distantly-Supervised Named Entity Recognition

NAACL 2022;做的远程监督NER,通过知识库构建 伪标签,通过对比学习构建负样本,负样本是entity的多余部分或其他不相关部分。即对entity的start和end 上面做负样本的构造和生成

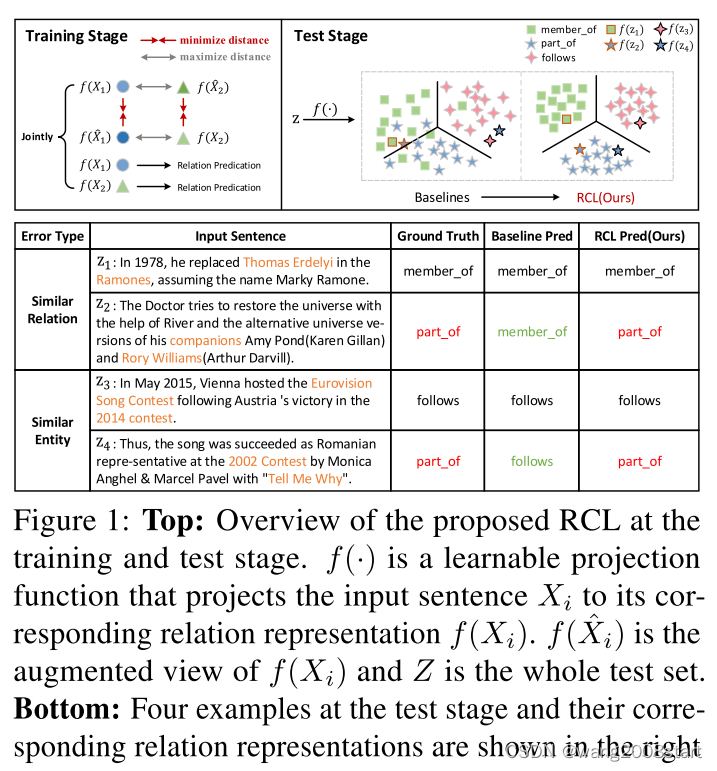

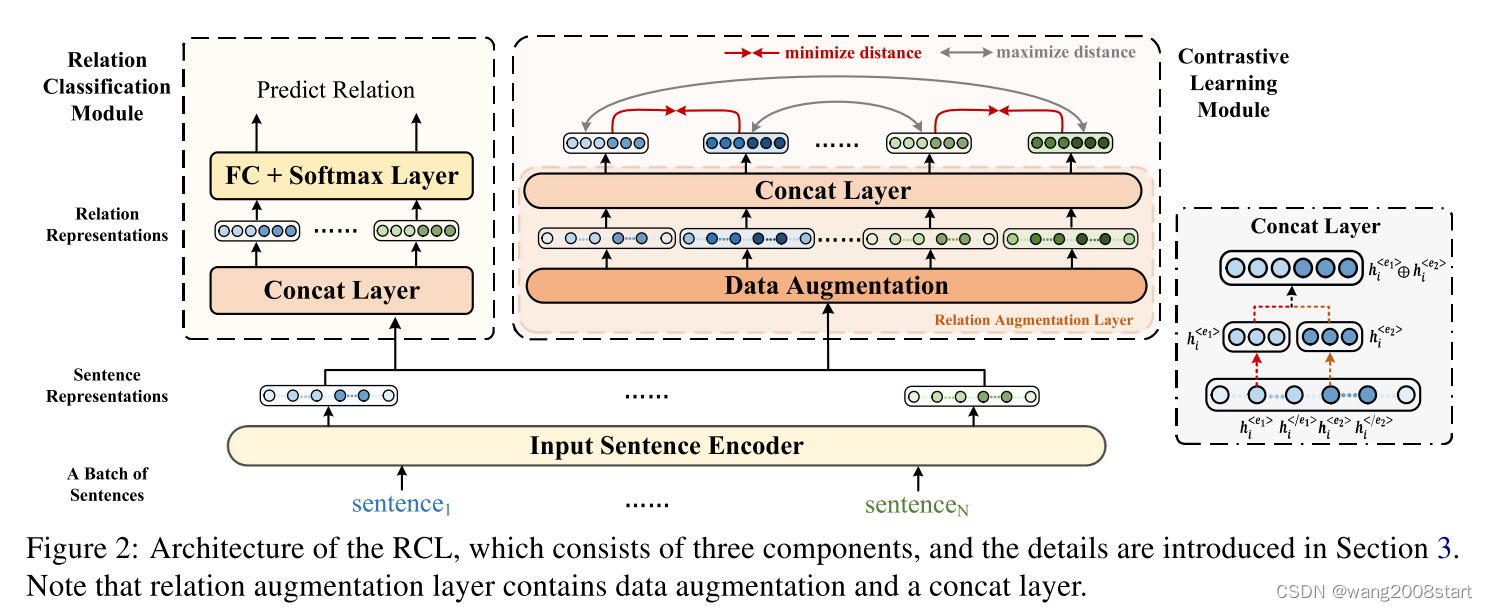

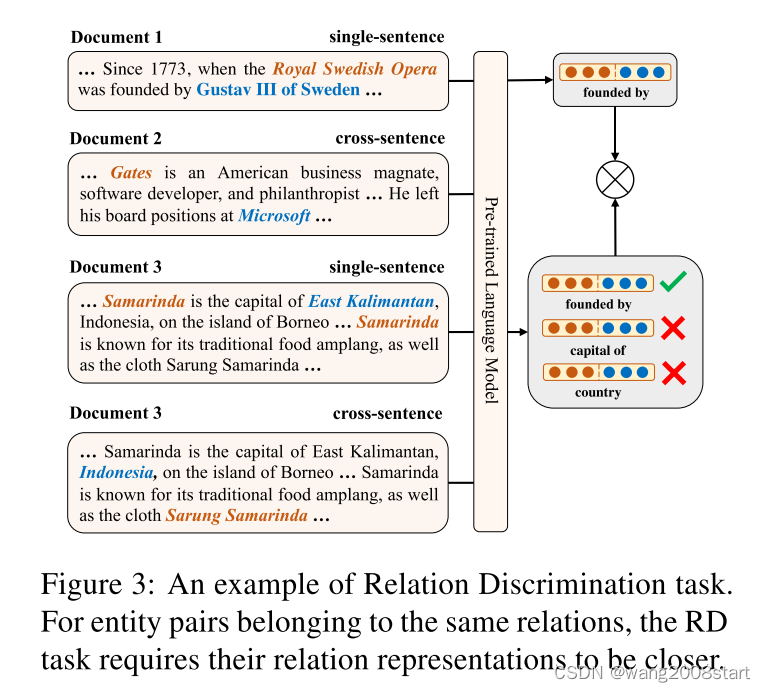

RCL: Relation Contrastive Learning for Zero-Shot Relation Extraction

NAACL 2022;零样本关系抽取;通过对比学习将相似实体和相似关系尽可能的分开而不是重叠在一起

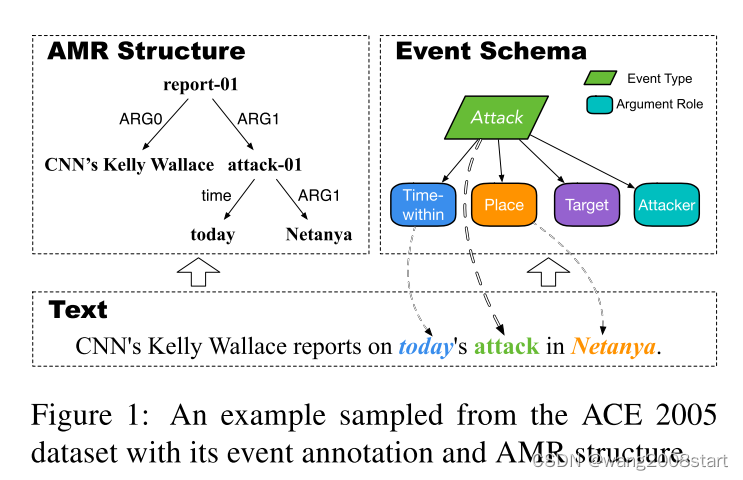

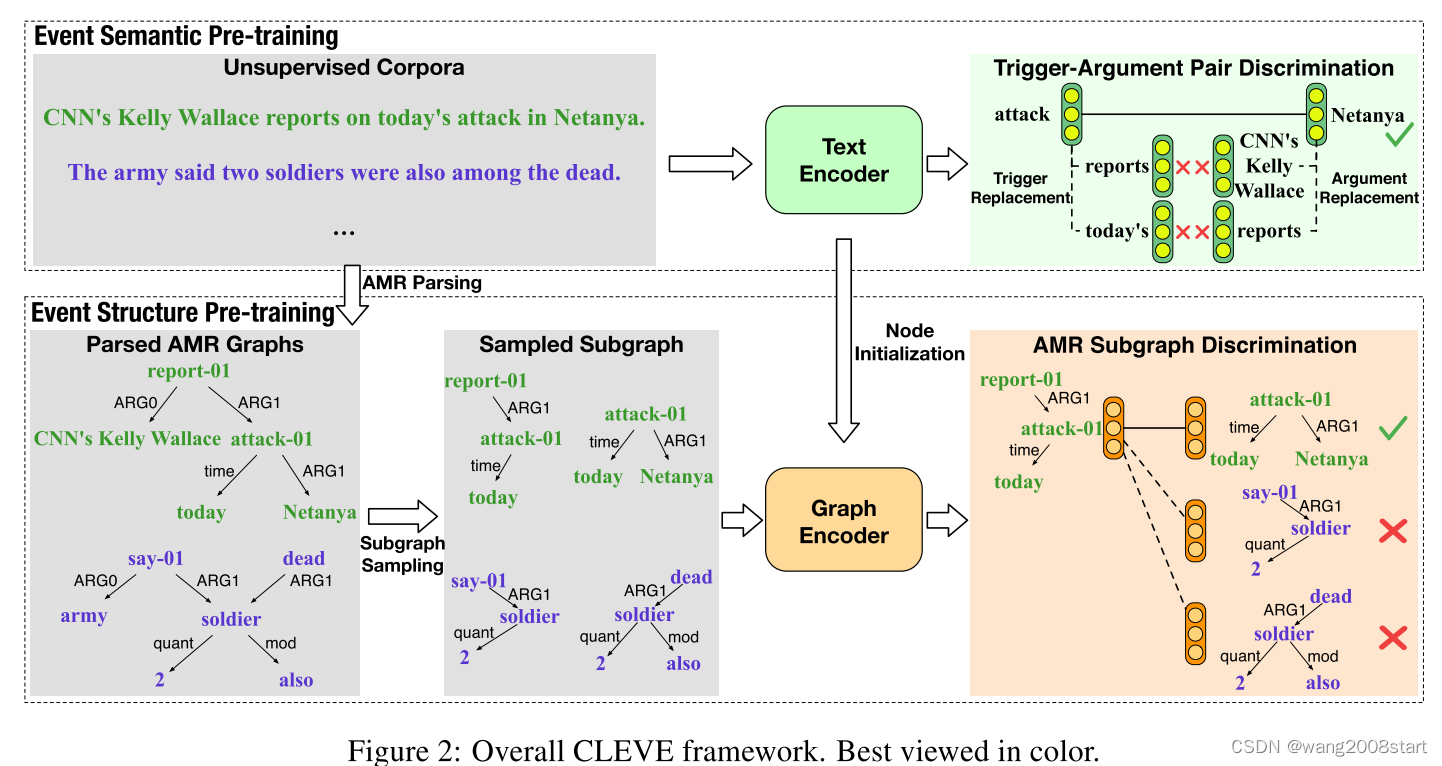

CLEVE: Contrastive Pre-training for Event Extraction

ACL21; 事件抽取,一个text encoder 抽取事件,一个graph encoder抽取事件关系。简单来说通过没有edge的节点抽取负样本

ERICA: Improving Entity and Relation Understanding for Pre-trained Language Models via Contrastive Learning

ACL21;抽取实体和关系;通过两个任务1)tail 节点是否可以通过head节点和关系得到 2)两个语义相同的关系在向量层面是否相近 来优化模型

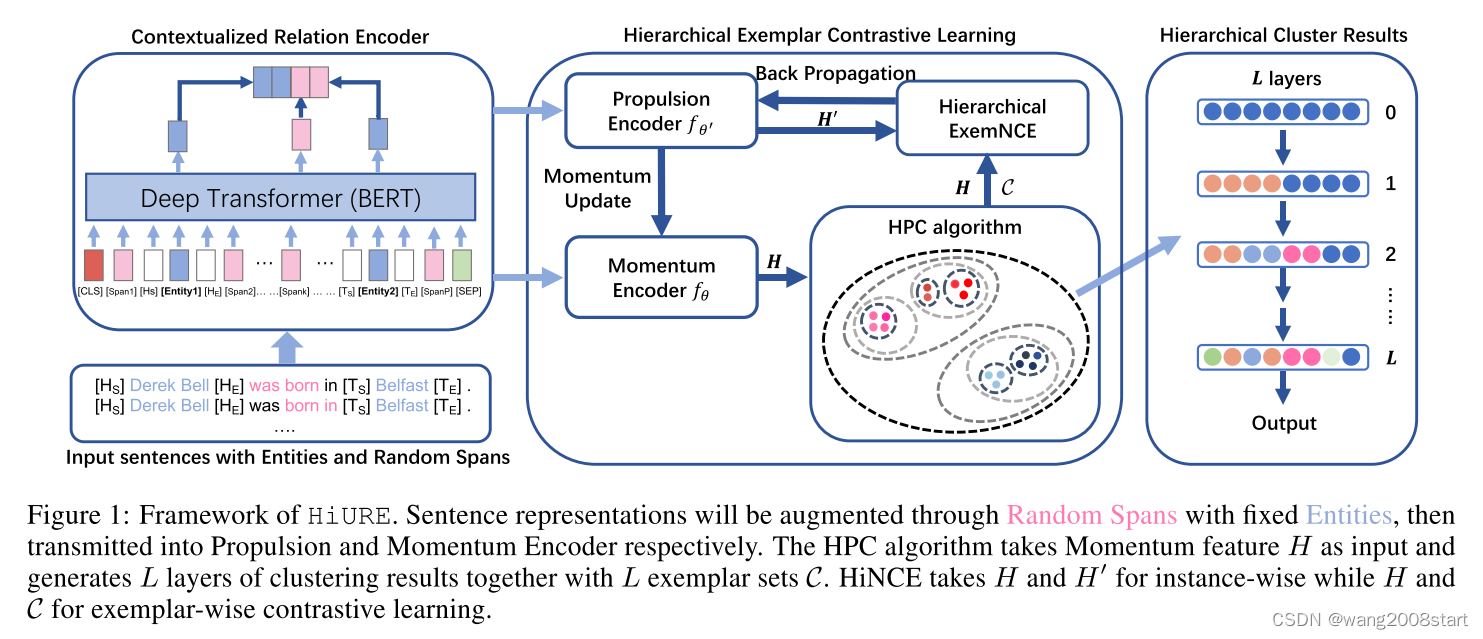

HiURE: Hierarchical Exemplar Contrastive Learning for Unsupervised Relation Extraction

ACL22;利用跨层次注意力从关系特征空间中提取层次信号,并在示例对比学习下有效优化句子的关系表示

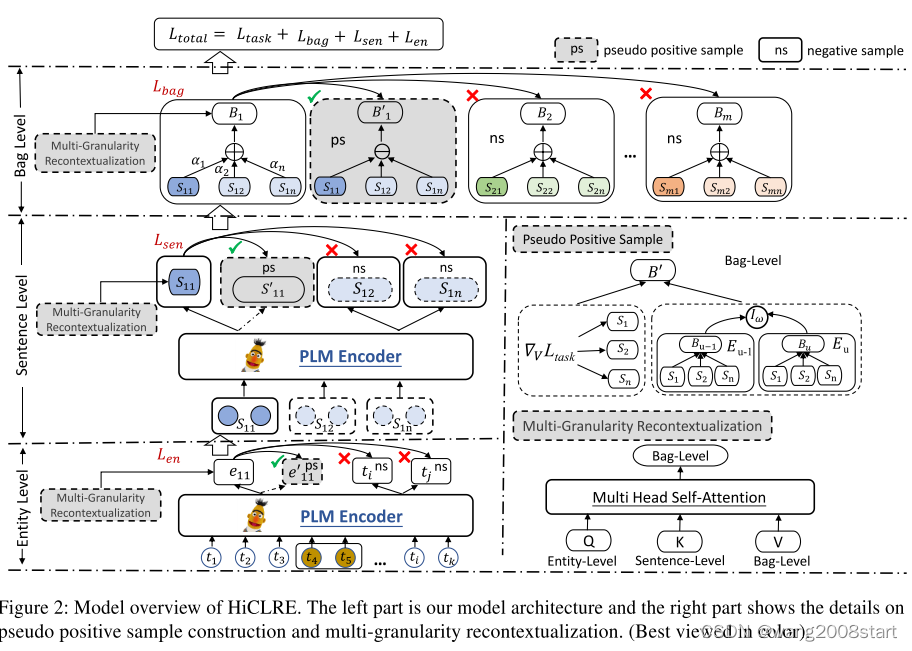

HiCLRE: A Hierarchical Contrastive Learning Framework for Distantly Supervised Relation Extraction

在融合全局结构信息和局部细粒度交互的基础上提出了一个三层的分层学习框架,通过自注意力自适应地与跨层交互,生成去噪的上下文感知表示,通过一种基于动态梯度的数据增强策略,在特定层次上提供伪正样本用于对比学习。三层分别为entity level、sentence level、bag level。

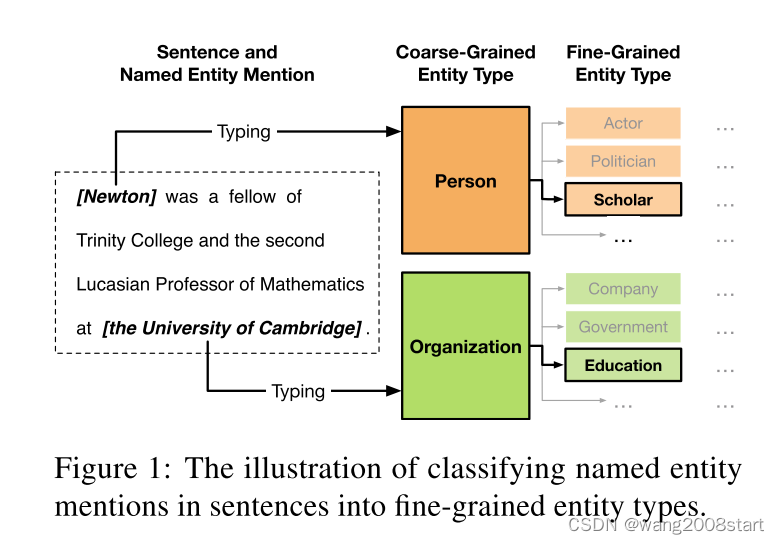

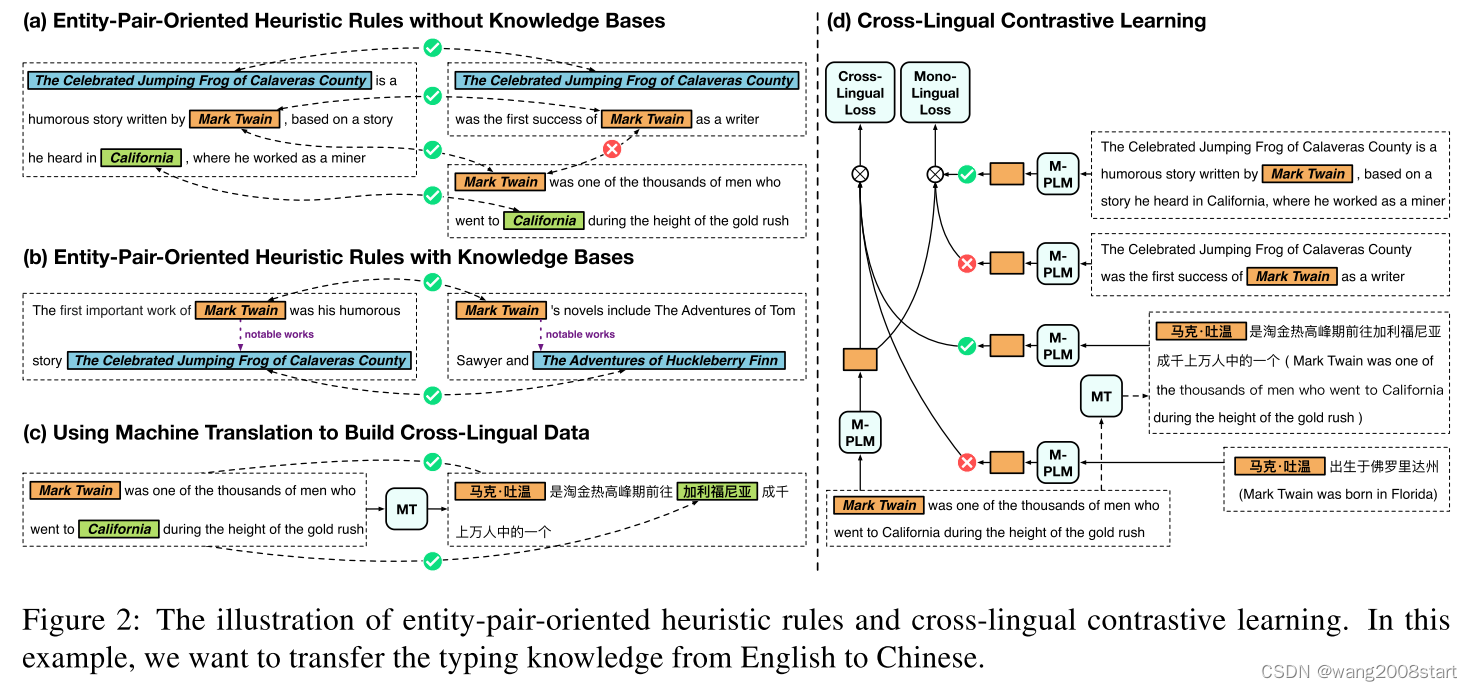

Cross-Lingual Contrastive Learning for Fine-Grained Entity Typing for Low-Resource Languages

Cross-Lingual Contrastive Learning for Fine-Grained Entity Typing for Low-Resource Languages

ACL22;将类型化知识从高资源语言(如英语)迁移到低资源语言(如中文)。引入面向实体对的启发式规则和机器翻译来获取跨语言远程监督数据,并在远程监督数据上应用跨语言对比学习来增强PLMs

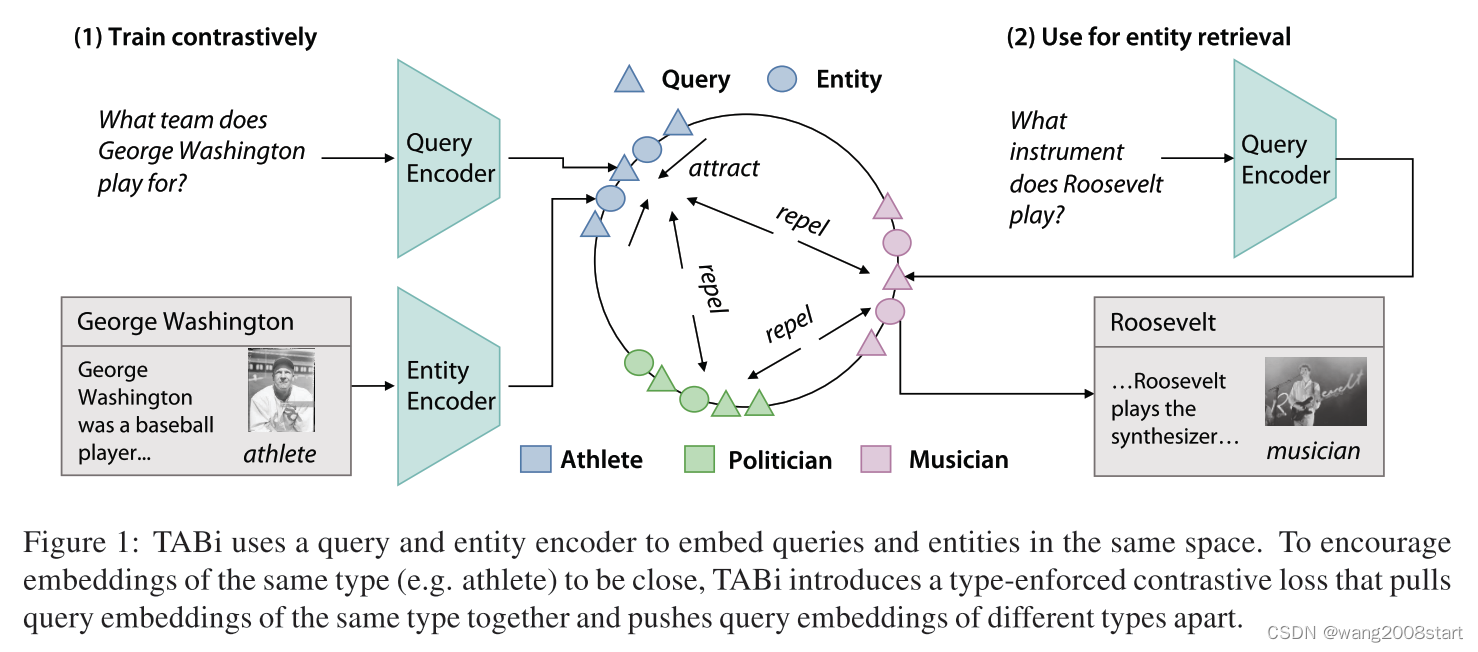

TABi: Type-Aware Bi-Encoders for Open-Domain Entity Retrieval

TABi是面向开放域任务实体检索,联合训练知识图谱类型和非结构化文本双编码器的方法。TABi利用类型强制的对比损失来鼓励相似类型的实体和查询在嵌入空间中接近。TABi改进了在有歧义实体检索 (AmbER) 集上的稀有实体检索,同时与最先进的检索器相比,在KILT基准的开放域任务上保持了强大的整体检索性能。

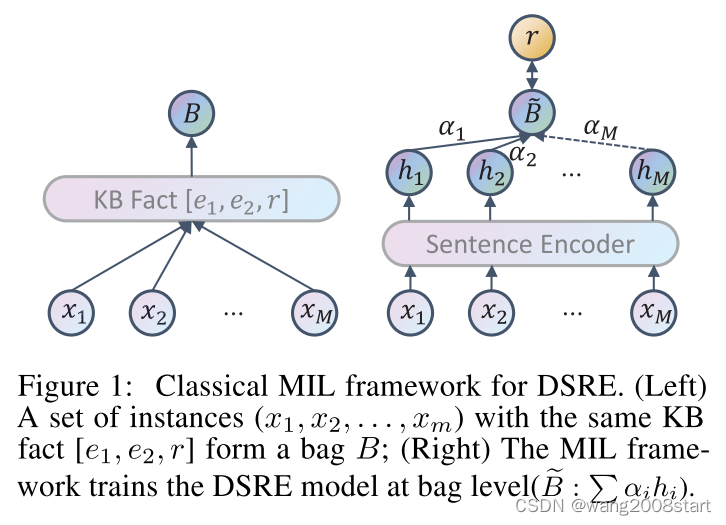

CIL: Contrastive Instance Learning Framework for Distantly Supervised Relation Extraction

自从远程监督(DS)生成的训练数据首次被引入关系抽取(RE)任务以来,就一直存在噪声问题。研究人员使用多示例学习(MIL)框架从句袋中寻找最可靠的特征,MIL - bags模式虽然可以大大降低DS噪声,但它无法表示数据集中其他许多有用的句子特征,远程监督正则模型的性能是有限制的。将初始多示例学习(MIL)视为关系三编码器,并为每个实例约束正对与负对。

)

节 -- 动态路由(OSPF))

)

:核心内容与学习收获(附大会核心PPT下载))

![防范[myers@airmail.cc].mkp攻击:解密[myers@airmail.cc].mkp勒索病毒的方法](http://pic.xiahunao.cn/防范[myers@airmail.cc].mkp攻击:解密[myers@airmail.cc].mkp勒索病毒的方法)

)