1 训练模型

python train_steelseal_det.py

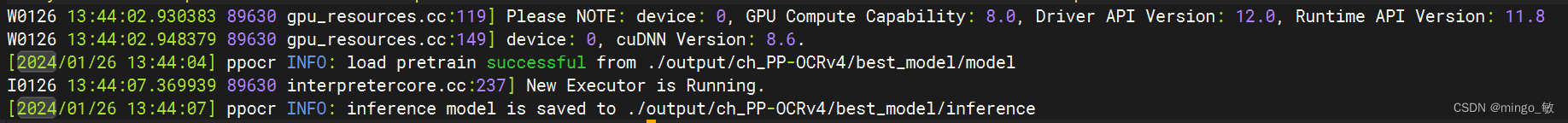

2 checkpoints模型转换为inference 模型

加载配置文件ch_PP-OCRv4_det_student_steelseal.yml,从./output/ch_PP-OCRv4/best_model/目录下加载model模型,inference模型保存在./output/ch_PP-OCRv4/best_model/目录下

python export_model_steelseal_det.py -c configs/det/ch_PP-OCRv4/ch_PP-OCRv4_det_student_steelseal.yml -o Global.pretrained_model="./output/ch_PP-OCRv4/best_model/model" Global.save_inference_dir="./output/ch_PP-OCRv4/best_model/"

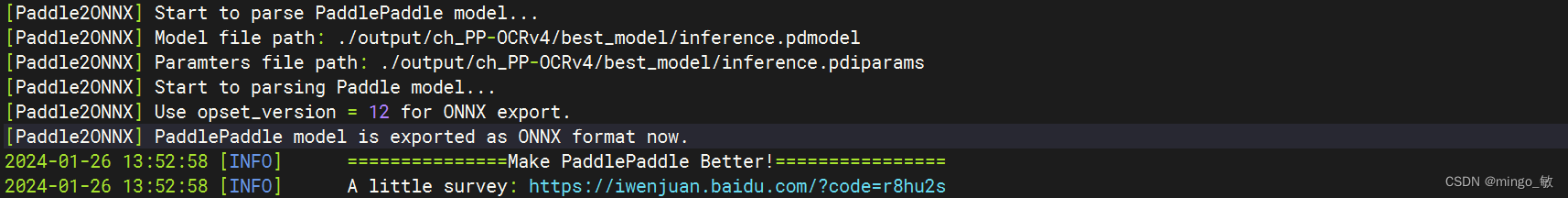

3 inference 模型转换ONNX模型

inference 模型(paddle.jit.save保存的模型) 一般是模型训练,把模型结构和模型参数保存在文件中的固化模型,多用于预测部署场景。 训练过程中保存的模型是checkpoints模型,保存的只有模型的参数,多用于恢复训练等。 与checkpoints模型相比,inference 模型会额外保存模型的结构信息,在预测部署、加速推理上性能优越,灵活方便,适合于实际系统集成。

使用 Paddle2ONNX 将Paddle静态图模型转换为ONNX模型格式:

paddle2onnx --model_dir ./output/ch_PP-OCRv4/best_model/ --model_filename inference.pdmodel --params_filename inference.pdiparams --save_file ./output/ch_PP-OCRv4/best_model/det.onnx --opset_version 12 --enable_onnx_checker True

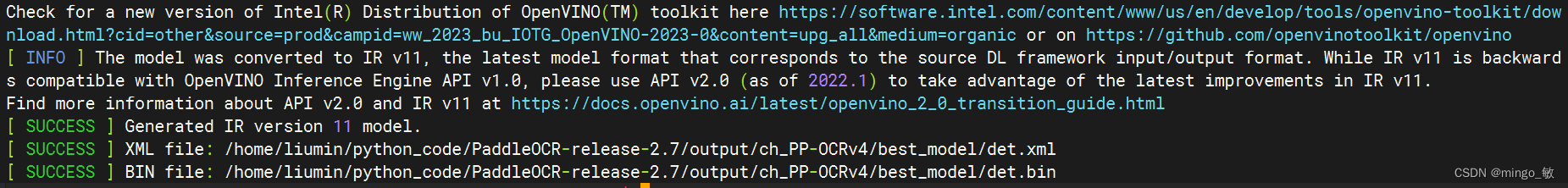

4 ONNX模型转为ov模型

onnx转为ov模型

mo --input_model ./output/ch_PP-OCRv4/best_model/det.onnx --output_dir ./output/ch_PP-OCRv4/best_model

)

:总销额同比下滑21%)

:pytorch 实现 diffusion 加噪过程)

)