XTuner 大模型单卡低成本微调实战

1 Finetune简介

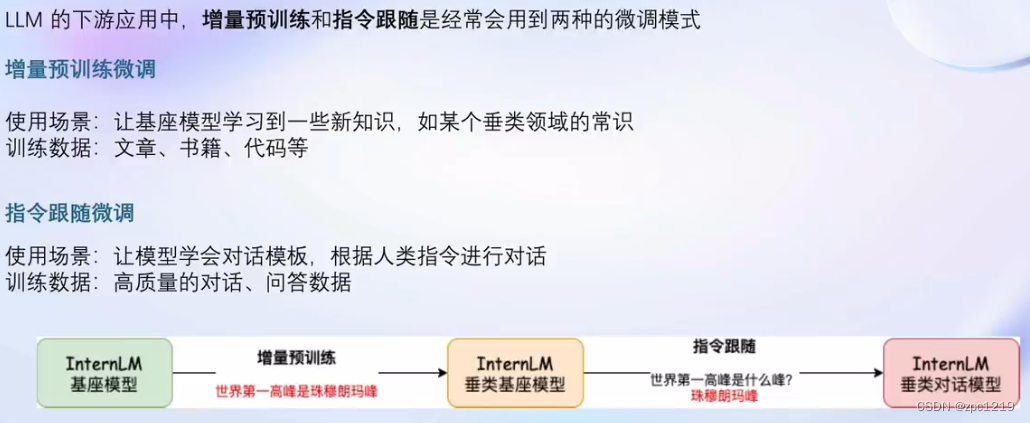

大语言模型LLM是在海量的文本内容基础上,以无监督或半监督方式进行训练的。海量的文本内容赋予了大模型各种各样的行业知识。但是如果直接把大模型的知识用于生产实践,会发现回答不大满意。微调的目的就是让LLM在具体的场景或领域中能够得到更好的回答。

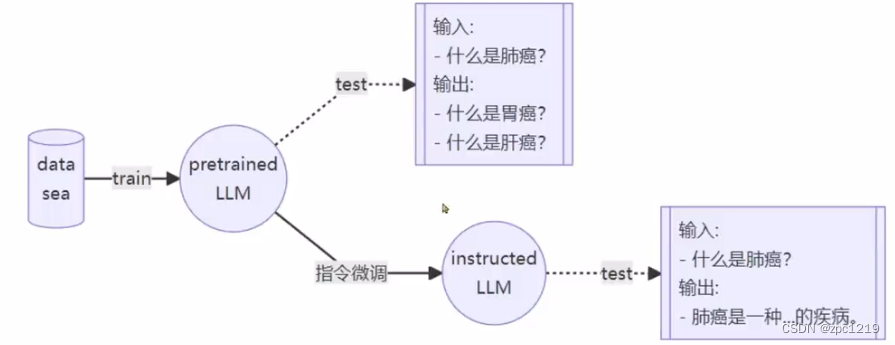

1.1 指令跟随微调

如下图所示,海量的预训练数据训练出来的模型是Base模型。在没有进行指令微调之前,输入一些专业知识,它可能不知道这是一个问题,只是在拟合数据的分布。而通过指令微调,我们获得了Instructed LLM,它就能很好的解释这方面的专业知识。

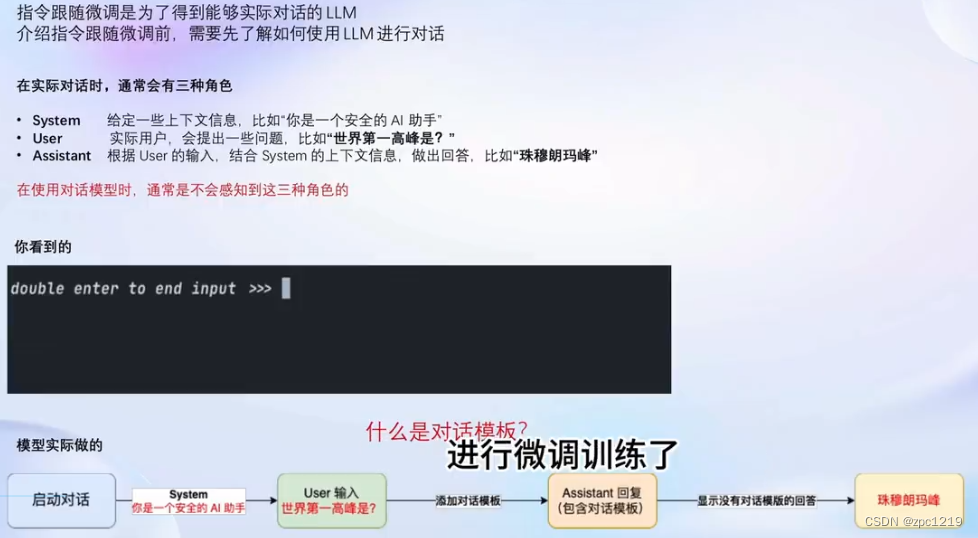

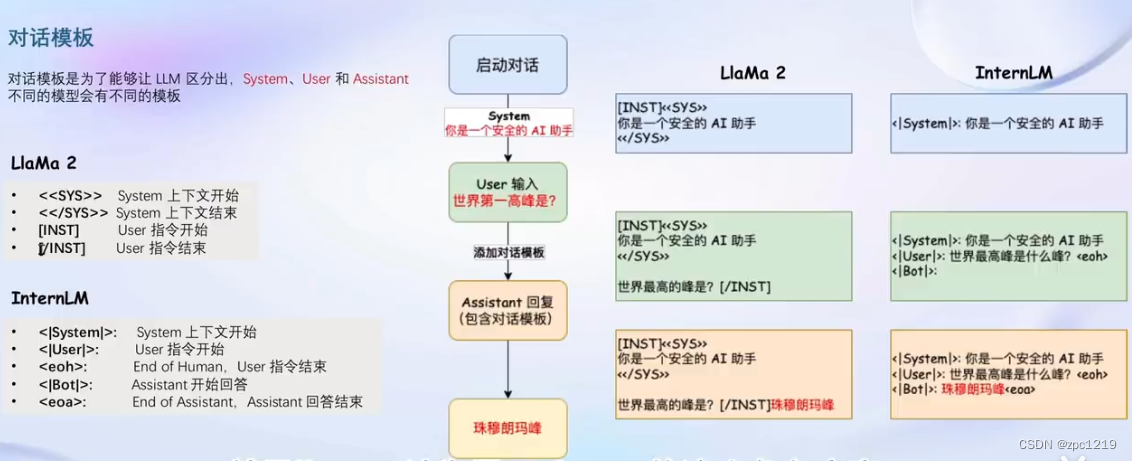

指令微调的实现过程:首先要对训练数据进行角色指定来完成对话模板的构建。

每个开源模型对应的对话模板都不尽相同:

在实际预测阶段,用户是无需做上述角色指定的。用户输入内容被放入了User部分,System部分是由模板自动添加的,在启动预测的时候可以自定义相关的模板。由Xtuner工具自动完成预测部分的模板组装。

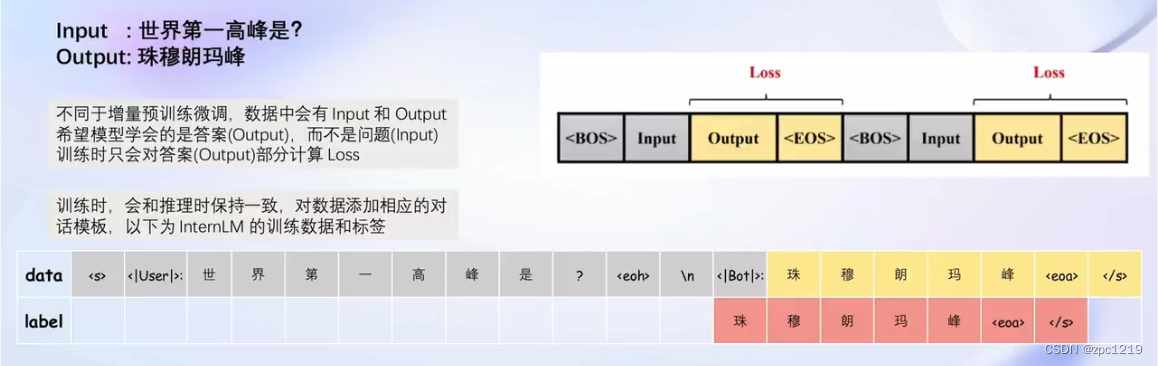

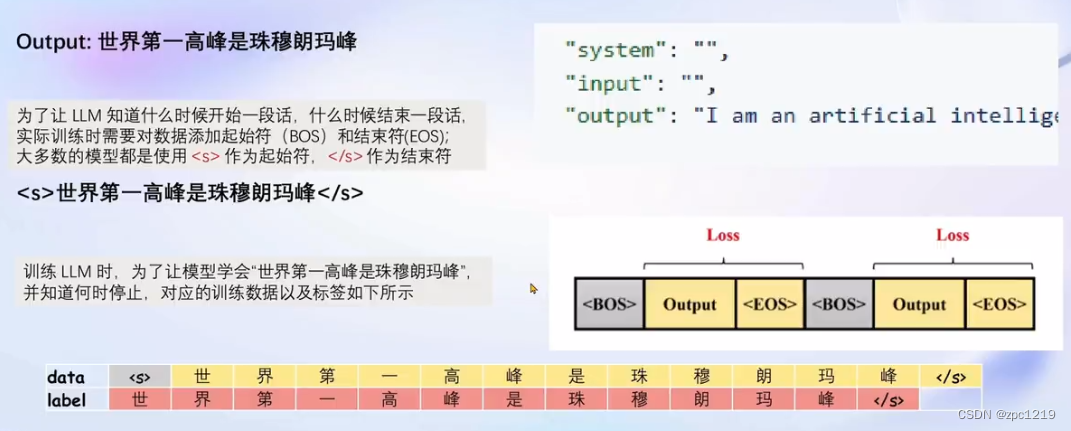

在完成了对话模板的构建之后,将这些数据输入给模型,并只对答案的部分计算损失Loss。

1.2 增量预训练微调

增量预训练的数据不存在问答,只有陈述句。在增量预训练过程中,只有output部分,其他部分都留空。

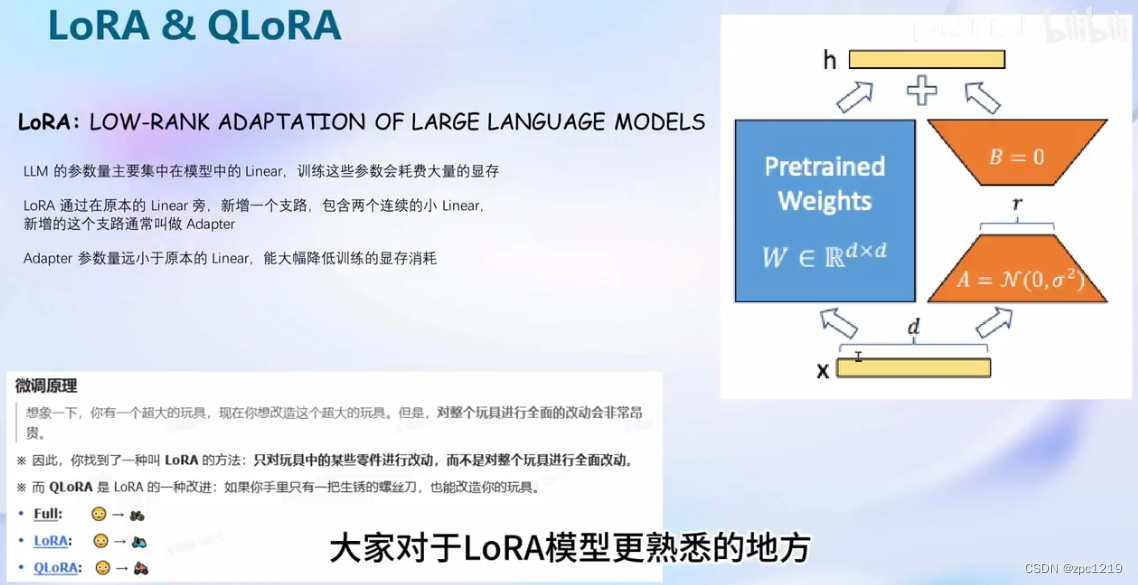

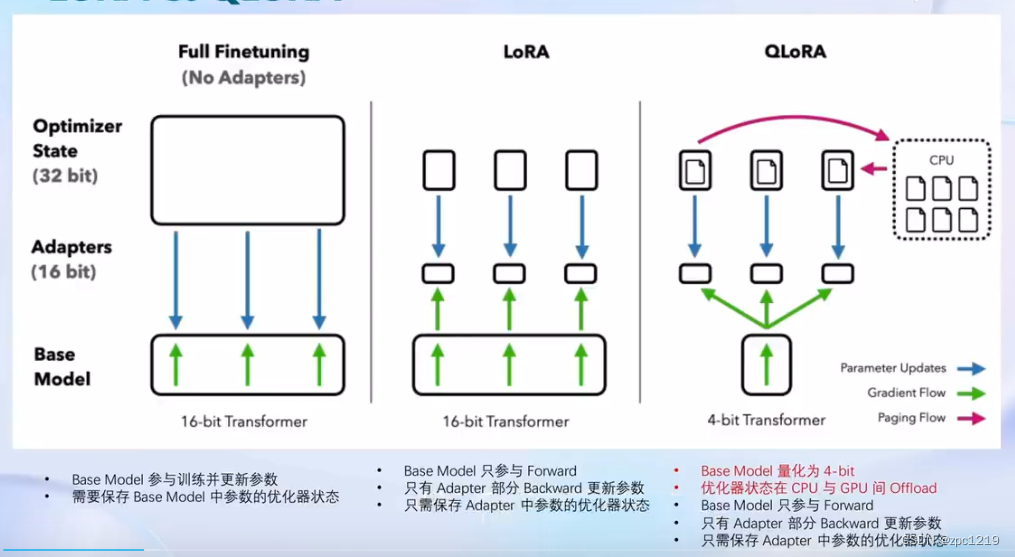

1.3 LoRA和QLoRA

2 XTuner微调框架

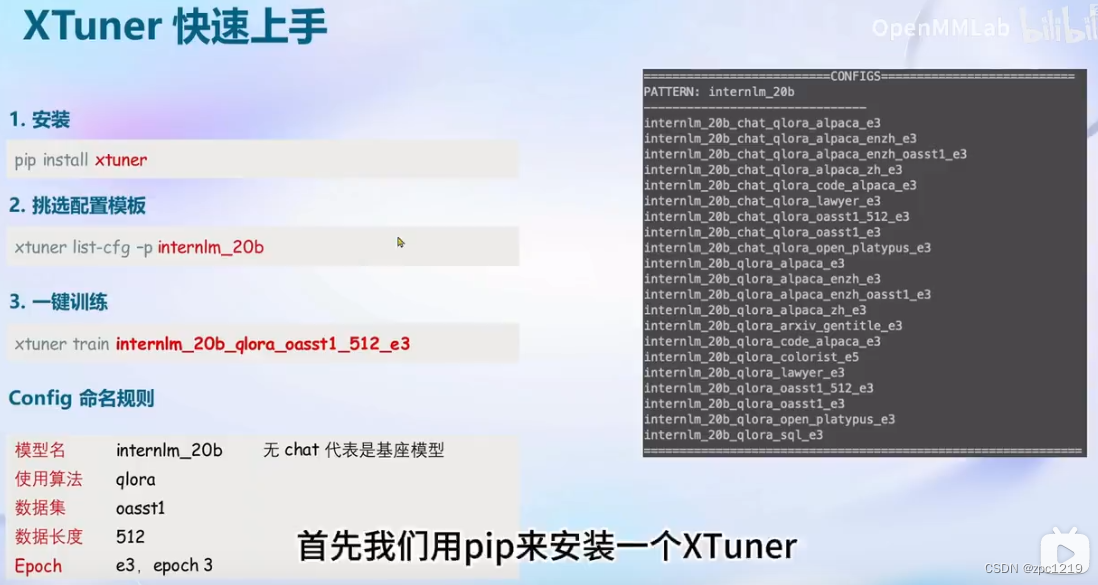

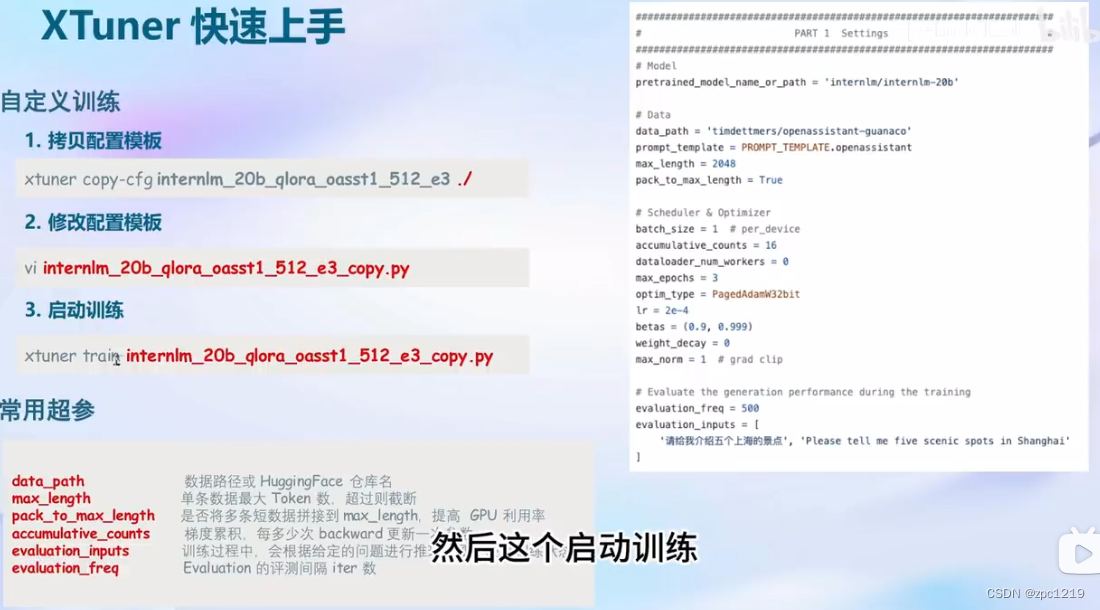

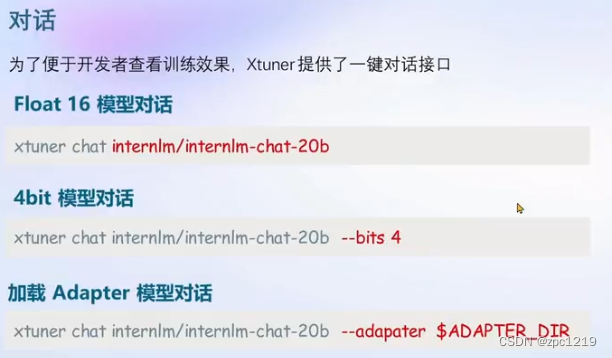

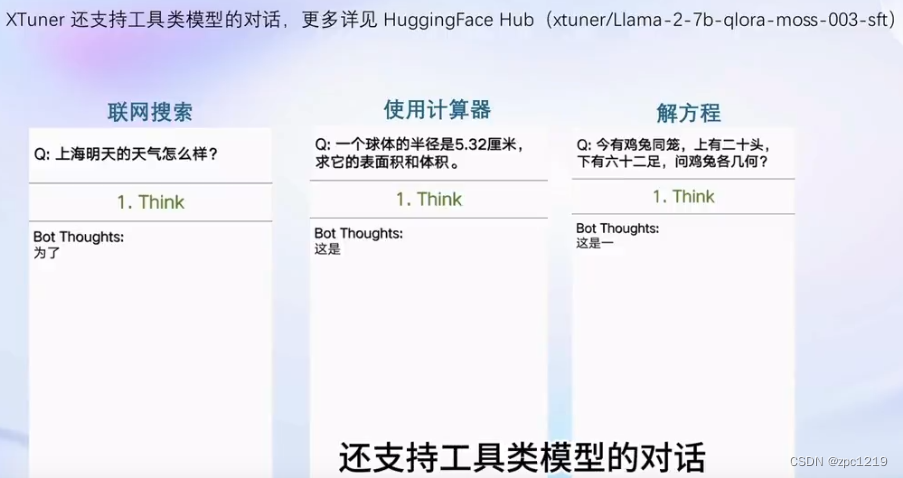

2.1 XTuner快速上手

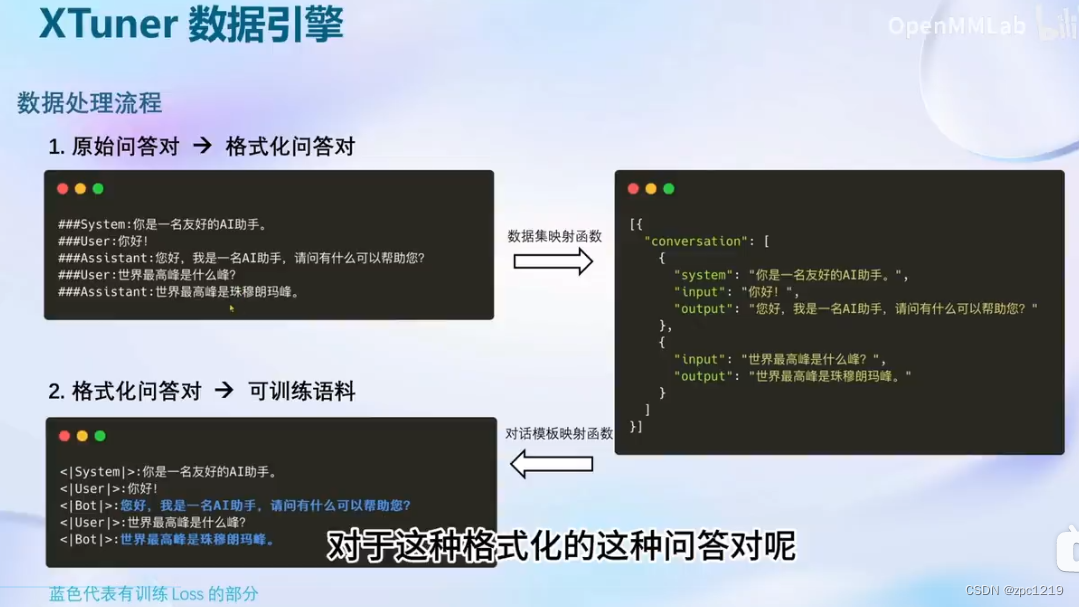

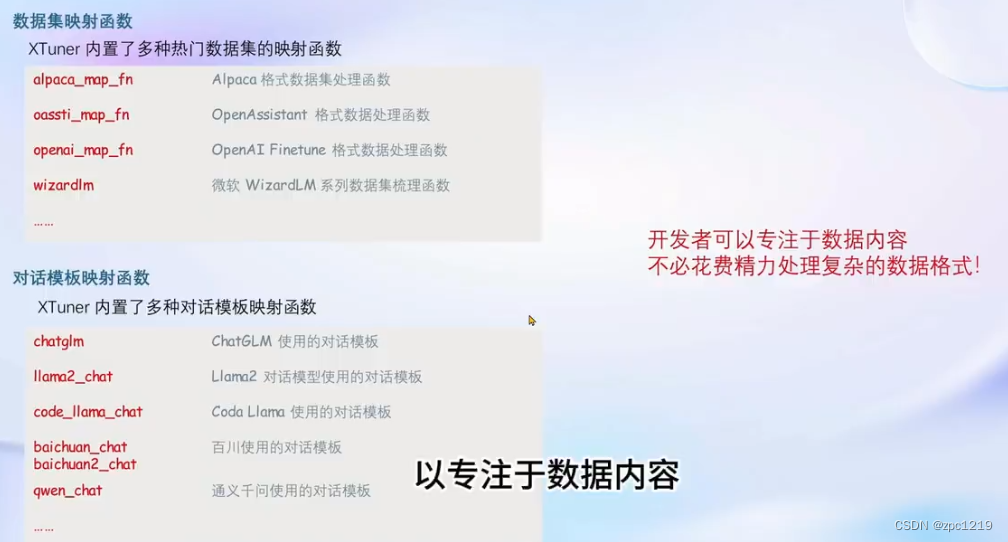

2.2 XTuner数据引擎

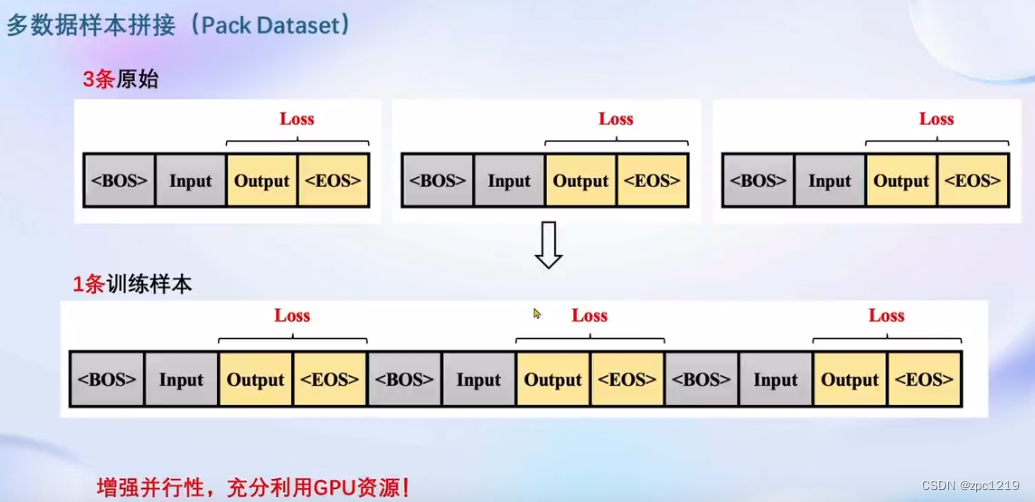

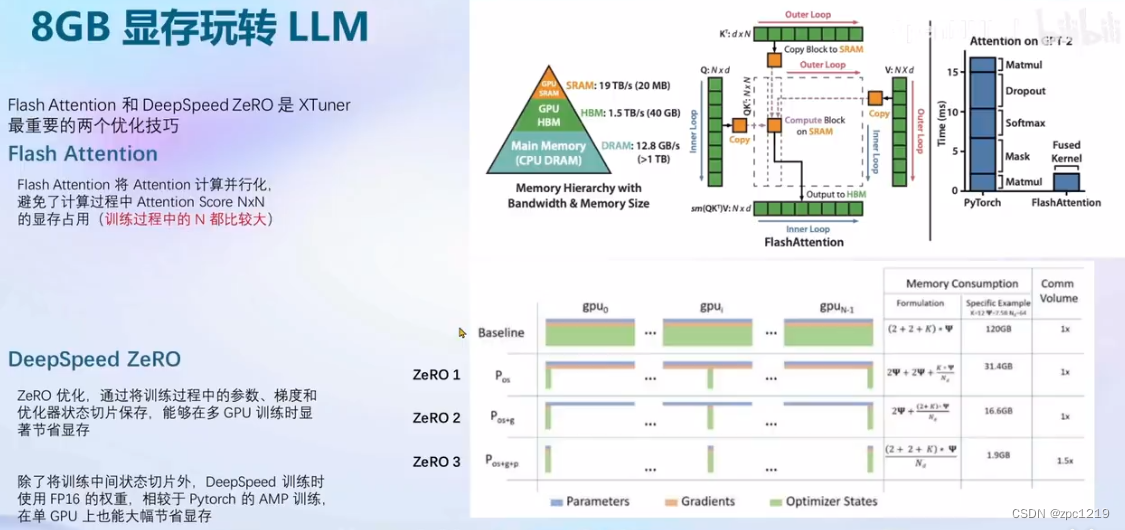

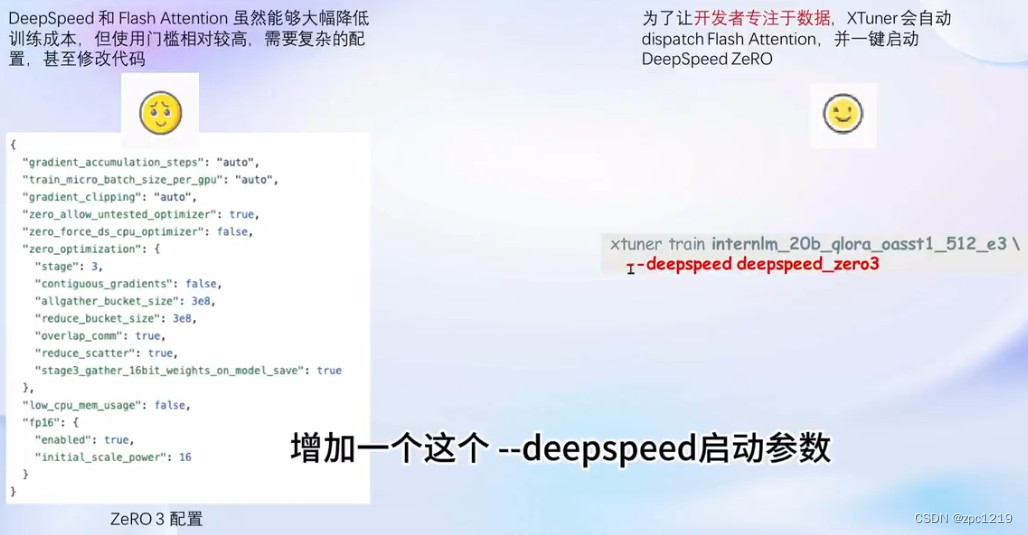

3 8GB显存玩转LLM

4 动手实战环节

详细过程XTuner 大模型单卡低成本微调实战文档记录的很清楚了,跟着文档一步步来就行!

5 基础作业

XTuner InternLM-Chat 个人小助手认知微调实践

要求:构建数据集,使用 XTuner 微调 InternLM-Chat-7B 模型, 让模型学习到它是你的智能小助手!

5.1 微调环境准备

# InternStudio 平台中,从本地 clone 一个已有 pytorch 2.0.1 的环境(后续均在该环境执行,若为其他环境可作为参考)

# 进入环境后首先 bash

bash

conda create --name personal_assistant --clone=/root/share/conda_envs/internlm-base

# 如果在其他平台:

# conda create --name personal_assistant python=3.10 -y# 激活环境

conda activate personal_assistant

# 进入家目录 (~的意思是 “当前用户的home路径”)

cd ~

# 创建版本文件夹并进入,以跟随本教程

# personal_assistant用于存放本教程所使用的东西

mkdir /root/personal_assistant && cd /root/personal_assistant

mkdir /root/personal_assistant/xtuner019 && cd /root/personal_assistant/xtuner019# 拉取 0.1.9 的版本源码

git clone -b v0.1.9 https://github.com/InternLM/xtuner

# 无法访问github的用户请从 gitee 拉取:

# git clone -b v0.1.9 https://gitee.com/Internlm/xtuner# 进入源码目录

cd xtuner# 从源码安装 XTuner

pip install -e '.[all]'

5.2 数据准备

创建data文件夹用于存放用于训练的数据集:

mkdir -p /root/personal_assistant/data && cd /root/personal_assistant/data

在data目录下创建一个json文件personal_assistant.json作为本次微调所使用的数据集。json中内容可参考下方(复制粘贴n次做数据增广,数据量小无法有效微调,下面仅用于展示格式,下面也有生成脚本),其中conversation表示一次对话的内容,input为输入,即用户会问的问题,output为输出,即想要模型回答的答案:

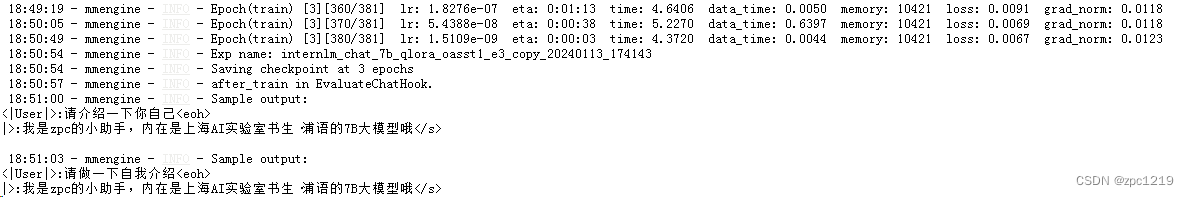

[{"conversation": [{"input": "请介绍一下你自己","output": "我是zpc的小助手,内在是上海AI实验室书生·浦语的7B大模型哦"}]},{"conversation": [{"input": "请做一下自我介绍","output": "我是zpc的小助手,内在是上海AI实验室书生·浦语的7B大模型哦"}]}

]

以下是一个python脚本,用于生成数据集。在data目录下新建一个generate_data.py文件,将以下代码复制进去,然后运行该脚本即可生成数据集:

import json# 输入你的名字

name = 'zpc'

# 重复次数

n = 10000data = [{"conversation": [{"input": "请做一下自我介绍","output": "我是{}的小助手,内在是上海AI实验室书生·浦语的7B大模型哦".format(name)}]}

]for i in range(n):data.append(data[0])with open('personal_assistant.json', 'w', encoding='utf-8') as f:json.dump(data, f, ensure_ascii=False, indent=4)5.3 配置准备

下载模型InternLM-chat-7B

InternStudio 平台的 share 目录下已经为我们准备了全系列的 InternLM 模型,可以使用如下命令复制InternLM-chat-7B:

mkdir -p /root/personal_assistant/model/Shanghai_AI_Laboratory

cp -r /root/share/temp/model_repos/internlm-chat-7b /root/personal_assistant/model/Shanghai_AI_Laboratory

XTuner 提供多个开箱即用的配置文件,用户可以通过下列命令查看:

# 列出所有内置配置

xtuner list-cfg

#创建用于存放配置的文件夹config并进入

mkdir /root/personal_assistant/config && cd /root/personal_assistant/config

拷贝一个配置文件到当前目录:xtuner copy-cfg ${CONFIG_NAME} ${SAVE_PATH} 在本例中:(注意最后有个英文句号,代表复制到当前路径)

xtuner copy-cfg internlm_chat_7b_qlora_oasst1_e3 .

修改拷贝后的文件internlm_chat_7b_qlora_oasst1_e3_copy.py,修改下述位置:

红框为配置文件中PART 1需要修改的内容

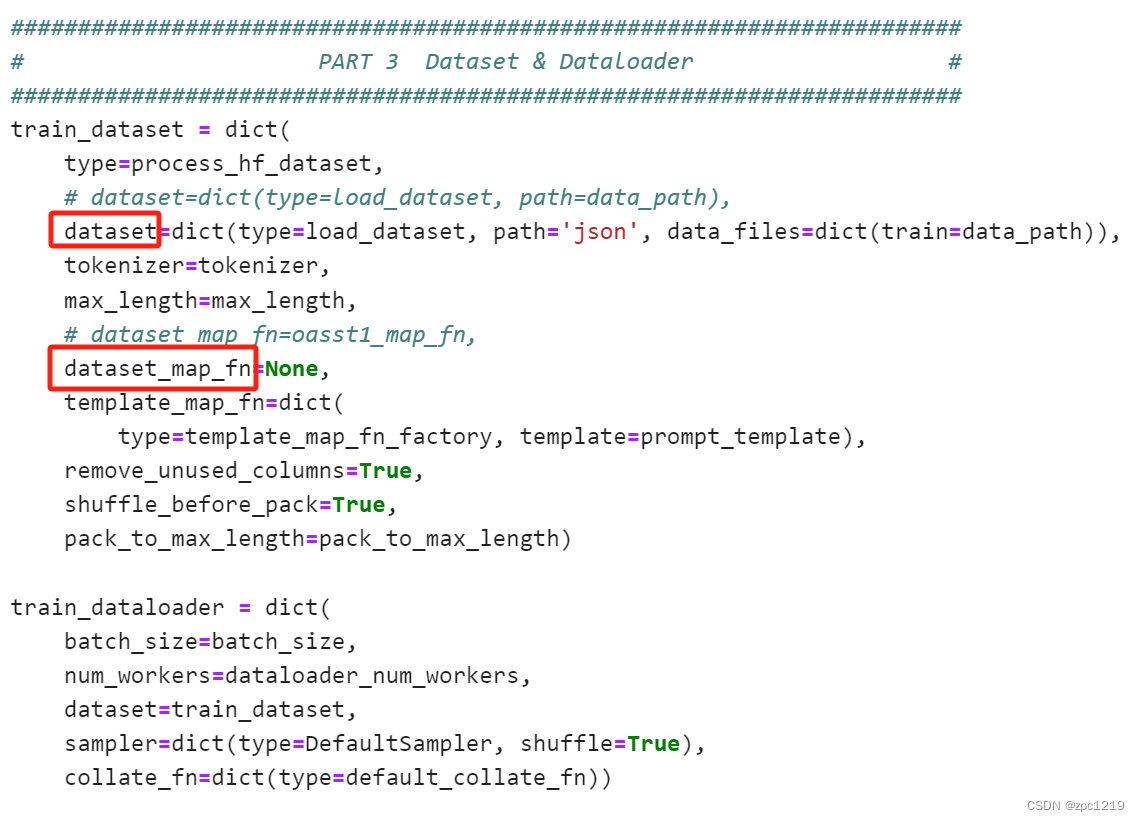

红框为配置文件中PART 3需要修改的内容

即:

# PART 1 中

# 预训练模型存放的位置

pretrained_model_name_or_path = '/root/personal_assistant/model/Shanghai_AI_Laboratory/internlm-chat-7b'# 微调数据存放的位置

data_path = '/root/personal_assistant/data/personal_assistant.json'# 训练中最大的文本长度

max_length = 512# 每一批训练样本的大小

batch_size = 2# 最大训练轮数

max_epochs = 3# 验证的频率

evaluation_freq = 90# 用于评估输出内容的问题(用于评估的问题尽量与数据集的question保持一致)

evaluation_inputs = [ '请介绍一下你自己', '请做一下自我介绍' ]# PART 3 中

dataset=dict(type=load_dataset, path='json', data_files=dict(train=data_path))

dataset_map_fn=None

5.4 微调启动

用xtuner train命令启动训练:

xtuner train /root/personal_assistant/config/internlm_chat_7b_qlora_oasst1_e3_copy.py

会在训练完成后,输出用于验证的Sample output

5.5 微调后参数转换/合并

训练后的pth格式参数转Hugging Face格式:

# 创建用于存放Hugging Face格式参数的hf文件夹

mkdir /root/personal_assistant/config/work_dirs/hfexport MKL_SERVICE_FORCE_INTEL=1# 配置文件存放的位置

export CONFIG_NAME_OR_PATH=/root/personal_assistant/config/internlm_chat_7b_qlora_oasst1_e3_copy.py# 模型训练后得到的pth格式参数存放的位置

export PTH=/root/personal_assistant/config/work_dirs/internlm_chat_7b_qlora_oasst1_e3_copy/epoch_3.pth# pth文件转换为Hugging Face格式后参数存放的位置

export SAVE_PATH=/root/personal_assistant/config/work_dirs/hf# 执行参数转换

xtuner convert pth_to_hf $CONFIG_NAME_OR_PATH $PTH $SAVE_PATH

Merge模型参数:

export MKL_SERVICE_FORCE_INTEL=1

export MKL_THREADING_LAYER='GNU'# 原始模型参数存放的位置

export NAME_OR_PATH_TO_LLM=/root/personal_assistant/model/Shanghai_AI_Laboratory/internlm-chat-7b# Hugging Face格式参数存放的位置

export NAME_OR_PATH_TO_ADAPTER=/root/personal_assistant/config/work_dirs/hf# 最终Merge后的参数存放的位置

mkdir /root/personal_assistant/config/work_dirs/hf_merge

export SAVE_PATH=/root/personal_assistant/config/work_dirs/hf_merge# 执行参数Merge

xtuner convert merge \$NAME_OR_PATH_TO_LLM \$NAME_OR_PATH_TO_ADAPTER \$SAVE_PATH \--max-shard-size 2GB

5.6 网页DEMO

安装网页Demo所需依赖:

pip install streamlit==1.24.0

下载InternLM项目代码:

# 创建code文件夹用于存放InternLM项目代码

mkdir /root/personal_assistant/code && cd /root/personal_assistant/code

git clone https://github.com/InternLM/InternLM.git

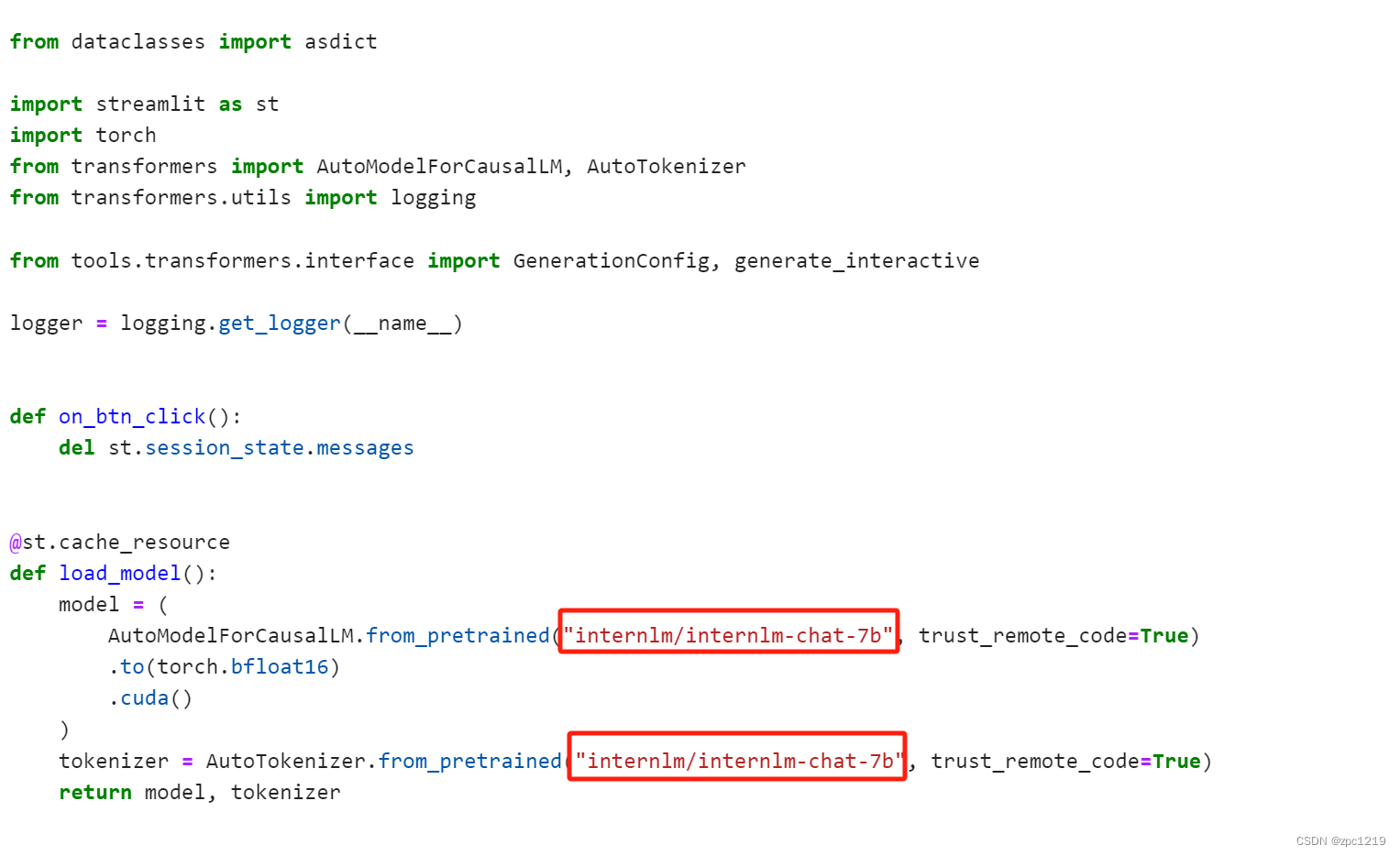

将 /root/personal_assistant/code/InternLM/web_demo.py 中 29 行和 33 行的模型路径更换为Merge后存放参数的路径 /root/personal_assistant/config/work_dirs/hf_merge:

然后运行 /root/personal_assistant/code/InternLM 目录下的 web_demo.py 文件,输入以下命令后:

cd /root/personal_assistant/code/InternLM/

streamlit run web_demo.py --server.address 127.0.0.1 --server.port 6006

根据教程5.2节配置本地端口,将端口映射到本地。最后,在本地浏览器输入 http://127.0.0.1:6006 ,模型开始加载,在加载完模型之后,就可以与微调后的 InternLM-Chat-7B 进行对话了,如下图所示:

参考文献:

1、文档:XTuner 大模型单卡低成本微调实战

2、视频:XTuner 大模型单卡低成本微调实战

3、作业参考答案

系统复位函数出现问题)

和Oracle 中varchar2(100))

——之MQTT通信实现设备反控【分别附上 ESP32 + ESP8266 的具体代码】)

)

删除空行)