一、Q-learning算法介绍

Q-learning是一种强化学习算法,用于解决基于环境的决策问题。它通过学习一个Q-table来指导智能体在不同状态下采取最优动作。下面是Q-learning算法的基本步骤:

1. 定义环境:确定问题的状态和动作空间,并创建一个变量来表示环境。

2. 初始化Q-table:创建一个Q-table,其大小与状态和动作空间相匹配,并将所有Q值初始化为0。

3. 设置超参数:设置一些超参数,如学习率(alpha)、折扣因子(gamma)和探索率(epsilon)。学习率控制了Q值的更新速度,折扣因子决定了未来奖励的重要性,探索率决定了智能体在探索和利用之间的平衡。

4. 执行Q-learning算法:在每个时间步骤中,智能体根据当前状态选择一个动作。可以使用epsilon-greedy策略,在探索率epsilon的概率下选择一个随机动作,否则选择具有最高Q值的动作。执行所选动作后,智能体观察到新的状态和奖励。

5. 更新Q值:根据Q-learning更新规则,使用以下公式更新Q-table中的Q值:

Q(s, a) = (1 - alpha) * Q(s, a) + alpha * (r + gamma * max(Q(s', a')))

其中,s是当前状态,a是当前动作,r是观察到的奖励,s'是新的状态,a'是在新状态下具有最高Q值的动作,alpha是学习率,gamma是折扣因子。

6. 重复执行步骤4和步骤5,直到达到停止条件,如达到最大迭代次数或Q值收敛。

通过不断迭代更新Q值,Q-learning算法能够学习到最优的策略,使智能体在环境中获得最大的累积奖励。

二、无人车配送路径规划介绍

无人车配送路径规划是指无人车将货物送达到所有客户中,并返回起始位置,并使得无人车路径最短。无人车配送路径规划可以简单抽象为旅行商问题(Traveling salesman problem, TSP)。TSP问题可以描述为一个商品推销员去若干城市推销商品,要求遍历所有城市后回到出发地,目的是选择一个最短的路线。当城市数目较少时,可以使用穷举法求解。而随着城市数增多,求解空间比较复杂,无法使用穷举法求解,因此可以采用强化学习提高求解TSP问题的效率。

三、Q-learning算法求解无人车配送路径规划

3.1部分代码

可以自动生成地图也可导入自定义地图,只需要修改如下代码中chos的值即可。

import matplotlib.pyplot as plt

from Qlearning import Qlearning

#Chos: 1 随机初始化地图; 0 导入固定地图

chos=1

node_num=41 #当选择随机初始化地图时,自动随机生成node_num-1个城市

# 创建对象,初始化节点坐标,计算每两点距离

qlearn = Qlearning(alpha=0.5, gamma=0.01, epsilon=0.5, final_epsilon=0.05,chos=chos,node_num=node_num)

# 训练Q表、打印路线

iter_num=1000#训练次数

Curve,BestRoute,Qtable,Map=qlearn.Train_Qtable(iter_num=iter_num)

#Curve 训练曲线

#BestRoute 最优路径

#Qtable Qlearning求解得到的在最优路径下的Q表

#Map TSP的城市节点坐标## 画图

plt.figure()

plt.ylabel("distance")

plt.xlabel("iter")

plt.plot(Curve, color='red')

plt.title("Q-Learning")

plt.savefig('curve.png')

plt.show()

3.2部分结果

(1)以国际通用的TSP实例库TSPLIB中的测试集bayg29为例:

Q-learning得到的最短路线: [1, 28, 12, 6, 5, 9, 26, 29, 3, 2, 21, 20, 10, 4, 15, 18, 14, 22, 17, 11, 19, 25, 7, 23, 27, 8, 24, 16, 13, 1]

(2)随机生成18个城市

Q-learning得到的最短路线: [1, 4, 9, 11, 5, 12, 14, 2, 13, 10, 6, 18, 15, 16, 7, 8, 17, 3, 1]

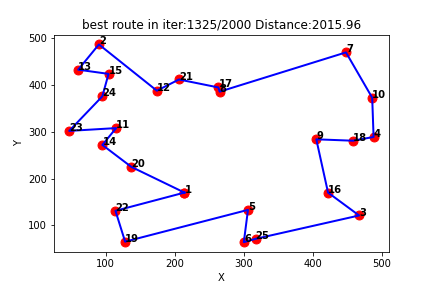

(3)随机生成25个城市

Q-learning得到的

最短路线: [1, 20, 14, 11, 23, 24, 15, 13, 2, 12, 21, 17, 8, 7, 10, 4, 18, 9, 16, 3, 25, 6, 5, 19, 22, 1]

四、完整Python代码

音频采集编码写入详细源码分析)

)

)

)