简介:在Windows操作系统中,没有与Linux中watch命令直接对应的内置工具,但有1种方法快速简单的方法可以实现类似的效果,尤其是用于监控类似于nvidia-smi的命令输出。

历史攻略:

Python:查看windows下GPU的使用情况、利用率

watch:超实用Linux命令实战

Win10:安装CUDA、cuDNN环境

深度学习:win10安装TensorFlow

深度学习-tensorflow2:02 - 训练、验证MNIST数据集

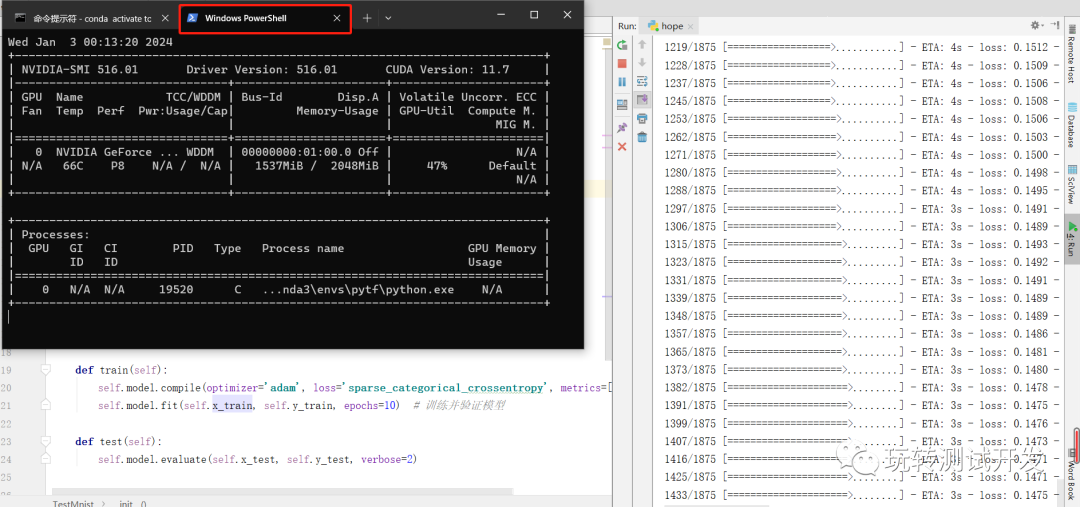

PowerShell 脚本:在Windows的PowerShell中,你可以编写一个简单的循环脚本来定期执行命令并刷新输出。例如,要模拟watch -n 1 nvidia-smi的效果。

while ($true) { cls; nvidia-smi; Start-Sleep -Seconds 1 }

上面的命令执行了以下操作:

- while ($true) { … }:创建了一个无限循环。

- cls;:清除屏幕。

- nvidia-smi;:运行nvidia-smi命令以显示NVIDIA GPU的状态。

- Start-Sleep -Seconds 1:暂停执行1秒。

运行tf案例:

# -*- coding: utf-8 -*-

# time: 2024/01/02 11:07

# file: save.py

# 公众号: 玩转测试开发

import tensorflow as tfclass TestMnist(object):def __init__(self):mnist = tf.keras.datasets.mnist # 将样本从整数转换为浮点数(self.x_train, self.y_train), (self.x_test, self.y_test) = mnist.load_data()self.x_train, self.x_test = self.x_train / 255.0, self.x_test / 255.0# 将模型的各层堆叠起来,以搭建 tf.keras.Sequential 模型。为训练选择优化器和损失函数self.model = tf.keras.models.Sequential([tf.keras.layers.Flatten(input_shape=(28, 28)),tf.keras.layers.Dense(128, activation='relu'),tf.keras.layers.Dropout(0.2),tf.keras.layers.Dense(10, activation='softmax')])def train(self):self.model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])self.model.fit(self.x_train, self.y_train, epochs=10) # 训练并验证模型def test(self):self.model.evaluate(self.x_test, self.y_test, verbose=2)if __name__ == '__main__':tm = TestMnist()tm.train()tm.test()

运行结果:

中断运行:按Ctrl+C来中断

)

)

:从入门到精通的【图像增强】之旅)

-反射)

? PPM/P6)

)