目录

1.简介

2.准备工作

3.解析器

4.基本用法

5.节点选择器

5.1选择元素

5.2提取信息

5.3嵌套选择

5.4关联选择

6.方法选择器

7. css 选择器

7.1 嵌套选择

7.2 获取属性

7.3 获取文本

总结

1.简介

简单来说,Beautiful Soup就是Python的一个HTML或XML的解析库,可以用它来方便地从网 页中提取数据。官方解释如下:

Beautiful Soup提供一些简单的、Python式的函数来处理导航、搜索、修改分析树等功能。 它是一个工具箱,通过解析文档为用户提供需要抓取的数据,因为简单,所以不需要多少代 码就可以写出一个完整的应用程序。

Beautiful Soup自动将输入文档转换为Unicode编码,输出文档转换为UTF-8编码。你不 需要考虑编码方式,除非文档没有指定一个编码方式,这时你仅仅需要说明一下原始编码方 式就可以了。

Beautiful Soup已成为和lxml、html61ib 一样出色的Python解释器,为用户灵活地提供不 同的解析策略或强劲的速度。 所以说,利用它可以省去很多烦琐的提取工作,提高了解析效率。

所以说, 利用它可以省去很多烦琐的提取工作,提高了解析效率。

2.准备工作

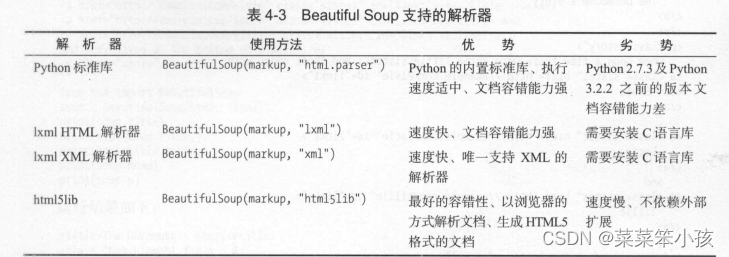

3.解析器

Beautiful Soup 在解析时实际上依赖解析器,它除了支持 Python 标准库中的 HTML 解析器外,还

通过以上对比可以看出,lxml解析器有解析HTML和XML的功能,而且速度快,容错能力强, 所以推荐使用它。

如果使用lxml,那么在初始化Beautiful Soup时,可以把第二个参数改为lxml即可:

from bs4 import BeautifulSoup

soup = BeautifulSoup('<p>Hello</p>', 'lxml')

print(soup.p.string)返回:

![]()

4.基本用法

下面首先用实例来看看Beautiful Soup的基本用法:

html ='''

<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title" name="dromouse"xb>The Dormouse's story</bx/p>

<p class="story">Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="linkl"><!-- Elsie --></a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.prettify())

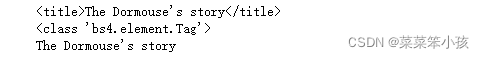

print(soup.title.string)返回:

这里首先声明变量html,它是一个HTML字符串。但是需要注意的是,它并不是一个完整的HTML 字符串,因为body和html节点都没有闭合。接着,我们将它当作第一个参数传给BeautifulSoup对象,该对象的第二个参数为解析器的类型(这里使用lxml),此时就完成了 BeaufulSoup对象的初始化。 然后,将这个对象赋值给soup变量。

接下来,就可以调用soup的各个方法和属性解析这串HTML代码了。

首先,调用prettify()方法。这个方法可以把要解析的字符串以标准的缩进格式输出。这里需要 注意的是,输出结果里面包含body和html节点,也就是说对于不标准的HTML字符串BeautifulSoup, 可以自动更正格式。这一步不是由prettify()方法做的,而是在初始化BeautifulSoup时就完成了。

然后调用soup.title.string,这实际上是输出HTML中title节点的文本内容。所以,soup.title 可以选出HTML中的title节点,再调用string属性就可以得到里面的文本了,所以我们可以通过 简单调用几个属性完成文本提取。

5.节点选择器

直接调用节点的名称就可以选择节点元素,再调用string属性就可以得到节点内的文本了,这种选择方式速度非常快。如果单个节点结构层次非常清晰,可以选用这种方式来解析。

5.1选择元素

下面再用一个例子详细说明选择元素的方法:

html ='''

<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title" name="dromouse"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters;and their names were

<a href="http://example.com/elsie" class="sister" id="linkl"><!-- Elsie --></a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.title)

print(type(soup.title))

print(soup.title.string)

print(soup.head)

print(soup.p)返回:

这里依然选用刚才的HTML代码,首先打印输出title节点的选择结果,输出结果正是title节 点加里面的文字内容。接下来,输出它的类型,是bs4.element.Tag类型,这是Beautiful Soup中一个 重要的数据结构。经过选择器选择后,选择结果都是这种Tag类型。Tag具有一些属性,比如string 属性,调用该属性,可以得到节点的文本内容,所以接下来的输出结果正是节点的文本内容。

接下来,我们又尝试选择了 head节点,结果也是节点加其内部的所有内容。最后,选择了 p节点。 不过这次情况比较特殊,我们发现结果是第一个p节点的内容,后面的几个p节点并没有选到。也就 是说,当有多个节点时,这种选择方式只会选择到第一个匹配的节点,其他的后面节点都会忽略。

5.2提取信息

上面演示了调用string属性来获取文本的值,那么如何获取节点属性的值呢?如何获取节点名 呢?下面我们来统一梳理一下信息的提取方式。

(1)获取名称

可以利用name属性获取节点的名称。这里还是以上面的文本为例,选取title节点,然后调用 name属性就可以得到节点名称:

html ='''

<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title" name="dromouse"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters;and their names were

<a href="http://example.com/elsie" class="sister" id="linkl"><!-- Elsie --></a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.title.name)返回:

![]()

(2) 获取属性

每个节点可能有多个属性,比如id和class等,选择这个节点元素后,可以调用attrs获取所有 属性:

html ='''

<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title" name="dromouse"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters;and their names were

<a href="http://example.com/elsie" class="sister" id="linkl"><!-- Elsie --></a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.p.attrs)

print(soup.p.attrs['name'])返回:

![]()

可以看到,attrs的返回结果是字典形式,它把选择的节点的所有属性和属性值组合成一个字典, 接下来,如果要获取name属性,就相当于从字典中获取某个键值,只需要用中括号加属性名就可以 To比如,要获取name属性,就可以通过attrs['name']来得到

其实这样有点烦琐,还有一种更简单的获取方式:可以不用写attrs,直接在节点元素后面加中 括号,传人属性名就可以获取属性值了。样例如下:

html ='''

<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title" name="dromouse"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters;and their names were

<a href="http://example.com/elsie" class="sister" id="linkl"><!-- Elsie --></a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.p['name'])

print(soup.p['class'])返回:

![]()

这里需要注意的是,有的返回结果是字符串,有的返回结果是字符串组成的列表。比如,name属 性的值是唯一的,返回的结果就是单个字符串。而对于class, 一个节点元素可能有多个class,所以 返回的是列表。在实际处理过程中,我们要注意判断类型。

(3 )获取内容

可以利用string属性获取节点元素包含的文本内容,比如要获取第一个p节点的文本:

html ='''

<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title" name="dromouse"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters;and their names were

<a href="http://example.com/elsie" class="sister" id="linkl"><!-- Elsie --></a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.p.string)返回:

![]()

再次注意一下,这里选择到的p节点是第一个p节点,获取的文本也是第一个p节点里面的文本。

5.3嵌套选择

在上面的例子中,我们知道每一个返回结果都是bs4.element.Tag类型,它同样可以继续调用节 点进行下一步的选择。比如,我们获取了 head节点元素,我们可以继续调用head来选取其内部的head 节点元素:

html ='''

<html><head><title>The Dormouse's story</title></head>

<body>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.head.title)

print(type(soup.head.title))

print(soup.head.title.string)返回:

第一行结果是调用head之后再次调用title而选择的title节点元素。然后打印输出了它的类型, 可以看到,它仍然是bs4.element.Tag类型。也就是说,我们在Tag类型的基础上再次选择得到的依 然还是Tag类型,每次返回的结果都相同,所以这样就可以做嵌套选择了。

最后,输出它的string属性,也就是节点里的文本内容。

5.4 关联选择

在做选择的时候,有时候不能做到一步就选到想要的节点元素,需要先选中某一个节点元素,然 后以它为基准再选择它的子节点、父节点、兄弟节点等,这里就来介绍如何选择这些节点元素。

(1)子节点和子孙节点

选取节点元素之后,如果想要获取它的直接子节点,可以调用contents属性,示例如下:

html ='''

<html>

<head>

<title>The Dormouse's story</title>

</head>

<body>

<p class="story"> Once upon a time there were three little sisters; and their names were <a href="http://example.com/elsie" class="sister" id="linkl">

<span>Elsie</span>

</a>

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a>

and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>

and they lived at the bottom of a well.

</p>

<p class="story">...</p>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

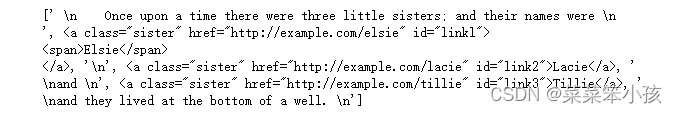

print(soup.p.contents)返回:

可以看到,返回结果是列表形式。p节点里既包含文本,又包含节点,最后会将它们以列表形式统一返回。

需要注意的是,列表中的每个元素都是p节点的直接子节点。比如第一个a节点里面包含一层span 节点,这相当于孙子节点了,但是返回结果并没有单独把span节点选出来。所以说,contents属性得到的结果是直接子节点的列表。

同样,我们可以调用children属性得到相应的结果:

html ='''

<html>

<head>

<title>The Dormouse's story</title>

</head>

<body>

<p class="story"> Once upon a time there were three little sisters; and their names were <a href="http://example.com/elsie" class="sister" id="linkl">

<span>Elsie</span>

</a>

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a>

and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>

and they lived at the bottom of a well.

</p>

<p class="story">...</p>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.p.children)

for i, child in enumerate(soup.p.children): print(i, child)返回:

还是同样的HTML文本,这里调用了children属性来选择,返回结果是生成器类型。接下来, 我们用for循环输出相应的内容。

如果要得到所有的子孙节点的话,可以调用descendants属性:

html ='''

<html>

<head>

<title>The Dormouse's story</title>

</head>

<body>

<p class="story"> Once upon a time there were three little sisters; and their names were <a href="http://example.com/elsie" class="sister" id="linkl">

<span>Elsie</span>

</a>

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a>

and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>

and they lived at the bottom of a well.

</p>

<p class="story">...</p>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

for i, child in enumerate(soup.p.descendants): print(i, child)返回:

此时返回结果还是生成器。遍历输出一下可以看到,这次的输出结果就包含了 span节点。descendants 会递归查询所有子节点,得到所有的子孙节点。

(2)父节点和祖先节点

如果要获取某个节点元素的父节点,可以调用parent属性:

html ='''

<html>

<head>

<title>The Dormouse's story</title>

</head>

<body>

<p class="story"> Once upon a time there were three little sisters; and their names were <a href="http://example.com/elsie" class="sister" id="linkl">

<span>Elsie</span>

</a>

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a>

and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>

and they lived at the bottom of a well.

</p>

<p class="story">...</p>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

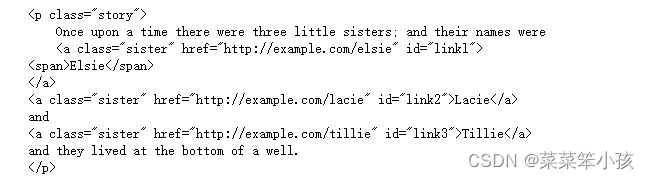

print(soup.a.parent)返回:

这里我们选择的是第一个a节点的父节点元素。很明显,它的父节点是p节点,输出结果便是p 节点及其内部的内容。

需要注意的是,这里输出的仅仅是a节点的直接父节点,而没有再向外寻找父节点的祖先节点。 如果想获取所有的祖先节点,可以调用parents属性:

html ='''

<html>

<body>

<p class="story">

<a href="http://example.com/elsie" class="sister" id="linkl">

<span>Elsie</span>

</a>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(type(soup.a.parents))

print(list(enumerate(soup.a.parents)))返回:

可以发现,返回结果是生成器类型。这里用列表输出了它的索引和内容,而列表中的元素就是a 节点的祖先节点。

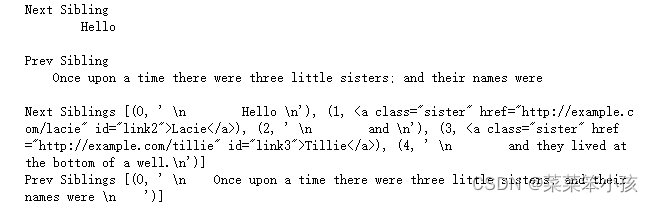

(3)兄弟节点

上面说明了子节点和父节点的获取方式,如果要获取同级的节点(也就是兄弟节点),应该怎么 办呢?示例如下:

html ='''

<html>

<body>

<p class="story"> Once upon a time there were three little sisters; and their names were <a href="http://example.com/elsie" class="sister" id="linkl">

<span>Elsie</span>

</a> Hello

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a> and they lived at the bottom of a well.

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print('Next Sibling', soup.a.next_sibling)

print('Prev Sibling', soup.a.previous_sibling)

print('Next Siblings', list(enumerate(soup.a.next_siblings)))

print('Prev Siblings', list(enumerate(soup.a.previous_siblings)))返回:

可以看到,这里调用了 4个属性,其中next_sibling和previous_sibling分另U获取节点的下一个 和上一个兄弟元素,next_siblings和previous_siblings则分别返回所有前面和后面的兄弟节点的生成器。

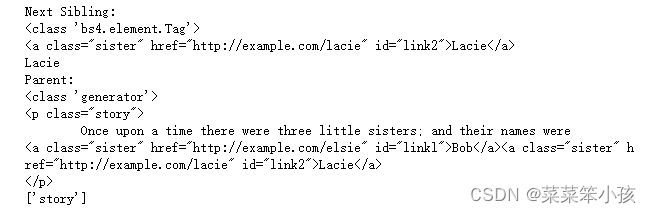

(4)提取信息

前面讲解了关联元素节点的选择方法,如果想要获取它们的一些信息,比如文本、属性等,也用 同样的方法,示例如下:

html ='''

<html>

<body>

<p class="story"> Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="linkl">Bob</a><a href="http://example.com/lacie"

class="sister" id="link2">Lacie</a>

</p>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print('Next Sibling:')

print(type(soup.a.next_sibling))

print(soup.a.next_sibling)

print(soup.a.next_sibling.string)

print('Parent:')

print(type(soup.a.parents))

print(list(soup.a.parents)[0])

print(list(soup.a.parents)[0].attrs['class'])返回:

如果返回结果是单个节点,那么可以直接调用string, attrs等属性获得其文本和属性;如果返 回结果是多个节点的生成器,则可以转为列表后取出某个元素,然后再调用string, attrs等属性获 取其对应节点的文本和属性。

6.方法选择器

前面所讲的选择方法都是通过属性来选择的,这种方法非常快,但是如果进行比较复杂的选择的 话,它就比较烦琐,不够灵活了。幸好,Beautiful Soup还为我们提供了一些查询方法,比如find_all() 和find()等,调用它们,然后传人相应的参数,就可以灵活查询了。

• find_all()

find_all,顾名思义,就是查询所有符合条件的元素。给它传人一些属性或文本,就可以得到符 合条件的元素,它的功能十分强大。

它的API如下:

find_all(name , attrs , recursive , text , **kwargs)html ='''

<div class="panel">

<div class="panel-heading">

<h4>Hello</h4>

</div>

<div class="panel-body">

<ul class="list" id="list-l">

<li class="element">Foo</li>

<li class="element">Bar</li>

<li class="element">]ay</li>

</ul>

<ul class="list list-small" id="list-2">

<li class="element">Foo</li>

<li class="element">Bar</li>

</ul>

</div>

</div>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.find_all(name='ul'))

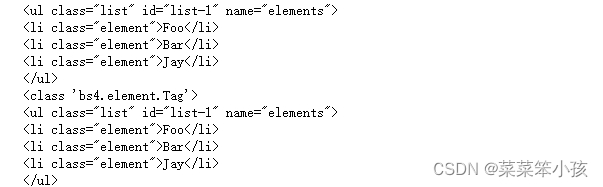

print(type(soup.find_all(name='ul')[0]))返回:

这里我们调用了 find_all()方法,传人name参数,其参数值为ul。也就是说,我们想要查询所 有ul节点,返回结果是列表类型,长度为2,每个元素依然都是bs4.element.Tag类型。

html ='''

<div class="panel">

<div class="panel-heading">

<h4>Hello</h4>

</div>

<div class="panel-body">

<ul class="list" id="list-l">

<li class="element">Foo</li>

<li class="element">Bar</li>

<li class="element">]ay</li>

</ul>

<ul class="list list-small" id="list-2">

<li class="element">Foo</li>

<li class="element">Bar</li>

</ul>

</div>

</div>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

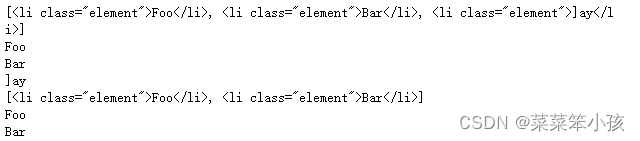

for ul in soup.find_all(name='ul'): print(ul.find_all(name='li'))返回:

返回结果是列表类型,列表中的每个元素依然还是Tag类型。

接下来,就可以遍历每个li,获取它的文本了:

html ='''

<div class="panel">

<div class="panel-heading">

<h4>Hello</h4>

</div>

<div class="panel-body">

<ul class="list" id="list-l">

<li class="element">Foo</li>

<li class="element">Bar</li>

<li class="element">Jay</li>

</ul>

<ul class="list list-small" id="list-2">

<li class="element">Foo</li>

<li class="element">Bar</li>

</ul>

</div>

</div>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

for ul in soup.find_all(name='ul'): print(ul.find_all(name='li')) for li in ul.find_all(name='li'): print(li.string)返回:

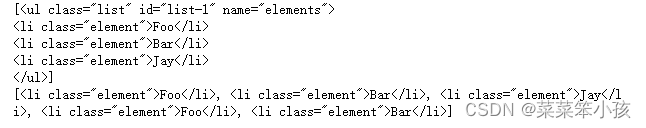

(2)attrs

除了根据节点名査询,我们也可以传人一些属性来查询,示例如下:

html ='''

<div class="panel">

<div class="panel-heading">

<h4>Hello</h4>

</div>

<div class="panel-body">

<ul class="list" id="list-1" name="elements">

<li class="element">Foo</li>

<li class="element">Bar</li>

<li class="element">Jay</li>

</ul>

<ul class="list list-small" id="list-2">

<li class="element">Foo</li>

<li class="element">Bar</li>

</ul>

</div>

</div>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.find_all(attrs={'id': 'list-1'}))

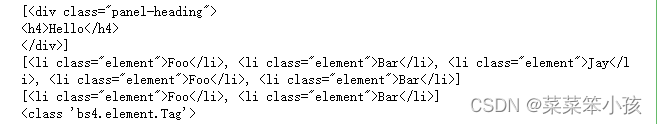

print(soup.find_all(attrs={'name': 'elements'}))返回:

这里查询的时候传人的是attrs参数,参数的类型是字典类型。比如,要查询id为list-1的节 点,可以传入attrs={'id': * list-1'}的查询条件,得到的结果是列表形式,包含的内容就是符合id 为list-1的所有节点。在上面的例子中,符合条件的元素个数是1,所以结果是长度为1的列表。

对于一些常用的属性,比如id和class等,我们可以不用attrs来传递。比如,要查询id为list-1 的节点,可以直接传人id这个参数。还是上面的文本,我们换一种方式来查询:

html ='''

<div class="panel">

<div class="panel-heading">

<h4>Hello</h4>

</div>

<div class="panel-body">

<ul class="list" id="list-1" name="elements">

<li class="element">Foo</li>

<li class="element">Bar</li>

<li class="element">Jay</li>

</ul>

<ul class="list list-small" id="list-2">

<li class="element">Foo</li>

<li class="element">Bar</li>

</ul>

</div>

</div>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.find_all(id='list-1'))

print(soup.find_all(class_='element'))返回:

这里直接传人id='list-r,就可以查询id为list-l的节点元素了。而对于class来说,由于class 在Python里是一个关键字,所以后面需要加一个下划线,即class,^element*,返回的结果依然还是 Tag组成的列表。

import re

html ='''

<div class="panel">

<div class="panel-body">

<a>Hello, this is a link</a>

<a>Hello, this is a link, too</a>

</div>

</div>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.find_all(text=re.compile('link')))返回:

![]()

这里有两个a节点,其内部包含文本信息。这里在find_all()方法中传人text参数,该参数为正 则表达式对象,结果返回所有匹配正则表达式的节点文本组成的列表。

• find()

除了 find_all()方法,还有find()方法,只不过后者返回的是单个元素,也就是第一个匹配的元 素,而前者返回的是所有匹配的元素组成的列表。示例如下:

html ='''

<div class="panel">

<div class="panel-heading">

<h4>Hello</h4>

</div>

<div class="panel-body">

<ul class="list" id="list-1" name="elements">

<li class="element">Foo</li>

<li class="element">Bar</li>

<li class="element">Jay</li>

</ul>

<ul class="list list-small" id="list-2">

<li class="element">Foo</li>

<li class="element">Bar</li>

</ul>

</div>

</div>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.find(name='ul'))

print(type(soup.find(name='ul')))

print(soup.find(class_='list'))返回:

这里的返回结果不再是列表形式,而是第一个匹配的节点元素,类型依然是Tag类型。

另外,还有许多查询方法,其用法与前面介绍的find_all()、find()方法完全相同,只不过查询 范围不同,这里简单说明一下。

- find_parents()和find_parent():前者返回所有祖先节点,后者返回直接父节点。

- find_next_siblings()和行11(1_/16乂1:__5:11)1:1|^():前者返回后面所有的兄弟节点,后者返回后面 第一兄i节点。

- find_previous_siblings()和find_previous_sibling():前者返回前面所有的兄弟节点,后者 返回前面第一个兄弟节点。

- find_all_next()和find_next():前者返回节点后所有符合条件的节点,后者返回第一个符合 条件的节点。

- find_all_previous()和find_previous():前者返回节点后所有符合条件的节点,后者返回第 一个符合条件的节点。

7. css 选择器

Beautiful Soup还提供了另外一种选择器,那就是CSS选择器。如果对Web开发熟悉的话,那么对 CSS选择器肯定也不陌生。如果不熟悉的话,可以参考CSS 选择器参考手册了解。

使用CSS选择器时,只需要调用select()方法,传人相应的CSS选择器即可,示例如下:

html ='''

<div class="panel">

<div class="panel-heading">

<h4>Hello</h4>

</div>

<div class="panel-body">

<ul class="list" id="list-1" name="elements">

<li class="element">Foo</li>

<li class="element">Bar</li>

<li class="element">Jay</li>

</ul>

<ul class="list list-small" id="list-2">

<li class="element">Foo</li>

<li class="element">Bar</li>

</ul>

</div>

</div>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

print(soup.select('.panel .panel-heading'))

print(soup.select('ul li'))

print(soup.select('#list-2 .element'))

print(type(soup.select('ul')[0]))返回:

这里我们用了 3次CSS选择器,返回的结果均是符合CSS选择器的节点组成的列表。例如, select('ul li')则是选择所有ul节点下面的所有li节点,结果便是所有的li节点组成的列表。

最后一句打印输出了列表中元素的类型。可以看到,类型依然是Tag类型。

7.1 嵌套选择

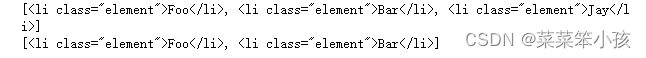

select()方法同样支持嵌套选择。例如,先选择所有ul节点,再遍历每个ul节点,选择其li节点,样例如下:

html ='''

<div class="panel">

<div class="panel-heading">

<h4>Hello</h4>

</div>

<div class="panel-body">

<ul class="list" id="list-1" name="elements">

<li class="element">Foo</li>

<li class="element">Bar</li>

<li class="element">Jay</li>

</ul>

<ul class="list list-small" id="list-2">

<li class="element">Foo</li>

<li class="element">Bar</li>

</ul>

</div>

</div>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

for ul in soup.select('ul'): print(ul.select('li'))返回:

可以看到,这里正常输出了所有ul节点下所有li节点组成的列表。

7.2 获取属性

我们知道节点类型是Tag类型,所以获取属性还可以用原来的方法。仍然是上面的HTML文本, 这里尝试获取每个ul节点的id属性:

html ='''

<div class="panel">

<div class="panel-heading">

<h4>Hello</h4>

</div>

<div class="panel-body">

<ul class="list" id="list-1" name="elements">

<li class="element">Foo</li>

<li class="element">Bar</li>

<li class="element">Jay</li>

</ul>

<ul class="list list-small" id="list-2">

<li class="element">Foo</li>

<li class="element">Bar</li>

</ul>

</div>

</div>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

for ul in soup.select('ul'): print(ul['id']) print(ul.attrs['id'])返回:

可以看到,直接传人中括号和属性名,以及通过attrs属性获取属性值,都可以成功。

7.3 获取文本

要获取文本,当然也可以用前面所讲的string属性。此外,还有一个方法,那就是get_text(), 示例如下:

html ='''

<div class="panel">

<div class="panel-heading">

<h4>Hello</h4>

</div>

<div class="panel-body">

<ul class="list" id="list-1" name="elements">

<li class="element">Foo</li>

<li class="element">Bar</li>

<li class="element">Jay</li>

</ul>

<ul class="list list-small" id="list-2">

<li class="element">Foo</li>

<li class="element">Bar</li>

</ul>

</div>

</div>

'''

from bs4 import BeautifulSoup

soup = BeautifulSoup(html, 'lxml')

for li in soup.select('li'): print('Get Text:', li.get_text()) print('String:', li.string)返回:

可以看到,二者的效果完全一致。

到此,Beautiful Soup的用法基本就介绍完了,最后做一下简单的总结。

总结

- 推荐使用lxml解析库,必要时使用html.parser

- 节点选择筛选功能弱但是速度快

- 建议使用find()或者find_all()查询匹配单个结果或者多个结果

- 如果对CSS选择器熟悉的话,可以使用selecto方法选择

之日期时间)

之因子类型)

——python)

——matlab)

)