点击蓝字关注我们

这三个文本检测算法都是segment base算法,通过由下而上的方式,先对text进行segment,然后再根据segment text,计算出text的instance

PSENet

近年来,自然场景文本检测在场景理解、产品识别、自动驾驶和目标定位等众多应用中得到了广泛的关注。然而,由于前景文本和背景对象的巨大差异,以及各种形状、颜色、字体、方向和尺度的文本变化以及极端的照明和遮挡,自然场景中的文本检测仍然面临着相当大的挑战。

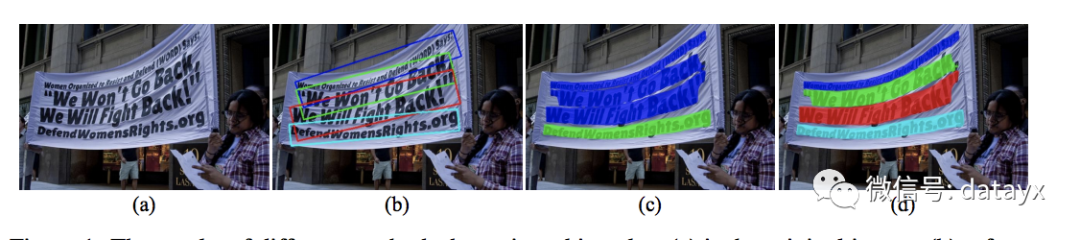

然而,随着卷积神经网络(CNNs) 的飞速发展,近年来取得了很大的进展。基于包围盒回归(Bounding Box Regression) 的方法被提出了一组方法来成功地定位具有特定方向的矩形或四边形形式的文本目标。不幸的是,这些框架无法检测任意形状的文本实例(例如曲线文本),这些文本实例也经常出现在自然场景中。自然,基于语义分割的方法可以显式地处理曲线文本的检测问题。 虽然像素分割可以提取任意形状文本实例的区域,但当两个文本实例相对接近时,仍然可能无法将它们分开,因为它们的共享相邻边界可能会将它们合并为一个单一文本实例。

语义分割(semantic segmentation)

图像的语义分割,从字面意思上理解就是让计算机根据图像的语义来进行分割;在图像领域,语义指的是图像的内容,对图片意思的理解。目前语义分割的应用领域主要有:地理信息系统、无人车驾驶、医疗影像分析、机器人等领域。具体的语义分割的简介可以看大佬的博客——计算机视觉之语义分割:http://blog.geohey.com/ji-suan-ji-shi-jue-zhi-yu-yi-fen-ge/

实例分割(Instance Segmentation)

实例分割就是机器自动从图像中用目标检测方法框出不同实例,再用语义分割方法在不同实例区域内进行逐像素标记,借一个浅显的说法:语义分割不区分属于相同类别的不同实例,而实例分割可以区分出这些像素属于同种类的不同物体。具体的实例分割可以看大佬的博客——实例分割总结

Instance Segmentation Summary:

https://blog.csdn.net/qq_39295044/article/details/79796663

PSENet有两方面的优势。 首先,psenet作为一种基于分割的方法,能够对任意形状的文本进行定位.其次,我们提出了一种渐进的尺度扩展算法,该算法可以成功地识别相邻文本实例。

具体地,我们将每个文本实例分配给多个预测的分割区域。为了方便起见,我们将这些分割区域表示为本文中的“核”,并且对于一个文本实例,有几个对应的内核。每个内核与原始的整个文本实例共享相似的形状,并且它们都位于相同的中心点但在比例上不同。为了得到最终的检测结果,我们采用了渐进的尺度扩展算法。 它基于宽度优先搜索(BFS), 由三个步骤组成:1)从具有最小尺度的核开始(在此步骤中可以区分实例);2)通过逐步在较大的核中加入更多的像素来扩展它们的区域;3)完成直到发现最大的核。

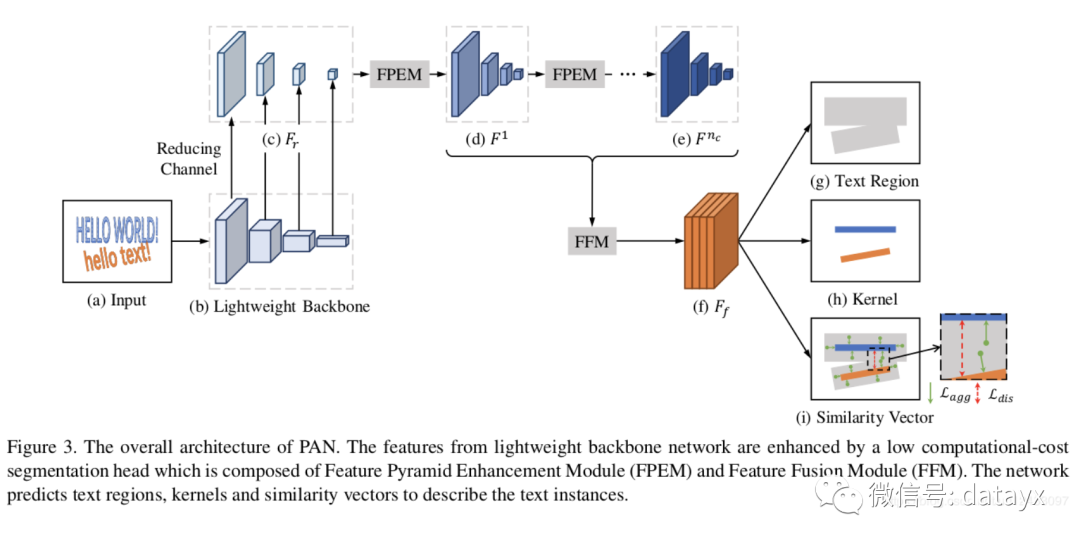

PANNet

PANNet采用lightweight backbone resnet18提取特征,再通过级联Feature Pyramid Enhancement Module (FPEM)模块,添加该模块在不太增加多少计算的情况下,使得不同的尺寸的特征可以更深,更有表达力,最后,通过Feature Fusion Module (FFM)模块,融合不同深度的FPEM特征,得到最后用于语义分割的图像。

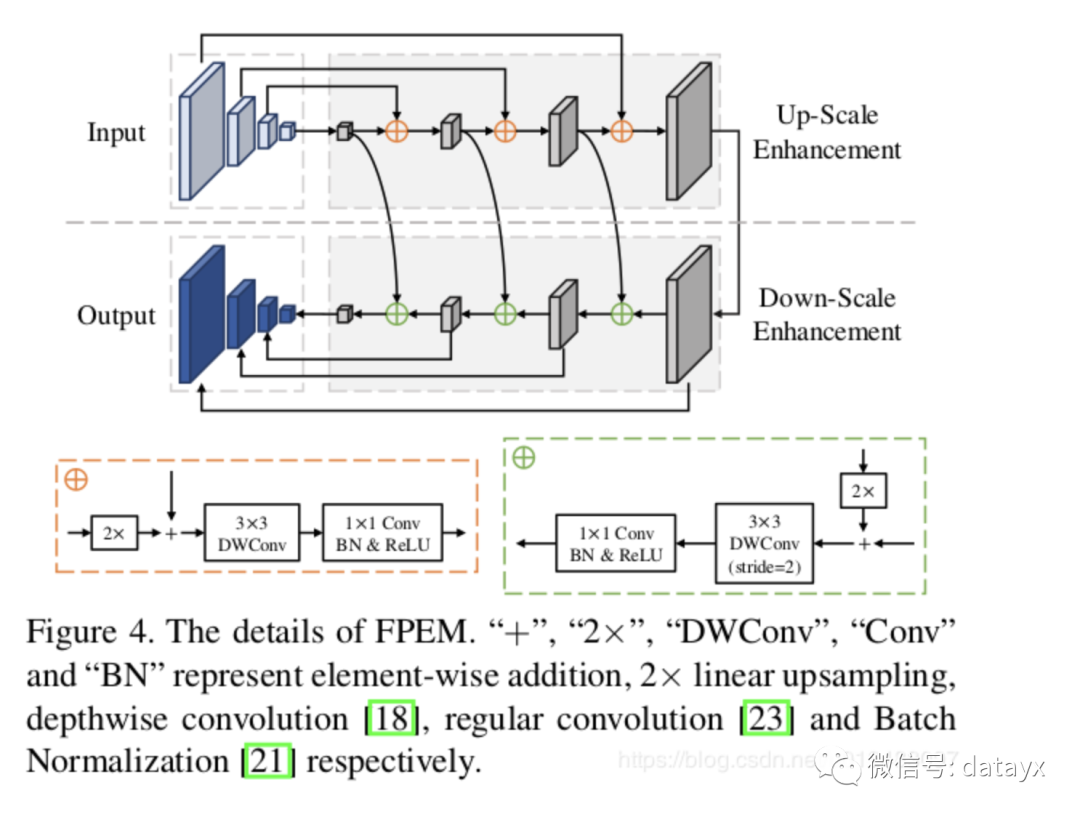

FPEM模块:PANNet的resnet18得到conv2,conv3,conv4,conv5的4个层特征图(其中conv2,conv3,conv4,conv5为原图的1/4,1/8,1/16,1/32),然后利用1X1的convolution,把resnet18的conv2,conv3,conv4,conv5特征图的通道数减为128,得到四个尺寸由小到大通道数为128的特征金字塔,通过级联n个FPEM模块,得到n个金字塔特征。

FPEM包括两个过程,都是U-shape,up-scale enhancement和down-scale enhancement,其中up-scale enhancement,小尺寸的特征通过线性放大两倍,add到相应的特征上,再通过3X3 DWConv(一种小计算量的卷积)和1X1 conv,BN,Relu,得到融合的特征,down-scale enhancement,从up-scale enhancement得到的小尺寸特征通过线性放大两倍,add到相应的特征上,然后再stride=2 的3X3 DWConv(一种小计算量的卷积)和1X1 conv,BN,Relu,得到融合的特征,输出最终的特征金字塔。

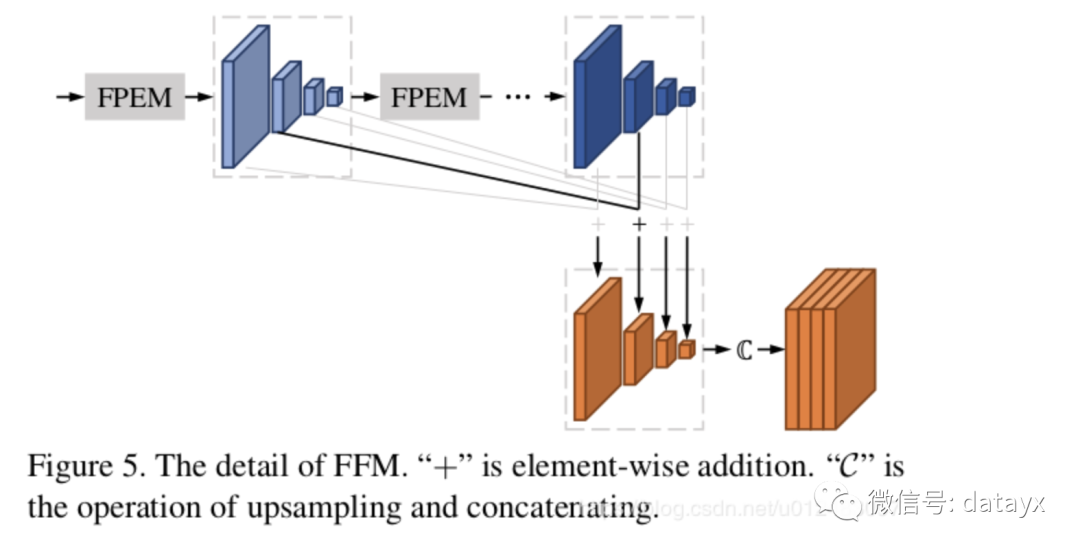

FFM模块 :该模块就是融合由FPEM产生的n个金字塔特征,如下图所示:

通过add相对应的n个金字塔特征,得到最后的金字塔特征,每个特征通道128,4层的金字塔总共512,最后通过upsample 不同尺寸的特征为原图的1/4大小,最后concatenates所有的特征,作为语义分割特征。

DBNet

Real-time Scene Text Detection with Differentiable Binarization是华科白翔老师团队发表在AAAI2020上的一篇文本检测文章,在PAN的效果上更近一步,效果和性能都再创新高。

论文地址

https://arxiv.org/pdf/1911.08947.pdf

官方代码

https://github.com/MhLiao/DB

当前由于文字检测的数据集变得更加具有挑战性,包含了各种任意形状的文字,基于分割的文字检测方法逐渐占据了主流。然而基于分割的方法往往要求复杂的网络结构和后处理,很难在速度和性能上做到平衡。本文提出了可微分的二值化模块,简化了基于分割方法的文字检测,在性能和速度上都获得了不错的效果。

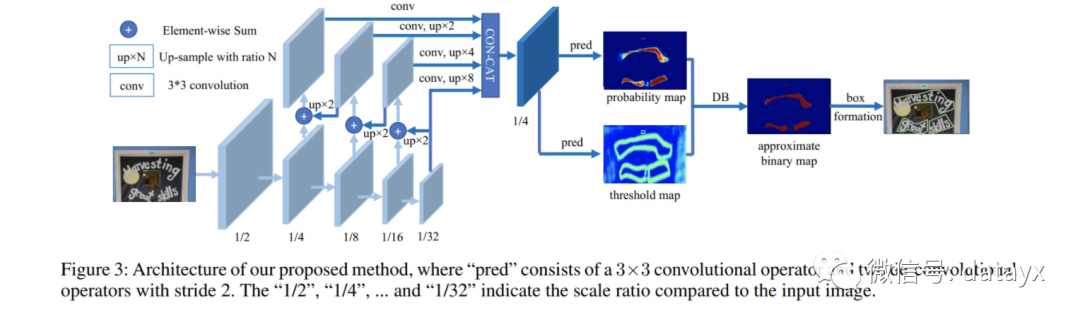

基于分割的文字检测方法往往会基于上图中蓝色箭头线的流程,首先对全图进行分割,然后基于人工设置的阈值对分割结果进行二值化,最后经过后处理得到文字区域。而该文的出发点在于将二值化的过程融入到整个网络的训练过程中进行端到端的优化及简化后处理的过程。如上图红线所示,该文算法在训练时不仅会预测出分隔图,同时会预测出阈值图,然后由二者进行二值化得到二值化mask。

首先前面的骨干网络采用了类似于FPN和U-Net的思路将不同尺度的特征图进行融合来让最终进行回归的特征图获得不同尺度的特征信息和感受野以处理不同尺寸大小的文字实例。接下来由骨干网络输出的特征图回归出一个分隔图(P)以及一个阈值图(T),然后由二者由可微分的二值化而得到二值化图,最后在推理阶段经过后处理得到文字区域。

智能卫星研究院

之ROS kinetic的安装...)

)

20002008历年考研专业课真题汇编)

报错的解决方案)

)