阿里妹导读:为什么聊天机器人越来越普及?聊天机器人不仅可以节省时间,提升效率,还能一天24小时提供服务,更是可以减少误差。聊天机器人背后的问题原理是什么?效率如何提升?就是今天我们要了解的内容。本篇内容已被收录于ACL2019,希望对你有所帮助。

1.背景

在Chatbot整体解决方案中, 既有面向任务型的taskbot(诸如订机票、查天气等), 也有更偏向知识问答的qabot,而在客服场景下,最基础的类型也是这类。如果从知识库的形式来区分qabot,可以有 基于「文档」的doc-qabot、基于「知识图谱」的kg-qabot、基于「问答对」的faq-qabot等。我们这里重点关注的是最后一种faq-qabot(也简称faqbot), 这种形式的方案对用户而言易理解易维护,也是目前chatbot解决方案中不可缺的一部分。

faqbot就是将query匹配到一条「问答对」上,从技术的角度看,有两大类方法, 一是text classification, 二是text matching,它们各有适合的场景,前者适合咨询量大且比较稳定的faq,后者适合长尾或时常变化的faq。

店小蜜是我们提供给阿里平台商家的一套智能客服解决方案。在店小蜜中, 基于Faq的问答是个很基础的部分,我们在这个领域,在文本分类和文本匹配上进行了各方面的研究和实践, 在本篇中重点对文本匹配的基础模型进行介绍。

「文本匹配」是NLP方向的一个重要研究领域,有着悠久的历史,很多NLP任务都与此相关,比如 natual language inference、parahparase identification、answer selection等,都可以归结成「文本匹配」问题。

有很多人研究这个课题, 当前优秀的匹配模型有哪些?这些模型有什么异同?这些模型存在哪些问题?这些都是我们展开这个项目需要先分析和回答的问题。我们通过分析SNLI榜单上的模型,有几个结论:

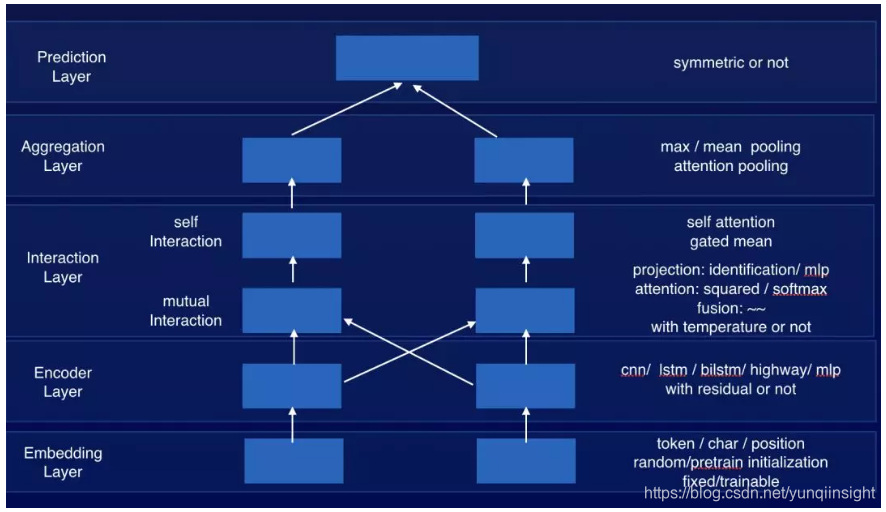

- 优秀的匹配模型都可以归纳成embed-encode-interacte-aggregate-predict五个步骤, interact部分主要是做inter-sentence alignment;

- 在interact步骤中的对齐操作,设计会比较复杂;而且很多模型只有一次interact步骤;

- 也有些更深的模型结构,会做多次的inter-sentence alignment, 但因为较深的模型面临着梯度消失、难以训练的问题;

- 不管是参数量还是响应时间,支撑像店小蜜这样对实时性能要求比较高的场景,都不是很理想。

所以我们在设计的时候, 要求我们的模型在更少的参数量、更简洁的模型结构、更少的inference cost, 保证更容易训练、更适合部署到生产环境, 在这几个前提下, 我们也希望能借鉴深层网络的优势,让我们可以很方便地加深我们的网络层次, 让模型有更强的表达能力。

2.模型

我们通过对学术界提出的各种模型,诸如Decomposable Attention Model、CAFE、DIIN等, 归纳总结,一个匹配模型的整体框架基本上有Embedding Layer、Encoder Layer、Interaction Layer、Aggregation Layer和Prediction Layer五层, 只是每一层都有不同的设计,我们实现一种可插拔的匹配模型框架, 每层都有一些典型的实现。

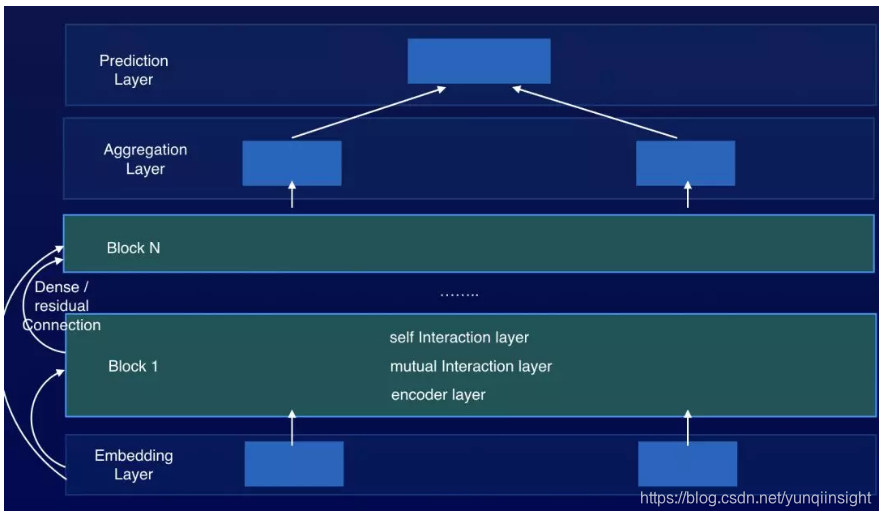

为了增强我们模型框架的表达能力, 我们将Encoder+Interaction Layer打包成一个Block, 通过堆叠多个Block, 通过多次的inter-sentence alignment,可以让我们的模型更充分地理解两句文本之间的匹配关系。

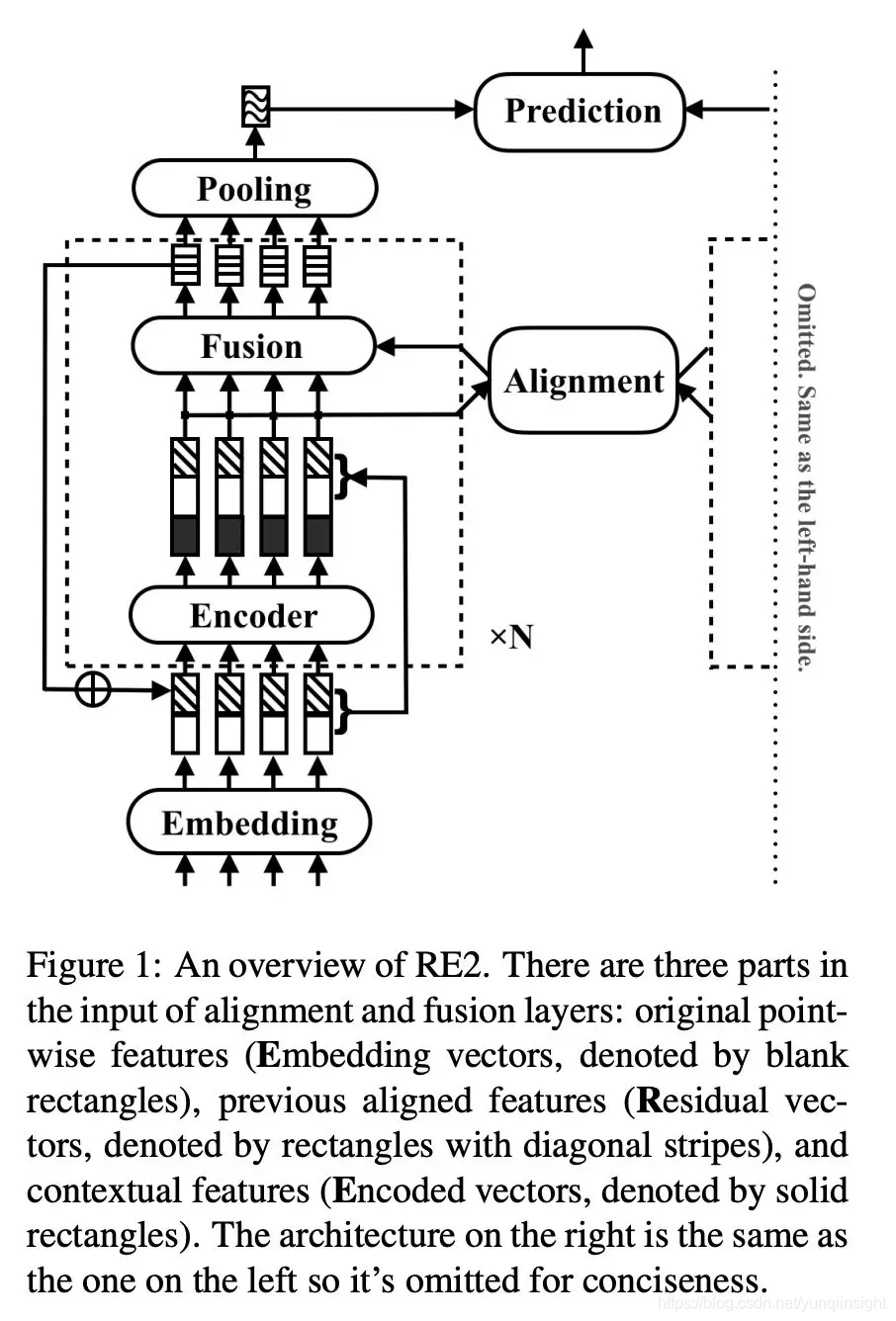

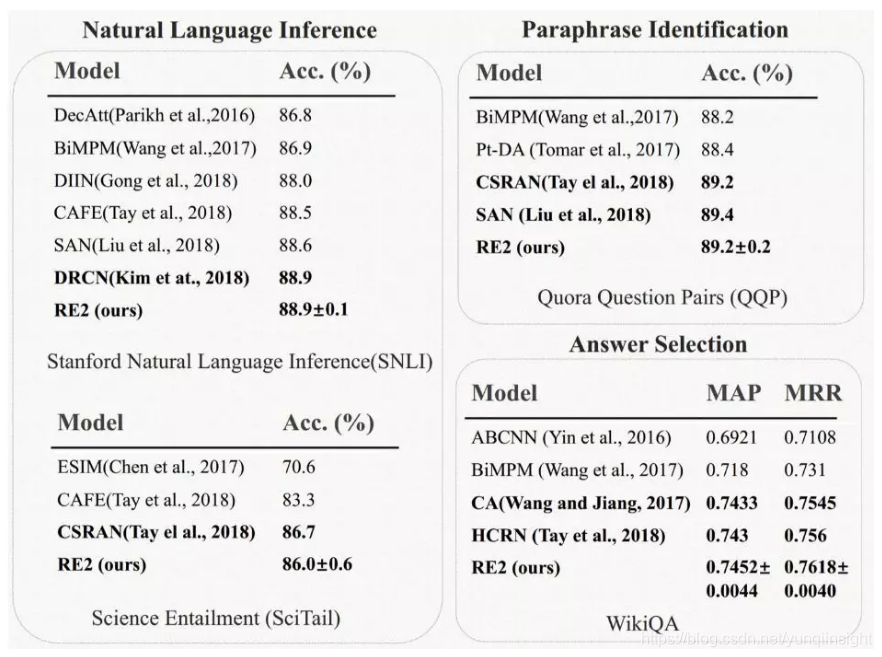

我们基于这种框架,通过大量试验得到一个模型结构RE2, 可以在各类公开数据集、和我们自己的业务数据上都能得到最优的结果,如下图所示。

RE2包括有N个Block, 多个Block的参数完全独立。在每个Block内有一个encoder产出contextual representation, 然后将encoder的输入和输出拼在一起,做inter-sentence alignment,之后通过fusion得到Block的输出。第i个Block的输出,会通过Augmented Residual Connection的方式与这个Block的输入进行融合, 作为第i+1个Block的输入。

下面我们详细介绍每个部分:

2.1 Augmented Residual Connection

连续的Block之间用Augmented Residual Connection来连接, 我们将第n个Block第i个位置的输出记作:是个全零的向量。

第一个Block的输入为, 也就是Embeddling Layer的输出, 在Augmented Residual Connection中,第n个block的输入为:

其中 [;] 表示拼接操作;

在interaction layer的输入中,存在三种信息, 一是original point-wise information, 在这里就是原始的词向量,在每个Block中都会使用这份信息;二是通过encoder编码得到的contextual information;三是之前两层Block经过对齐加工过的信息。这三份信息,对最终的结果都有不可替代的作用, 在试验分析中会展显这一点。在我们这里encoder使用两层CNN(SAME padding)。

2.2 Alignment Layer

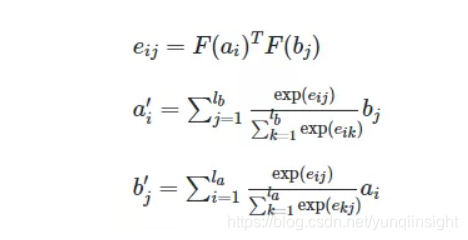

这块我们使用Decomposable Attention Model(Parikh et al., 2016)的对齐机制:

2.3 Fusion Layer

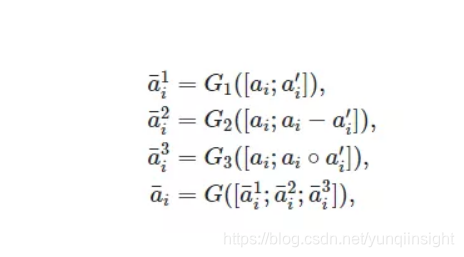

这块我们参考CAFE中对concat、multiply、sub三个操作分别通过FM计算三个scalar特征值, 我们针对这三个操作, 用独立的三个全连接网络计算三个vector特征, 之后将三个vector拼接并用进行projection。

2.4 Prediction Layer

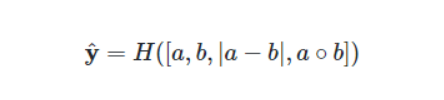

输出层就比较常规,针对文本相似度匹配这类任务, 我们使用对称的形式:

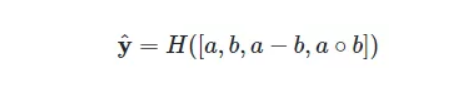

针对文本蕴含、问答匹配这类任务, 我们使用

其中H表示多层全联接网络;

3.试验

3.1 数据集

要验证模型效果,我们选择三类NLP任务, Nature Language Inference、Paraphrase Identification、Question Answering, 选用SNLI、MultiNLI、SciTail、Quora Question Pair、Wikiqa这样几份公开数据集。评估指标,前两个任务选用Acc, 后一个任务选择MAP/MRR。

3.2 实现细节

我们用Tensorflow实现模型, 用Nvidia P100 GPU 训练模型, 英文数据集使用NLTK分词并统一转小写、去除所有标点。序列长度不做限制,每个batch中的序列统一pad到这个batch中最长序列长度,词向量选用840B-300d Glove向量,在训练过程中fix住,所有OOV词初始化为0向量,训练中不更新这些参数。所有其他参数使用He initialization, 并用Weight normalization归一化;每个卷积层或全联接层之后,有dropout层,keep rate设为0.8;输出层是两层前馈网络;Block数量在1-5之间调参。

在这几份公开数据集上, 隐层大小设为150;激活函数使用GeLU激活函数。优化算法选用Adam,学习率先线性warmup然后指数方式衰减,初始学习率在1e-4~ 3e-3之间调参;batch size在64~512之间调参。

3.3 结果

我们在这几份公开数据集上,均取得state-of-art的结果(不使用BERT的情况下):

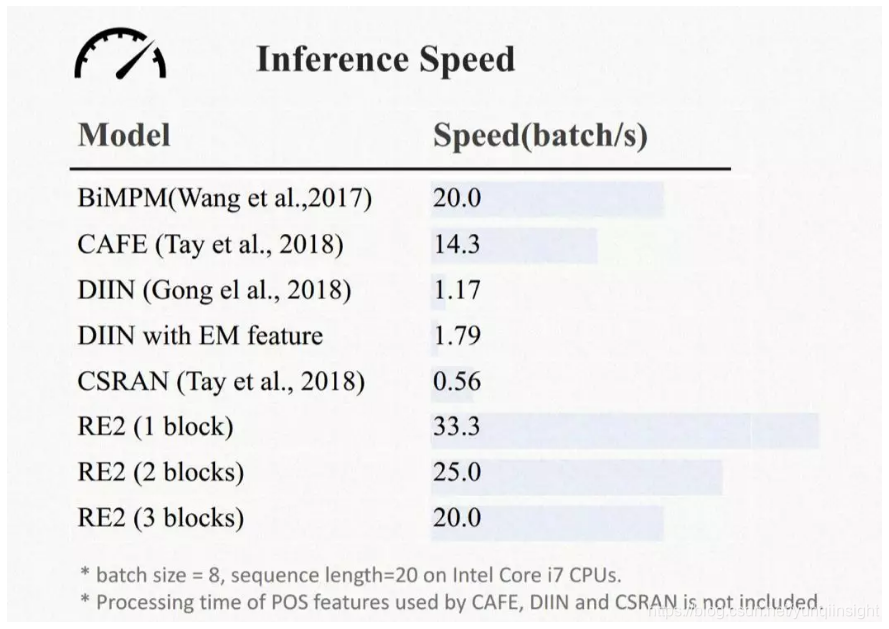

同样这个模型性能上也有很良好的表现,参数量和inference speed都有很强的竞争力, 从而可以在我们店小蜜这样的工业场景中得到广泛应用,给我们匹配准确率这样的业务指标上带来显著的提升。

3.4 结果分析

3.4.1 Ablation study

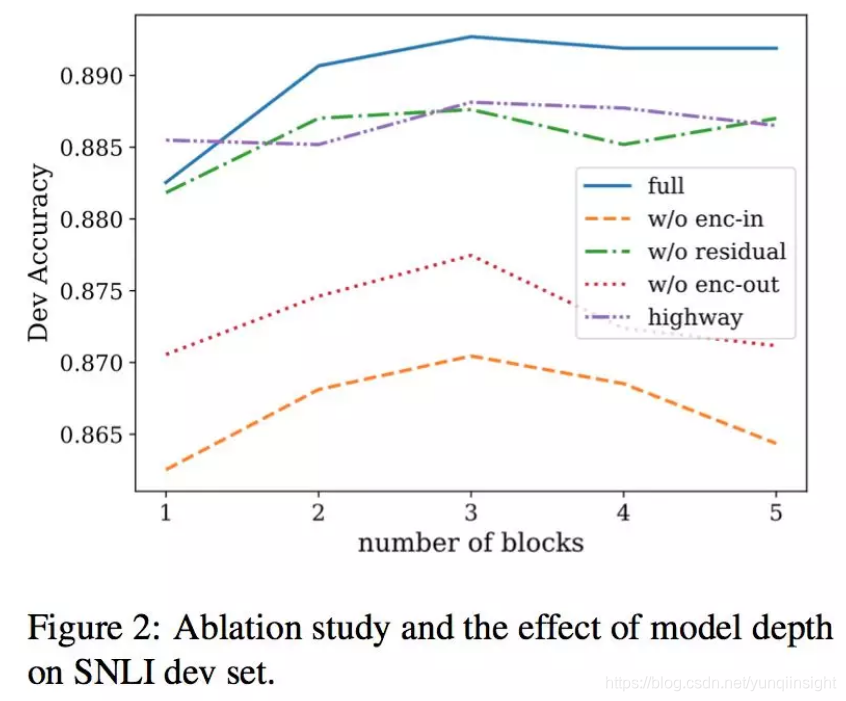

我们构造了四个baseline模型, 分别是:

1) w/o enc-in: alignment layer只使用encoder的输出;

2) w/o residual:去除所有block之间的residual 连接;

3) w/o enc-out: 去除所有encoder,alignment layer只使用block的输入;

4) highway: 使用highway 网络融合encoder的输入和输出,而不是直接拼接。

在SNLI上得到的结果如图所示。通过1)3)和完整模型的对比, 我们发现alignment layer只使用encoder的输出或只使用encoder的输入,都会得到很差的结果,说明原始的词向量信息、之前Block产出的align信息、当前Block中encoder产出的上下文信息,对最终的结果都是缺一不可的。通过2)和完整模型的对比,我们发现Block之间residual连接发挥了作用;而4)和完整模型的对比显示,我们直接拼接的方式是个更优解。

3.4.2 Block数量的影响

如上图所示,通过Augmented Residual Connection连接的网络,更容易在深层网络中生效,能够支撑更深的网络层次,而其他baseline 模型,在Block数量大于3时, 效果会有很明显的下降,并不能支撑更深层模型的应用。

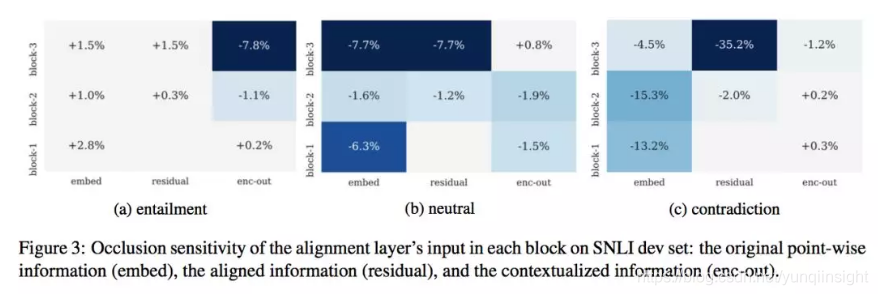

3.4.3 Occlusion sensitivity

前面讲过, 在alignment layer的输入中,其实是三类信息的拼接:原始的词向量信息、之前Block产出的align信息、当前Block中encoder产出的上下文信息, 为了更好地理解这三份信息对最终结果的影响,我们参照机器视觉中相关工作, 进行了Occlusion sensitivity的分析。我们在SNLI-dev数据上,使用包含3个Block的一个RE2模型,分别将某层Block中alignment layer输入特征的某部分mask成0向量,然后观察在entailment、neutral 、 contradiction三个类别上的准确率变化:

可以得到几个分析结论:

- mask原始的词向量信息, 会对neutral和contradiction类的识别带来比较大的损失, 说明原始词向量信息在判断两个句子差异性上发挥着重要作用;

- mask之前Block产出的alignment信息, 会对neutral和contradiction类带来比较大的影响,尤其是最后一层Block的这部分信息对最终的结果影响最大, 说明residual connection使得当前Block能更准确地关注应该关注的部分;

- mask住Encoder的输出结果, 对entailment的影响更大,因为encoder是对phrase-level 的语义进行建模, encoder的产出更有助于entailment的判断;

3.4.4 Case study

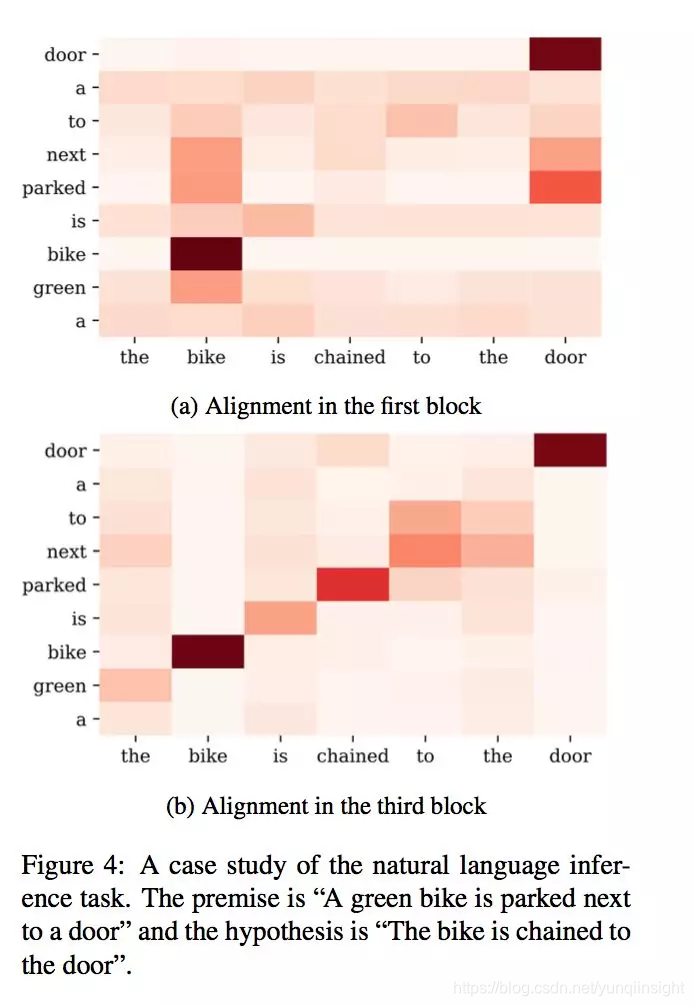

我们选了一个具体的case分析多层Block的作用。

这个case中, 两句话分别是“A green bike is parked next to a door”“The bike is chained to the door”。在第一层Block中,是词汇/短语级别的对齐, 而“parked next to”和“chained to”之间只有很弱的连接,而在第三层Block中, 可以看到两者已经对齐, 从而模型可以根据“parked next to”和“chained to”之间的关系,对两句话整体的语义关系做出判断。从中也可以看到,随着Block的递增, 每层Block的alignment关注的信息都随之进行着调整,通过不止一次的alignment, 可以让模型更好地理解两句话之间的语义关系。

4. 业务结果

在店小蜜中,自定义知识库是由商家维护,我们提供知识定位方案;在店小蜜无法给出准确回复时, 我们会推荐相关知识,这里的文本匹配模型,也主要用在店小蜜的这两个业务模块。我们重点优化了7个大类行业模型(服饰、美妆洗护、鞋、电器、茶酒零食、母婴、数码)、一个大盘基础模型和相关知识推荐模型。在保证覆盖率的情况下, 7类主营行业准确率从不到80%提升到89.5%,大盘基础模型准确率提升到84%,知识推荐有效点击从14%左右提升到19.5%。

店小蜜自定义知识库后台配置:

店小蜜旺旺咨询示例:

总结展望

我们在工业场景下,实现了一个简洁同时具有很强表达能力的模型框架,并在公开数据集和业务数据集上取得很好的结果。

- 这种「通用」的语义匹配模型,已经对当前的业务带来很大的提升, 但是,针对店小蜜这样的业务场景, 是否在不同行业不同场景下可以得到更合适更有特色的解决方案,比如融合进商品知识、活动知识等外部知识做文本匹配。

- 怎么进一步完善FaqBot的技术体系,比如在文本分类、Fewshot分类等方向,也是我们团队的一个重点工作。

- 随着BERT模型的出现,NLP各项任务都达到了新的SOTA。然而BERT过于庞大,对计算资源的需求很高,因此我们想利用Teacher-Student框架将BERT模型的能力迁移到RE2模型上。

原文链接

本文为云栖社区原创内容,未经允许不得转载。