0 摘要

Background and Objective: 打鼾是一种普遍现象。 它可能是良性的,但也可能是阻塞性睡眠呼吸暂停 (OSA) 一种普遍存在的睡眠障碍的症状。 准确检测打鼾可能有助于筛查和诊断 OSA。

Methods: 我们介绍了一种基于卷积神经网络 (CNN) 和循环神经网络 (RNN) 组合的打鼾检测算法。 我们获得了转诊到临床中心进行睡眠研究的 38 名受试者的录音。 所有受试者都由放置在床周围关键位置的总共 5 个麦克风记录。 CNN 用于从声音频谱图中提取特征,而 RNN 用于处理连续的 CNN 输出并将音频事件分类为打鼾和非打鼾事件。 我们还解决了麦克风放置对算法性能的影响。

Results: 该算法在我们的数据集(包括 18412 个声音事件)的鼾声检测中对所有麦克风实现了 95.3 ± 0.5% 的准确度、92.2 ± 0.9% 的灵敏度和 97.7 ± 0.4% 的特异性。 从放置在受试者头部上方约 70 cm 处的麦克风观察到的最佳准确度 (95.9%),从放置在受试者头部上方约 130 cm 处的麦克风观察到的最差 (94.4%)。

Conclusion: 我们的结果表明,我们的方法可以高精度地从录音中检测打鼾事件,并且麦克风的放置对检测性能没有重大影响。

keywords: Snore detection, Convolutional neural network, Recurrent neural network, Audio signal processing, Constant Q transformation, Body-position in sleep

1 引言

Motivation: 尽管上述几项研究产生了相对准确或至少有希望的结果,但它们涉及手动特征提取,这不仅需要特定领域和信号处理知识,还需要大量人力。

Methods: 作者引入了一种使用音频信号进行打鼾检测的深度学习方法。 网络架构主要由三个卷积神经网络 (CNN) 层和一个循环神经网络 (RNN) 层组成。 (1)CNN 层用于从音频数据的二维 (2D) 表示中自动提取特征(无需人工进行特征工程)[16,17]。(2)由于其在低频范围内具有更高的频谱分辨率,类似于梅尔标度,因此选择了恒定 Q 变换 (Constant-Q transformation, CQT) 来将音频信号转换为其相关的 2D 表示。 它已由 Youngberg 和 Boll [18] 以及后来的 Brown [19] 提出,并已用于音乐处理 [20-22]。(3) RNN 层用于探索音频数据的序列特征,已广泛应用于其它基于音频的应用,如语音识别 [23,24] 和自然语言处理 [25-27]。

此外,在以前的研究中,麦克风几乎总是放置在一个固定位置,这似乎是临时的,并且因研究而异(见表 6)。 打鼾记录技术缺乏一致性和建议 [7,28,29]。 有限数量的研究调查了麦克风放置对打鼾记录的影响。 吴等人 [30] 评估了嘴到麦克风的距离对打鼾信号质量和患者舒适度的影响。 该研究建议最佳嘴到麦克风距离为 0.3 m。 赫尔佐格等人 [31] 研究了麦克风放置与鼾声频率分析结果之间的关系。 他们观察到空气耦合麦克风比身体接触麦克风具有更宽的频率范围。 然而,他们的研究并不清楚麦克风的放置如何影响打鼾检测性能。

2 数据和方法

2.1 数据

数据集: 使用的数据集是大型 SOMNIA 数据库 [32] 的一个子集。 根据录音的可用性,包括 38 名受试者。

2017 年 6 月至 2017 年 11 月期间,所有受试者在荷兰 Heeze 的 Kempenhaeghe 睡眠医学中心的睡眠实验室接受了常规 PSG 监测。

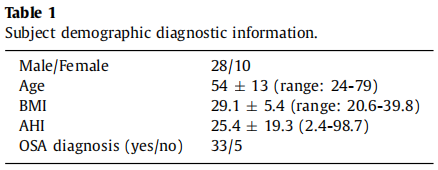

在性别、体重指数 (BMI) 和 AHI 方面没有强加特定的选择要求。 年龄小于 18 岁和接受持续气道正压通气治疗的受试者被排除在外。 表 1 总结了这些受试者的人口统计学和诊断信息。

SOMNIA 研究由 Maxima 医疗中心(荷兰埃因霍温。文件编号:N16.074 和 W17.128)的医学伦理委员会审查。 所有参与者都提供了书面知情同意书。 所有研究均符合赫尔辛基宣言的伦理原则、良好临床实践指南和现行法律要求。 本数据分析研究的方案得到了 Kempenhaeghe 睡眠医学中心审查委员会和飞利浦机构审查委员会(生物医学实验内部委员会)的批准。

2.2 数据标注

声音事件的手动检测是一个劳动密集型过程。 为了加快速度,我们使用了由Arsenali 等人 [14]描述的声音间隔的自动选择。然后是打鼾、非打鼾、可能打鼾和可能非打鼾事件的手动注释,由经验丰富的睡眠技术人员完成。

Arenai 等人的自动检测方法[14]有四个步骤。 首先,原始信号由 A 加权滤波器处理,该滤波器考虑人耳感知的相对响度。 其次,使用持续时间为 0.1 秒和步长为 1 个样本的滚动窗口来估计滤波信号的功率。 第三,双阈值用于从过滤信号的估计功率中检测声音事件。 检测阈值(即,低和高)是为每个记录手动选择的,以考虑由例如空调系统引起的本底噪声的变化。 最后,持续时间小于 0.2 秒的声音事件被排除在进一步分析之外。 此过程导致每个受试者平均 4756 个声音事件(最小值和最大值分别为 1793 和 8509)。

接下来,图形用户界面促进了手动注释,该界面可以对自动检测到的声音事件进行视听检查,并使用其周围环境来加快注释过程。每个事件都由一名注释者标记为以下标签之一:打鼾、非打鼾、可能打鼾和可能非打鼾。这两个标签用于指示既不属于清除打鼾也不属于清除非打鼾的事件(即,它们用于标记不确定事件)。注释者被指示专注于反复出现的打鼾模式。这样做有两个原因。首先,这些模式通常包含相似数量的打鼾和非打鼾声音事件,这会产生一个平衡良好的数据集。其次,在打鼾序列内进行注释时,注释过程通常比在此模式之外进行注释时更快。上述过程共产生了 20225 个带注释的声音事件,包括 7936 个(39.2%)打鼾事件(每个受试者的范围从 25 到 439 个)、10476 个(51.8%)非打鼾事件和 1813 个(9%)不确定事件(注释为可能打鼾和可能不打鼾)。本研究排除了不确定事件,因为尚不清楚这些事件是打鼾还是呼吸急促。

2.3 数据预处理及表示

图 2 显示了主要的数据处理步骤。 对于每个声音事件,将截止频率为 50 Hz 且阶数为 3 的低通滤波器应用于其相关的音频信号,以去除电源噪声。 为了确保 CNN 层的所有输入具有相同的长度,我们截断了超过 3.5 秒的声音事件,并在处理之前对较短的事件使用零填充。 3.5 s 的长度是通过检查所有带注释的声音事件的持续时间来决定的。

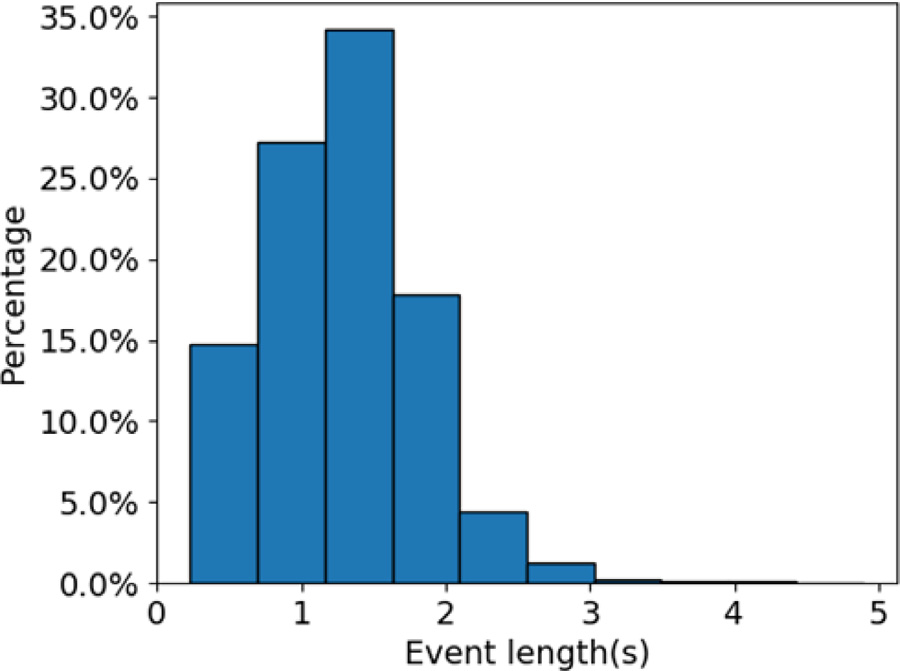

图 3 显示了所有声音事件的时间长度分布,从中我们可以看出大多数声音事件(> 99%)短于 3.5 s,平均持续时间为 1.3 s。 因此,选择 3.5 s 以减少不必要的计算并保留尽可能多的信息。

将事件切割为 3.5 秒后,信号通过 CQT,产生其 2D 频谱图表示。 这种表示同时显示了时域和频域,并实现了输入数据的简化。 在 CQT 中,Q 代表 Q 因子,它是中心频率与带宽的比值。 所有频率仓的 Q 因子都相等。 这里我们简要介绍 CQT 的数学计算,更多细节可以在 [18,19]找到。

Q 因子可以表示为

Q=fkΔfk(1)Q = \frac{f_k}{\Delta f_k} \tag1Q=Δfkfk(1)

其中Δfk\Delta f_kΔfk是带宽,fkf_kfk 是第kkk 个 bin 的中心频率。fkf_kfk值可以由下式来获取:

fk=f12k−1B(2)f_k = f_1 2^{\frac{k-1}{B}} \tag2fk=f12Bk−1(2)

其中f1f_1f1是最低频率仓的中心频率,B 表示每倍频程的仓数。

基于这两个方程,CQT频谱图在低频范围内具有较高的频率分辨率,在高频范围内具有较高的时间分辨率。 这一重要特性使得 CQT 比线性频率尺度上的短时傅立叶变换更适合于打鼾信号处理,因为打鼾声音在低频段比在高频段具有更多的成分 [28]。 此外,CQT 的频率尺度接近人类听觉系统 [20],这类似于众所周知的 Mel 频率尺度,但在低频段具有更多细节。

对于离散时域信号x(n)x(n)x(n),其 CQT X(k,n)X(k, n)X(k,n) 定义为:

X(k,n)=∑j=n−⌊Nk/2⌋j=n+⌊Nk/2⌋x(j)ak∗(j−n+Nk/2)(3)X(k,n) = \sum_{j = n - \lfloor N_k/2 \rfloor}^{j = n + \lfloor N_k/2 \rfloor} x(j) a_k^*(j-n+N_k/2) \tag3X(k,n)=j=n−⌊Nk/2⌋∑j=n+⌊Nk/2⌋x(j)ak∗(j−n+Nk/2)(3)

其中⌊∙⌋\lfloor \bullet \rfloor⌊∙⌋表示向负无穷大舍入,ak∗(n)a_k^*(n)ak∗(n)是ak(n)a_k(n)ak(n)的复共轭。基函数 ak(n)a_k(n)ak(n) 是复值波形,定义为

ak(n)=1Nkw(nNk)exp[−i2πnfkfs](4)a_k(n) = \frac{1}{N_k}w(\frac{n}{N_k})exp[-i 2\pi n \frac{f_k}{f_s}] \tag4ak(n)=Nk1w(Nkn)exp[−i2πnfsfk](4)

其中 fsf_sfs 是采样频率,w(t)w(t)w(t) 是一个连续的窗函数(本工作中的 Hanning), Nk∈RN_k \in RNk∈R 在公式(3)-(4)处表示采样窗口长度。

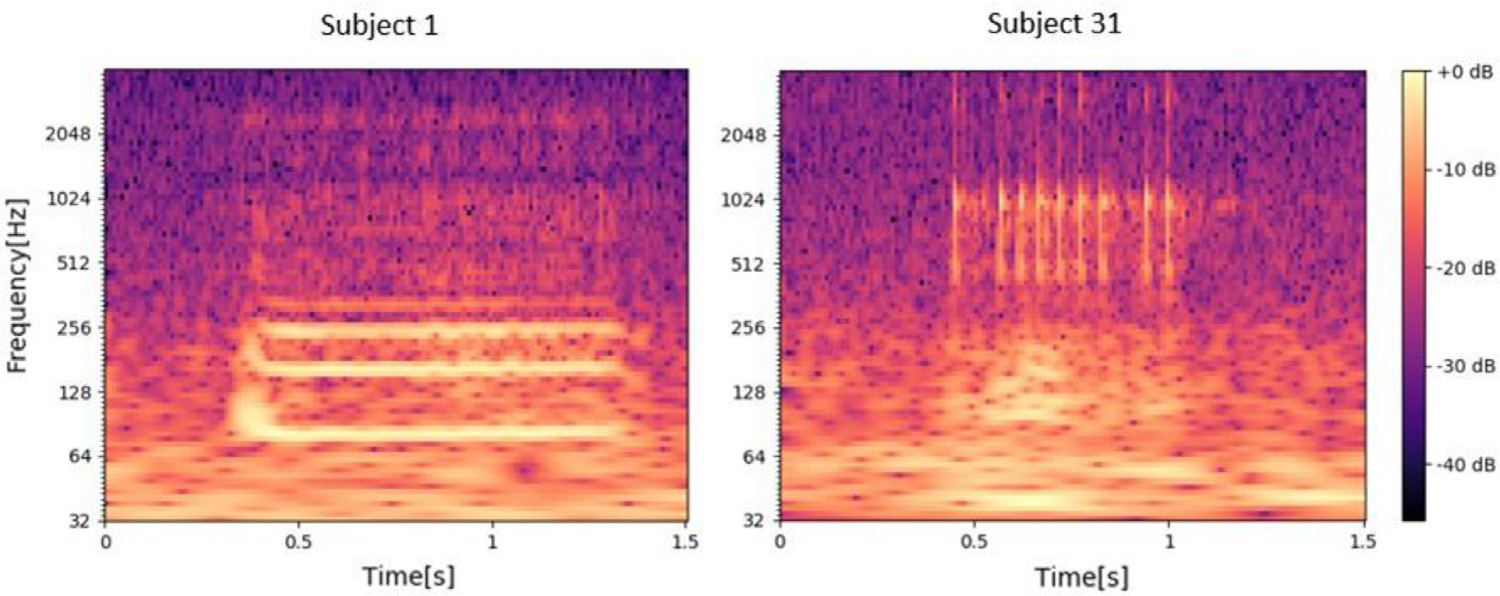

CQT 计算基于 Python 库 LibROSA (https://librosa.github.io/librosa) 使用 Youngberg 和 Boll [18] 提出的递归子采样方法实现的。 在计算 CQT 能量时,选择了 512 个样本的跳跃长度和 84 个 bin 数(每倍频程 12 个 bin)。 然后用对数标度(以分贝为单位)转换计算出的光谱能量,以应对大范围的能量强度。 包括 7 个鼾声事件和相应 CQT 频谱图的音频信号的示例如图 4 所示。可以观察到,鼾声事件的主频率分量主要分布在低频范围内,CQT 频谱图提供了准确的表示。

之后,将光谱能量归一化为具有零均值和单位标准偏差,并应用零填充以确保长度为 3.5 s。 这确定了提交给分类神经网络的输入样本。

2.4 深度神经网络体系

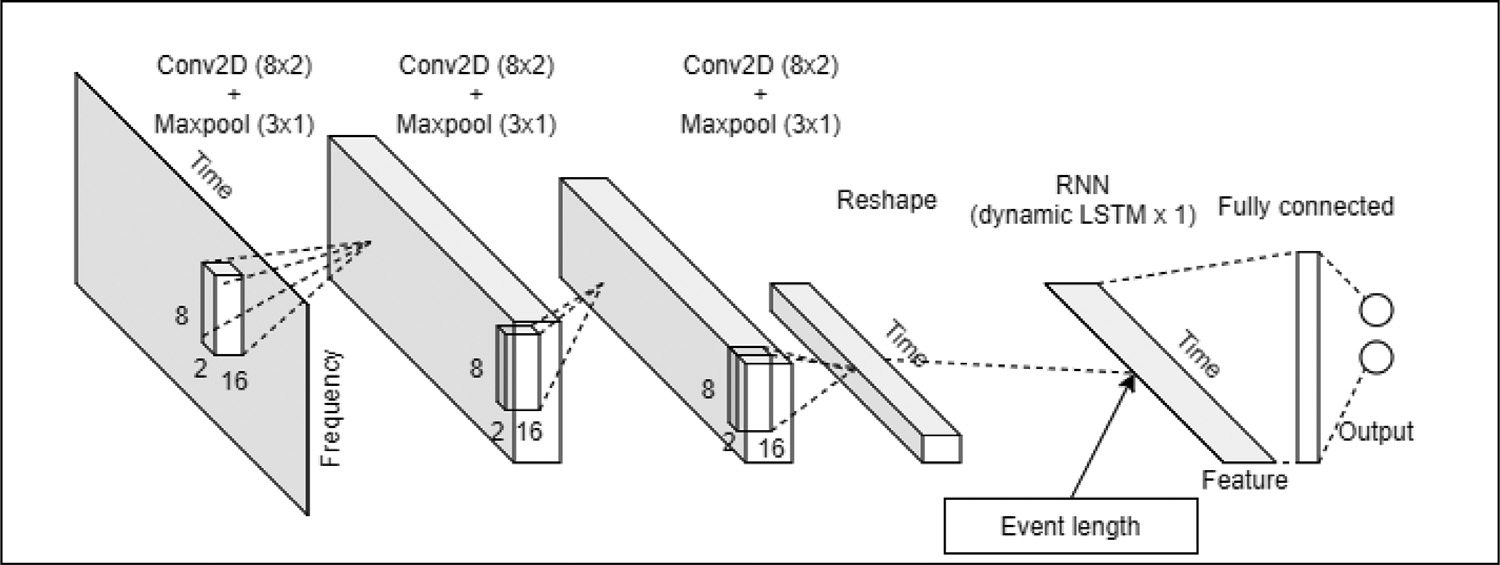

如前所述,我们的深度神经网络架构主要由三个 CNN 层和一个 RNN 层构成,如图 5 所示。该架构是基于对训练损失和准确性的实验设计的。

CNN 层用于从 CQT 频谱图中自动提取时频域特征,而不会沿时间轴改变输入的形状。 CNN 中经常使用的方形滤波器被更改为矩形滤波器,以从频域中获取更多特征 [33]。 这些滤波器沿频率轴 2 和时间轴具有 8 个数据点(像素)的长度。 对于每个 CNN 层,使用“ReLU”作为激活函数,然后是一个 2D 最大池化层和一个丢弃率为 0.5 的丢弃层,以减少过度拟合。

关于 RNN,在我们的架构中选择了长短期记忆 (LSTM) 模型,因为它旨在表征具有长期依赖关系的序列数据,并且它比传统 RNN 模型更有效地用于声学相关应用 [34] . 使用动态 LSTM 层来处理可变序列长度。 从 CNN 获得的特征和沿时间轴的声音事件的频谱图长度一起输入到具有 64 个隐藏单元的动态 LSTM 层。 之后,连接具有“softmax”激活函数的全连接层以生成模型输出(即检测打鼾事件)。

在训练过程中,使用学习率为 0.001 的自适应矩估计算法(Adam)作为优化器,使用交叉熵作为损失函数。 批量大小和纪元数(batch size and epoch number)根据经验分别设置为 64 和 100。 这些超参数是通过实验确定的。

2.5 验证

我们使用 5 折交叉验证来迭代训练和测试我们的算法。 38 名受试者被分为五组,三组 8 名受试者和两组 7 名受试者。在每一轮交叉验证中,四组用于训练,剩下的一组用于测试。这种方法可确保“独立于主题”的建模和评估,其中来自同一主题的数据不会同时出现在训练和测试组中。运行交叉验证后,我们得到了五组检测输出。我们对这些输出应用了 0.5 的分类阈值以获得打鼾/非打鼾分类。然后我们评估了每个科目的表现。之后,将所有这些结果集汇总在一起以评估算法的整体性能。分类结果由混淆矩阵、阳性预测值 (PPV)、阴性预测值 (NPV)、敏感性、特异性和准确性表示。为了公平比较,分别训练和验证不同麦克风记录的音频数据。

2.6 麦克风放置分析

为了研究麦克风放置对打鼾检测精度的影响,从 PSG 数据中提取所有打鼾事件的身体位置信息。 总共有4种不同的体位:

- 睡在右肩上(身体面向 M3),

- 仰卧(仰卧,身体面向M1和M2),

- 睡在左肩(身体面向 M4),

- 趴着睡觉(俯卧)。

监测和分析每个麦克风每个身体位置的鼾声事件检测率,以评估麦克风放置对分类性能的影响。 为了确保一个麦克风只有一个面向它的体位,当M5在床的左侧时,我们将M5的体位左右切换,因为M5没有固定在一个位置(右27,左11) . 此后,M5在右侧体位的检出率即为身体面向M5时的检出率。

3 结果

打鼾和非打鼾分类的混淆矩阵是从所有 38 名受试者可用的声音注释上的每个麦克风数据流中获得的。表 2 中给出了 5 个混淆矩阵,从中计算了分类器的主要性能指标,包括阳性预测值 (PPV)、阴性预测值 (NPV)、敏感性、特异性和准确性。表 3 将每个麦克风条件的这些值以百分比形式报告为汇总值(整体性能)。汇集的准确度值在 94.4% 和 95.9% 之间的范围内,虽然相似,但它们在麦克风之间显示出有趣的差异。当使用位于受试者 (M1) 上方 70 cm 处的麦克风时,我们的方法在 PPV (97.6%)、特异性 (98.3%) 和准确性 (95.9%) 方面实现了最佳的整体性能。使用 M3 和 M4 获得第二好的结果,它们以固定距离放置在对象的左侧或右侧。 M5 放置在床头柜上更远的地方,而 M2 位于对象上方 130 厘米处,导致大多数指标的表现最差。通过将汇总的灵敏度和特异性值分别解释为打鼾和非打鼾声音的检测率,可以观察到非打鼾事件比打鼾事件更容易识别,平均差异为 5.5%,最大值为 6.9% M2 和 M4 最低 4.2%。

在表 3 中,除了整体合并性能外,我们还指出了所有麦克风的每个主题的中值和四分位距 (IQR)。通过这种方式,可以在个体层面评估分类器的性能。所有中值均高于合并值,PPV 在 97.1% 到 98.2% 之间,NPV 在 97.0% 到 98.7% 之间,敏感性在 95.4% 到 97.7% 之间,特异性在 95.4% 到 97.7% 之间,准确度在 96.3 之间% 和 97.8%。它们显示出与整体性能相似的趋势,M1 的性能更好,而 M2 和 M5 的性能更差。除了灵敏度,几乎所有的 IQR 都在 5% 左右。尽管中位数灵敏度远高于汇总灵敏度,但高 IQR(约 10%)表明,相当多的受试者误检了许多打鼾事件。使用 Wilcoxon 秩和检验来测试 M1 和其他麦克风之间差异的显着性,我们发现只有使用 M2 的特异性显着低于使用 M1(p < 0.05)。

4 讨论

我们基于深度神经网络模型从音频录音中开发了一种自动打鼾检测算法。 目前的算法是在 38 名受试者中开发和验证的。 对来自所有麦克风的录音进行 5 倍交叉验证的总体准确度高于 94%。 对于每个受试者的准确性,M1、M3、M4 和 M5 之间没有发现显着差异,表明该算法对麦克风放置和受试者之间的差异具有鲁棒性。 尽管总体准确度很高,但仍有 4.2% 至 6.9% 的打鼾事件被遗漏,并且一些受试者的准确度和灵敏度低于平均水平(图 6)。 为了找出原因,我们分析了BMI、AHI、性别和年龄,发现它们与性能之间没有统计关联。 为了进一步解释错过的打鼾检测,我们对所有错过的事件进行了彻底的监听,直观地分析了 CQT 频谱图,并确定了导致大多数误检测的四个主要因素:

- 呼气时(而不是吸气时)产生的鼾声。

- 对应于弱响度事件的低水平声能。

- 由于咽部收缩的不同位置,鼾声的变化。

- 打鼾和非打鼾事件的手动注释不一致。

对于第一个因素,有一小部分呼气打鼾声音与主要的主要吸气打鼾声音具有不同的声音特征 [35]。它们的小流行使算法难以学习呼气打鼾的特征,从而导致对这些打鼾事件的误检测。 Dafna 等人之前已经发现并解决了这个问题 [11]。关于第二个因素,低水平声能的打鼾事件具有较小的信噪比和较不清晰的频谱图。因此,我们的算法很容易错过这些事件。当谈到第三个因素时,鼾声的特征可能非常多样化,因为它们对应于上呼吸道的不同部分收缩位置 [36]。一个例子如图 7 所示,从中我们可以清楚地看到来自不同受试者的两个打鼾事件的 CQT 谱图。不同的光谱图。如果一种鼾声在训练集中没有很好地代表,则在测试过程中可能会遗漏它。这导致某些特定主题的准确性较低。最后一个因素涉及注释的准确性。注释由一个人完成,没有进一步验证或重新确认。因此,存在与注释相关的主观因素,根据定义,无法保证 100% 准确,这可能会导致错误率。 Dafna 等人也提到了这个因素。 [11] 并且已经通过涉及同一数据集的三个注释者并在没有完全同意的情况下对事件应用多数票来解决。

除了 CQT 谱图外,语音识别中经常使用的 Mel-scale 谱图也使用相同的神经网络模型进行训练和测试。 Huzaifah [37] 已经证明,使用 CNN 进行环境声音分类时,梅尔尺度频谱图的性能始终优于短时傅立叶变换 (STFT) 和 CQT 频谱图。 使用 M1 数据的 Melscaled 频谱图的准确率为 95.3%,中位数为 96.9%,IQR 为 6.7%。 这个性能比 CQT 谱图略差。 然而,得出结论认为 CQT 频谱图在打鼾检测方面始终优于 Mel 标度频谱图是危险的,因为我们只试验了一个数据集,而 CQT 频谱图和 Mel 标度频谱图都可以在一定程度上提供低频范围内的更多细节 . 为了找到音频数据的最佳二维表示,应该测试具有大数据集的其他时频表示(例如 STFT、小波变换)。

为了将我们的研究与之前的工作进行比较,我们在表 6 中总结了之前的研究。 从该表中,我们可以看到大多数方法需要从音频信号中提取多个特征,这需要特定的特征提取和选择算法知识.相比之下,我们的深度 NN 方法算法可以使用 CNN 层自动获取特征,这是本研究的主要新颖之处。虽然孙等人。 [13] 使用原始音频信号,PPV 比我们的低得多。此外,除了 Dafna 等人的研究外,我们的算法优于大多数先前的研究。 [11] 和 Shin 和 Cho [15]。但是 Dafna 等人的方法的一个缺点。 [11] 是它需要 127 个特征。对于 Shin 和 Cho [15],他们只考虑简单的打鼾者。 Ar senali 等。 [14] 在本研究中使用了相同数据的一个子集,并在 6 个受试者上评估了他们的算法,打鼾检测准确率为 95.4%,对于相同的受试者,我们的分类器达到了 97.5% 的准确率。

本研究的另一个贡献涉及麦克风放置对打鼾检测准确性的影响。已发表的探索不同麦克风类型和位置的研究并不总是解决这一问题,如表 6 所示。从表 5 中,我们可以观察到,当麦克风面向对象时,检测率略高,而当麦克风面向对象时,检测率略低。麦克风面向对象的背部进行横向位置。在仰卧位时,考虑到当受试者仰卧时,他的头部仍然可以向左或向右转动,面向其他麦克风,因此很难详细说明。尽管如此,我们注意到仰卧位的检出率低于其他位置的检出率。在检查错误分类的事件后,我们发现在我们的数据集中,具有低声能的弱鼾声的受试者在仰卧位时过多。这是出乎意料的,因为经常观察到在仰卧位打鼾特别响亮,这是由于上咽部分减少引起的帆板或后舌的机械振动 [38]。这可能是由于选择了仅在每晚的一部分采样并且不代表整个睡眠时段的带注释的声音。这需要进一步调查证实。

即使不同麦克风在不同位置的检测率不同,M1、M3 和 M4 的整体性能也相似(表 2)。 因此,我们可以得出结论,在安静的外部条件(卧室的低背景噪音)下评估麦克风放置对检测性能没有重大影响。 从表 2 中我们可以进一步观察到 M2 的整体性能最差。 由于 M2 与对象的距离最大(约 130 厘米),这表明距离可能是比麦克风放置在鼾声检测性能方面更重要的因素。 在这项研究中,我们建议将麦克风紧贴在睡眠者的头顶上方,因为 M1 具有最佳的整体性能。

尽管我们的算法在打鼾检测方面取得了良好的性能,但也存在局限性。 第一个是主体的可变性。 这些特征在年龄、BMI 和 AHI 方面差异很大,再加上样本量有限,很难比较这种方法在不同群体上的表现。 此外,只有少数打鼾事件发生在呼吸暂停附近,这可能是我们找不到这些与检测性能之间相关性的原因。 第二个因素是我们只使用了整夜录音的部分内容。 如果没有对全夜录音进行测试,就很难知道该方法将如何推广到现实世界应用中全夜录音存在的问题。 最后一个限制是安静的背景。 由于该数据集的噪音水平较低,因此不清楚在使用噪音水平较高的录音时性能如何。

5 结论和未来的工作

我们提出了一种深度神经网络模型,可以从音频信号中对打鼾和非打鼾音频事件进行分类。设计的深度学习模型不使用任何人工设计的功能,而是对来自不同位置的 5 个麦克风的 38 个对象的音频数据进行了训练和测试。我们在所有麦克风位置都获得了稳健的性能。该方法优于以往研究中的大多数方法。此外,我们分析了麦克风放置对这种方法性能的影响,发现距离比位置更重要。

未来的工作可以沿着不同的方向进行。第一个可能是进一步提高当前打鼾检测算法的准确性。这可以通过将呼气与吸气鼾声分离、添加更多来自不同对象的事件以提高训练样本的多样性、使用降噪技术提高信噪比、组合来自不同麦克风的信号以增加高质量覆盖范围来实现。信号并进一步检查注释的有效性。另一个方向可能是探索打鼾检测如何帮助 OSA 检测任务。这项研究可能是 OSA 检测的第一步,因为进一步分析打鼾的声学特性可能会产生诊断该病症的特征 [39]。除了声学特性外,打鼾的其他特性(例如睡眠期间打鼾的时间百分比)也可能是呼吸暂停分析的指标。此外,一些研究表明呼吸暂停后立即产生的打鼾与其他打鼾事件之间存在差异 [40,41]。因此,我们可以扩展当前的算法来分离这些鼾声,以潜在地帮助估计 AHI(例如,[42])

参考文献

[1] Chamara V. Senaratna, Jennifer L. Perret, Caroline J. Lodge, Adrian J. Lowe, Brittany E. Campbell, Melanie C. Matheson, Garun S. Hamilton, Shyamali C. Dharmage, Prevalence of obstructive sleep apnea in the general population: a systematic review, Sleep medicine reviews 34 (2017) 70–81.

[2] Terry Young, Paul E. Peppard, Daniel J. Gottlieb, Epidemiology of obstructive sleep apnea: a population health perspective, American journal of respiratory and critical care medicine 165 (9) (2002) 1217–1239.

[3] Fabio Mendonca, Sheikh Shanawaz Mostafa, Antonio G. Ravelo-García, Fernando Morgado-Dias, Thomas Penzel, A review of obstructive sleep apnea detection approaches, IEEE journal of biomedical and health informatics 23 (2) (2018) 825–837.

[4] Asela S. Karunajeewa, Udantha R. Abeyratne, Craig Hukins, Silence-breathing–snore classification from snore-related sounds, Physiological Measurement 29 (2) (2008) 227.

[5] Negar Ahmadi, Gilla K. Shapiro, Sharon A. Chung, Colin M. Shapiro, Clinical diagnosis of sleep apnea based on single night of polysomnography vs. two

nights of polysomnography, Sleep and Breathing 13 (3) (2009) 221–226.

[6] Nimrod Maimon, Patrick J. Hanly, Does snoring intensity correlate with the severity of obstructive sleep apnea? Journal of clinical sleep medicine 6 (05)

(2010) 475–478.

[7] Victor. Hoffstein, Snoring, Chest 109 (1) (1996) 201–223.

[8] W.D. Duckitt, S.K. Tuomi, T.R. Niesler, Automatic detection, segmentation and assessment of snoring from ambient acoustic data, Physiological measurement 27 (10) (2006) 1047.

[9] M. Cavusoglu, M. Kamasak, O. Erogul, T.O.L.G.A. Ciloglu, Y.E. ¸S. ˙I. M. Serinagaoglu, T. Akcam, An efficient method for snore/nonsnore classification of sleep sounds, Physiological measurement 28 (8) (2007) 841.

[10] Ali Azarbarzin, Zahra MK Moussavi, Automatic and unsupervised snore sound extraction from respiratory sound signals, IEEE Transactions on Biomedical Engineering 58 (5) (2011) 1156–1162.

[11] Eliran Dafna, Ariel Tarasiuk, Yaniv Zigel, Automatic detection of whole night snoring events using non-contact microphone, PloS one 8 (12) (2013).

[12] Vinayak R. Swarnkar, Udantha R. Abeyratne, Roneel V. Sharan, Automatic picking of snore events from overnight breath sound recordings, 2017 39th Annual International Conference of the IEEE Engineering in Medicine and Biology Society (EMBC), pp. 2822-2825. IEEE, 2017.

[13] Jingpeng Sun, Xiyuan Hu, Yingying Zhao, Shuchen Sun, Chen Chen, Silong Peng, SnoreNet: Detecting Snore Events from Raw Sound Recordings, 2019 41st Annual International Conference of the IEEE Engineering in Medicine and Biology Society (EMBC), pp. 4977-4981. IEEE„ 2019.

[14] Bruno Arsenali, Johannes van Dijk, Okke Ouweltjes, Bert den Brinker, Dirk Pevernagie, Roy Krijn, Merel van Gilst, Sebastiaan Overeem, Recurrent neural network for classification of snoring and non-snoring sound events, 2018 40th Annual International Conference of the IEEE Engineering in Medicine and Biology Society (EMBC), pp. 328-331. IEEE, 2018.

[15] Hangsik Shin, Jaegeol Cho, Unconstrained snoring detection using a smart-phone during ordinary sleep, Biomedical engineering online 13 (1) (2014) 116.

[16] Tom LH Li, Antoni B. Chan, Andy HW Chun, Automatic musical pattern feature extraction using convolutional neural network, Genre 10 (2010) 1x1.

[17] Minkyu Lim, Donghyun Lee, Hosung Park, Yoseb Kang, Junseok Oh, Jeong-Sik Park, Gil-Jin Jang, Ji-Hwan Kim, Convolutional Neural Network based Audio Event Classification, KSII Transactions on Internet & Information Systems 12 (6) (2018).

[18] James Youngberg, Steven Boll, Constant-Q signal analysis and synthesis, In ICASSP’78. IEEE International Conference on Acoustics, Speech, and Signal Processing, vol. 3, pp. 375-378. IEEE, 1978.

[19] Judith C. Brown, Calculation of a constant Q spectral transform, The Journal of the Acoustical Society of America 89 (1) (1991) 425–434.

[20] Christian Schörkhuber, Anssi Klapuri, Constant-Q transform toolbox for music processing, 7th Sound and Music Computing Conference, Barcelona, Spain, pp.3-64., 2010.

[21] Robert Alexandru Dobre, Negrescu Cristian, “Automatic music transcription software based on constant Q transform.”, 2016 8th International Conference on Electronics, Computers and Artificial Intelligence (ECAI), pp. 1-4. IEEE, 2016.

[22] Chun-Ta Chen, Jyh-Shing Roger Jang, Wen-Shan Liu, Chi-Yao Weng, An efficient method for polyphonic audio-to-score alignment using onset detection and constant Q transform, 2016 IEEE International Conference on Acoustics, Speech And Signal Processing (ICASSP), pp. 2802-2806. IEEE, 2016.

[23] Alex Graves, Abdel-rahman Mohamed, Geoffrey Hinton, Speech recognition with deep recurrent neural networks, 2013 IEEE international conference on acoustics, speech and signal processing, pp. 6645-6649. IEEE, 2013.

[24] Sak, Ha ¸sim, Andrew Senior, Kanishka Rao, and Françoise Beaufays. “Fast and accurate recurrent neural network acoustic models for speech recognition.” arXiv preprint arXiv:1507.06947 (2015).

[25] Tomáš Mikolov, Martin Karafiát, Lukáš Burget, Jan ˇ Cernocký, Sanjeev Khudanpur, Recurrent neural network based language model, Eleventh annual conference of the international speech communication association (2010).

[26] Tomáš Mikolov, Stefan Kombrink, Lukáš Burget, Jan ˇCernocký, Sanjeev Khudanpur, Extensions of recurrent neural network language model, 2011 IEEE international conference on acoustics, speech and signal processing (ICASSP), pp.5528-5531. IEEE„ 2011.

[27] Tomas Mikolov, Geoffrey Zweig, Context dependent recurrent neural network language model, 2012 IEEE Spoken Language Technology Workshop (SLT), pp.234-239. IEEE, 2012.

[28] Dirk Pevernagie, Ronald M. Aarts, Micheline De Meyer, The acoustics of snoring, Sleep medicine reviews 14 (2) (2010) 131–144.

[29] Carolina Beatriz Gonzalez de Oliveira, Diego Greatti Vaz da Silva, Henrique Takachi Moriya, Robert Skomro, Adriano Mesquita Alencar, Geraldo Lorenzi-Filho, Snoring: the silent signal in sleep medicine, Sleep Science 4 (1) (2011) 21–27.

[30] Andrew Keong Ng, Zhi Jie Ho, Tong San Koh, Effects of microphone position on snore signal quality and patient comfort, 2008 9th International Conference on

Signal Processing, pp. 2130-2133. IEEE, 2008.

[31] Michael Herzog, Thomas Kühnel, Thomas Bremert, Beatrice Herzog, Werner Hosemann, Holger Kaftan, The impact of the microphone position on the frequency analysis of snoring sounds, European archives of oto-rhino-laryngology 266 (8) (2009) 1315–1322.

[32] Merel M. van Gilst, Johannes P.van Dijk, Roy Krijn, Bertram Hoondert, Pedro Fonseca, Ruud JG van Sloun, Bruno Arsenali, et al., Protocol of the SOMNIA project: an observational study to create a neurophysiological database for advanced clinical sleep monitoring, BMJ open 9 (11) (2019).

[33] Jordi Pons, Thomas Lidy, Xavier Serra, Experimenting with musically motivated convolutional neural networks, 2016 14th international workshop on content-based multimedia indexing (CBMI), pp. 1-6. IEEE, 2016.

[34] Sak, Hasim, Andrew W. Senior, and Françoise Beaufays. “Long short-term memory recurrent neural network architectures for large scale acoustic modeling.” (2014).

[35] W. Whitelaw, Characteristics of the snoring noise in patients with and without occlusive sleep apnea, Am Rev Respir Dis 147 (1993) 635–644.

[36] Yoshiaki Miyazaki, Kazuo Itasaka, Kiyoshi Ishikawa, Soichiro Togawa, Acoustic analysis of snoring and the site of airway obstruction in sleep related respiratory disorders, Acta Oto-Laryngologica 118 (537) (1998) 47–51.

[37] Huzaifah, Muhammad. “Comparison of time-frequency representations for environmental sound classification using convolutional neural networks.” arXiv preprint arXiv:1706.07156 (2017).

[38] Hiroshi Nakano, Togo Ikeda, Makito Hayashi, Etsuko Ohshima, Akihiro Onizuka, Effects of body position on snoring in apneic and nonapneic snorers, Sleep 26(2) (2003) 169–172.

[39] Hui Jin, Li-Ang Lee, Lijuan Song, Yanmei Li, Jianxin Peng, Nanshan Zhong, Hsueh-Yu Li, Xiaowen Zhang, Acoustic analysis of snoring in the diagnosis of obstructive sleep apnea syndrome: a call for more rigorous studies, Journal of Clinical Sleep Medicine 11 (7) (2015) 765–771.

[40] W. Whitelaw, Characteristics of the snoring noise in patients with and without occlusive sleep apnea, Am Rev Respir Dis 147 (1993) 635–644.

[41] J.A. Fiz, J. Abad, R. Jane, M. Riera, M.A. Mananas, P. Caminal, D. Rodenstein, J. Morera, Acoustic analysis of snoring sound in patients with simple snoring and obstructive sleep apnoea, European Respiratory Journal 9 (11) (1996) 2365–2370.

[42] Nir Ben-Israel, Ariel Tarasiuk, Yaniv Zigel, Obstructive apnea hypopnea index estimation by analysis of nocturnal snoring signals in adults, Sleep 35 (9) (2012) 1299–1305.

怎么办)

)

![计算机连接交换机配置命令,[计算机]交换机配置命令.doc](http://pic.xiahunao.cn/计算机连接交换机配置命令,[计算机]交换机配置命令.doc)

》19年12月在线作业【满分答案】...)

)