上一篇文章(第六章)主要介绍了最大熵模型,并从中推导出逻辑斯谛回归,感觉意犹未尽。在复习了CS229 Lecture note之后,我决定重新整理思路:从广义线性模型的角度来看逻辑斯谛回归。最后,基于样本特征 X 分布的假设,生成和逻辑斯谛回归一样的模型。

一、背景

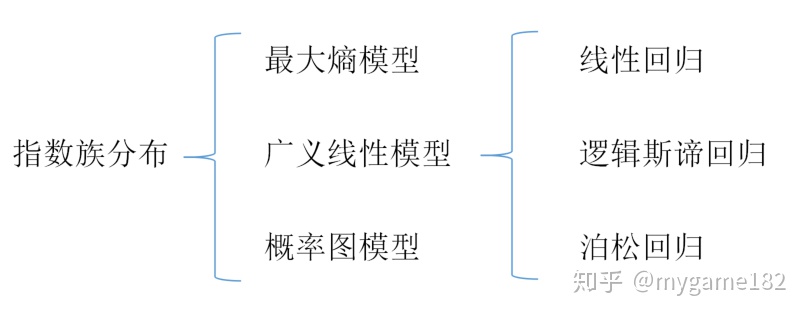

上图参考了b站“机器学习白板推导系列”:https://www.bilibili.com/video/BV1aE411o7qd?p=39

实际上,逻辑斯谛回归是广义线性模型的一种,而广义线性模型与最大熵模型都是源于指数族分布。因此直接从最大熵模型推出逻辑斯谛回归,确实有些不太自然的地方(具体在“特征函数”的取值上,违背了原来特征函数的取值假设),但从广义线性模型出发就没有违和感了。

二、指数族分布

什么是指数族分布呢?它是一个分布家族,包括:高斯分布、伯努利分布、二项分布、泊松分布等常见分布。

关于“指数族分布”可以参考这篇文章:https://zhuanlan.zhihu.com/p/89155678,是根据“白板推导”整理而成的笔记。

(1)一般形式

指数族分布具有以下一般形式:(此处使用CS229的符号规则)

其中:

(2)高斯分布

为了简化计算,假设高斯分布的方差为1:

它的指数族形式如下:

(3)伯努利分布

它的指数族形式如下:

三、广义线性模型

广义线性模型用来解决“给定

,经常假设

假设一: 认为 y 是服从指数族分布的。由于广义线性模型既可用于“回归”,也可用于“分类”,因此不同分布将生成不同模型。回归对应连续型分布,分类对应离散型分布。

假设二:

假设三:“自然参数”是样本x的线性组合,因此它是一个“线性模型”。

见证奇迹的时刻,看如何通过三个假设,得到不同的线性模型:

(1)线性回归

线性回归对应高斯分布:

根据假设二,线性模型有如下形式:

线性回归模型的输出:

(2)Logistic Regression

逻辑斯谛回归对应伯努利分布:

逻辑斯谛回归的分类结果:

(3)Softmax Regression

Softmax 与 多项逻辑斯谛回归是等价的,下面将证明这一点,它被用于解决多分类问题。由于涉及多分类,不能简单地假设

设

用分布参数

当

当

由此可见,上述 k 个参数

令

其中

接下来是关键一步,由于

由此得到 softmax 的概率质量函数:

如果把

以上就是 softmax 的指数族形式。

最后,寻找“自然参数”

由于

把上式左右两边累加起来,得到:

将“即”字后面的两个式子整理一下,得到:

但请注意:

刚好满足

根据假设三:

当

当

上述式(3)、式(4)就是 Softmax Regression 模型,与多项逻辑斯谛回归模型一样。

四、线性从何而来

如果选择一个公式代表“逻辑斯谛回归”,该选择哪个公式呢?我认为是:

也就是“对数几率”等于 x 的线性函数。

从这个公式出发,可以推导出逻辑斯谛回归的全部公式。

如果把右侧的线性模型记作 s,上式可以表示为

sigmoid 的作用是将

回顾感知机模型(线性模型),通过模型的符号标记分类结果,逻辑斯谛回归只是进一步把符号转换为概率值。如果把线性模型替换为其他非线性模型,只要用正数、负数表示不同分类,将其代入 sigmoid 函数,仍可得到不同的概率输出。

最后一个问题:为什么选择线性模型

仅仅是因为线性模型最简单吗?此处试图从另一个角度看待这个问题。根据贝叶斯定理,

其中

上式等号右侧为 x 与 参数

在更为一般的情况下,如果将

请参阅:https://tech.meituan.com/2015/05/08/intro-to-logistic-regression.html

延伸阅读部分。

)

ResourceBundle类)

)