原文来源:arXiv

作者:Alex Lamb、Jonathan Binas、Anirudh Goyal、Dmitriy Serdyuk、Sandeep Subramanian、Ioannis Mitliagkas、Yoshua Bengio

「雷克世界」编译:嗯~是阿童木呀、KABUDA、EVA

导语:深度神经网络在各种各样的重要任务中取得了令人印象深刻的成果。但有一点,对不同于训练分布的数据进行评估时,表现并不是很好。最近,蒙特利尔算法学习研究所提出了一种强化网络,它能够有效提高现有深度神经网络的鲁棒性。

众所周知,深度网络已经在各种各样的重要任务中取得了令人印象深刻的成果。然而,其一个已知的弱点是在对不同于训练分布的数据进行评估时,即使这些差异非常小,仍然表现不佳,比如对抗样本。我们提出了强化网络(Fortified Networks),它是现有网络的一个简单转化,通过识别隐藏状态在数据流形中断开的时间,并将这些隐藏状态映射回到网络运行良好的数据流的部分,加强了深度网络中的隐藏层。我们的主要贡献是表明了强化这些隐藏状态可以提高深度网络的鲁棒性,我们的实验:

•证明了在黑盒和白盒威胁模型中针对标准对抗攻击的鲁棒性有所提高。

•表明了我们的改进并非主要是由于梯度掩码问题引起的。

•显示了在隐藏层而不是输入空间中进行这种强化的优点。

深度神经网络在各种各样的任务中都非常成功。这一成功也推动了其在可靠性和安全性至关重要的领域中的应用,包括自动驾驶汽车(Bojarski等人于2016年提出)、医疗保健、人脸识别(Sharif等人于2017年提出)以及恶意软件检测(LeCun等人于2015提出)。当使用该系统的智能体可以从系统的不佳表现中受益时,就会出现安全问题。当训练期间所看到的输入数据的分布与进行评估模型的分布不同时,就会出现可靠性问题。

对抗样本(Adversarial examples)(Goodfellow等人于2014年提出)是一种攻击神经网络模型的方法。这种攻击对输入应用了一个小的干扰,从而改变预测的类。值得注意的是,这个干扰有可能非常小,以至于肉眼不可见。研究表明,简单的梯度方法可以让人找到经常改变输出类的输入的修改(Szegedy等人于2013年提出; Goodfellow 等人于2014年提出)。最近,更多的研究表明,即使在相机上显示时,创建一个补丁也是可能的,它也会以高度的置信度来改变输出类(Brown等人于2017年提出)。

作为回应,针对对抗样本的防御已经被研发出来。一些最突出的防御类包括特征压缩(Xu等人于2017年提出)、输入的自适应编码(雅各布巴克曼,2018年)和与精炼相关的方法(Papernot等人于2015年提出)。现有的防御系统提供了一定程度的鲁棒性,但大多数都不容易部署。此外,很多已经被证明易受梯度掩码的影响。还有其他一些则需要直接在可视的空间中训练生成模型,即使在相对简单的数据集上,这在当前仍然是很困难的。

我们的目标是提供一种方法:

•可以被广泛地添加到现有网络中。

•使该网络具有鲁棒性以抵御对抗攻击。

•提供一个可靠的信号,表明输入数据的存在,而这些数据并不位于网络所训练的数据流上。

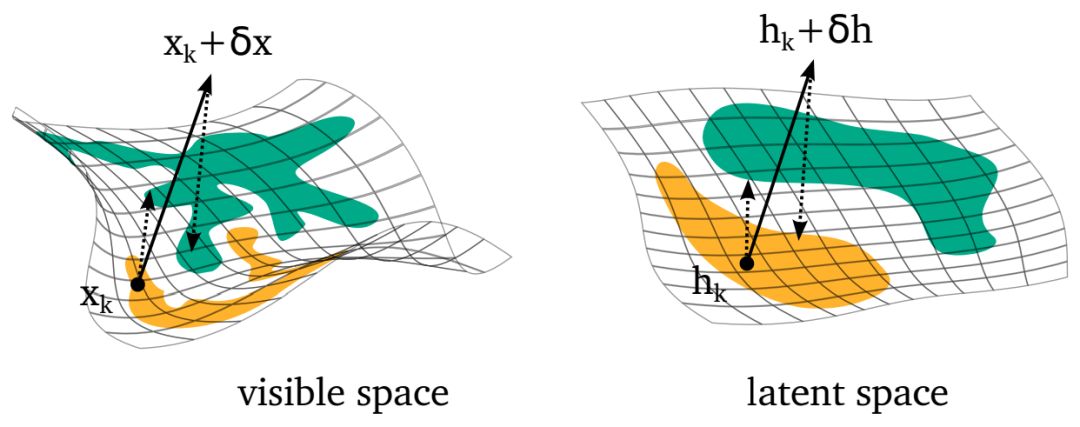

将生成模型的能力直接用于输入数据以提高鲁棒性并不新鲜。我们的主要贡献是,在所学习的隐藏表征的分布上使用了这种鲁棒化,而不是让断开数据流的识别变得更容易(如图1所示)。

图1.输入空间(顶部)和抽象隐藏空间(底部)中,自动编码器动态示意图。最左侧的面板显示来自三个不同类的数据点,中间面板显示描述自动编码器动态的向量场。最右侧面板显示一系列结果轨迹和吸引域。强化网络背后的主要动机是,在具有更简单统计结构的抽象空间中,更容易识别出指向数据流形成的方向,从而更容易将对抗样本映射回投影的数据流形。

我们提出了强化网络。这一强化包括使用去噪自动编码器来“修饰”原始网络的隐藏层。我们在Pythonic的意义上使用“修饰”,它可以用于任何函数(在本例中是网络的一部分),并且在不大幅修改它的情况下扩展它的行为。因此,强化需符合上述三个目标。我们探讨了隐藏层强化背后的直觉,并给出了该方法的一些显著特性。我们在MNIST、Fashion-MNIST和CIFAR10数据集上,针对白盒和黑盒攻击对我们所提出的方法进行了评估。

图2.一个映射回可视空间(左)和隐藏空间(右)的流形过程的示例。阴影区域表示空间中被给定类的数据点所占据的区域(它们不表示决策边界)

可以这样说,防范对抗性样本在关键任务应用程序中至关重要。我们提出了一种强化网络,它是一种能够提高现有的深度神经网络鲁棒性的简单方法。我们的方法具有以下特点:

•实用性:强化现有网络需要在网络的隐藏层之间引入DAE,并且能够实现自动化。我们正在准备一个PyTorch模块,它将真正做到这一点,并将在短期内发布在深度学习社区,以供使用。此外,测试时的DAE重构误差是分布移位的可靠信号,这与训练期间遇到的情况有所不同。高误差可能意味着对抗攻击或显著的域移位,这二者都是分析人员或系统需要注意的重要情况。

•有效性:我们展示的结果完善了MNIST对抗攻击的最新技术水平,同时也改进了在CIFAR和Fashion-MNIST上进行执行的结果。

•局限性:该方法的成本是,由于搜索对抗性样本和训练自动编码器而延长了训练时间。相比于对抗训练,强化层本身的附加成本相对较低,并且比在输入空间中训练一个完整的生成式模型(如GAN)容易得多,也简单得多。层强化通常涉及较小的DAE,所需计算量较小。此外,我们通过只增加两个强化层,对Res Net做了一些改进,因此计算成本的变化非常小。同时,强化网络只有在与对抗训练同时使用时才能提高鲁棒性,这对于迭代攻击而言,是非常昂贵的。

原文链接:https://arxiv.org/pdf/1804.02485.pdf

未来智能实验室是人工智能学家与科学院相关机构联合成立的人工智能,互联网和脑科学交叉研究机构。

未来智能实验室的主要工作包括:建立AI智能系统智商评测体系,开展世界人工智能智商评测;开展互联网(城市)云脑研究计划,构建互联网(城市)云脑技术和企业图谱,为提升企业,行业与城市的智能水平服务。

如果您对实验室的研究感兴趣,欢迎加入未来智能实验室线上平台。扫描以下二维码或点击本文左下角“阅读原文”

:PDF签名机制的漏洞分析)

:PDF的签名值到底存在哪里?)

CLR Via C#》中两个比较有趣的知识点)

![[译]How to make searching faster](http://pic.xiahunao.cn/[译]How to make searching faster)