来源:腾讯AI实验室

语音识别及深度学习领域专家、腾讯AI Lab副主任及西雅图实验室负责人俞栋博士,在2018年腾讯全球合作伙伴大会上展示了腾讯AI正在推进的跨领域前沿研究:下一代的多模态智能人机交互。以下是有补充的演讲全文,介绍了人机交互的历史与目标、下一代智能人机交互的优势与挑战,及腾讯AI的解决方案。

人机交互的未来

就是多模态智能人机交互

人机交互的历史

在计算机的发展历史上,随着技术的进步,发生过几次大的交互模式的演进。最近的两次大家比较熟悉的转变是从以鼠标/键盘为主的交互模式转换为以触摸和语音为主的交互模式。

人类创造计算机的最早目的是帮助自己处理一些繁琐的计算任务,比如弹道计算;那时候,只有经过训练的专业人员才有能力向计算机输入信息和阅读计算机输出的结果。随着硬件和软件技术的发展,计算机的速度越来越快,功能也愈渐强大,人与计算机的交互方式也越来越多样化,并日益向对人类而言更自然更便捷的“以人为中心”的方向发展。实际上,在计算机的发展历史上已发生过几次显著的交互范式演进。

1946 年正式投入使用的世界第一台通用计算机 ENIAC 的输入和输出都在卡带上进行,这种人机交互方式需要对卡带进行加工(打孔或涂绘等),从而为计算机提供二进制程序,因此速度缓慢。60 年代中期,命令行界面出现了,计算机使用者可以通过键盘直接输入程序并在屏幕上获得反馈,各种编程语言也顺势发展。1968 年,Douglas Engelbart 设计的 NLS 系统将鼠标、指针、超文本和多窗口界面整合进了计算机系统中,奠定了我们当今的主流桌面计算机的基于图形界面的形式基础。

人机交互的未来

现在,智能手机的普及已经让人们习惯了基于触摸屏的交互方式,现在几乎所有有人的地方都有“点手机”的身影。在语音识别和自然语言处理技术的推动下,基于语音的交互方式也正在迅猛发展——智能语音助手已经成为了很多智能手机的标配,智能音箱也正在进入越来越多的家庭。此外,基于计算机视觉乃至脑波分析的交互技术也已经出现,比如通过人脸跟踪控制系统或通过检测玩家的表情来个性化地调整视频游戏的难度和剧情等。

交互模式的演进主要还是为了降低交互的困难程度,使更多人能够使用计算和智能设备,也使用户能够方便地使用更多形态和数量的设备。显而易见,每一次交互范式的转变都带来了新的用户群体、新的应用场景、新的商业模式、和新的想象空间。比如触摸方式的普及使很多老年人也会使用智能设备,语音技术的进展则使得我们可以远距离控制设备,极大地增加了可交互设备的数量。但是,新型交互方式并不会在所有场景中都完全替代已有的交互方式;在可预见的未来里,程序命令、图形界面和语音等交互方式都将有各自更为擅长的应用场景,基于智能处理技术的多模态交互将成为人机交互发展的未来。

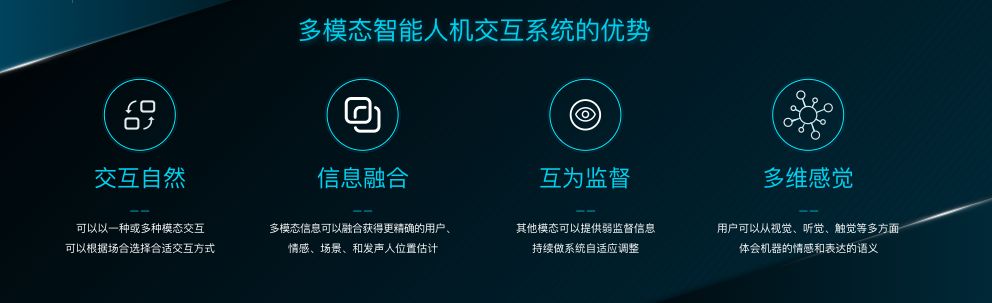

多模态智能人机交互系统的优势

多模态的智能人机交互相比单模态的传统交互方式有几个优点:

优势1: 交互自然

最明显的优点是交互的自然度和自由度,用户可以根据场合以及对不同模态的熟悉度来选择一种或多种方式与设备交互,比如用户可以用手势或语音或者结合手势和语音来表达同一意思。

优势2:信息融合

在很多场景下,单一的信息源往往不足以保证系统的准确率和鲁棒性,比如在高噪音场景下,语音信号会受到很大干扰从而影响语音识别的准确率。然而通过多模态信息的融合,比如同时基于手势、口型或面部表情我们可以获得更精确的语义信息。不但如此,多模态信息融合也可以使系统更准确地辨识用户、情感、场景、和发声人位置,从而降低交互的成本。

优势3:互为监督

不同模态之间可以互相提供关联和监督信息。不同模态之间的关联是语义理解的一个很重要的组成部分,比如当我们提到一个有实体的概念时我们往往会联想到这个实体的形状、声音、运动方式等诸多方面,又比如当我们听到咣当一声时会联想到门被关上了,并且头脑中会出现门的形象。这些都是通过多模态之间的关联学习到的。不同模态之间的关联和监督信息还能够帮助系统在运行过程中持续做自适应学习,比如当系统同时具备麦克风阵列和摄像头阵列时,麦克风和摄像头可以互相提供校准信息。

优势4:多维感觉

这对用户和系统都很重要,因为人在交互过程中,除了语言信息外,还会使用很多副语言信息和非语言信息,例如态度、情感、意图等。这些信息很多是通过面部表情和肢体语言来辅助表达的。多维感觉对用户尤其重要,因为用户可以在多模态交互系统中从视觉、听觉、触觉等多个维度来感知和体会智能设备想要表达的情感和语义。

智能人机交互系统的终极目标

智能人机交互系统的终极目标是使人与机器交互和人与人交互一样轻松自然。我们认为从以人为本的角度来看,理想的系统应该具有几个重要的指标。

目标1:不用学就会

最重要的指标就是不用学就会,如果用户愿意学习一些不熟悉的交互方式,他/她会有更多的选择,但是如果他/她不愿意学的化也能以其最自然的方式比如听觉和视觉与机器交互。

目标2:多模态交互

人与人之间的交互就是多模态的,我们可以用语言、表情和肢体动作等方式传达我们的想法和意图,因为这些方式对人而言是最自然的。基于刚刚提到的多模态交互的优势我们认为这样的系统也应该是多模态的,这里多模态包含输入的多模态和输出的多模态,而由于智能设备可以提供屏幕输出,从输出的效率来说它们甚至可能比人更为优越,这一模态是很多人机交互场景的核心。

目标3:深层次理解

结合场景、世界知识和历史交互信息,再对语义、语用和情感进行深层次理解,能交互自然而有效率。

目标4:拟人式对话

在系统的输出侧,如果系统能够以高逼真度、高自然度、和高清晰度的拟人形象、声音、用词、和表达方式来和用户交互,就能大大减小对用户感知能力的要求。

目标5:个性化交互

最后一个指标是个性化交互,这也是为了使交互更自然。比如当与小孩交互时我们会希望机器的回答匹配孩子的认知水平、智能设备的语调和口吻适合孩子。又比如当与不同人交互时我们会希望智能设备的交互方式和内容是用户所感兴趣的。我们虽然不知道这些指标到什么程度用户会觉得足够好,但我们知道如果智能设备可以生成对话和形象使之表现得和与用户进行视频通话的朋友一样自然, 那智能人机交互系统的终极目标就达到了。

智能交互系统距离期望目标尚远

在下一代智能交互的道路上,我们已经有了一些进展,但离我们的目标还有不少的距离。比如,虽然用户可以用语音和系统交互,但是用户往往需要适应机器,需要学习如何和系统交互以及系统能理解什么。在多模态交互方面,各模态往往互相独立或只有单一模态,没有充分发挥多模态能提供的能力和体验。对语义、情感、和场景的理解也还远远不到位,往往只有在非常特定的垂类上有一定的理解能力,超出这些垂类系统就表现得非常弱智。机器在交互过程中脸部表情和声音还不自然,并且有时会出现前言不搭后语的情况,更不用说通过不同的语调,借助不同的语气词,使用不同的回答方式,并结合丰富的面部表情和肢体语言来和用户交互。系统对用户也没有或只有简单的辨识和建模,对答没有统一风格也缺少个性化特色。

多模态智能交互系统的挑战与实现路径

我们可以看到,人机是一个高度协同的系统,为了降低对人的要求和限制,我们必须通过技术手段提升机器的能力。这里是一个高度简化的多模态交互系统,我们只列了语音和视觉两个模态的输入和输出。不过,这已经足以让我们看到系统的主要能力和信息流。在目前的系统中,这个框架图中的每一个模块都还不完善,都需要很多的前沿研究和细致的工程实现。要实现人机智能交互的终极目标我们面对的挑战还很多。这里我列举其中的四个挑战和我们正在研究的解决方案。

挑战一:复杂场景下语音唤醒和识别

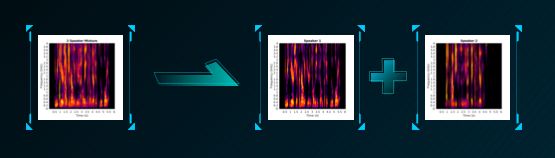

在多模态交互系统中,语音作为对人来说最自然和最常用的交互手段是不可或缺的。虽然语音识别技术经过这些年的研究已经能在近场识别中达到或超过实用的门槛,但在很多真实远场场景下性能还远远不够,而远距交互是语音优于其他交互方式比如键盘和触摸的关键点。这里主要的挑战来自于重口音和鸡尾酒会这样的场景。为了在这些复杂场景下提升系统的识别率,我们的解决方案需要结合声源和人脸信息来辨识说话人及其方向,使用多通道语音来分离和跟踪特定说话人的语音,并利用该说话人信息做识别自适应。目前的交互系统中有一个很大的痛点是用户需要经常使用唤醒词来唤醒系统,这使交互过程不够自然,效率不高。我们认为结合语义、目光交流、和视觉场景分析是减少交互中唤醒词使用次数的重要方向。

挑战二:对话、场景、和情感理解

理解能力,这不仅包含自然语言的理解还包含场景和情感层面的理解。自然语言理解被广泛地认为是目前系统里最薄弱的一个环节,这是因为语言是用来刻画和描述世界并传递信息的,所以要理解一个语句所对应的实体或概念,我们往往需要了解这个实体或概念相对应的视觉、听觉、触觉体验以及和它相关的其他概念。而且,为了提升语言交互的效率人们往往假设许多背景信息交互的双方是已知的,不需要在对话中提及或传输。

这些都表明要提升理解能力很重要的一点,就是构建一个关于世界的模型,这个模型可能不止包含语言表达的知识还包括与概念相关的其他模态信息。这也表明为了使系统更有效率地和用户交互需要建立用户模型,用以描述用户的个性、习惯、爱好、对话历史,以及用户所了解的世界,有了用户模型,系统就可以针对性地进行个性化交互,也可以比较容易地理解和用户相关的语言。另外,为了提升对对话场景和情感的理解,我们可以同时利用声音和视觉信息来判别场景和情感。

挑战三:智能对话管理

对话需要逻辑上一致、语义上连贯。与人与人交互类似,人机交互也有不同的目的,并且多种目的的交互方式往往会在同一个对话段里出现,对话系统需要能灵活处理不同类型的对话而且需要因人而异。

一个可行的实现方式是将任务型、问答型、和闲聊型对话分解成可复用的更小的数量巨大的微技能,并通过统一的多层次对话管理模块整合在一起。对话管理模块需要能支持用户主导和系统主导的对话,能在两者之间自由切换,并对不同个性的用户使用不同的对话策略。

挑战四:高逼真度多模态对话回复

这是为了使用户能够和与人交互那样自然地得到信息反馈。在视频展示方面,我们的做法是逐步实现低成本、高可定制化、可控人脸实时动态三维建模和高真实度纹理生成和渲染。这里是我们和腾讯NEXT Studio团队合作的Siren虚拟人,可以看到我们在高逼真度智能控制语音和人脸方面的一些进展。在对话回答的生成方面,我们从数据中总结出各种表达语义信息的模板,并利用它们作为基本回复方式结合用户模型和对话状态生成最后的回答,并和视频同步合成具有情感的表情和声音。

Siren虚拟人

这样的虚拟人已经具备了一些基础的功能,包括多模态的输入、语音闲聊、简单的行政功能等,但是,完全达到智能人机交互的终极目标还有很长的路要走。

多模态智能人机交互系统赋能应用场景

然而,在我们逼近这一目标的过程中,就可以逐渐赋能一系列应用场景,比如在办公场景下的虚拟秘书、家庭里的陪伴机器宠物、游戏里的虚拟玩家、车载虚拟助手、和社交里的千人千面的交互bot。

多模态智能人机交互系统赋能应用场景

比如,对于青年人来说,开车途中可以通过和虚拟助手通话来控制汽车中控系统和智能设备,而虚拟助手还可以通过语音和视觉信息来判断驾驶员的疲劳程度和情感状态,降低驾驶风险。工作中,虚拟秘书可以帮助处理高重复性、高标准化工作,让你专注在核心问题上。下班后,虚拟社交使你能够打破时间、空间、想象力的界限,兼顾娱乐性、隐私性,创造更大的世界。

多模态智能人机交互系统服务不同场景下的不同人群——青年

再比如,对于儿童来说,虚拟教师可以随时随地根据儿童的现状和特点做针对性教学,学生可以通过AR/VR来认识世界并通过和虚拟世界中虚拟人物的交互而快速掌握知识。虚拟妈妈可以代替真实的妈妈陪伴儿童,给儿童讲故事,陪儿童玩游戏,指导儿童做作业。

多模态智能人机交互系统服务不同场景下的不同人群——儿童

随着智能技术的进一步发展,计算机对多模态数据的理解和整合能力也将越来越强,人机交互也将变得更加自然便捷。可以预见,未来的智能机器不仅能听懂和理解我们的话语,通过我们微妙的肢体语言洞悉我们的情绪,也许甚至还能基于充分的数据在我们表达出自己的想法之前就预测到我们的意图。

此外,未来的智能机器也许根据需求精确地呈现视觉形象,甚至借助味觉、嗅觉和触觉等方式与人类进行更丰富的交互。正如某些科幻中描述的那样,随着多模态智能人机交互的演进,未来某天我们也许真的能够创造出那种无论是外观还是行为都与人类别无二致的智能机器。我们非常看好多模态智能交互的未来。