1.1 准备

通过gedit编辑器修改比较方便,因此需先安装gedit。

sudo apt-get install gedit

1.2 修改配置文件core-site.xml和hdfs-site.xml(如下注释部分需要删除)

- gedit打开core-site.xml

$ gedit ./etc/hadoop/core-site.xml

<configuration>#在该语句对中添加如下语句,单机模式删除该语句对中的所有语句。<property><name>hadoop.tmp.dir</name> #用于存储hadoop运行过程中的临时文件的目录<value>file:/usr/local/hadoop/tmp</value>#指定目为/usr/local/hadoop/tmp,若不设置,Hadoop关闭后,系统默认设置的目录会被情况,下次在开启hadoop时,又需要运行hadoop format初始化,才能正常使用。<description>Abase for other temporary directories.</description></property><property><name>fs.defaultFS</name> #设置fs.dfaultFS对应的值<value>hdfs://localhost:9000</value>#设置整个hdfs路径的逻辑名称为hdfs://localhost:9000</property>

</configuration>

- gedit打开hdfs-site.xml

$ gedit ./etc/hadoop/hdfs-site.xml

<configuration>#在该语句对中添加如下语句,单机模式删除该语句对中的所有语句。<property><name>dfs.replication</name>#表示副本的数量<value>1</value> #伪分布式其实只有一台机器,可以设置副本数量为1</property><property><name>dfs.namenode.name.dir</name>#表示本地磁盘目录,是存储fsimage文件的地方<value>file:/usr/local/hadoop/tmp/dfs/name</value>#设置其值</property><property><name>dfs.datanode.data.dir</name>#表示本地磁盘目录,HDFS数据存放block的地方<value>file:/usr/local/hadoop/tmp/dfs/data</value>#设置其对应的值</property>

</configuration>

设置完后保存。

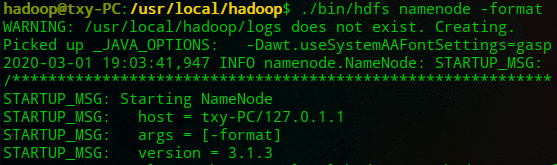

1.3 配置完成后,执行NameNode的格式化

$ cd /usr/local/hadoop

$ ./bin/hdfs namenode -format

输出如下信息则成功。

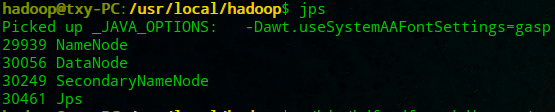

1.4 开启NameNode和DataNode守护进程。

$ cd /usr/local/hadoop

$ ./sbin/start-dfs.sh

1.5 通过jps来判断是否成功启动,出现NameNode、DataNode、SecondaryName(若没有这个,则再次尝试启动)则成功。

1.6 单机模式读取的是本地数据,伪分布式读取的是HDFS上的数据。要使用HDFS,则需要在HDFS中创建用户目录。

$ ./bin/hdfs dfs -mkdir -p /user/hadoop

1.7 三种shell命令方式介绍

- hadoop fs:适用于任何不同的文件系统,如本地文件系统和HDFS文件系统。

- hadoop dfs:只适用于HDFS文件系统。

- hdfs dfs:只适用于HDFS文件系统。

1.8 使用

- 将./etc/hadoop中的.xml文件作为输入,复制到分布式文件系统中的/user/hadoop/input中。

- 执行如下命令创建文件夹和复制文件

$ ./bin/hdfs dfs -mkdir input

$ ./bin/hdfs dfs -put ./etc/hadoop/*.xml input

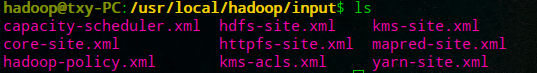

- 查看复制的文件目录

$ ./bin/hdfs dfs -ls input

1.9 伪分布式运行MapReduce作业与单机模式相同,伪分布式读取的HDFS中的文件。

$ ./bin/hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-*.jar grep input output 'dfs[a-z.]+'

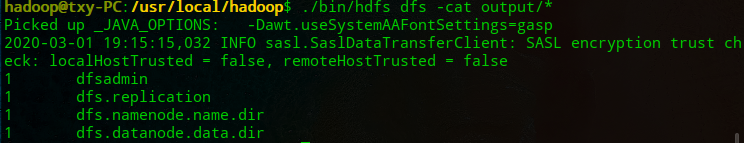

1.10 查看输出文件,每次运行上述输出语句,需要删除output输出文件夹。

$ ./bin/hdfs dfs -cat output/*

1.11 hadoop的关闭与启动:下次启动无需运行NameNode初始化。

$ ./sbin/stop-dfs.sh

$ ./sbin/start-dfs.sh

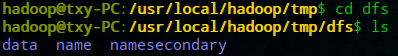

1.12 hadoop命令目录:

- hadoop所在目录为/usr/local/hadoop

- hadoop命令在sbin文件夹中。

- HDFS文件数据目录:/tmp/dfs/

- input 输入文件目录

1.1.3 hadoop的访问:hadoop3.x版本的默认端口问9870,即通过localhost:9870可以访问启动的hadoop。

1.14 可能的错误

-

若1.3 运行后出错Error: JAVA_HOME is not set and could not be found. 那么请保证JAVA_HOME配置正确。若还出错,则:

转到hadoop的安装目录,修改配置文件“/usr/local/hadoop/etc/hadoop/hadoop-env.sh”中的“export JAVA_HOME=${JAVA_HOME}”为Java安装路径的具体地址,如“export JAVA_HOME=/usr/lib/jvm/default-java”。 -

启动hadoop识,若出现类似“ssh: Could not resolve hostname xxx”的错误。

这不是SSH的问题,可以通过Hadoop配置来解决。

先ctrl+c中断启动,然后在~./bashrc中添加如下语句

export HADOOP_HOME=/usr/local/hadoop#hadoop的安装目录

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

保存执行命令使配置生效。

source ~/.bashrc

在执行启动命令。

$ ./sbin/start-dfs.sh

-

Hadoop 运行程序时,输出目录不能存在,否则会提示错误 “org.apache.hadoop.mapred.FileAlreadyExistsException: Output directory hdfs://localhost:9000/user/hadoop/output already exists” ,需要删除output文件夹。

-

可以通过命令设置,可以运行是自动删除output目录,避免复杂的其他操作。

Configuration conf = new Configuration();

Job job = new Job(conf);/* 删除输出目录 */

Path outputPath = new Path(args[1]);

outputPath.getFileSystem(conf).delete(outputPath, true);

源文档

http://dblab.xmu.edu.cn/blog/2441-2/#more-2441

-数据链路层设备)

-以太网)

-IEEE802.11无线局域网)

-广域网-PPP协议和HDLC协议)

——适配器模式)