论文笔记整理:谭亦鸣,东南大学博士。

来源:TACL 2020

链接:

https://arxiv.org/ftp/arxiv/papers/2003/2003.01343.pdf

1.背景介绍

跨语言实体链接(Cross-lingual Entity Linking, XEL)旨在利用源语言文本中实体描述(提及),从目标语言的知识库中获取对应的参照实体,其解决方法一般分为两个步骤:1.候选生成;2.实体挑选。这一任务在富资源场景下(如Wikipeida)取得了不错的研究成果,但是并没有很好的扩展到低资源语言上(Low-resource Language, LRL)。虽然近期利用迁移学习的工作通过利用相关语言资源能够一定程度上缓解LRL对资源的需求,但是其实验性能依旧远逊于富资源的XEL模型。

其中一个主要原因是,跨语言的实体链接无法像单语那样使用序列匹配的方式解决候选生成问题,虽然Wikipedia提供了inter language links这样的多语言实体对齐资源,具有一定可扩展的潜力,但是现阶段的工作依然表现不佳。也有一些工作提出利用翻译模型生成LRL的英文实体,或者基于实体词典训练跨语言的序列匹配模型。然而这些方法在Top-30的候选实体上依然远不如富资源,且有落后达70%的候选召回率。

动机

作者对现有的SOAT候选生成模型Rijhwani et al. (2019)进行错误分析,发现两个普遍存在的错误原因:1.知识库与文本中实体名(提及)的误匹配;2.字符串匹配模型本身的失误。

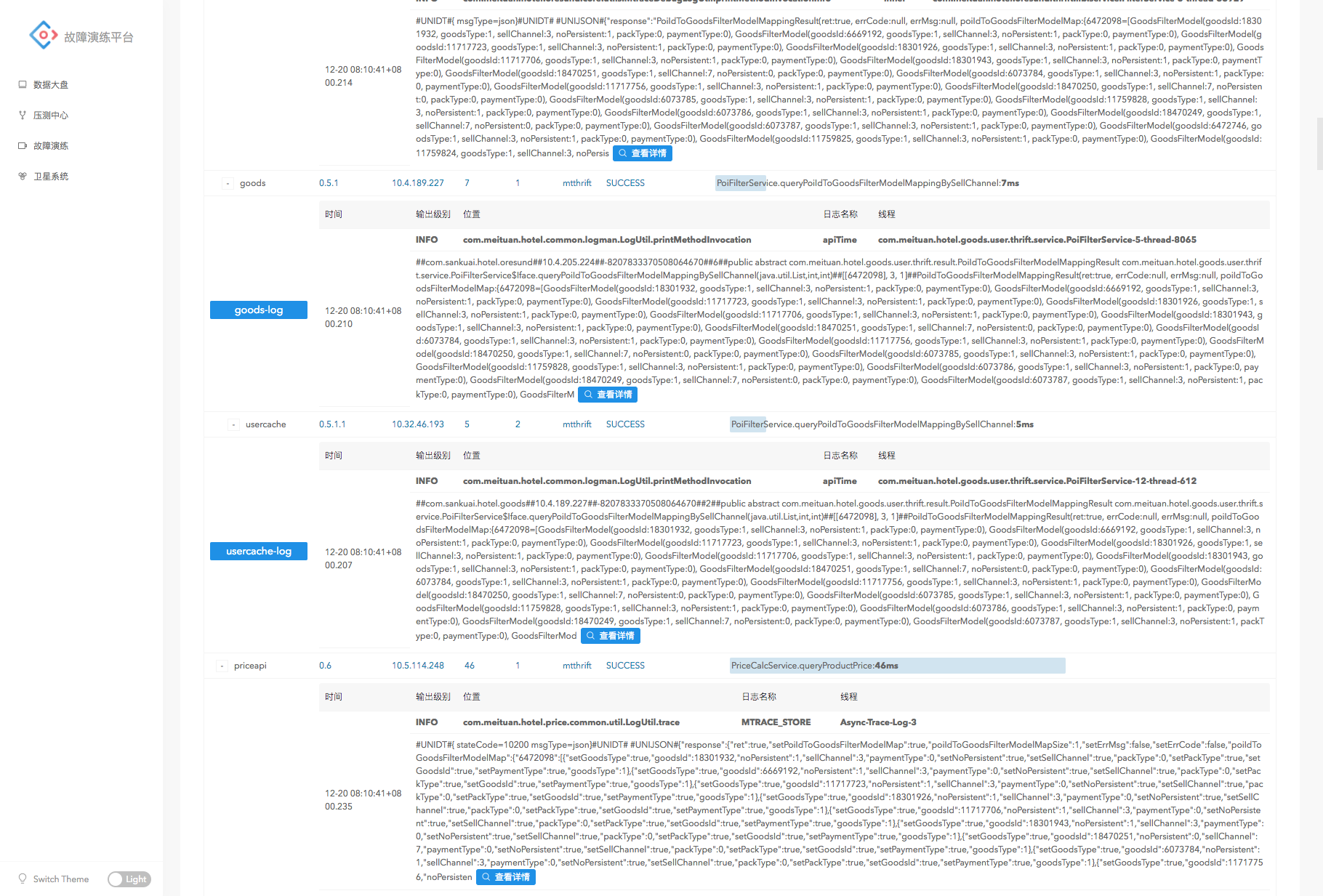

如图1所示,这是一个Marathi语言到英语知识库的链接实示例(一种来自印度西部地区的小语种)。在这个例子中,第一类错误表现为英语实体Cobie Smulders被匹配到文本中的Smulders(绿色部分)或者Jacoba Francisca Maria Smulders(黄色部分);第二类错误则是类似蓝色例子中的Cobie Smulder被序列匹配到Cobie Sikkens上。

为了解决这两类问题,作者提出如下改进:

对于误匹配问题,作者注意到learning-based方法中,包括(Pan et al., 2017; Rijhwani et al., 2019)等工作的候选生成模型训练数据集是由“实体-实体”组构成,这就使得模型无法捕捉文本中可能存在提及的多样性。因此,作者将“提及-实体”组也添加到训练数据中,从而提供更明确的监督。此外,注意到许多源语言资源(variation)与其英文表示存在的相似性,因此也可以使用英文语言资源去获取它们。因此作者从英文Wikipedia中收集了实体的别名资源,并允许模型在生成候选的时候查询这些别名。

本文的第二个贡献是改进了对提及以及实体字符串的表示策略。作者首先假定Rijhwani et. al 2019的LSTM模型可能存在的部分问题,即未能对字符串中所有的单词进行适当的表示学习,这可能是因为该模型不是很适合在LRL上进行学习。在这里,作者提出改用基于字符n-gram的embedding方法替代LSTM。

2.模型/方法

首先对现有模型的不足进行实验分析,以印证本文猜测。

2.1提及类型与分析

作者使用HRL(富资源语言,这里使用的是Amharic, Hindi和Thai等语言)-EN的实体组作为训练数据集(数据集信息实验部分会做说明),训练了一个Pivoting-based Entity Linking(PBEL)模型用于生成LRL文本中抽取出的实体提及所对应的候选实体。在LRL方面使用了Tigrinya, Oromo, Marathi以及Lao等四种语言。

作者从每个LRL随机抽取100个系统输出,并在性能分析时对它们的提及创建类型,并做人工标注,主要包含以下类型:

DIRECT:直接音译

ALIAS:别名(与KB中的完全不同);

TRANS:字对字翻译;

EXTRA_SRC:在提及中至少多了一个(非专有名词)单词;

EXTRA_ENG:在英文实体中至少多了一个(非专有名词)单词;

BAD_SPAN:提及范围不是一个实体(实体抽取部分出错);

对于每个候选实体样本,作者考虑了三种场景:Top-1(目标实体是Top-1候选);Top-2~30;不属于Top-30。图2描述了这组场景和样本的分布情况,可以看到Top-30完全无法覆盖目标实体的三类提及是:ALIAS,EXTRA_SRC,EXTRA_ENG。

2.2模型改进

首先作者在保持“实体-实体”组训练集的基础上,收集了“提及-实体”组,用于扩充训练数据。其次,通过利用Wikipeida中的“alsoknown as”获取到英语实体的别名列表,用于扩充可产生候选实体的匹配范围(公式1)。

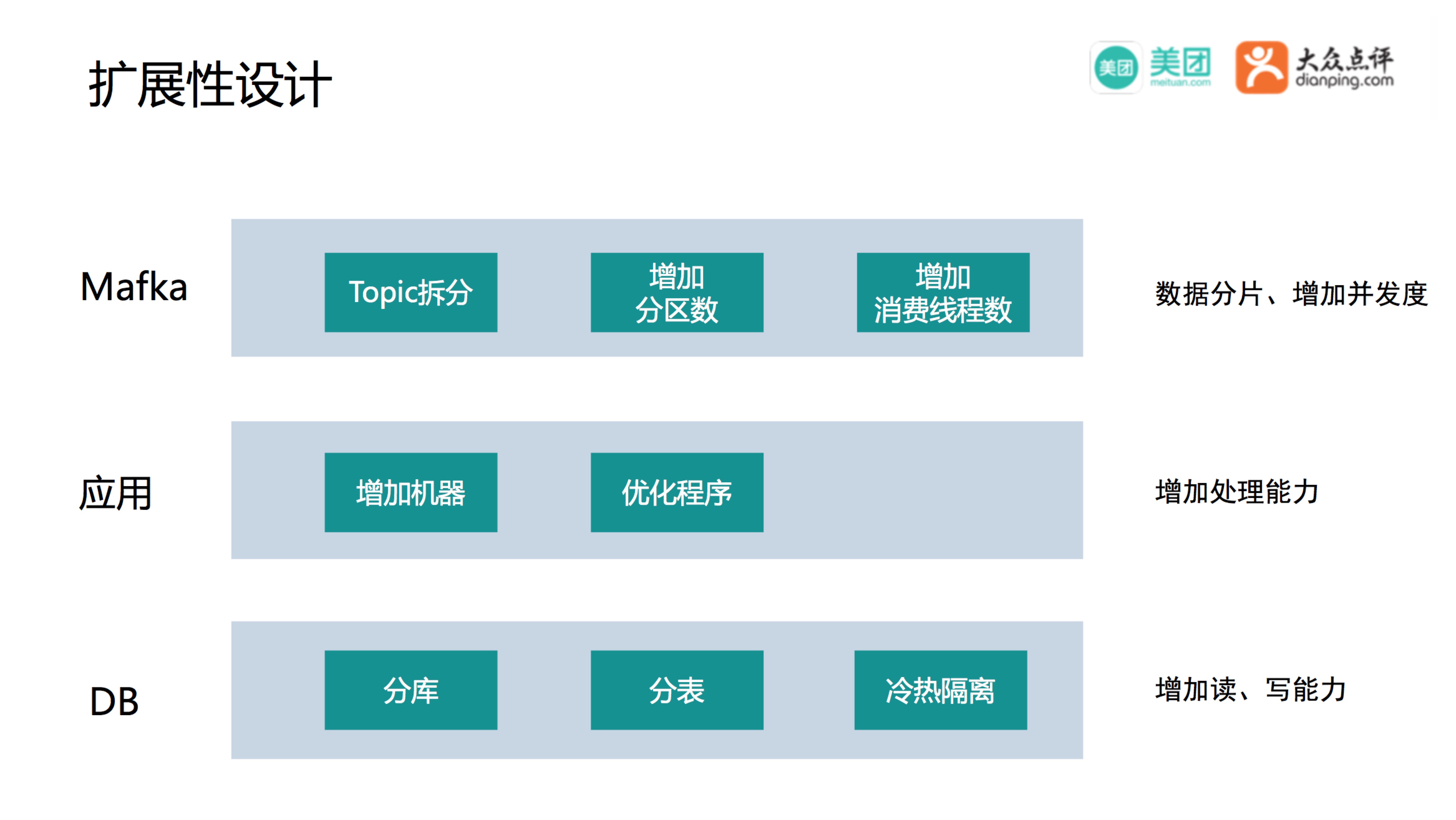

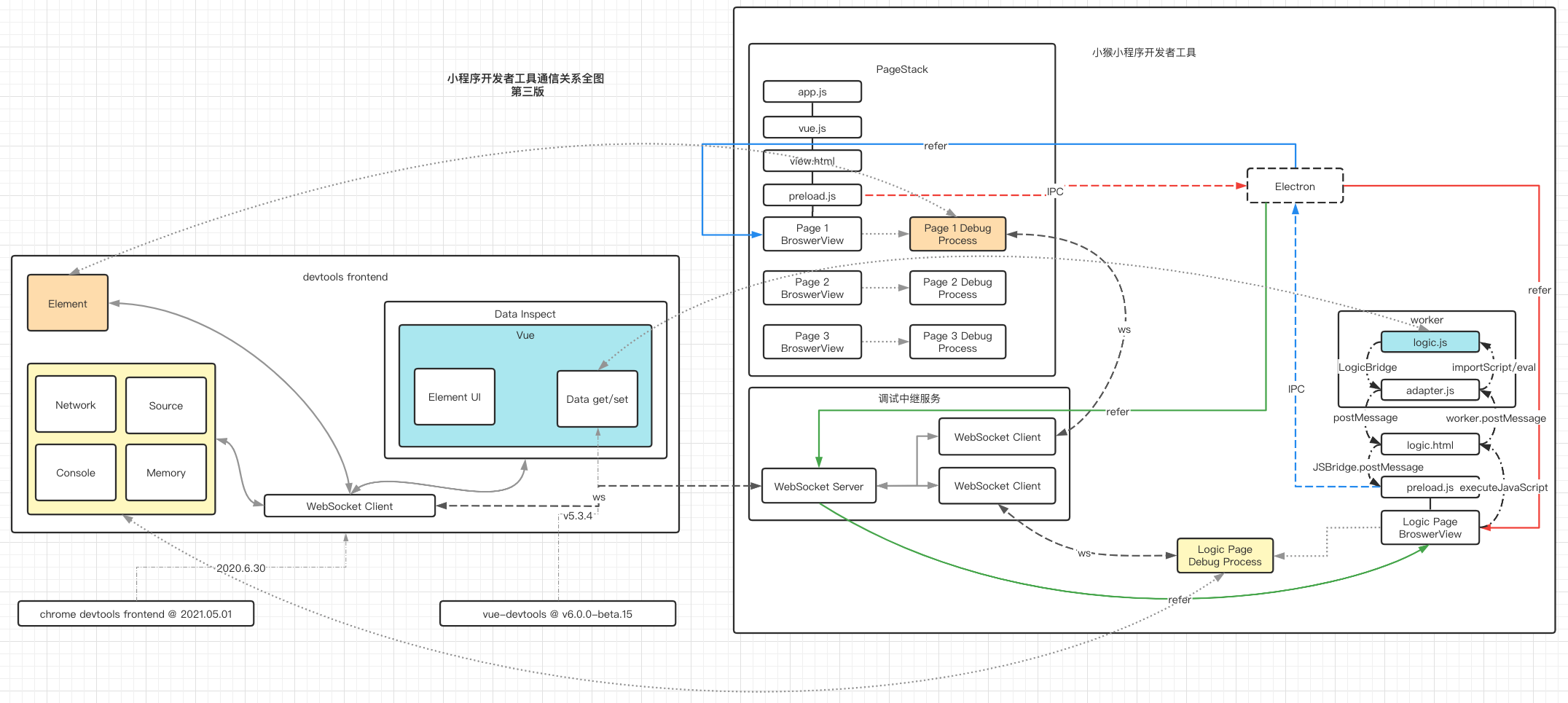

之后,作者使用CHARAGRAM,替换Bi-LSTM作为字符串的编码模型,其结构如图3所示:

字符串的编码过程如下:

其中,N是预设的滑动窗口尺寸,V是训练数据集中所有出现的n-gram的集合,如果n-gram是未出现在V中的,那么将会直接音译。

3.实验

数据

DARPA-LRL:来自新闻,博客和社交媒体,包含Tigrinya (ti), Oromo (om), Kinyarwanda (rw), Marathi (mr), Sinhala (si)以及Lao (lo)等小语种语言。

WIKI:Wikipedia中的子数据集(Pan et al., 2017; Rijhwani et al., 2019)

各语言的表示方式见表2。

结果

作者给出了各模型上Top-30候选的召回率作为评价标准,如表3所示:

并再一次做了错误分析,对比可以看到,新的方法在各提及类型上都产生了一定的效果:

OpenKG

开放知识图谱(简称 OpenKG)旨在促进中文知识图谱数据的开放与互联,促进知识图谱和语义技术的普及和广泛应用。

点击阅读原文,进入 OpenKG 网站。