文 | Chaos

编 | 小戏

不知你是否有过这样的体验,当你周围有人在大声讲电话时,你会不自觉的感觉到烦躁。为什么呢?有一种委婉的说法是因为你听到了不完整的对话。直白点说其实就是讲电话的人通过放大声音强行让你接收了他说的信息,但你又无法接受到电话那边的人所回复的信息,因此对这个讲电话的人,你也可能不知所云,心情自然变得烦躁。

正如我们以前在做阅读理解时经常碰到的问题“请结合上下文谈谈此处作者想要表达的思想感情” 一样,很多的自然语言处理的问题——诸如问答,对话,文本摘要等——都需要在一个丰富的文本环境下去预测某个单句的意思。

近期 Google 的大佬们就对这一问题进行了深入细致的研究,他们提出句子的 Decontextualization (去情境化,注意这里不是 Bert ,并不是一个新的模型名,就是一个名词),目的是让句子都能表述自己的 Truth-Conditional Meaning (真值条件义)。

论文题目:

Decontextualization: Making Sentences Stand-Alone

论文链接:

https://arxiv.org/pdf/2102.05169.pdf

定义

定义

Definition 1 (Decontextualization)

Given a sentence-context pair , a sentence is a valid decontextualization of s if:

(1) the sentence is interpretable in the empty context; and (2) the truth-conditional meaning of in the empty context is the same as the truth-conditional meaning of in content

这里涉及到的是一个句子文本对,其中是将被去情境化的句子,是包含句子的文本,那么作为的有效去情境化句子必须满足:(1)在没有上下文的情况下是可以被理解的;(2)句子所表达的真值条件义和在文本里的句子所表达的真值条件义是一致的。举个例子吧,如下图:

如果不结合上下文单看paragraph里灰色背景的句子,你就不知道是哪个队在什么比赛上的最好成绩是2018年决赛2-4输给了法国队。但是如果你看 Decontextualized Sentence,你就可以不再需要上下文,而直接明白文本里的灰色句子的意思,这个就是作者定义的去情境化。

那这个" Truth-Conditional Meaning " 又是什么呢?作者专门强调并且引用了一系列语义学理论。笔者并未深究,感觉就是"话语显义",也就是字面意思,不涉及含义以及引申义。还是引用上面的例子,换个语境如下图:

这里 Jon 说的话和之前文本里的句子一模一样,所以 Decontextualized Sentence 也可以沿用之前的句子,但是实际上语境里 Susan 问的是 Croatia 是否拿过冠军, Jon 的回答从表面上看并不直接,但却间接包含了 Croatia 并未夺冠的含义,这个含义在去情境化的句子里也没有直接表达。

这也就是在 Decontextualiation 过程中只要求字面意思一样,并不涉及含义,于是便出现了在两种不同语境里的同一句话实际上 Decontextualized 之后是一样的,这是不是真就是"去情境化"呢?无论你是在哪里"飙车",反正超速就得扣驾照分。

通过对" Truth-Conditional Meaning "的考究,我们确实可以看出 Google 大佬们工作真是细致,确实对现阶段的 NLP 模型来说,能理解话语显义感觉就很不错了,要是不久的将来, NLP 模型能理解你说的"内涵",那可真就厉害了。扯远了...拉回来,如图1所示,像" thus far "这样的额外的语境,在去情境化的过程中是不需要处理的。

任务

任务

训练语言模型完成这样一个去情境化的任务其实是一个有监督的学习任务,既然是有监督的学习,就离不开"打标"。一个注释者——即打标的人,需要对一份包含目标句子(首尾用,和标注)的完整文本进行打标。

首先他需要判断这个句子是否可以去情境化,即标注 FEASIBLE 或者 INFEASIBLE, 如果例子被标 FEASIBLE ,那么注释者需要提供满足 Definition 1 的去情境化后的句子。

被标 FEASIBLE 的句子指的是那些不需要或者只需稍微编辑就能去情境化的句子,而那被标 INFEASIBLE 的句子就是很难被去情境化的句子,比方说:

笔者碰巧学过物理,这句去情境化后应该是“金属的相变潜热与热容之比要比水高出许多,这个比值通常在400到1200之间”,但是这个过于专业就算去情境化后也很难被人理解,所以便被标注 INFEASIBLE ,此外还有一些叙述性比较强或者过于依赖上下文的句子也很难被去情境化。

对于被标注为 FEASIBLE 的句子,编辑的方式也是有套路的,通常可以分为4大类:

(1) Name Completion , Pronoun / NP Swap 名称补全和代词转换。

(2) DM Removal 包括对一些语篇标记( Discourse Markers )词的删除,比方说( therefore )。

(3) Bridging , Global scoping 包括加一些短语(通常是介词短语)来对某些名词词组或者是整个句子进行补充说明。

(4) Addition 通常是加入一些背景元素增强可读性。

示例如下:

数据与模型

数据与模型

数据使用的是英文维基百科,采用人工打标的方式,注释者都是美国本土的 English speaker 。总共28个注释者,其中11个注释者注释了超过1K个 examples (有必要说的这么详细吗?额, Google 大佬,有必要,为了保持样本的一致性,那为什么不让1个人注释?嘿嘿,你想累死那位老哥...) 。

数据统计如下:

仔细看一下数据统计,你就会发现其实绝大部分的 examples 都是那11位注释者注释的(所以说是一致性嘛),这个里面文本长度( par.len )和句子长度( sent.len )都是用字节( bytes )计算的,其中训练集只有一个 Reference ,验证和测试集有5个 Reference ,另外 Expert 那一行的样本是作者们自己注释的。

作者提供了两套模型用来进行自动去情境化,一个是指代消解模型,还有一个是 Seq2seq 模型,数据的输入形式如下:

其中是分隔符,是维基百科的页标题,是该段文本的小标题,是文本里的句子,是目标句子。

指代消解模型使用的是开源的 SpanBert-Large (保持原始的超参数),对输入的 Sequence 采用这个模型,将所有和目标句子存在指代关系的部分都筛选出来,然后选择其中在文本里最靠前的和目标句有指代关系的实体进行替换,平均下来有36.5%的 examples 是通过这种方式改进的。

Seq2seq 模型采用的是 T5 模型,两个变种,一个是 Base 版本一个是11B,主要区别在模型容量上。

这里训练时将 Target Sequence 设置为 ,其中

当 时 是去情境化后的句子,当时,是文本原句。

结果与评估

结果与评估

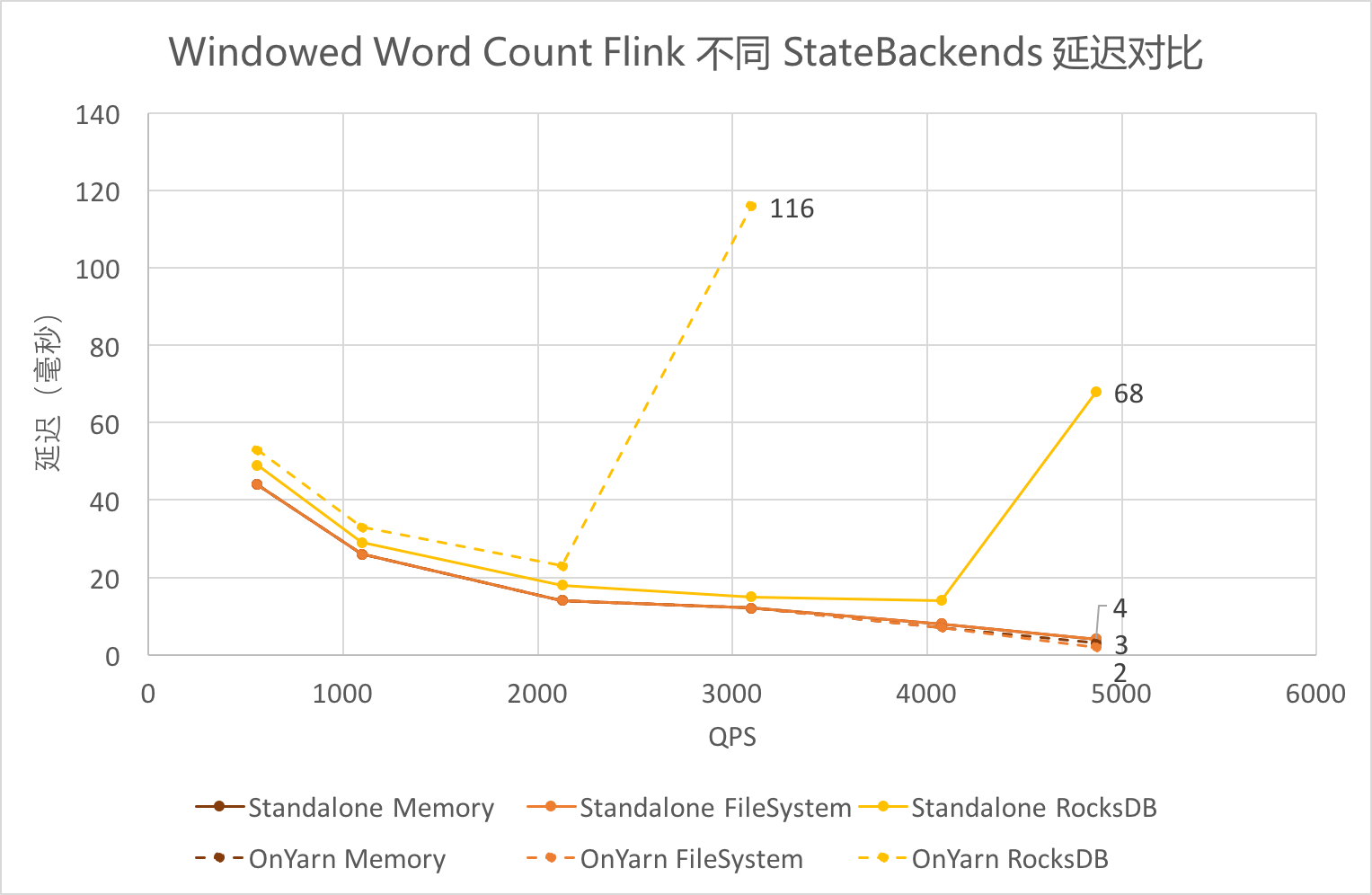

对于去情境化的可行性检测,也就是判断 FEASIBLE 和 INFEASIBLE 的一个二分类问题, T5 预测 FEASIBLE 达到了88%的准确率, T5-11B 达到了89%的准确率,都优于人的判断(85%的准确率),再次说明预训练语言模型在分类问题上的良好表现。另外指代消解模型并不能判断可行性。

对于去情境化句子生成结果,作者给了4种评估方法:(1) Length Increase :长度增量为;

(2) % edited:在去情境化的过程中,修改部分所占得比例;

(3) Sentence match:句子匹配程度, 描述模型预测结果和 Reference 之间的相似性;

(4) SARI(System Output Against References And Against The Input Sentence):这里主要是将模型预测结果和 Reference 一起和输入原句进行对比,采用一元模型,对每个 Reference ,可以算它的 Add Edits,也就是在 Reference 里而不在原句里的部分,同理也可以计算 Delete edits ,以这个为标准,计算模型输出在 Add/Delete Edits 上相对于 Reference 的准确率/召回率/F1值,作者主要以 SARI 作为模型的评估标准。

评估结果如下:

可以看出 T-5 模型在各项指标上明显优于指代消解模型,其中容量更大的 11B Model 表现更好 而且在 Sentencematch 上更是超过了 Human ,不过 Human 在更具代表性的 SARI 值上表现是最好的

作者还做了人工评估,也就是将模型输出与注释者注释的句子放在一块让专家评估。主要有两个指标,一是语句的流畅程度,二是是否正确的去情境化了。评估结果模型预测在流畅程度上得分88%,在正确性上得分67.5%,Human Reference 在流畅程度上得分84.5%,在准确性上得分 78.5%。

另外作者还做了一个喜好测试,即让两位专家选择是更喜欢模型的输出还是注释者的注释,也可以两者都不选。结果如下:

行与列分别代表两位专家,结果还是比较一致的,两位专家还是更喜欢注释者的句子,不过对于一些 Samples 专家也会选择T5模型的输出。

总结

总结

论文作者定义了何为句子的去情境化,构建了一个用于此任务的数据集,而且还给出了一个去情境化相对效果还不错的模型( T5-11B )。

总的来说,对于一个相对较新的NLP任务,作者们在任务的确立,数据集的构建,模型的筛选,甚者到最后的应用与推广等方方面面都做了细致的工作,确实给众多NLPer树立了一个良好的榜样!

寻求报道、约稿、文案投放:

添加微信xixiaoyao-1,备注“商务合作”

后台回复关键词【入群】

加入卖萌屋NLP/IR/Rec与求职讨论群

后台回复关键词【顶会】

获取ACL、CIKM等各大顶会论文集!