笔记整理 | 谭亦鸣,东南大学博士生

来源:COLING 2020

链接:https://www.aclweb.org/anthology/2020.coling-main.520.pdf

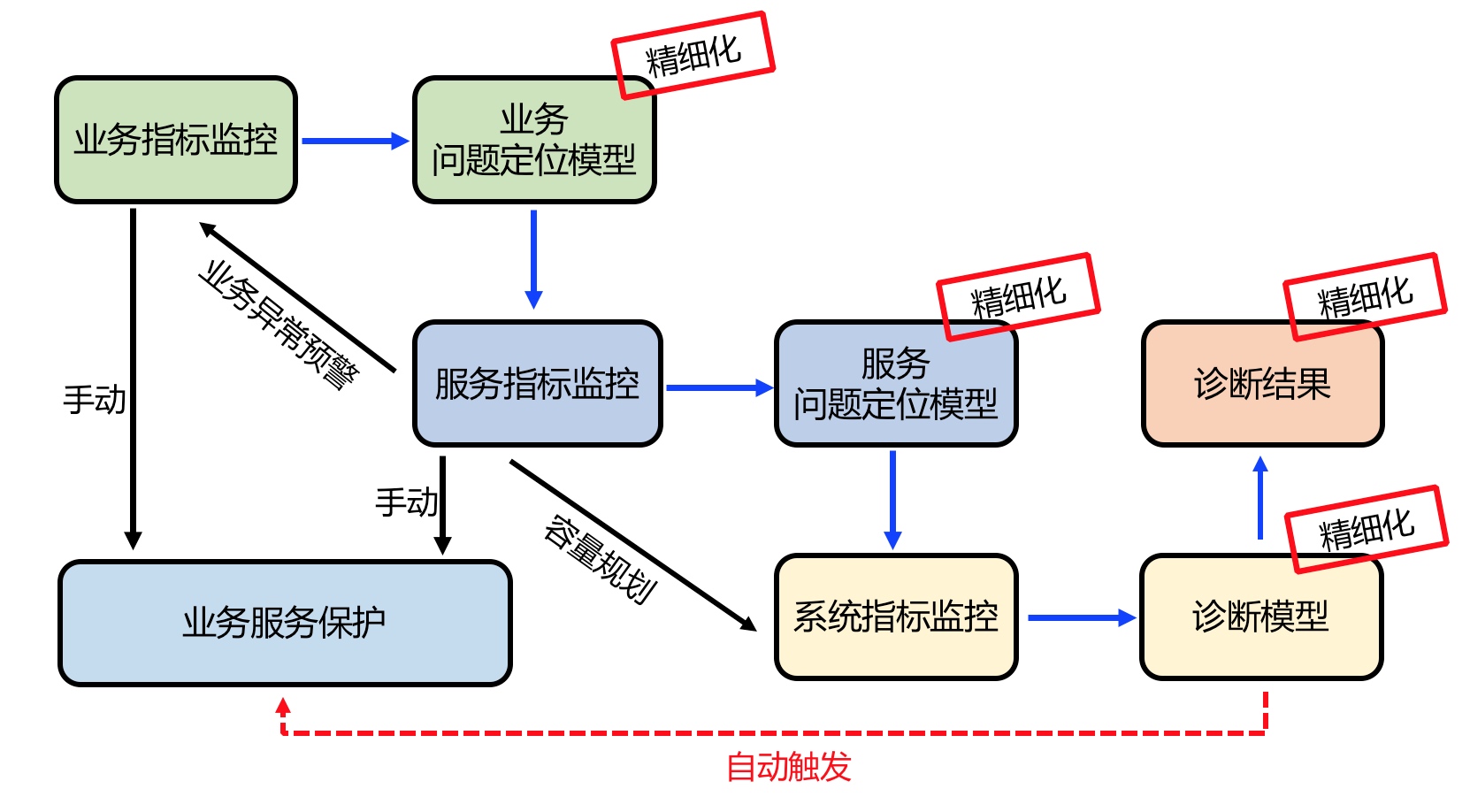

本文发现,目前基于GCN的对齐方法都是分别考虑两个KG,然后分别学习它们的embedding,并认为这种做法忽视了KG预对齐链接的使用。因此,作者提出了一种新的上下文对齐强化跨图谱注意力网络(Contextual Alignment Enhanced Cross Graph Attention Network, CAECGAT),用于跨语言实体对齐任务。该模型能够利用来自预对齐种子的跨图谱信息联合学习不同图谱的embedding。论文在三个benchmark实体链接数据集上做了充分的实验,论证了该方法性能上的优势。

方法

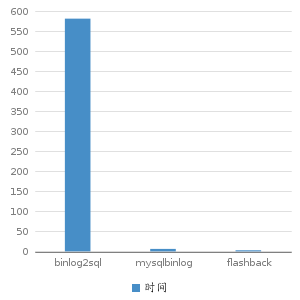

图1(a) 描述了使用预对齐实体的上下文信息,能够为对齐构建提供更加充分的证据。

例如:中文图谱中的“哥威迅语“是的译文可以匹配上英文图谱中的”Gothic language“,但是事实上正确的英文实体对齐是”Gwich’ in language“,利用预对齐的上下文信息则可清晰判断出这种情况。

图1(b) 则描述了考虑预对齐上下文的模型与常规GCN-based模型之间的区别。

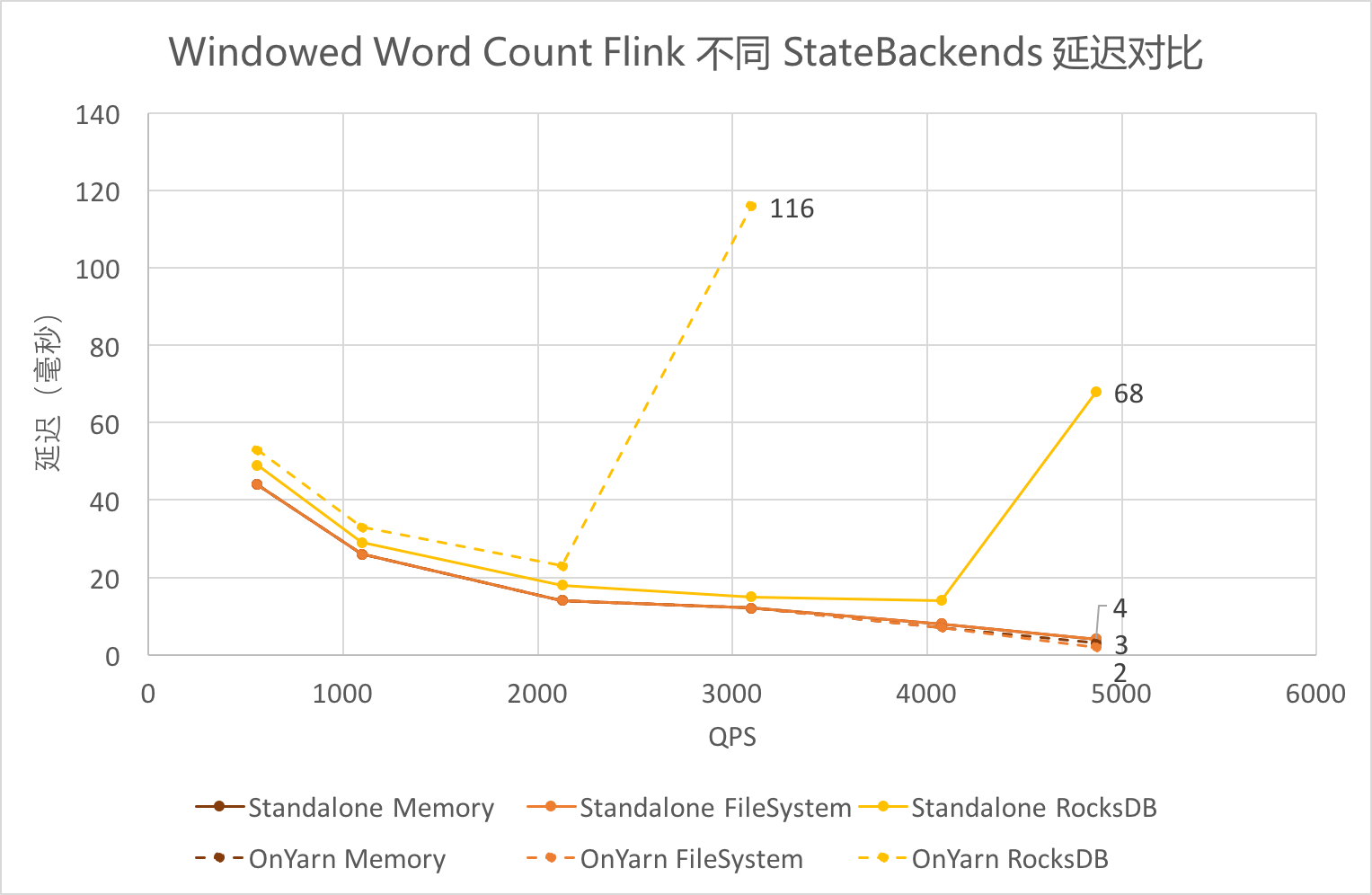

图2是CAECGAT的方法示意图,其中的核心是CGAT(Cross-KG Attention)层,该部分包含Aggregation和 Attention-based Cross-KG Propagation两个主要部分,前者利用预对齐种子上下文,转换双语图谱得到跨图谱信息。后者则用于扩展这些跨图谱信息。进一步利用Stacking multiple CGAT层,能够扩展单跳邻居信息为多跳邻居。

对于每组预对齐实体组合,组合它们在其他KG中的对应实体的embedding,并使用一个门单元更新它们。其形式如公式1:

其中,el表示第l层的向量表示,gl表示门单元,用于控制跨图谱信息流,如公式2,对于没有预对齐的实体在aggregation层则没有变化。

通过应用这种aggregation方法,可以获得带有共享实体表示的跨图谱embedding,形式上如公式3,4所示:

接着,利用收集的邻居信息,继续使用attention机制对entity embeding进行更新,形式如公式5和6:

形式上,上述aggregation与propagation两层可以一起表示为:

作者描述CAECGAT模型的算法如下:

实验

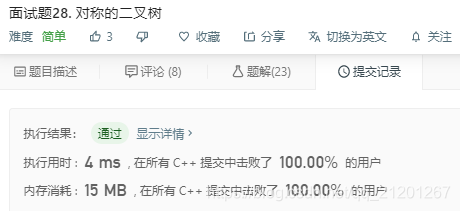

本文实验使用的是DBP15K数据的三个子集,统计信息如下所示:

实验结果如表3所示:

OpenKG

开放知识图谱(简称 OpenKG)旨在促进中文知识图谱数据的开放与互联,促进知识图谱和语义技术的普及和广泛应用。

点击阅读原文,进入 OpenKG 网站。