目录

层次分析法(AHP)

基本步骤

建立层次模型

构造判断矩阵

一致性检验

求得权重

填表得结果

一点补充

详细做法补充

特征向量含义思考

一些问题

优劣解距离法(TOPSIS)

基本思想

模型步骤

数据处理

指标正向化

标准化处理

计算得分

*结果处理

熵权法

模型思想

基本步骤

更多理解

*归一化与标准化

归一化(Normalization)

1.平均归一化(Mean Normalization)

2.minmax归一化(Rescaling)

3.非线性归一化(Non-Linear Normlization)

标准化(Standardization)

1.Z-Score标准化

中心化(Centralization)

区别和用途

灰色关联分析(GRA)

基本步骤

确定分析序列

数据预处理

计算灰色关联系数

计算关联度

综合评价

正向化预处理

去除量纲

构造母序列

计算关联系数

计算指标关联度

计算指标权重

计算得分

结果归一化

*去量纲化方法

初值化

均值化

百分比变换

倍数变换

归一化变换

极差最大值变换

区间值变换

模糊综合评价(fuzzy sets)

基本步骤

建立综合评价的因素集

建立综合评价的评价集

构造隶属函数,获得评价矩阵

确定因素权向量

建立综合评价模型

一些思考

层次分析法(AHP)

层次分析法(Analytic Hierarchy Process,AHP)

这是一种定性和定量相结合的、系统的、层次化的分析方法。这种方法是在对复杂决策问题的本质上,利用较少的定量信息使决策的思维过程数学化,从而为多目标、多准则或无结构特性的决策问题提供简便的决策方法。是对难以定量的复杂系统进行决策的模型。

层次分析法的根本是打分法:确定指标,不同方案指标打分,为指标确定权重。用于处理数据未知的评价。

层次分析法将问题分解为组成因素,并按照因素间关联、影响以及隶属关系将因素按不同的层次聚集组合,形成一个多层次的分析结构模型。从而最终使问题归结为最低层(供决策的方案、措施等)相对于最高层(总目标)的相对重要权值的确定或相对优劣次序的排定。

基本步骤

建立层次模型

思考以下问题:

- 我的的评价目标是什么?

- 达到目标有哪些方案?

- ★对方案的评价准则或指标是什么?(最好参考引用文献)

将决策的目标、决策准则(考虑的因素)和决策对象绘制为层次结构图。

- 最高层(目标层):决策的目的、要解决的问题;

- 中间层(准则层或指标层):考虑的因素、决策的准则;

- 最低层(方案层):决策时的备选方案;

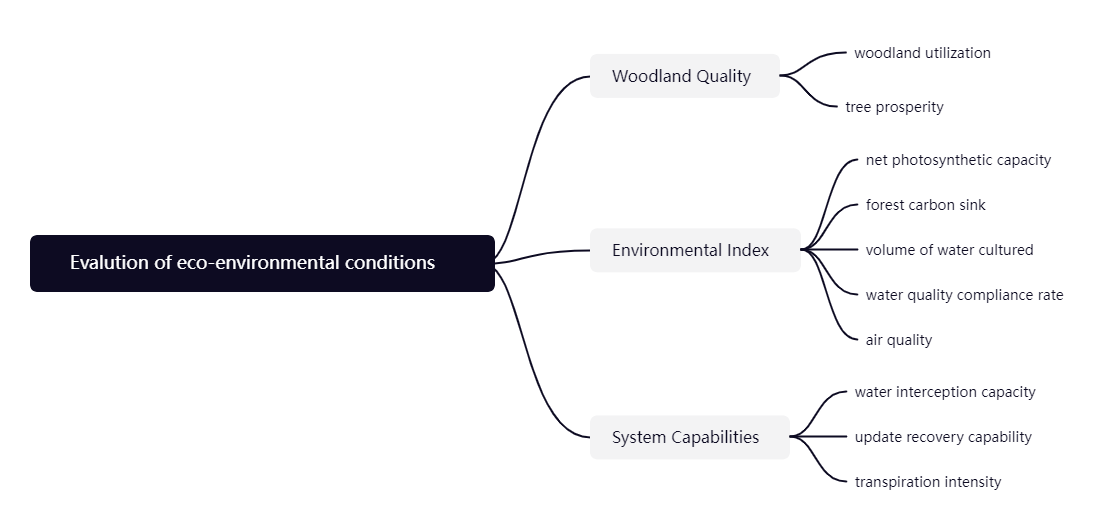

或仅绘制评价体系(树状图或表格)如下 (要包含多级指标):

评价模型

构造判断矩阵

(成对比较矩阵)

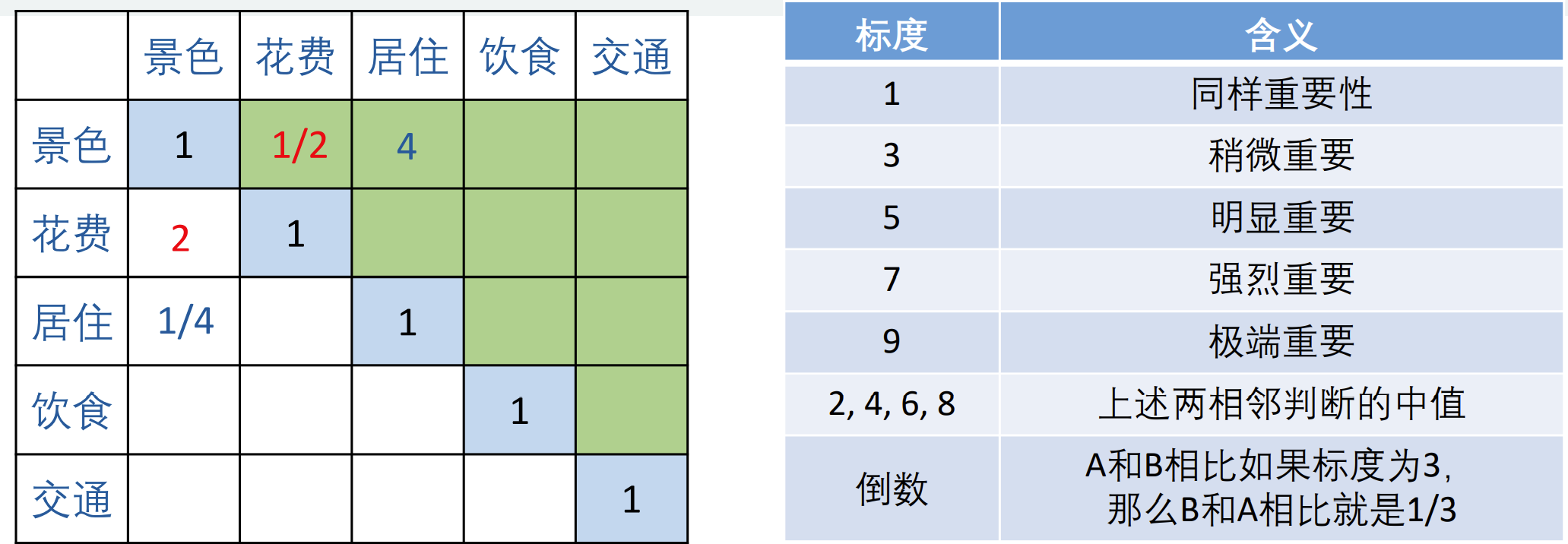

在确定权重时,只给出定性的结果(就是我认为景色占80%,费用10%等等),常常不被别人接受,因此采用一致矩阵法,即:

- 不把所有因素放在一起比较,而是两两比较

- 对此时采用相对尺度,尽可能减少诸因素导致的相互比较的困难,提高准确性

成对比较矩阵是表示本层所有因素针对上一层某一个因素(准侧或目标)的相对重要性的比较。成对比较矩阵的元素 \(a_{ij}\) 表示的是第 \(i\) 个因素相对于第 \(j\) 个因素的比较结果,这个值使用的是Santy的1-9标度方法给出。

定义且满足

\[a_{ij}=i相对j的重要度=\frac{i的重要程度}{j的重要程度}=a_{ik}a_{kj}\]

一致性检验

\(\left[\begin{array}{cccc} a_{11} & a_{12} & \cdots & a_{1 n} \\ a_{21} & a_{22} & \cdots & a_{2 n} \\ \vdots & \vdots & \ddots & \vdots \\ a_{n 1} & a_{n 2} & \cdots & a_{n n} \end{array}\right]\)为一致矩阵的充要条件\(\left\{\begin{array}{l} a_{i j}>0 \\ a_{11}=a_{22}=\cdots=a_{n n}=1 \\ {\left[a_{i 1},..., a_{i n}\right]=k_{i}\left[a_{11},..., a_{1 n}\right]} \end{array}\right.\)

对于

一致阵:则我们自然会取对应于最大特征根 \(n\) 的归一化特征向量 \(\{w_1,w_2,\cdots,w_n\}\) ,且 \(\sum_{i=1}^{n}{w_i=1}\) , \(w_i\) 表示下层第 \(i\) 个因素对上层某个因素影响程度的权值。

非一致阵:用其最大特征根对应的归一化特征向量作为权向量 \(W=\{w_1,w_2,\cdots,w_n\}\) ,则 \(AW=\lambda W\) ,这样确定权向量的方法称为特征根法;

定理:

- \(n\) 阶一致阵的唯一非零特征根为 \(n\)

- \(n\) 阶互反阵 \(A\left(a_{i j}>0, a_{i j}=\frac{1}{a_{j i}}, a_{i i}=1\right)\) 最大特征根 \(\lambda \geq n\) ,当且仅当 \(\lambda=n\) 时, \(A\) 为一致矩阵。

\(\lambda\) 连续的依赖于 \(a_{ij}\) ,则 \(\lambda\) 比 \(n\) 大的越多, \(A\) 的不一致性越严重。用最大特征值对应的特征向量作为影响程度的权向量,其不一致程度越大,引起的判断误差越大。

第一步:计算一致性指标CI

\[CI=\frac{\lambda -n}{n-1}\]

- \(CI=0\) ,有完全的一致性;

- \(CI\) 接近 \(0\) ,有满意的一致性

- \(CI\) 越大,不一致越严重;

第二步:查找对应的平均随机一致性指标RI

| n | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 | 13 | 14 | 15 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| RI | 0 | 0 | 0.52 | 0.89 | 1.12 | 1.26 | 1.36 | 1.41 | 1.46 | 1.49 | 1.52 | 1.54 | 1.56 | 1.58 | 1.59 |

\(RI\) 为统计结果,详细计算方法参考这里

第三步:计算一致性比例CR

\[CR=\frac{CI}{RI}\]

如果 \(CR < 0.1\), 则可认为判断矩阵的一致性可以接受;否则需要对判断矩阵进行修正。

求得权重

- 算术平均法求权重 \[\omega_{i}=\frac{1}{n} \sum_{j=1}^{n} \frac{a_{i j}}{\sum_{k=1}^{n} a_{k j}}\]

- 几何平均法求权重 \[\omega_{i}=\frac{\left(\prod_{j=1}^{n} a_{i j}\right)^{\frac{1}{n}}}{\sum_{k=1}^{n}\left(\prod_{j=1}^{n} a_{k j}\right)^{\frac{1}{n}}}\]

- 特征值法求权

特别的:若特征值为n,对应特征向量为\(k\left[\frac{1}{a_{11}}, \frac{1}{a_{12}}, \cdots, \frac{1}{a_{1 n}}\right]^{T}\),且特征向量刚好为矩阵第一列。

假如我们的判断矩阵一致性可以接受,那么我们可以仿照一致矩阵权重的求法。

- 求出矩阵A的最大特征值以及其对应的特征向量

- 对求出的特征向量进行归一化即可得到我们的权重( \(\sum_{i=1}^{n}{w_i=1}\) )

填表得结果

表格

然后相应的加权计算得分即可得到结果。

一点补充

详细做法补充

- 对于评价指标:

- 单层评价指标:构造所有指标的两两判断矩阵,得到权值

- 多层评价指标:

- 构造一级指标的两两判断矩阵,得到权值

- 构造每个一级指标下的二级指标的两两判断矩阵(每个一级指标一个矩阵),得到权值

- 构造每个二级指标下……

……

- 对于方案:

- 对于每个最低级指标构造所有方案的两两判断矩阵,得到权值

示例:

\[ \left\{\begin{array}{l} 一级指标1\left\{\begin{array}{l} 二级指标1 :a_{11},a_{12},a_{13}\\ 二级指标2 :a_{21},a_{22},a_{23}\\ \end{array}\right.\\ \\ 一级指标2\left\{\begin{array}{l} 二级指标3 :a_{31},a_{32},a_{33}\\ 二级指标4 :a_{41},a_{42},a_{43}\\ 二级指标5 :a_{51},a_{52},a_{53}\\ \end{array}\right.\\ \\ 一级指标3 : a_{61},a_{62},a_{63} \end{array}\right.\\ \]

特征向量含义思考

对于矩阵 \(A=\left[\begin{array}{cccc} a_{11} & a_{12} & \cdots & a_{1 n} \\ a_{21} & a_{22} & \cdots & a_{2 n} \\ \vdots & \vdots & \ddots & \vdots \\ a_{n 1} & a_{n 2} & \cdots & a_{n n} \end{array}\right]\) , \(W=\left[\begin{array}{c} w_{1}\\ w_{2}\\ \vdots\\ w_{n} \end{array}\right]\) ,满足 \(AW=\lambda A\) 。

矩阵的本质是变换,把 \(A\) 看作对 \(m\) 纬空间单位球体进行 \(A\) 变换,取 \(\lambda\) 最大时的特征向量 \(W\) ,即表示为变换后的球体上与变换前方向相同的点中距离原点 \(O\) 最远的点(距离原点距离为 \(\lambda\) )所表示的方向向量 。记 \(W\) 为可以代表整个变换 \(A\) 的线性变换。

特别的对于对称矩阵 \(A\) ,变换 \(A\) 一定是将球变为椭球,这也是不同特征值对应特征向量一定正交的原因,相同特征值 \(\lambda\) 若有多个特征向量 \(e_1,e_2,...\),特征向量的张成空间都是该特征值 \(\lambda\) 的特征向量。\(\lambda\) 的特征向量。

但是,对于非特殊矩阵,几何意义不明确,另外对于正互反矩阵、一致性矩阵的变换性质,笔者并不清楚,所以也仅仅能近似的类比理解到这里了。 (22.1.18)

一些问题

- 评价的决策层不能太多,太多的话n会很大,判断矩阵和一致矩阵差异可能会很大。

- 平均随机一致性指标RI的表格中n最多是15。

所以当n过大可以分层归纳为多级指标再构造多个判断矩阵。

优劣解距离法(TOPSIS)

TOPSIS法(Technique for Order Preference by Similarity to Ideal Solution)

可翻译为逼近理想解排序法,国内常简称为优劣解距离法。是根据有限个评价对象与理想化目标的接近程度进行排序的方法,是在现有的对象中进行相对优劣的评价。

TOPSIS 法是一种常用的综合评价方法,其能充分利用原始数据的信息,

其结果能精确地反映各评价方案之间的差距。

基本思想

构造计算评分公式:\(\frac{x-min}{max-min}\)

该公式能够良好的对一个指标下的数据进行评分,反应了单个数据在数据范围区间所处的位置。

拓展:将其中 \(x-min\) 理解为“x与最小点的距离”;\(max-x\) 理解为“x于最大值点的距离”即可得到多指标评价公式

模型步骤

数据处理

对所有的指标构成进行说明

对于 \(m\) 个评价指标横向排列,\(n\) 个评价对象纵向排列的矩阵,记为 \[X_{nm}=\left[\begin{array}{cccc} x_{11} & x_{12} & \cdots & x_{1 m} \\ x_{21} & x_{22} & \cdots & x_{2 m} \\ \vdots & \vdots & \ddots & \vdots \\ x_{n 1} & x_{n 2} & \cdots & x_{n m} \end{array}\right]\]

指标正向化

描述:统一指标类型,将为极小型、中间型、区间型等指标转换为极大值指标

注:最好不要出现负数(无法求熵权)

- 极小型指标转换为极大型指标的公式

\[\bar{x}_{i}=max-x_i或\bar{x}_{i}=\frac{1}{x_i}\] 其中:\(\bar{x}_{i}\)代表转化后的结果

- 中间型指标转化为极大型指标

\[\bar{x}_{i}=1-\frac{\left|x_{i}-x_{\text {best }}\right|}{\max \left(\left|X-x_{\text {best }}\right|\right)}\] 其中:\(x_{best}\) 指代的是最好的值

- 区间型指标转化为极大型指标

\[ \overline{x_{i}}=\left\{\begin{array}{c} 1-\frac{a-x_{i}}{M}, x_{i}>a \\ 1, \quad a<x_{i}<b \\ 1-\frac{x_{i}-b}{M}, x_{i}>b \end{array} \right. \] 其中:\(M=\max \{a-\min (X), \max (X)-b\}\)即偏离最优区间最远的值; \(a\)为下界,\(b\)为上界

标准化处理

描述:消去不同指标量纲的影响

记标准化矩阵为\(Z_{nm}\),有\(Z_{i j}=\frac{x_{i j}}{\sqrt{\sum_{i=1}^{n} x_{i j}^{2}}}\)

计算得分

定义 \[ \begin{aligned} Z^{+} &=\left(Z_{1}^{+}, Z_{2}^{+}, \cdots, Z_{m}^{+}\right) \\ &=\left(\max \left\{z_{11}, z_{21}, \cdots, z_{n 1}\right\}, \max \left\{z_{12}, z_{22}, \cdots, z_{n 2}\right\}, \cdots, \max \left\{z_{1 m}, z_{2 m}, \cdots, z_{n m}\right\}\right) \\ Z^{-} &=\left(Z_{1}^{-}, Z_{2}^{-}, \cdots, Z_{m}^{-}\right) \\ &=\left(\min \left\{z_{11}, z_{21}, \cdots, z_{n 1}\right\}, \min \left\{z_{12}, z_{22}, \cdots, z_{n 2}\right\}, \cdots, \min \left\{z_{1 m}, z_{2 m}, \cdots, z_{n m}\right\}\right) \end{aligned} \]

定义第 \(i(i=1,2, \cdots, n)\) 个评价对象与最大值的距离 \(D_{i}^{+}=\sqrt{\widetilde{w}_{j}\sum_{j=1}^{m}\left(Z_{j}^{+}-z_{i j}\right)^{2}}\)

定义第 \(i(i=1,2, \cdots, n)\) 个评价对象与最小值的距离 \(D_{i}^{-}=\sqrt{\widetilde{w}_{j}\sum_{j=1}^{m}\left(Z_{j}^{-}-z_{i j}\right)^{2}}\)

其中\(\widetilde{w}_{j}\)为加权的指标权重,权重默认为1(因为除法,权重单位量对结果无影响),可以用层次分析法或熵权法确定权重。

第 \(i(i=1,2, \cdots, n)\) 个评价对象未归一化得分\(S_{i}=\frac{D_{i}^{-}}{D_{i}^{+}+D_{i}^{-}}\)

*结果处理

为了比较不同评价模型得到的结果曲线,常常对结果处理。让结果更容易解释,或更好比较。(归一化、标准化)

\[\widetilde{S_{i}}=\frac{S_{i}}{\sum_{i=1}^{n} S_{i}}\]

熵权法

熵权法构建系数利用了信息论的知识。简单的说,数据的变异程度(方差)越大,就说明这个指标蕴含的信息量越大,也就越重要。例如:一个指标都是相同的数值,那么这个指标的变异程度(方差)就超级小,也没对最终的判断做出贡献,所以这个指标的权重就可以赋为0。

模型思想

记信息量为\(I(p)\),概率为\(p\),有\(I(1)=0\)、\(I(0^+)=+\infty\),可以得到一个\(I\)与\(p\)呈反比的函数图像。

构造\(I(x)=- \ln{p(x)}\)保证\(0 \leqslant p(x) \leqslant 1\)。\(x\)表示事情发送的情况,\(p(x)\)表示事情发生的概率。

可定义事件\(X={x_1,x_2,...,x_n}\)(\(x_i\)为发生情况)的信息熵为: \[H(X)=\sum_{i=1}^{n}\left[p\left(x_{i}\right) I\left(x_{i}\right)\right]=-\sum_{i=1}^{n}\left[p\left(x_{i}\right) \ln \left(p\left(x_{i}\right)\right)\right]\] 信息熵的本质是对信息量的期望值。

注:可证当\(p(x_1)=p(x_2)=...=p(x_n)=\frac{1}{n}\)时\(H(x)\)取得最大值为\(\ln n\)。

基本步骤

- 矩阵正向化和标准化 \[Z=\left[\begin{array}{cccc} z_{11} & z_{12} & \cdots & z_{1 m} \\ z_{21} & z_{22} & \cdots & z_{2 m} \\ \vdots & \vdots & \ddots & \vdots \\ z_{n 1} & z_{n 2} & \cdots & z_{n m} \end{array}\right] \]

- 对已经正向化和标准化的矩阵,若有负数需再次归一化(另一种标准化) \[\tilde{z}_{i j}=\frac{x_{i j}-\min \left\{x_{1 j}, x_{2 j}, \cdots, x_{n j}\right\}}{\max \left\{x_{1 j}, x_{2 j}, \cdots, x_{n j}\right\}-\min \left\{x_{1 j}, x_{2 j}, \cdots, x_{n j}\right\}}\]

- 计算概率矩阵 \[p_{i j}=\frac{\tilde{z}_{i j}}{\sum_{i=1}^{n} \tilde{z}_{i j}}\]

- 计算熵值。之所以除以了一个 \(ln(n)\) 是为了归一化 \[e=-\frac{1}{\ln (n)} \times \sum_{i=1}^{n} p_{i} \ln \left(p_{i}\right)\]

- 构建权重。首先用\(1-e_j\)得到信息的效用值,之后因为权重只和为\(1\),在对权重进行归一化即可得到\(w_j\)权重 \[d_j=1-e_j\] \[w_j=\frac{d_j}{\sum_{j=1}^m d_j}\]

熵权法仅仅能反应指标信息量的大小,并不能反应指标的重要程度,所以使用熵权法加权的评价模型得到的结果往往比未加权的结果变化幅度更大,增减趋势更明显。但似乎并不能得到一个客观的评分? (22.1.21)

更多理解

对于形如上文 \(Z\) 的矩阵,可以将\(m\)个评价指标看作\(m\)个坐标轴。对于这\(m\)个坐标轴的张成空间 \(V\) ,每一条横轴(即待评价单元)就可表示为该空间上的一点 \(P(x_{i1},x_{i2},...,x_{im})\)。

\(Z^{+}(Z_{1}^{+}, Z_{2}^{+}, \cdots, Z_{m}^{+})\) , \(Z^{-}(Z_{1}^{-}, Z_{2}^{-}, \cdots, Z_{m}^{-})\) 为包含所有评价点集的最小“\(m\)维体”的主对称轴上的两端点。

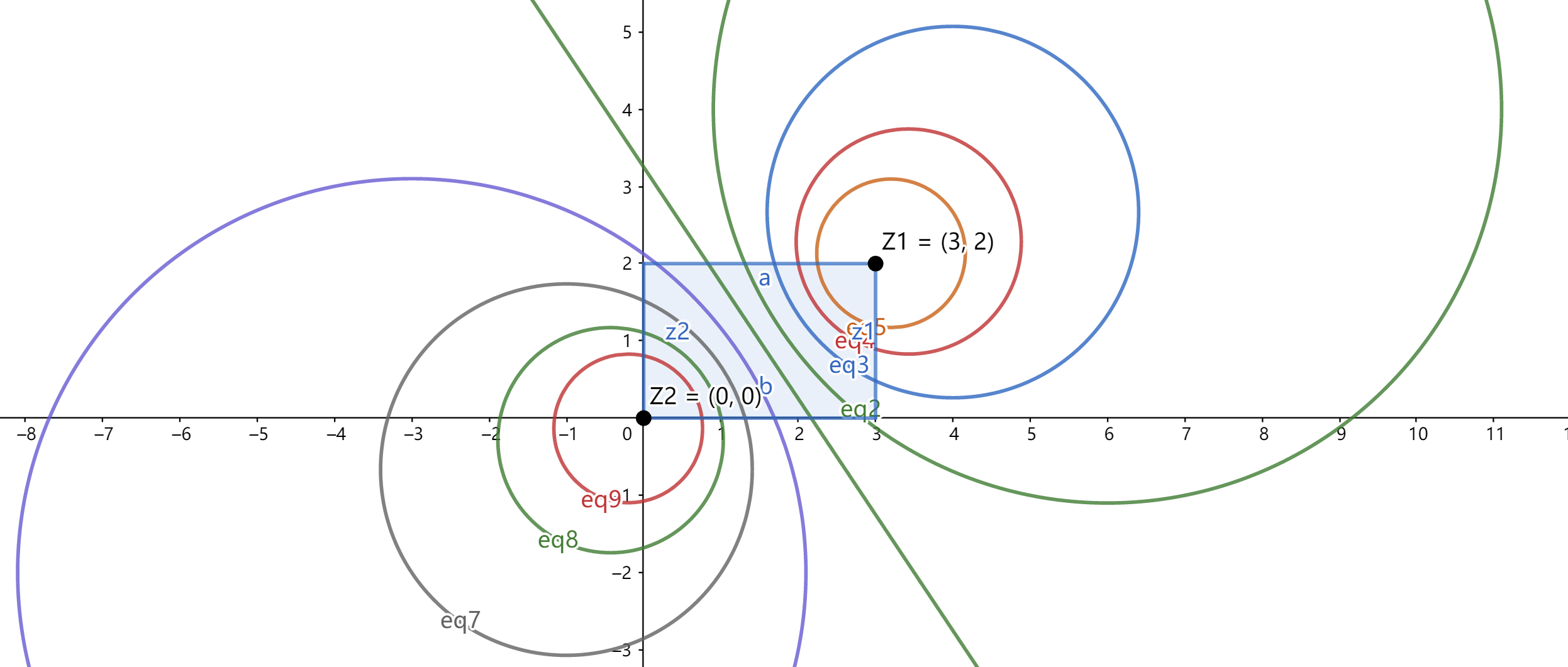

对于 \(S_{i}=\frac{D_{i}^{-}}{D_{i}^{+}+D_{i}^{-}}=\frac{1}{1+k}\) , \(k\) 的含义为点到 \(Z^+\) 与 \(Z^-\) 的距离比值。形如 \(k=\frac{D^+}{D^-}=\frac{dis(X,Z^+)}{dis(X,Z^-)}\) 的式子表示的曲线为\(m\)纬的球体。

以下为2个评价指标时,以 \(Z^+(3,2)\) , \(Z^-(0,0)\) 为端点,\(k=\{2^{-4},2^{-3},...,2^4\}\) 时的函数图像。同一曲线上的点表示的评价结果相同。

二维评价张成空间

如图,可以看出TOPSIS评价对空间进行了扭曲(把\(m\)空间非线性压缩为一维评价系)。保留了样本间间距,但损失了原始统计信息。

通过下文解释,所以TOPSIS是高纬的归一化(Normalization)?但下文中说,归一化也是线性放缩。 (22.1.18)

*归一化与标准化

它们都是指特征工程中的特征线性缩放过程

作用:

- 使不同量纲的特征处于同一数值量级,减少方差大的特征的影响,使模型更准确。

- 加快学习算法的收敛速度。

缩放过程可以分为以下几种:

- 缩放到均值为0,方差为1(Standardization——StandardScaler())

- 缩放到0和1之间(Standardization——MinMaxScaler())

- 缩放到-1和1之间(Standardization——MaxAbsScaler())

- 缩放到0和1之间,保留原始数据的分布(Normalization——Normalizer())

1就是常说的z-score归一化,2是min-max归一化。

归一化(Normalization)

1.平均归一化(Mean Normalization)

这种归一化需防止在线学习或在线推理中,新进样本突破原始min或max数据

\[\frac{X_{i}-\mu }{X_{\max }-X_{\min }}\]

其中:\(X_{min}\)表示对应矩阵中最小的数;\(X_{max}\)表示对应矩阵中最大的数

2.minmax归一化(Rescaling)

这种归一化需防止在线学习或在线推理中,新进样本突破原始min或max数据 \[\frac{X_{i}-X_{\min }}{X_{\max }-X_{\min }}\]

3.非线性归一化(Non-Linear Normlization)

\[ \begin{array}{c} \lg x \\ \log _{2} x \\ \frac{2}{\pi} \arctan x \end{array} \] 这种归一化需考虑数据分布,进行适当的非线性函数选取。

标准化(Standardization)

1.Z-Score标准化

\[\frac{X_{i}-\mu}{\sigma}\] 这种标准化需要要求原数据近似高斯分布。

其中:\(\mu\)表示矩阵均值;\(\sigma\)表示矩阵标准差

中心化(Centralization)

对于中心化,有的地方成为Mean-Subtraction,表示均值-减去(有点日本话的感觉),有的地方称之为Zero-Mean即零均值化,还有的为Zero-Centered这个只可意会很难翻译。但总而言之,他们都是下面这个形式: \[x_i-\mu\]

区别和用途

归一化和标准化的相同点都是对某个特征(column)进行缩放(scaling)而不是对某个样本的特征向量(row)进行缩放。对特征向量进行缩放是毫无意义的。

归一化和标准化都保持数据分布不变的情况下(两者本质上都只是对数据进行线性变化),对数据进行处理,但是从公式上面还是能够明显看出来,归一化的处理只是和最大值最小值相关,归一化后样本会失去原始的信息;标准化却是和数据的分布相关(均值,方差)。归一化更好保留了样本间间距;标准化的统计意义更强,是数据缩放的首选。

| 归一化 | 将一列数据“拍扁”到某个固定区间(常为[0,1]),和最大/小值有关 |

|---|---|

| 标准化 | 将数据变换为均值0,标准差为1的分布(并非一定正态),缩放和每个点都有关(通过均值+方差体现) |

| 中心化 | 变量减去均值,可避免异常值和极端值的影响,本质为口个平移过程,平移后数据中心是原点0 |

灰色关联分析(GRA)

灰色关联度分析(Grey Relation Analysis)

可以在一个灰色系统中,衡量某个项目受其他的因素影响的相对强弱。

两个系统之间的因素,随时间或不同对象而变化的关联性大小的量度,称为关联度。两个因素变化即同步变化程度较高,即可谓二者关联程度较高;反之,则较低。因此,灰色关联分析方法,根据因素之间发展趋势的相似相异程度,为衡量因素间关联程度提供了量化的度量。

灰色关联分析的基本思想是根据序列曲线几何形状的相似程度来判断其联系是否紧密。曲线越接近,相应序列之间的关联度就越大,反之就越小。

基本步骤

确定分析序列

- 母序列(又称参考序列、母指标)

能反映系统行为特征的数据序列,类似于因变量 \(Y\) ,记为

\[Y=[y_1,y_2,...,y_m]^T\]

- 子序列(又称比较序列、子指标)

影响系统行为的因素组成的数据序列,类似于因变量 \(X\) ,记为

\[X_{nm}=\left[\begin{array}{cccc} x_{11} & x_{12} & \cdots & x_{1 m} \\ x_{21} & x_{22} & \cdots & x_{2 m} \\ \vdots & \vdots & \ddots & \vdots \\ x_{n 1} & x_{n 2} & \cdots & x_{n m} \end{array}\right]\]

其中:\(n\) 为年份数量,\(m\) 为要素的个数

数据预处理

由于不同要素具有不同量纲和数据范围范围,因此我们需要对它们进行归一化(常用均值化)去量纲,将它们统一到近似的范围内,然后重点关注其变化和趋势。

\[\widetilde{y}_{k}=\frac{y_{k}}{\bar{y_i}}, \quad \bar{y_i}=\frac{1}{n} \sum_{k=1}^{n} y_{k}\]

\[\widetilde{x}_{ki}=\frac{x_{ki}}{\bar{x_{\_i}}}, \quad \bar{x_{\_i}}=\frac{1}{n} \sum_{k=1}^{n} x_{ki}, (i=1,2,...m)\]

注:下文继续用 \(X\) 代指预处理后的 \(\widetilde{X}\) , \(Y\) 代指 \(\widetilde{Y}\)。

计算灰色关联系数

计算子序列中各个指标与母序列的关联系数

记 \[a=\min _{i} \min_{k}\left|x_{0}(k)-x_{i}(k)\right|, \quad b=\max _{i} \max_{k}\left|x_{0}(k)-x_{i}(k)\right|\] 为两极最小差和最大差。

构造 \[z_{k,j}=\xi_j(k)=\frac{a+\rho b}{|x_{kj}-y_j|+\rho b}\] 构成 \(Z\)。

其中:\(\rho\)为分辨系数,一般取0.5

计算关联度

\[r_j=\frac{1}{n} \sum_{k=1}^{n} \xi_j(k) = \frac{1}{n} \sum_{k=1}^{n} z_{kj}\]

综合评价

正向化预处理

记正向化后的数据为: \[X_{nm}=\left[\begin{array}{cccc} x_{11} & x_{12} & \cdots & x_{1 m} \\ x_{21} & x_{22} & \cdots & x_{2 m} \\ \vdots & \vdots & \ddots & \vdots \\ x_{n 1} & x_{n 2} & \cdots & x_{n m} \end{array}\right]\]

其中:\(n\) 为年份数,\(m\) 为指标数

去除量纲

每个数 \(x_{ij}\) 除以每一列的平均值 \(\bar{x_{\_i}}\) ,记作 \(Z\) ,有

\[z_{ki}=\frac{x_{ki}}{\bar{x_{\_i}}}, \quad \bar{x_{\_i}}=\frac{1}{n} \sum_{k=1}^{n} x_{ki}, (i=1,2,...m)\]

\[Z_{nm}=\left[\begin{array}{cccc} z_{11} & z_{12} & \cdots & z_{1 m} \\ z_{21} & z_{22} & \cdots & z_{2 m} \\ \vdots & \vdots & \ddots & \vdots \\ z_{n 1} & z_{n 2} & \cdots & z_{n m} \end{array}\right]\]

构造母序列

构造 \(Y=[y_1,y_2,...,y_n]^T\) 其中 \[y_i=max(x_{i1},x_{i2},...,x_{im})\]

计算关联系数

记差值矩阵为 \(K\),有 \[K_{nm}=\left[\begin{array}{cccc} k_{11} & k_{12} & \cdots & k_{1 m} \\ k_{21} & k_{22} & \cdots & k_{2 m} \\ \vdots & \vdots & \ddots & \vdots \\ x_{k 1} & k_{n 2} & \cdots & k_{n m} \end{array}\right]=\left[\begin{array}{cccc} |x_{11}-y_1| & |x_{12}-y_1| & \cdots & |x_{1 m}-y_1| \\ |x_{21}-y_2| & |x_{22}-y_2| & \cdots & |x_{2 m}-y_2| \\ \vdots & \vdots & \ddots & \vdots \\ |x_{n 1}-y_n| & |x_{n 2}-y_n| & \cdots & |x_{n m}-y_n| \end{array}\right]\]

记 \[a=\min _{i} \min_{j}\left|k_{ij}\right|, \quad b=\max_{i} \max _{k}\left|k_{ij}\right|\] 为两极最小差和最大差。

计算指标关联度

记 \[\xi_{ij}=\frac{a+\rho b}{|k_{ij}|+\rho b}\]

其中:\(\rho\)为分辨系数,一般取0.5

\[r_j=\frac{1}{n} \sum_{j=1}^{n} \xi_{ij}\]

其中:\(r_j\) 为第 \(j\) 个指标的灰色关联度

计算指标权重

\[w_j=\frac{r_j}{\sum_{k=1}^{m} r_k} (j=1,2,...,m)\]

计算得分

\[S_i= \sum_{j=1}^{m} Z_{ij} \cdot r_j\]

结果归一化

\[\tilde{S}_i=\frac{S_i}{\sum_{k=1}^{m} S_k} (i=1,2,\cdots,n)\]

*去量纲化方法

初值化

顾名思义,就是把这一个序列的数据统一除以最开始的值,由于同一个因素的序列的量级差别不大,所以通过除以初值就能将这些值都整理到1这个量级附近。

\[f(x(k))=\frac{x(k)}{x(1)}=y(k), \quad x(1) \neq 0\]

均值化

顾名思义,就是把这个序列的数据除以均值,由于数量级大的序列均值比较大,所以除掉以后就能归一化到1的量级附近。

\[f(x(k))=\frac{x(k)}{\bar{x}}=y(k), \quad \bar{x}=\frac{1}{n} \sum_{k=1}^{n} x(k)\]

百分比变换

\[f(x(k))=\frac{x(k)}{\max _{k} x(k)}=y(k)\]

倍数变换

\[f(x(k))=\frac{x(k)}{\min _{k} x(k)}=y(k), \quad \min_{k} x(k) \neq 0\]

归一化变换

\[f(x(k))=\frac{x(k)}{x_{0}}=y(k)\]

极差最大值变换

\[f(x(k))=\frac{x(k)-\min _{k} x(k)}{\max_{k} x(k)}=y(k)\]

区间值变换

\[f(x(k))=\frac{x(k)-\min _{k} x(k)}{\max_{k} x(k)-\min _{k} x(k)}=y(k)\]

模糊综合评价(fuzzy sets)

模糊综合评价(Fuzzy Comprehension Evaluation Method)又为模糊集合理论(fuzzy sets) 对于难以明确分类,边界不明显的评价指标可才用模糊综合评价,模型关键在于构造的隶属函数的准确性和合理性。

基本步骤

建立综合评价的因素集

模糊综合评价指标的构建。

因素集是以影响评价对象的各种因素为元素所组成的一个普通集合,通常用 \(U\) 表示, \(U=(u_1,u_2,\cdots,u_m)\),其中元素 \(u_i\) 代表影响评价对象的第 \(i\) 个因素。这些因素,通常都具有不同程度的模糊性。

建立综合评价的评价集

评价集是评价者对评价对象可能做出的各种结果所组成的集合,通常用 \(V\) 表示, \(V=(v_1,v _2,\cdots,v_m)\) ,其中元素 \(v_i\) 代表第 \(i\) 种评价结果

构造隶属函数,获得评价矩阵

构造合理美观的隶属函数 \(Fuzz(x)\)。

若因素集U中第i个元素对评价集V中第1个元素的隶属度为 \(r_{i1}\) ,则对第 \(i\) 个元素单因素使用隶属函数评价的结果用模糊集合表示为:\(R_i=(r_{i1},r_{i2},\cdots,r_{in})\)。以 \(m\) 个单因素评价集构成 \(R_{mn}=[R1,R2,\cdots,Rm]^T\) ,称为模糊综合评价矩阵。

确定因素权向量

评价工作中,各因素的重要程度有所不同,为此,给各因素 \(u_i\)一个权重 \(w_i\) ,各因素的权重集合的模糊集,用 \(W\) 表示: \(W=(w_1,w_2,\cdots,w_m)\)。

建立综合评价模型

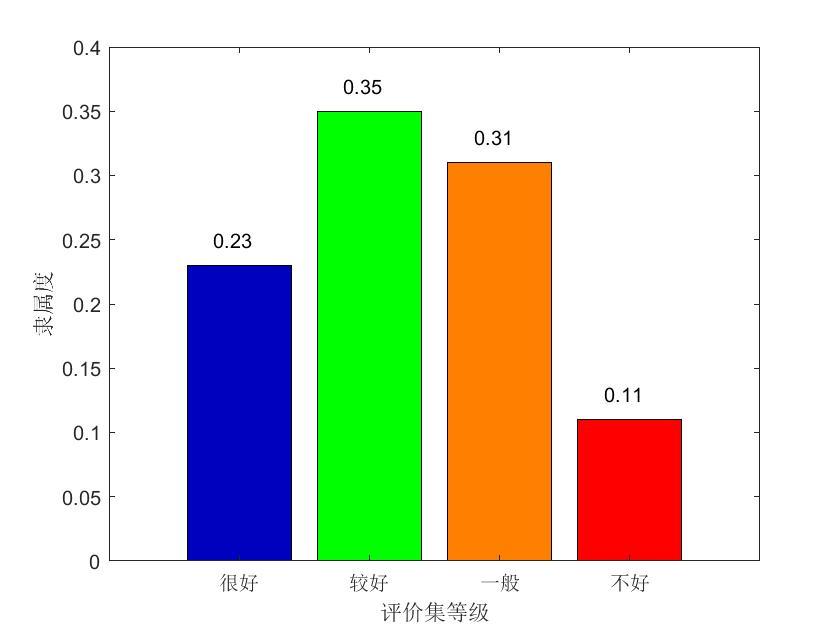

确定单因素评判矩阵 \(R\) 和因素权向量 \(W\) 之后,通过模糊变化将 \(U\)上的模糊向量 \(A\) 变为 \(V\) 上的模糊向量 \(B\),即 \[B=W_{1m}\cdot R_{mn}=(b_1,b_2,\cdots,b_n)\]

绘出结果 \(B\) 图像,如

一些思考

对于模糊评价,相较于作为一个“综合评价”,我更愿意把模糊综合评价看作为类似于层次分析法的带有主观意愿的评价(体现在隶属函数的构造上);对于模糊集合理论(模糊数学),更愿意看作一种思想(隶属程度的思想)。

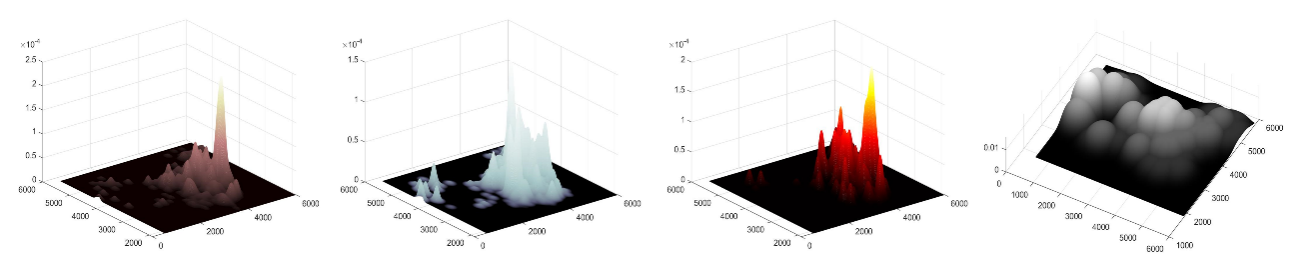

在2021亚太杯C题的第三四题中我用模糊数学思想,对于“是否属于城市印象范围”构造了这样的“模糊隶属函数”。\(Fuz_1(x)=\frac{ℯ^{-(k(x-b))}}{ℯ^{-(k(x-b))}+1}\)、\(Fuz_2(x)=ℯ^{\frac{(x-a)^2}{q}}\) 得到了以下的结果。 (22.2.1)

一些城市相关评价指标评分(隶属)图像

python开发中的trick:常量)