1.keras中使用相同的loss与metrics,都指定为mse,为什么训练时每轮完成后它们数值不一样?

答:

此时的loss是指完成最后一个batch后得到的这轮epoch的loss的加权平均,权重就是每个batch的样本数,(因为最后一个batch样本数往往跟训练时指定的不一样),完成最后一个batch后,此时loss已经固定了,但是仍然需要反向更新网络中的参数。注意,metrics是在这次更新完参数后对标签值和预测值进行计算,这里的预测值是模型训练完成后再正向传播得到的ouput,因此相比于loss中的y_pred,metrics的y_pred使用新的神经网络参数计算的,自然数值也就不一样了。

链接:https://www.zhihu.com/question/323251494/answer/719247402

20200311

1.运行如下代码,会发现model.summary()那里报错了

from tensorflow.keras.datasets import mnist

from tensorflow.keras.utils import to_categorical

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense,Flatten

#categorical_labels = to_categorical(int_labels, num_classes=None)

(X_train, y_train), (X_test, y_test) = mnist.load_data()

y_train = to_categorical(y_train, 10)

y_test = to_categorical(y_test, 10)

X_train = X_train[:10000]/255.0

y_train = y_train[:10000]

X_test = X_test[:10000]/255.0

y_test = y_test[:10000]

model = Sequential()

model.add(Flatten())

model.add(Dense(units = 512, input_dim = 28*28,activation = 'relu'))

model.add(Dense(units = 32,activation = 'relu'))

model.add(Dense(units = 10,activation = 'softmax'))model.summary()# model.compile(loss='categorical_crossentropy', optimizer='adam',metrics = ['acc'])

# model.fit(X_train, y_train, epochs=5, batch_size=128, verbose=1)

ValueError: This model has not yet been built. Build the model first by calling `build()` or calling `fit()` with some data, or specify an `input_shape` argument in the first layer(s) for automatic build.

意思是你还没告诉模型输入的尺寸格式,他自然没法给你返回summary。

解决方式也告诉你了,有如下几种:

1.需要在model.summary()上面写一句:model.build((None,28, 28))

参数最开始的这个None,代表的意思应该是数据样本个数,这里你替换成其他任意数值都是可以的。甚至(None,28,28,1)也可以。

但是有个问题,summary是下图这样的,Output Shape的格式是multiple,不显示具体值,也不知道为啥?

Model: "sequential_4"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

flatten_4 (Flatten) multiple 0

_________________________________________________________________

dense_9 (Dense) multiple 401920

_________________________________________________________________

dense_10 (Dense) multiple 16416

_________________________________________________________________

dense_11 (Dense) multiple 330

=================================================================

Total params: 418,666

Trainable params: 418,666

Non-trainable params: 0

2.先调用下面注释掉的fit,让他自动识别input_shape(当然应该得先conpile一下)

3.也是最常用的一种方式,就是在第一层,也就是Flatten的时候指明input_shape。即:model.add(Flatten(input_shape = (28,28)))

注意这里inputshape就不需要加None了。上面第一种方式中是必须要加一维None

Model: "sequential_13"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

flatten_14 (Flatten) (None, 784) 0

_________________________________________________________________

dense_37 (Dense) (None, 512) 401920

_________________________________________________________________

dense_38 (Dense) (None, 32) 16416

_________________________________________________________________

dense_39 (Dense) (None, 10) 330

=================================================================

Total params: 418,666

Trainable params: 418,666

Non-trainable params: 0

分析一下:注意是每一层的输出节点,都需要对应一个偏置!所以401920是 (784+1) * 512得来的 !!不是输入节点的偏置,也不是参数的偏置,是一个输出节点对应一个偏置!

参考链接:

https://blog.csdn.net/sisiel/article/details/103163016

20200311

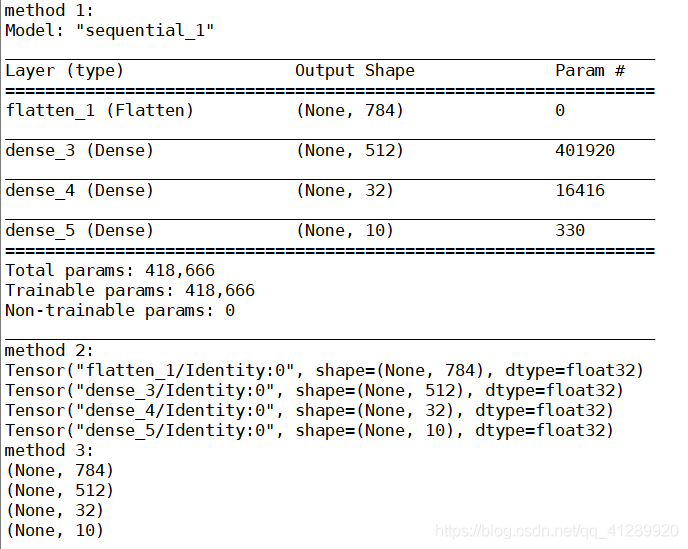

1. 各种定义和建立模型的方法,和input_shape,output_shape的输出方法

(下面代码中的模型还是昨天的那个模型)

from tensorflow.keras.datasets import mnist

from tensorflow.keras.utils import to_categorical

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense,Flatten

#categorical_labels = to_categorical(int_labels, num_classes=None)

(X_train, y_train), (X_test, y_test) = mnist.load_data()

y_train = to_categorical(y_train, 10)

y_test = to_categorical(y_test, 10)

X_train = X_train[:10000]/255.0

y_train = y_train[:10000]

X_test = X_test[:10000]/255.0

y_test = y_test[:10000]

model = Sequential()

model.add(Flatten(input_shape = (28,28) ))

model.add(Dense(units = 512, input_dim = 28*28,activation = 'relu'))

model.add(Dense(units = 32,activation = 'relu'))

model.add(Dense(units = 10,activation = 'softmax'))print('method 1:')

model.summary()print('method 2:')

for i in range(len(model.layers)):print(model.get_layer(index=i).output)print('method 3:')

for layer in model.layers:print(layer.output_shape)输出:

2.MaxPooling1D和MaxPooling2D的区别

Class MaxPooling1D:1D输入的最大池化层

- pool_size:一个整数或者一个单个整数的tuple/list,表示池化窗口的大小

- strides:一个整数或者一个单个整数的tuple/list,指定池化操作的移动步幅

- padding:一个字符串。padding的方法:”valid”或者’same’

- data_format:一个字符串,channels_last(默认)或channels_first中的一个,输入中维度的排序,channels_last对应于具有形状(batch, length, channels)的输入,而channels_first对应于具有形状(batch, channels, length)的输入。

- name:一个字符串,表示层的名称。

Class MaxPooling2D:2D输入的最大池化层

- pool_size:一个整数或者2个整数的元组/列表:(pool_height,pool_width),指定池化窗口的大小。 可以是单个整数,以为所有空间维度指定相同值。

- strides:一个整数或者2个整数的元组/列表,指定池操作的步幅。 可以是单个整数,以为所有空间维度指定相同值。

- padding:字符串,“valid”或者”same”

- data_format:一个字符串,channels_last(默认)或channels_first中的一个,输入中维度的排序,channels_last对应于具有形状(batch,height, width, channels)的输入,而channels_first对应于具有形状(batch, channels, height,width)的输入。

- name:层的名称。

20200312

1.关于输入数据的格式

我们要明白几点内容,当我们用theano作为backend时候,我们在进行卷积等一些操作时候,系统都会自动按照channel_first的来,比如卷积后的深度那一维放到了H,W的前面。而我们如果用tensorflow作为backend时候,系统会默认是channel_last。你可以通过修改backend来达到你想要的效果,并且通过下面这个函数测试,你目前是什么类型:

tf.keras.backend.image_data_format()这样就知道建立模型model的时候,input_shape()参数该怎么设置啦

20200313

1.关于keras模型和训练的可视化

1.模型可视化

关于模型的可视化,可以用keras自带的这个模块:plot_model

导入方式:

from tensorflow.keras.utils import plot_model具体的使用方式可以看博客或者b站那个视频。

参考链接:https://blog.csdn.net/leviopku/article/details/81433867

2.训练过程可视化

关于keras训练过程的可视化,可以看之前写的一篇博客。

链接:https://blog.csdn.net/qq_41289920/article/details/104755617

与服务应用程序框架(Service Application Framework) 1)

与服务应用程序框架(Service Application Framework) 2)