一、搭建环境的前提条件

环境:Linux系统

Hadoop-2.6.0

MySQL 5.6

apache-hive-2.3.7

这里的环境不一定需要和我一样,基本版本差不多都ok的,所需安装包和压缩包自行下载即可。但是注意hive和hadoop都是2.x系列版本的。

这里提供一个我下载的hive版本的链接,读者有需要可以自取:http://mirror.bit.edu.cn/apache/hive/hive-2.3.7/

这里需要提前搭建好hadoop环境和MySQL环境,具体可以看我的博客链接:Hadoop2.0伪分布式平台环境搭建和Linux环境下MySQL 5.6安装与配置----亲测有效----纯离线安装

二、搭建的详细步骤

1.使用mysql来存储hive元数据

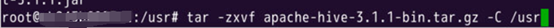

将hive下载完成后解压到指定目录下,注意这里的3.1版本改成我们前面的2.3版本即可。

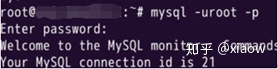

登录mysql

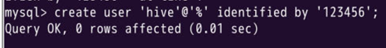

建立hive用户

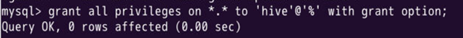

赋予hive用户足够权限

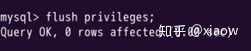

刷新mysql的系统权限相关表

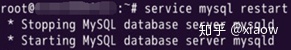

重启mysql服务,注意:这里需要使用 service mysqld restart 这个命令

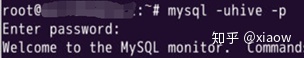

使用hive用户登录mysql

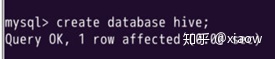

创建Hive专用元数据库

2.配置hive

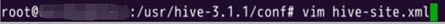

创建配置文件hive-site.xml

在xml输入以下内容,这里面的password是刚才创建hive用户的密码,我这里是123456

把mysql的jdbc驱动包复制到hive的lib目录下,下载网址https://dev.mysql.com/downloads/connector/j/,读者如有需要可联系我私发。

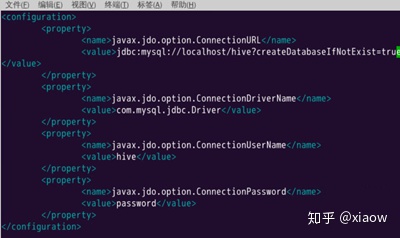

hive初始化

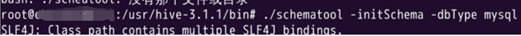

初始化的结果

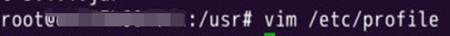

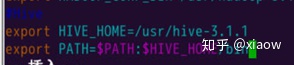

配置PATH环境变量进入profile文件

输入以下内容

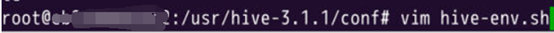

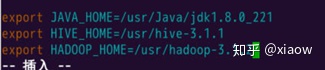

修改配置文件hive-env.sh ,执行以下命令

在hive-env.sh添加以下内容,这里的jdk与hadoop版本视自己本身情况而定。

3.启动hive

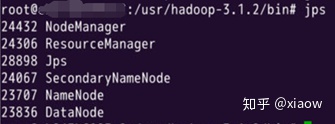

先开启hadoop集群,使用jps查看是否开启

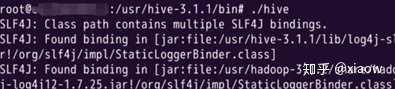

启动hive

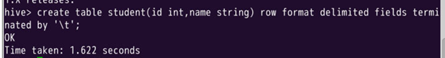

在Hive中创建表student

关闭hive的话使用exit;即可

hive>exit;

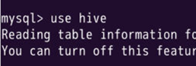

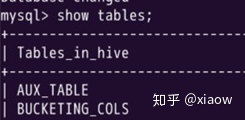

使用mysql查看

显示hive数据库中的数据表

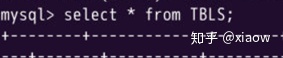

查看hive的元数据信息

三、总结

我这篇博文是基于MySQL和Hadoop伪分布式搭建的一个hive平台,在搭建的过程中也遇到了一些问题,也请教了一些同事,最终成功搭建出来了,希望这篇博文能够对各位有所帮助。

![[蓝桥杯2017初赛]九宫幻方-数论+next_permutation枚举](http://pic.xiahunao.cn/[蓝桥杯2017初赛]九宫幻方-数论+next_permutation枚举)

--学习笔记(上))

——汇总分析)