背景

-

日志系统主要包括系统日志,应用程序日志和安全日志。系统运维和开发人员可以通过日志了解服务器的软件,硬件信息,检查配置过程中的错误以及错误发生的原因。通常分析日志可以了解服务器的负荷,性能安全性,从而及时采取措施纠正错误。

-

难点一:通常日志被分散在不同设备上,如果你管理数十台上百台服务器,你开在使用一次登录每一台机器的传统方法查询日志,效率明显低下。我们应该使用集中化的日志管理,例如:开源的syslog,将所有服务器上的日志收集汇总。

-

难点二:集中化管理后,日志系统的统计检索又成为一件比较麻烦的事情,一般我们使用grep, awk, wc等linux命令能实现检索和统计,但是对于要求更高的查询,排序和统计等要求和庞大的机器数量依然使用这样的方法难免会有点力不从心。

-

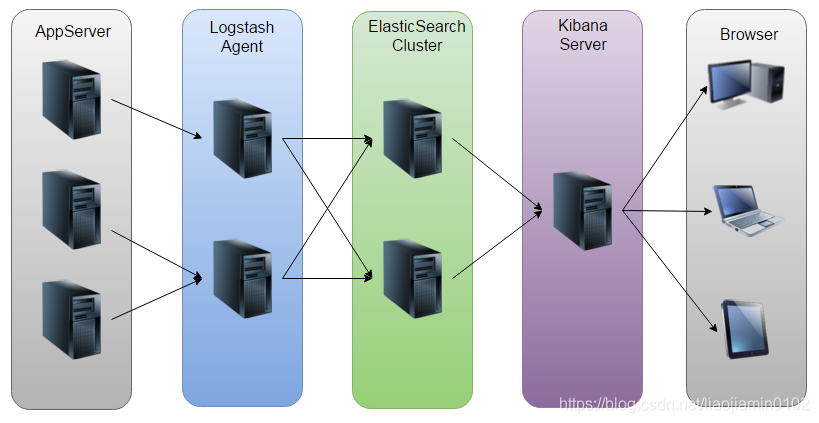

解决方法:开源实时的日志分析ELK平台能够王梅的解决我们上述的问题,ELK由ElasticSearch,Logstash和Kibana三个开源工具组成,官网:https://www.elastic.co/cn/products/

- Elasticsearch是一个开源分布式搜索引擎,他的特点是:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格的接口,多数据源,自动搜索负载等。

- Logstash是一个完全开源的工具,他可以对你的日志进行收集,过滤,并将其存储以后使用(比如,搜索)

- Kibana也是一个开源和免费的工具,Kibana可以为Logstash和ElasticSearch提供日志分析友好的Web界面,可以帮助汇总,分析,和搜索重要数据日志。

-

以下ELK工作原理图:

安装环境

- Windows10

- ElasticSearch:7.3.2

- Logstash:7.3.2

- Kibana:7.3.2

- JDK:1.8

- NSSM:2.24

安装配置Java环境

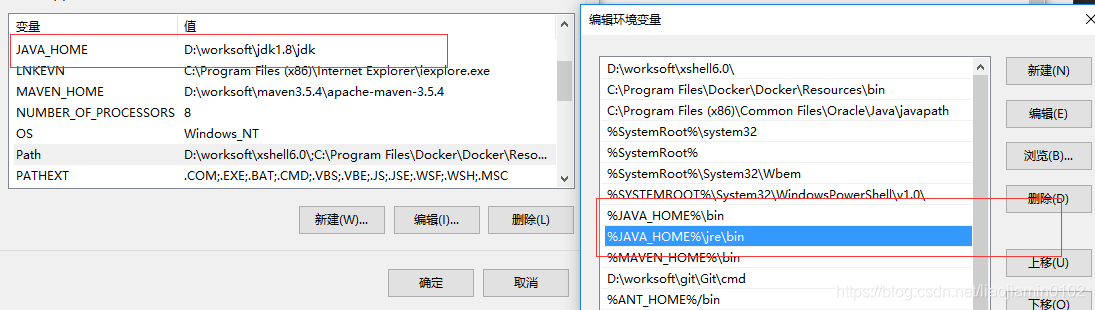

- 在Oracle官网获取最新版本的JAVA版本,运行按提示下一步就可以完成,安装后配置环境变量如图:

- CMD窗口下运行java -version命令,如果如下结果表示安装成功:

$ java -version

java version "1.8.0_171"

Java(TM) SE Runtime Environment (build 1.8.0_171-b11)

Java HotSpot(TM) 64-Bit Server VM (build 25.171-b11, mixed mode)

安装ELK

- 由于Logstash服务依赖ES服务,Kibana服务依赖LogStash和ES,所以ELK服务启动顺序为:ES—LogStash—Kibana,为了配合服务启动顺序,我们安装顺序也按启动顺序,首先准备所需要软件,如下地址:

- elasticsearch国内镜像

- kibana国内镜像

- logstash国内镜像

- NSSM下载地址

- 三个软件尽量用同一个版本的,否则可能出现不兼容的情况

Elasticsearch安装

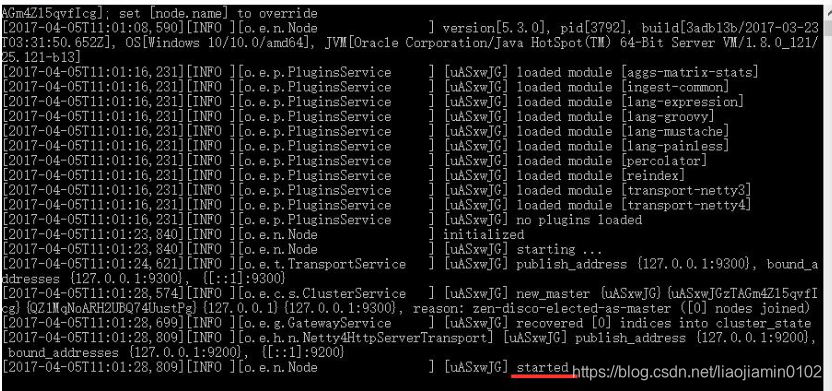

- 下载解压,进入bin目录下,直接双击执行elasticsearch.bat,可以看到如下

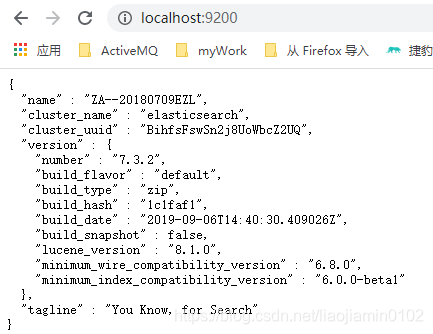

- 我们测试一下是否启动成功:

- 安装ElasticSearch-head插件,此处直接在Chrom浏览器中搜索ElasticSearch-head插件安装即可。

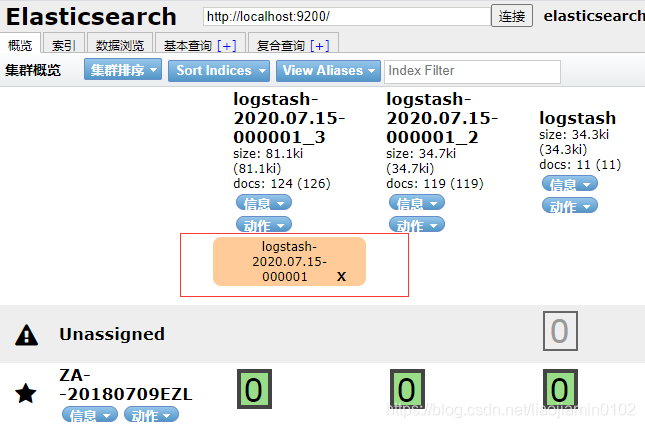

- 如下效果,输入localhost:9200,点击链接,就可以通过插件浏览es中现有的数据,并且支持查询操作:

- 以上启动方式是直接通过bat脚本,我们现在利用nssm软件对ES进行管理,将ES添加到系统进程中进行启动更加方便,如下流程:

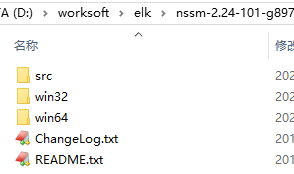

- 下载nssm,加压缩得到如下:

- 找到自己系统对应的win32,或者win64系统,将里面nssm.ext复制到ElasticSearch的bin目录中

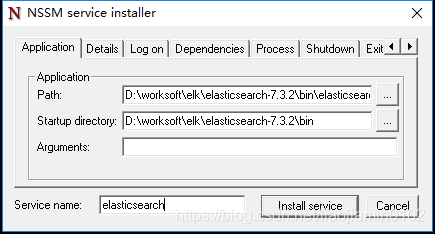

- CMD到es的bin目录下,执行nssm install elasticsearch,回车后会弹出一个安装设置界面:

- 如上图所示,填好对应的目录地址,applicationPath:选es的bin目录下 elasticsearch.bat文件,startup directory会自动填充,点击install service提示安装成功

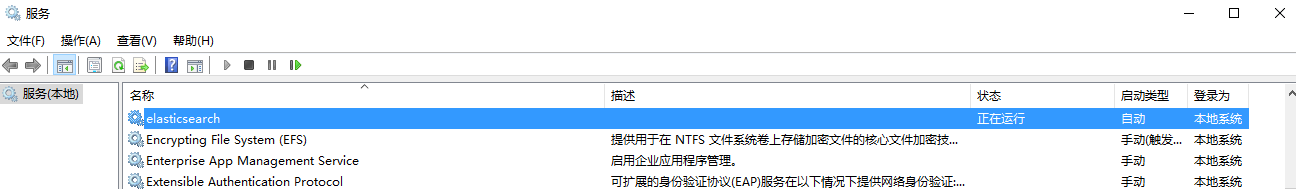

- 在CMD中输入services.msc打开windows服务管理界面找到elasticsearch,右键启动,按上步骤测试即可。

Logstash安装

- 先来一个常规非nssm方式的安装,下载解压,进入到logstash,将config目录下logstash-sample.conf 文件负责到bin目录,并且修改如下,重命名logstash.conf 首先来一个最简单配置:

input {stdin{ }

}

output {elasticsearch {hosts => ["http://localhost:9200"]}

}

- 配置如上input指定日志来源是为空设置,表示日志来自控制台,output配置日志输出位置,指定位es地址,允许多个

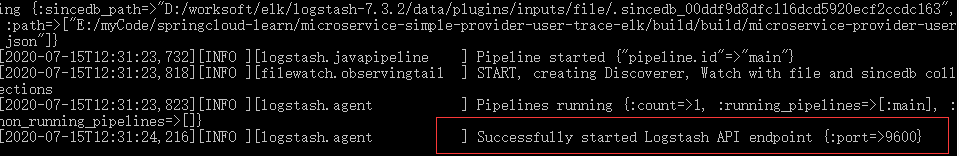

- CMD到logstash的bin目录下执行启动命令:logstash -f stdin.conf

- 当看到如上日志,表示已经成功启动并且连接到es,我们在控制台上输入任意字符,多试几次,日志推送到es中有一定延迟,接着到es-head中查看

- 在elasticsearch中会自动创建一个内容分配,用来存储logstash推送过来的信息,如下图所示:

- 我们可以通过基本查询来查询到我们刚才在控制台输入的信息。

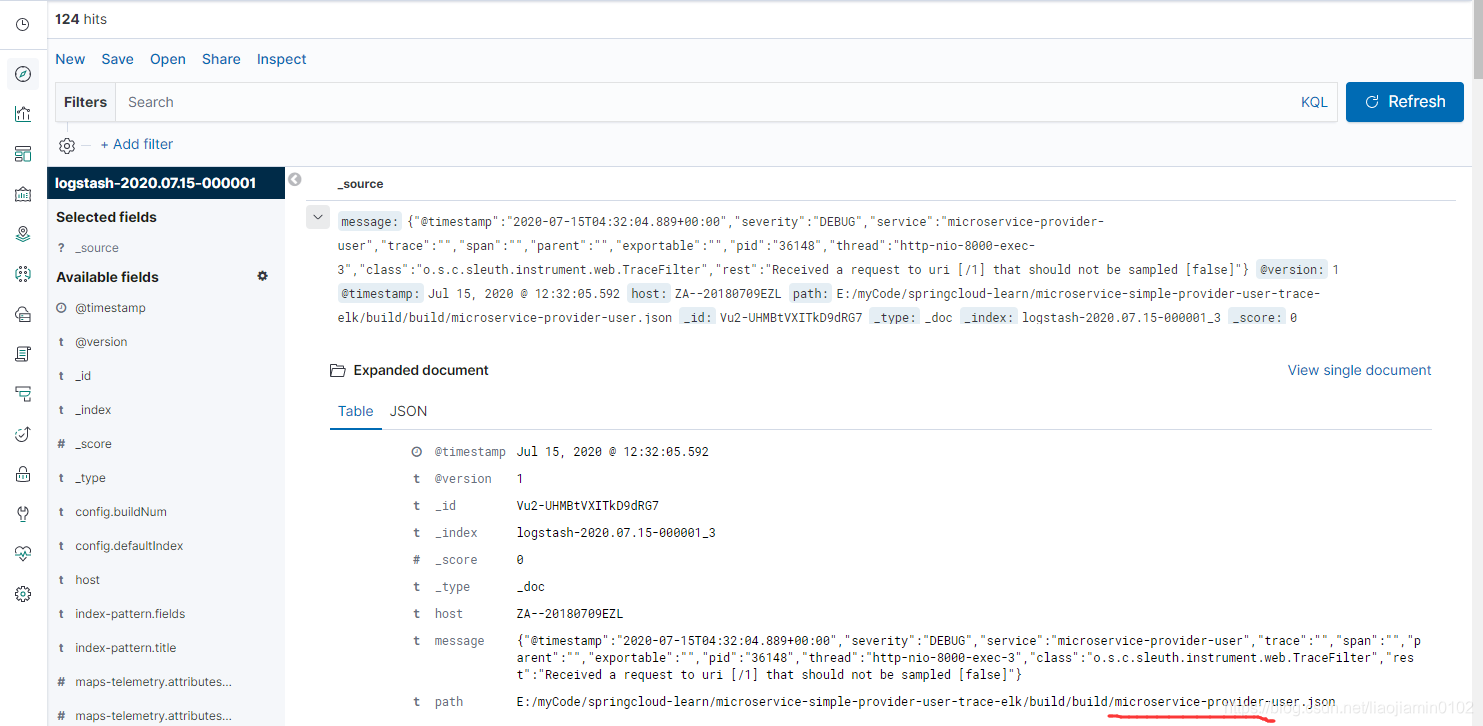

- 接着我们来指定文件的形式来指定输入参数,毕竟我们实际运行的时候一定是读取日志文件中的内容,我们修改刚才复制到bin目录中的logstash.config文件如下:

input {file {path => ["E:/myCode/springcloud-learn/microservice-simple-provider-user-trace-elk/build/build/microservice-provider-user.json"]}

}

output {elasticsearch {hosts => ["http://localhost:9200"]}

}

- 如上图所示,file指定了是文件输入类型,path指定文件地址,是数组类型可以指定多个,此处我们用一个springboot项目的json日志格式来进行测试。

- 再次启动,并启动springboot项目,多次请求,再次查询ES。

logstash 常用命令:

-f:指定logstash的配置文件

-e:格式是后面跟字符串,这个字符串就被当做是logstash的配置;如果"",那么默认使用stdin作为输出,stdout作为输出;

-t:测试配置文件是否正确

logstash -f stdin.conf -t

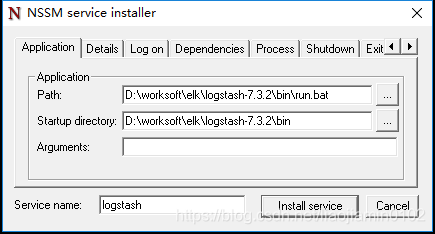

- 以上是通过bat脚本直接运行,接着我们还是用nssm的方式来进行配置,还是和刚才一样的流程

- 将nssm.exe文件拷贝到logstash的bin目录下,在bin目录下创建run.bat并且编辑填入如下信息:

logstash.bat agent -f logstash.conf

- cmd到bin目录下,执行 nssm install logstash,选择刚才创建的run.bat,点击install service,提示安装成功。

安装kibana服务

- 下载解压,这次直接用nssm的方式

- 还是将nssm目录下对应本系统的nssm.exe复制到kibana的bin目录下

- cmd到kibana的bin目录下,执行nssm install kibana,选择bin目录下kibana.bat,点击install service 完成安装

启动项目

- CMD找那个运行services.msc,打开windiws服务,依次启动如下服务:

- Elasticsearch

- Logstash

- Kibana

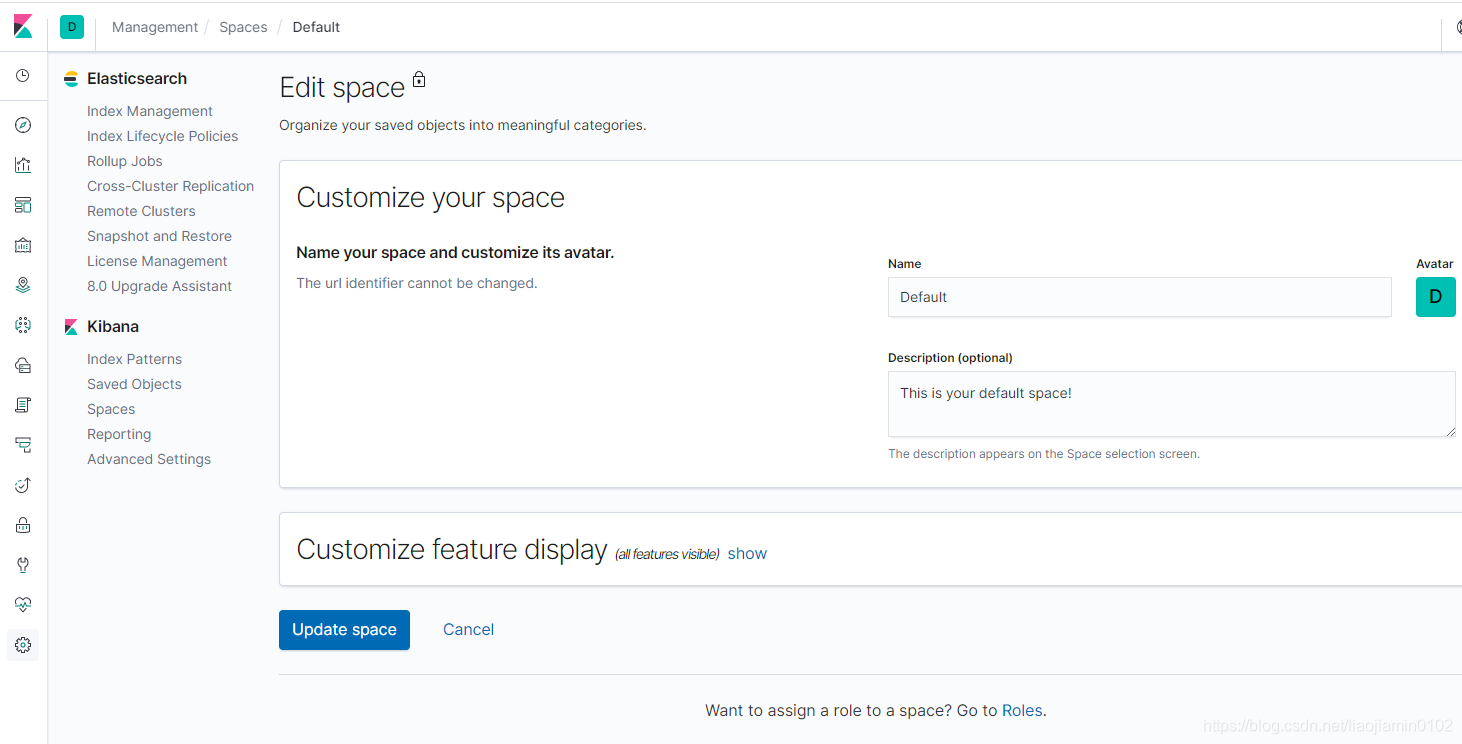

- 在浏览器中输入http://localhost:5601/,可以看到如下界面:

- 上截图界面来配置一个对应es中分配的查询,点击左侧的index patterns,选择es中的分片,我们可以得到如下查询界面:

- 如上图所示,我们将日志文件中的信息通过kibana来进行查询。

- 至此,所有服务安装完成,平台搭建完成,本次只是一个单机,单节点的测试项目,后续的机去部署需要每个软件进行集群配置安装。

![[剑指offer]面试题19:二叉树的镜像](http://pic.xiahunao.cn/[剑指offer]面试题19:二叉树的镜像)

)

![[剑指offer]面试题21:包含min函数的栈](http://pic.xiahunao.cn/[剑指offer]面试题21:包含min函数的栈)

)

![[剑指offer]面试题22:栈的压入、弹出序列](http://pic.xiahunao.cn/[剑指offer]面试题22:栈的压入、弹出序列)

![[剑指offer]面试题23:从上往下打印二叉树](http://pic.xiahunao.cn/[剑指offer]面试题23:从上往下打印二叉树)

![[剑指offer]面试题26:复杂链表的复制](http://pic.xiahunao.cn/[剑指offer]面试题26:复杂链表的复制)

![[剑指offer]面试题28:字符串的排列](http://pic.xiahunao.cn/[剑指offer]面试题28:字符串的排列)

![[剑指offer]面试题31:连续子数组的最大和](http://pic.xiahunao.cn/[剑指offer]面试题31:连续子数组的最大和)

![[剑指offer]面试题34:丑数](http://pic.xiahunao.cn/[剑指offer]面试题34:丑数)