ChatGPT——Chat Generative Pre-trained Transformer

1 文字接龙

- 每次输出一个概率分布,根据概率sample一个答案

- ——>因为是根据概率采样,所以ChatGPT每次的答案是不一样的

- (把生成式学习拆分成多个分类问题)

- 将生成的答案加到原来的句子里面

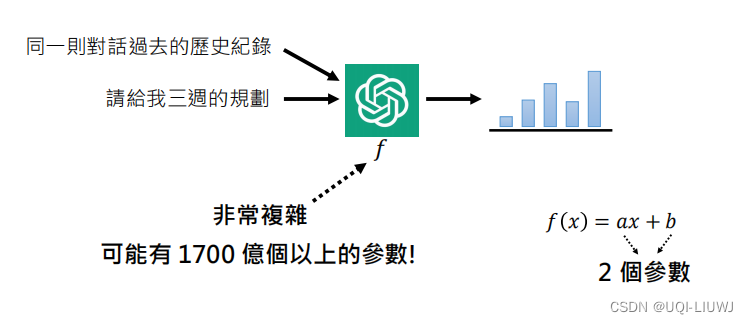

1.1 同时使用同一个会话中之前的互动作为输入

- 模型的输入不止有现在的互动,还有同一会话中过去的互动

- 这里说的1700亿参数是OpenAI GPT3的参数量

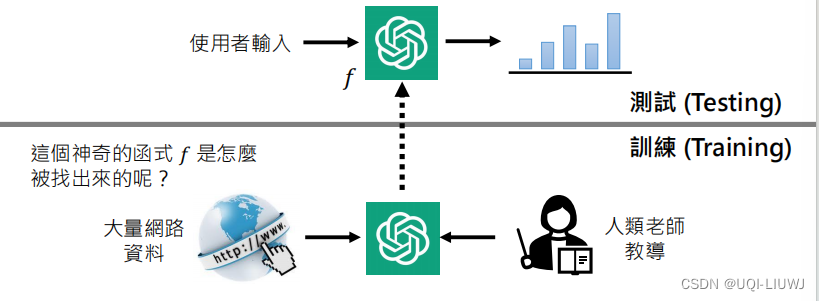

1.2 测试和训练

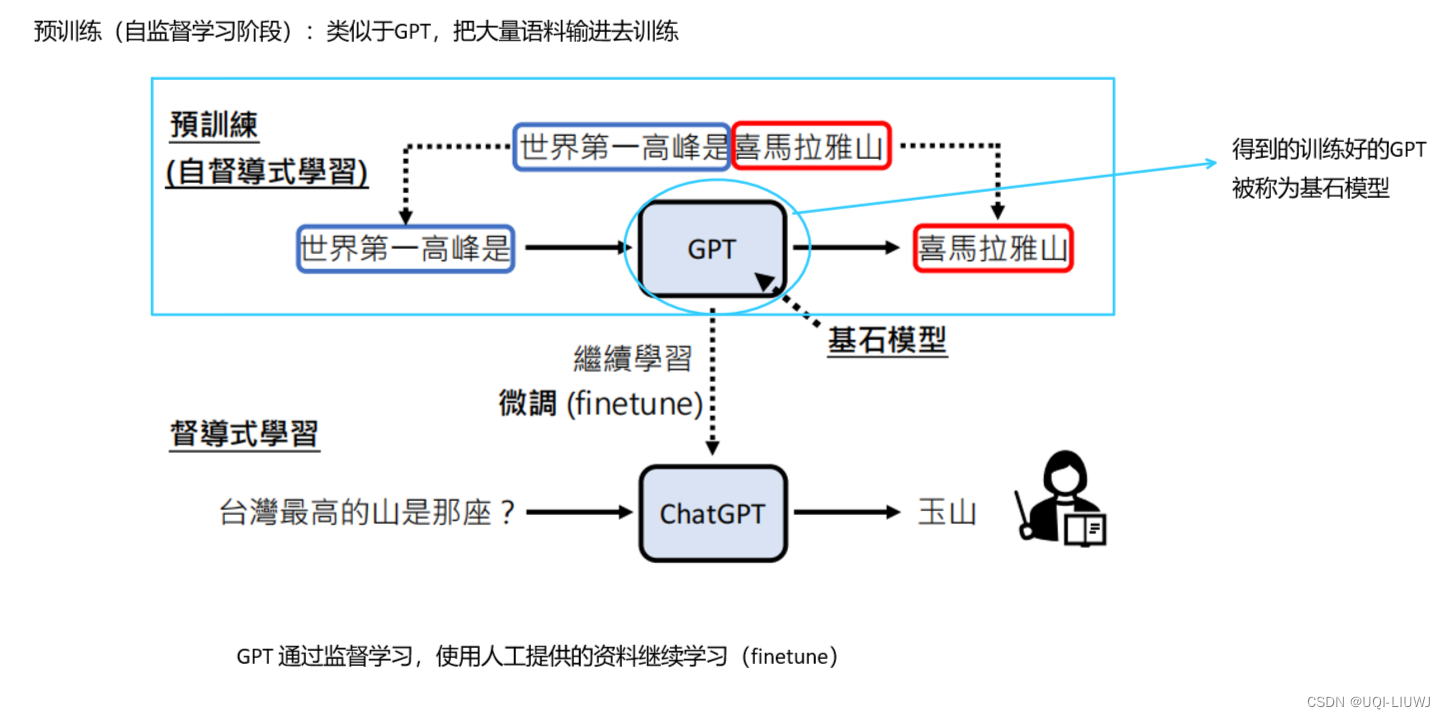

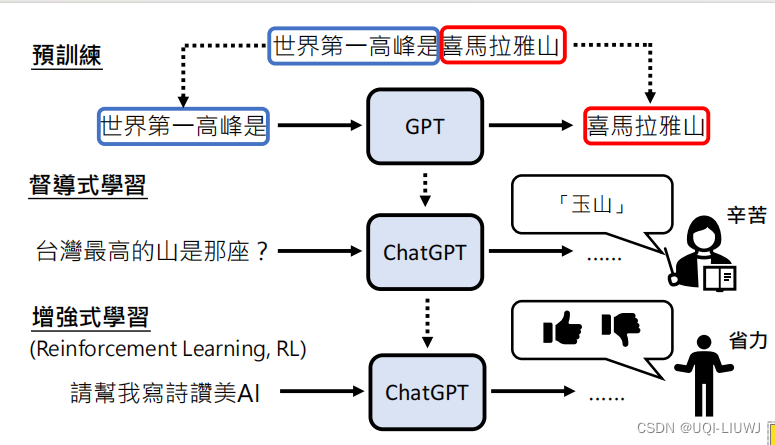

2 背后的技术——预训练

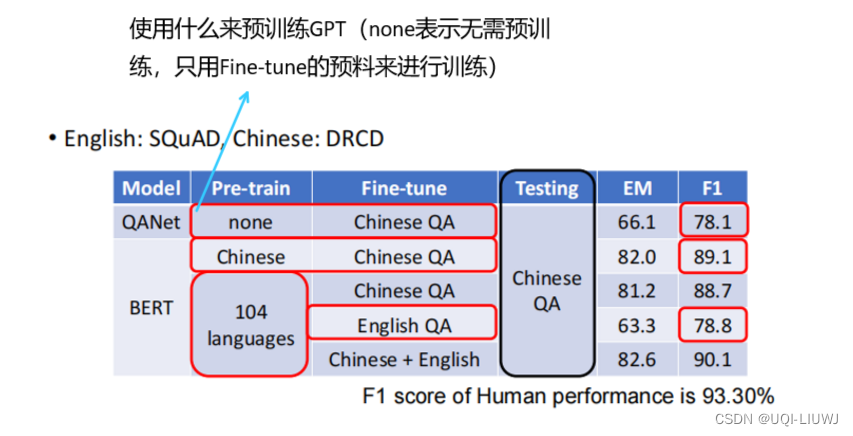

2.1 预训练的帮助(不同语言训练的迁移性)

- 在多种语言上预训练,只需要教某一个语言的某一个任务,其他语言的同样任务可以自动学习

2.2 chatGPT的预训练

- 除了监督学习的Finetune,ChatGPT还使用了强化学习来进行FineTune

- 不直接给他答案,而是给他结论:答案好还是不好

- 相比于监督学习,更省事,更容易收集到更多的资料

- 同时,很多问题人类自己都不知道正确答案(比如创造类的问题,写诗写作文等)

3 ChatGPT带来的研究问题

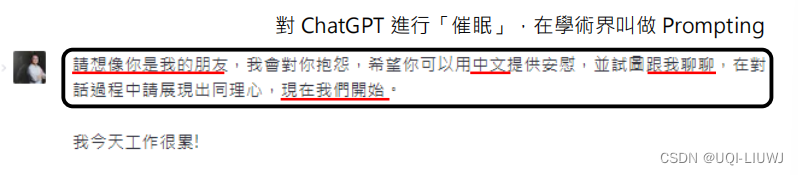

- 精准提出要求(Prompting)

-

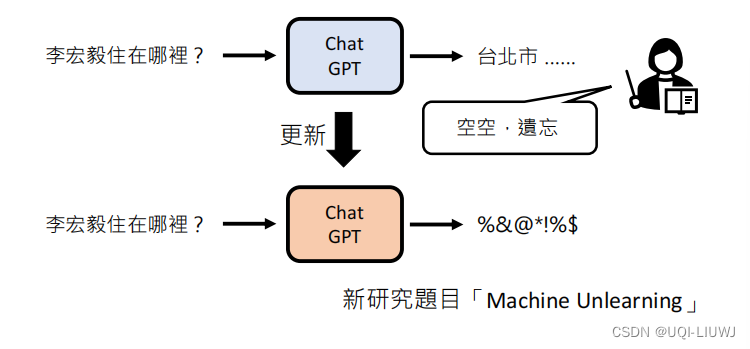

更正错误(neural editing)

-

改一个错误,可能会让很多原来对的地方的回答错误

-

-

- 偵測 AI 生成的物件

-

-

- 一些内容不应该被输出(machine unlearning)

视频来源:【生成式AI】快速了解機器學習基本原理 (2⧸2) (已經略懂機器學習的同學可以跳過這段)_哔哩哔哩_bilibili

)

)

)

)

-订单分页)

:ASCLIN MCAL配置及代码实战)

)