SparkContext: Error initializing SparkContext解决方法

Spark在配置高可用集群中,出现报错

ERROR SparkContext: Error initializing SparkContext. java.net.ConnectException: Call From hadoop102/192.168.10.102 to hadoop102:8020 failed on connection exception: java.net.ConnectException: Connection refused;

这是因为我们配置了Spark日志存储在HDFS中,但是在开启Spark集群后,却没有打开Hadoop,造成提交任务时报错。

解决方案:

- 不再存储事件日志

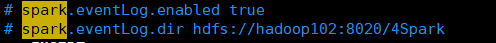

找到Spark安装目录/conf/spark-defaults.conf文件,如图所示,注释掉相应事件日志部分

- 将事件日志存在本地,而非HDFS中

将上图中第二行的目录替换为Linux本地目录 - 启动Hadoop集群(即HDFS服务)

究其出错原因,还是我们配置了spark日志存储于HDFS中,但是缺没有打开HDFS,所以开启Hadoop集群即可

概念数据模型)

文件实时同步)

研发中心”落户高新区)

)