目录

- windows 10 下 搭建 pyspark

- 所需要的工具

- 过程与步骤

windows 10 下 搭建 pyspark

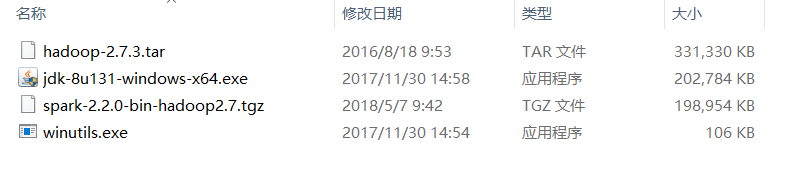

所需要的工具

Java JDK 1.8.0

spark-2.2.0-bin-hadoop2.7

hadoop-2.7.3

winutils.exe

还需要有python环境,我用的是Anaconda 3(默认你已经装好此环境)。

所需工具下载链接

链接:https://pan.baidu.com/s/1e7YQO1UErH9QFQ90pncAeA

提取码:ohv8

过程与步骤

- 安装 Java JDK,这里默认安装就好,一直下一步下一 步,直到完成。

- 解压 Hadoop,Spark,并到所需要的目录下,这两个只需要解压就好,目录不要有中文与空格等字符。

- 配置Java,Spark,Hadoop环境变量。

-

JAVA 环境变量

- 先在用户变量新建,然后变量名为JAVA_HOME,变量名为你的JDK的安装路径如下图。下面的Path,添加 %JAVA_HOME%\bin,这样就设置好啦。

-

Spark 环境变量

- 跟JAVA环境变量设置一样,只不过变量名与路径名要变成SPARK_HOME与你的Spark的路径。

-

Hadoop 环境变量

- 跟JAVA环境变量设置一样,只不过变量名与路径名要变成HADOOP_HOME与你的HADOOP的路径。

详细的配置,请参考下图。

4. 把winutils.exe 复制到hadoop 的bin下,并用管理员打开cmd,跟着现在第二个图操作,利用winutils.exe 修改写入的权限。

winutils.exe chmod 777 C:\tmp\hive

一般都没有什么问题。

- 可能会出现的问题

- ChangeFileModeByMask error (2): ???

- 解决方法

- 在C盘下创建tmp\hive的文件夹

- 如C盘下已经有tmp文件夹了,可以在文件夹下添加hive的文件夹,如下图

修改后再试一下上面winutils.exe的命令。

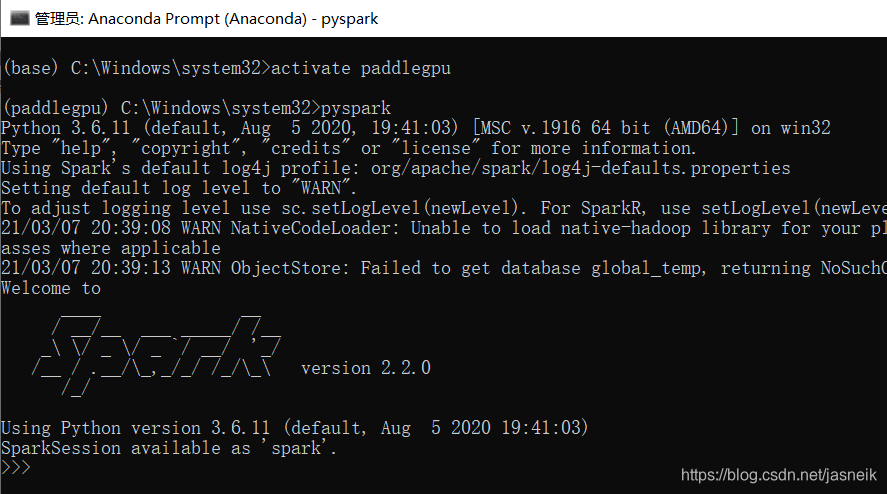

- 修改完后权限后,就是安装pyspark。这里也可以会翻车。因为现在pyspark更新到3.x啦。pip install pyspark 应该是安装最新的。安装完后在终端应该输入pyspark,应该也会SPARK的图案了,如下图。

但是可能用的还是会报如下错误,解决办法,就是安装pyspark对应的版本,后面加的链接是阿里云,这样下载就会快很多。

pip install pyspark=2.2.1 -i https://mirrors.aliyun.com/pypi/simple/

java.util.NoSuchElementException: key not found: _PYSPARK_DRIVER_CALLBACK_HOST

安装完后,应该就没有什么问题啦,运行如下。

C++模板实现)

- 图像复原与重建1 - 高斯噪声)

和call()的区别)

- 图像复原与重建2 - 瑞利噪声)

AF参数“自动调焦”...)

)

- 图像复原与重建3 - 爱尔兰(伽马)噪声)