欢迎关注我的公众号 [极智视界],获取我的更多经验分享

大家好,我是极智视界,本文来介绍一下 算子融合、矩阵分块 一图看懂大模型优化技术FlashAttention。

邀您加入我的知识星球「极智视界」,星球内有超多好玩的项目实战源码下载,链接:https://t.zsxq.com/0aiNxERDq

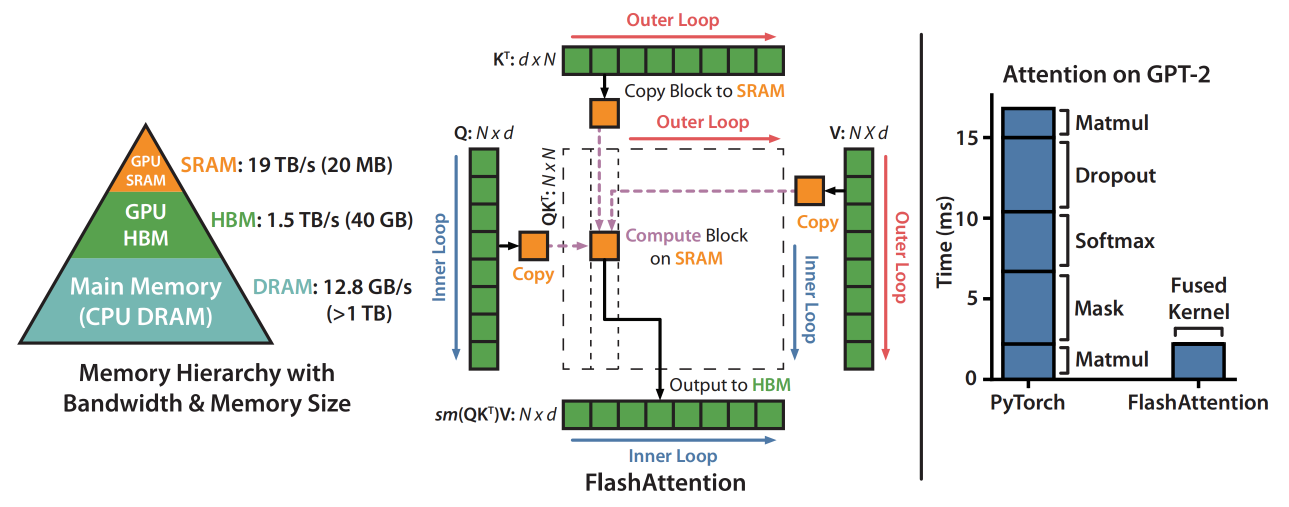

没错没错,就是这个图啦,

所谓一图胜千言,一张好的图对于一个工作的表达很重要,通常能够让人更能直观理解这个工作在做什么。

这里基于这张图,来解读大模型优化技术之 FlashAttention。

先用一句话来总结 FlashAttention 的优化之道:算子融合,矩阵分块,分而治之。

大家知道,基于 Transformer 架构的大模型,在模型推理优化方面已经将以往 CNN 模型的计算密集型 (Compute-Bound) 优化

-k8s存储对象Persistent Volume Claim)