文章目录

- 方法一(推荐)

- 方法二

- 方法三

- 依然存在的问题

由于某些原因,huggingface的访问速度奇慢无比,对于一些模型(比如大语言模型LLM)的权重文件动辄几十上百G,如果用默认下载方式,很可能中断,这里推荐几种方式。

方法一(推荐)

使用镜像站。

我个人比较常用的是:https://hf-mirror.com/

网站地址

这里直接转载一下命令。按照这个方式下载就可以:

1.进入你的虚拟环境,输入:

pip install -U huggingface_hub

2.输入:

export HF_ENDPOINT=https://hf-mirror.com

3.如果你下载的模型是xxx,希望保存在本地的路径是yyy

huggingface-cli download --resume-download --local-dir-use-symlinks False xxx --local-dir yyy

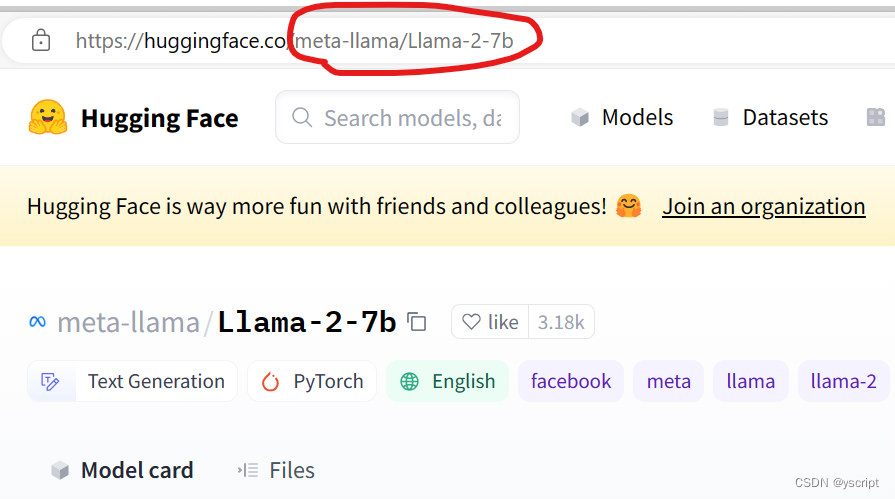

yyy(路径)自行指定,关于xxx(模型名称)怎么确定,这里举一个例子:

网址中的:meta-llama/Llama-2-7b就是模型名称

再举一个例子:

https://huggingface.co/tiiuae/falcon-40b-instruct

模型名称就是tiiuae/falcon-40b-instruct

第三步的下载命令为:

huggingface-cli download --resume-download --local-dir-use-symlinks False tiiuae/falcon-40b-instruct --local-dir ./falcon-40b-instruct

huggingface-cli download --resume-download --local-dir-use-symlinks False tiiuae/falcon-40b-instruct --local-dir ./falcon-40b-instruct

一些其他的问题

有些模型是需要认证或登录的,这个时候你需要在下载命令里面包含你的个人认证密匙。

比如你想使用llama,你首先需要去meta那里申请一个账号并且认证,和你的huggingface绑定后,进行下面的步骤。

下载命令(以llama为例):

huggingface-cli download --token hf_*** --resume-download --local-dir-use-symlinks False meta-llama/Llama-2-7b-hf --local-dir Llama-2-7b-hf

注意这个部分:

--token hf_***

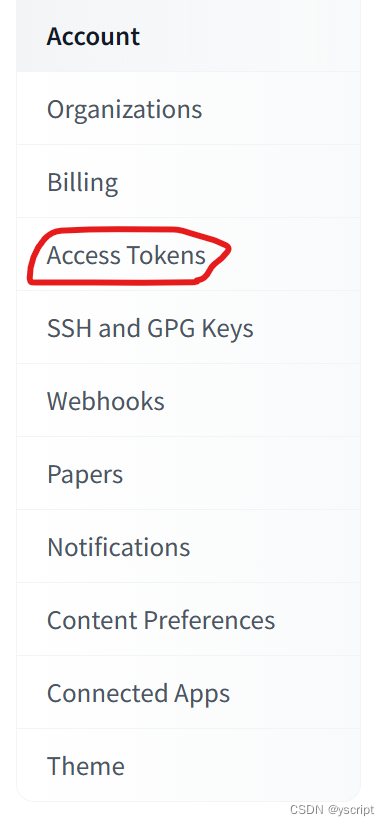

需要把hf_***换成你自己的密匙。密匙的位置在你的个人主页下面。

进入settings:

复制你的一个token到之前的命令里面。

方法二

使用魔法。无需多言。

方法三

试试别的平台。

国内现在有modelscope社区。里面有一部分模型和数据。使用这个社区的话,代码部分也要用它的API。

https://www.modelscope.cn/

网站地址

百度的飞桨也可以找一找。还有网盘资源(可能有好心人下载好了放到百度网盘或者阿里网盘等里面)

依然存在的问题

实际下载的时候发现经常因为模型太大下载终止。有时候用镜像站也是这样,希望懂的朋友一起交流交流。

私有化部署-实现 binlog 中间件适配)

-k8s核心对象CronJob)

)

)