M3VSNET:无监督多度量多视图立体视觉网络(2021年)

- 摘要

- 1 引言

- 2 相关工作

- 3 实现方法

- 3.1 网络架构

B. Huang, H. Yi, C. Huang, Y. He, J. Liu and X. Liu, “M3VSNET: Unsupervised Multi-Metric Multi-View Stereo Network,” 2021 IEEE International Conference on Image Processing (ICIP), Anchorage, AK, USA, 2021, pp. 3163-3167, doi: 10.1109/ICIP42928.2021.9506469.

The code is available at https://github.com/whubaichuan/M3VSNet

摘要

与传统的MVS方法相比,目前采用的基于监督学习的网络的多视图立体匹配(MVS)方法具有显著的性能。然而,用于训练的真实深度图很难获得,而且是在有限的情况下。在本文中,我们提出了一种新的无监督多度量MVS网络,名为M3VSNet,用于没有任何监督的密集点云重建。为了提高点云重构的鲁棒性和完整性,我们提出了一种新的多度量损失函数,该函数结合了像素级和特征级损失函数,从匹配对应的不同角度学习固有的约束条件。此外,我们还在三维点云格式中加入了正常深度的一致性,以提高估计深度图的准确性和连续性。实验结果表明,M3VSNet建立了最先进的无监督方法,在DTU数据集上取得了比以前的监督MVSNet更好的性能,并在坦克和寺庙数据集上证明了强大的泛化能力和有效的改进。

1 引言

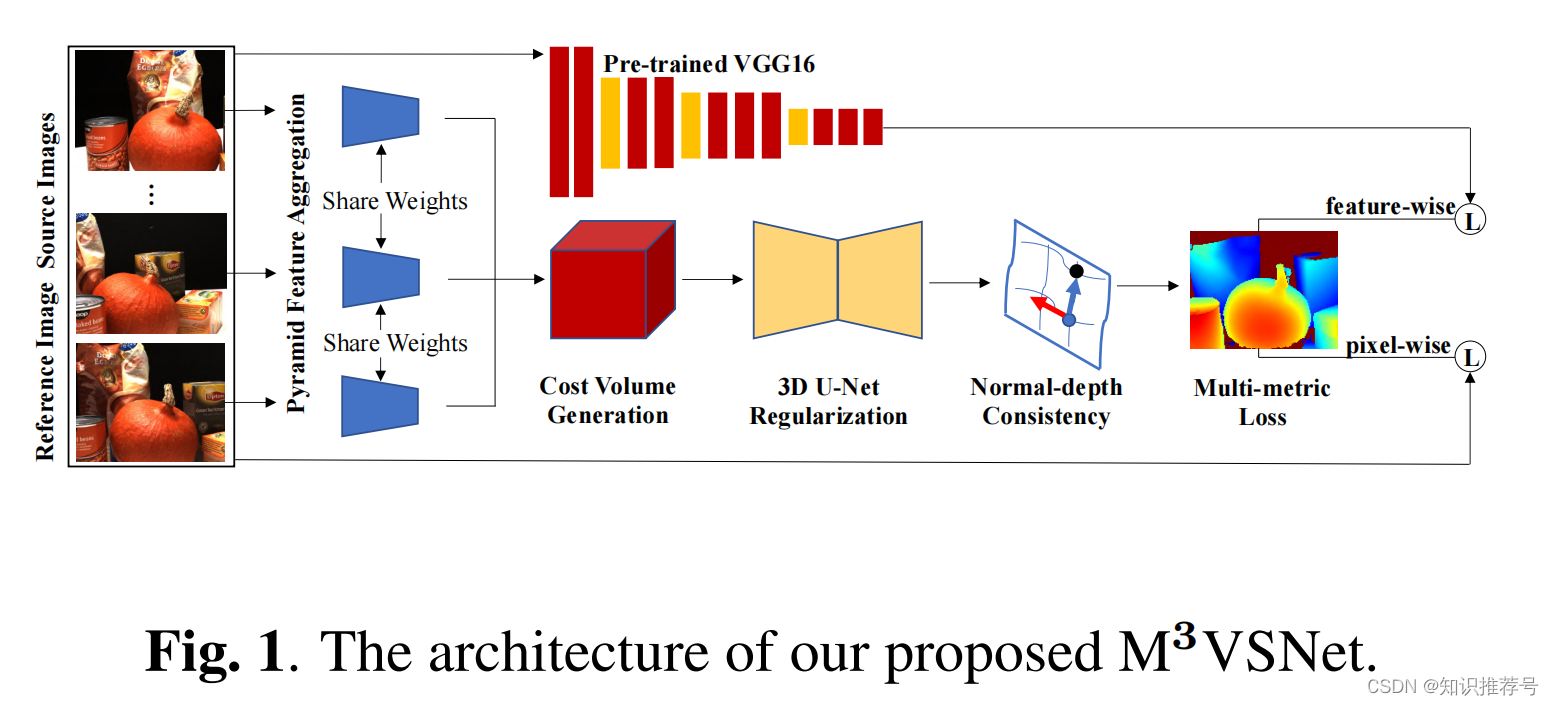

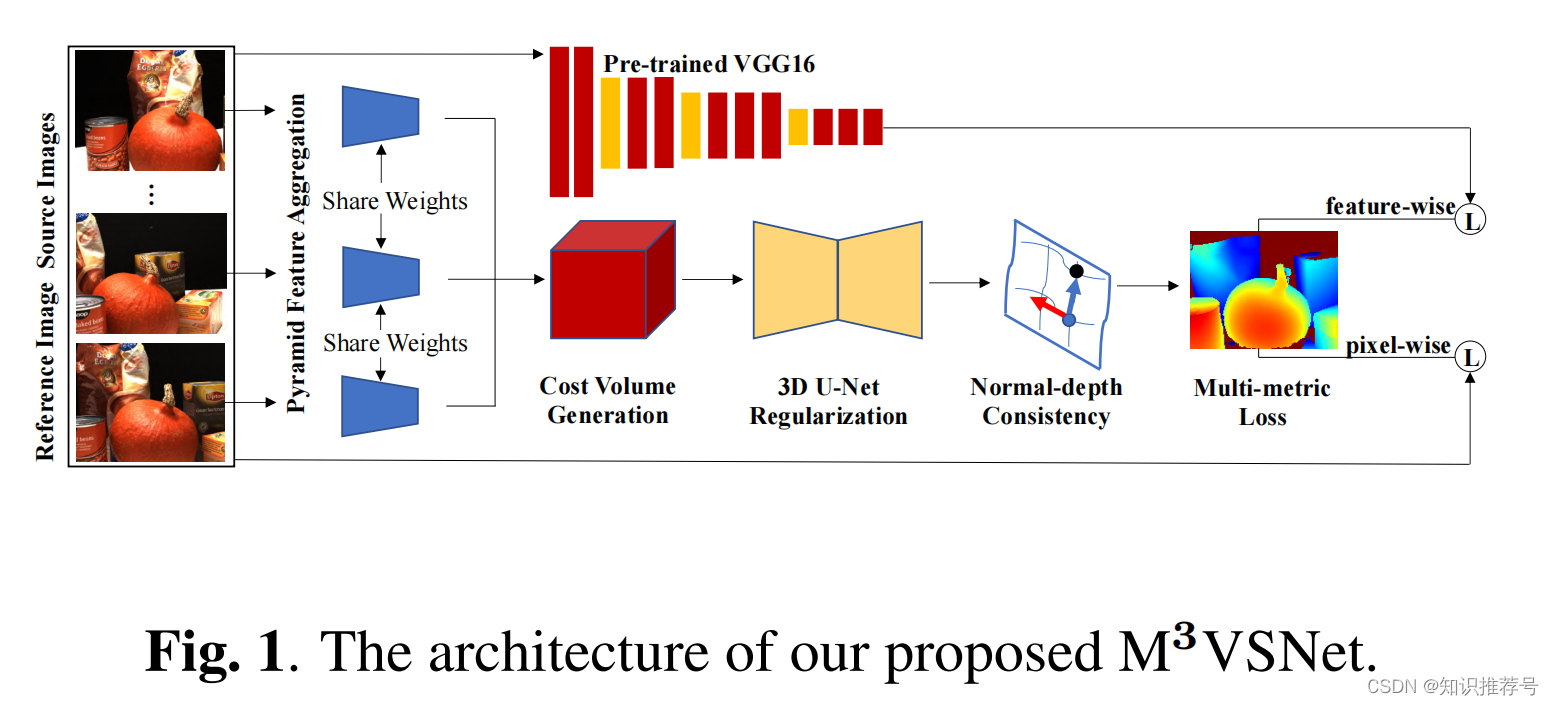

多视图立体视觉(MVS)旨在从多视图图像中重建三维密集点云,在增强现实、虚拟现实和机器人技术等领域有多种应用。传统方法通过手工特征(如NCC)计算匹配对应取得了很大的进展。然而,MVS在大规模环境中的有效和鲁棒的方法仍然是具有挑战性的任务。最近,深度学习被引入来缓解这一限制。基于监督学习的MVS方法取得了显著进展,特别是提高了密集点云重建的效率和完整性。这些基于学习的方法通过学习和推断信息来处理立体视觉对应难以获得的匹配歧义性。然而**,这些基于监督学习的方法强烈地依赖于具有真实深度图的训练数据集。它们的场景种类有限,也不容易获得。因此,这是一个很大的障碍,可能导致在不同复杂场景下的泛化能力差**。此外,密集点云重建的鲁棒性和完整性仍有很大的改进空间。基于学习的方法主要基于像素级水平,这会导致不正确的匹配对应,且的鲁棒性较低。因为对于两个相同的图像,只要从像素水平的角度进行像素偏移,差异可能会很大。然而,从特征水平等感知的角度来看,它们几乎是相同的。因此,本文旨在研究基于学习的MVS的数据独立性、鲁棒性和完整性。在本文中,我们提出了一种新的无监督多度量MVS网络,名为M3VSNet,如图1所示,即使在非理想环境下,它也可以推断出密集点云重建的深度图。最重要的是,我们提出了一种新的多度量损失函数,即像素级和特征级损失函数。关键的见解是,人类的视觉系统通过物体的特征来感知周围的世界。在损失函数方面,可以很好地保证光度和几何匹配的一致性。

具体来说,我们引入了来自预先训练过的VGG16网络的多尺度特征图,作为特征级丢失的重要线索。低级特征表示学习更多的纹理细节,而高级特征学习具有较大的接受域的语义信息。不同层次的特征是对不同的感受域的表现。此外,为了提高深度图的精度和连续性,我们在世界坐标空间中加入法线-深度一致性来约束估计深度图得到的局部表面切线与计算的法线正交。因此,在无纹理、镜面反射或反射和纹理重复区等具有挑战性的场景中,网络可以很好地提高匹配对应的鲁棒性和准确性。

2 相关工作

该领域提出了许多传统的方法,如基于体素的方法[8]、特征点扩散[3]和估计深度图[9]的融合。估计深度图的融合可以将重建解耦为深度估计和融合。单目的视频和双目成对图像的深度估计与多视点立体视觉有许多相似之处。单目视频缺乏实际深度的真实尺度,双目成对图像总是需要对并行的两幅图像进行校正。与单眼视频和双目成对图像相比,多视图遮挡和一致性等障碍提高了多视图立体视觉深度估计的难度。自从Yao Yao在2018年提出MVSNet以来,已经提出了许多基于MVSNet的监督网络。更重要的是,获得真实的深度图非常繁琐。Dai以对称的方式同时预测所有视图的深度图,这消耗了大量的GPU内存。此外,Tejas提出了简化的网络和传统的损失指定,但结果不令人满意。

3 实现方法

3.1 网络架构

M3VSNet的基本架构由三个部分组成,即金字塔特征聚合、基于方差的成本量生成和3D U-Net正则化,如图1所示。

)

(第五版)【读书笔记 + 思考总结】)

:树搜索指定数据域的结点(算法FindTarget))

)