原文参见

Explore open source AI Infra for Large Language Models: Highlights from the Open Source AI Meetup Beijing | Cloud Native Computing Foundation

背景介绍:

最近,在 ChatGPT 的成功推动下,大型语言模型及其应用程序的流行度激增,引发了人们对这些模型背后的技术内部工作的极大兴趣。 为了深入探讨大型语言模型和相关应用背后的基础设施,WasmEdge 在云原生计算基金会(CNCF)的支持下于 7 月 8 日在北京组织了一次开发者聚会。 本次活动汇聚了AI云原生开源社区各个领域的专家和开发者,共同探讨和分析大语言模型开发的生命周期的不同技术。

我们讨论了以下主题

Michael Yuan ——使用 Rust 和 Wasm 构建轻量级 AI 应用程序

CNCF WasmEdge 运行时的创始人 Michael Yuan 探索了利用 WebAssembly (Wasm) 容器基础设施构建大型语言模型 (LLM) 插件。

他概述了当前大语言模型函数和 plugin 的几个关键问题:

- LLM 锁定迫使用户留在单一供应商的生态中。 这限制了灵活性。

- 模型工作流程锁定意味着无法轻松更换分词器或推理引擎等组件。 一切都必须保持在一个整体框架内。

- UI 锁定将 UI/UX 限制为供应商提供的内容,定制空间较小。

- 缺乏对机器输入的支持 - 如今的大语言模型是为具有人工输入的对话模型而构建的。 它们不能很好地处理结构化的、机器生成的数据。

- 大语言模型无法发起对话或主动提供信息。 用户必须驱动所有交互。

现有的开源框架也带来了挑战:

- 即使是基本应用程序,开发者也必须构建和管理基础设施。 无法选择 serverless 方式。

- 一切都依赖于 Python,与 Rust 等编译语言相比,Python 的推理速度很慢。

- 开发者必须编写自定义身份验证和连接器到外部服务(例如数据库)。 这种开销会减慢开发速度。

为了克服这些限制,WebAssembly 和 Serverless 函数是构建轻量级 LLM 应用程序的好方法。 Wasm 提供了启动很快的可移植的运行时,支持多种语言,包括 Rust,它非常适合计算密集型推理。

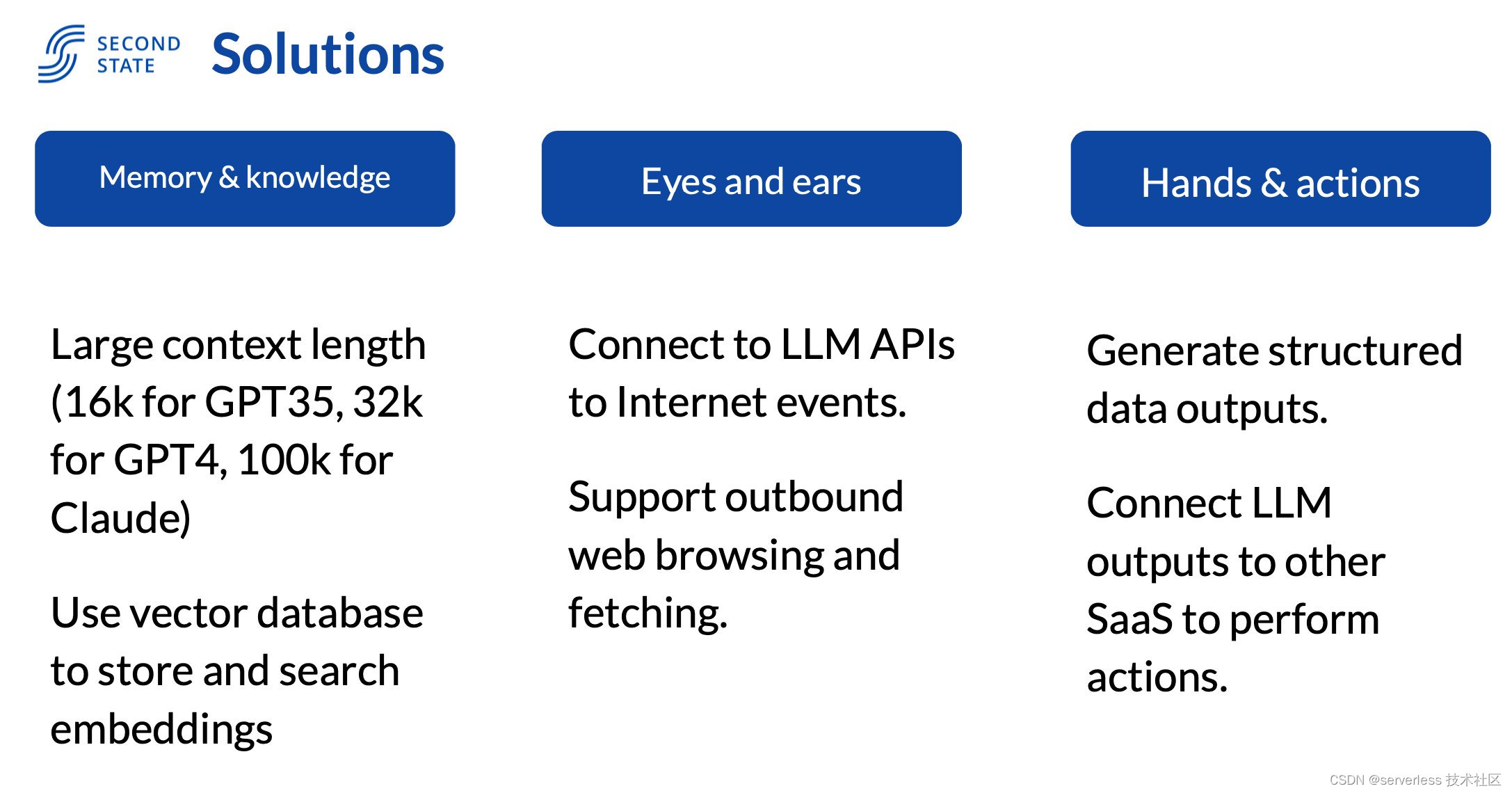

WasmEdge 构建了一个平台 flows.network,允许开发者在 WasmEdge 中的研发管理、DevRel、营销自动化和培训/学习中运行serverless rust 函数,为大语言模型提供记忆、耳朵、双手和行动能力,从而能够用 serverless 的方式在几分钟内实现大模型应用程序。 这可以将开发时间从几个月缩短到几分钟。 它可以实现新一代可定制的垂直大语言模型应用。

通过本次演讲,观众学会了 3 分钟时间内用 flows.network 以serverless方式构建 AI 应用程序。

王方驰 - FATE-LLM:联邦学习遇见大型语言模型

VMware CTO办公室高级工程师、FATE项目维护者王方驰介绍了FATE-LLM,这是一种将联邦学习与大语言模型技术相结合的前瞻性解决方案。 FATE-LLM 允许多个参与者使用其私有数据协作微调大型模型,确保数据隐私,而无需在本地域之外共享数据。 演讲涵盖了将联邦学习应用于 ChatGLM 和 LLaMA 等大型语言模型的最新成果,讨论了技术挑战、设计概念和未来计划。

联邦学习是解决大语言模型数据隐私问题的一种有前途的方法。 联邦学习有助于克服大语言模型的下列挑战:

- 当公共数据耗尽或不足时使用私有数据

- LLM建设和使用过程中维护隐私

FATE-LLM(FATE 联邦大型语言模型)允许参与者使用自己的私有数据微调共享模型,而无需传输原始数据。 这可以使更多组织从大语言模型中受益。

- 多个客户端可以通过FATE内置的预训练模型支持进行横向联邦学习,并使用私有数据进行大规模模型微调;

- 支持30+参与者进行协作训练

李晨——向量数据库:大模型的长期记忆体

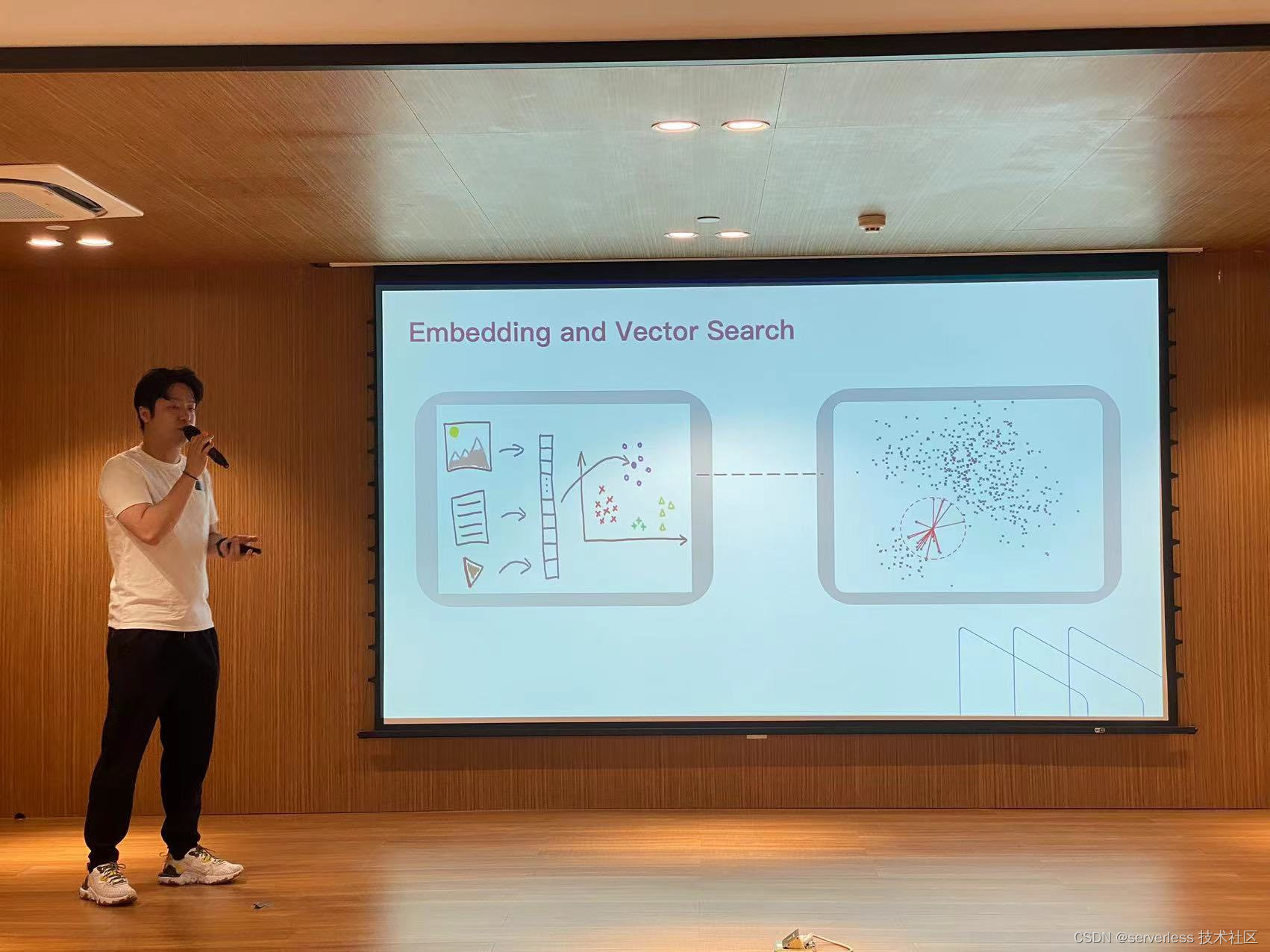

Milvus 运营和生态开发负责人 Li Chen 强调了向量数据库对于构建自定义大型语言模型的组织的重要性。 Milvus 是一个专为云原生环境设计的开源向量数据库。 它采用基于 Kubernetes(K8s)的微服务架构,实现分布式云原生操作。 Milvus 采用存储计算分离的方式,提供弹性可扩展性,允许根据工作负载需求进行无缝扩展和收缩。 其高可用性可确保从故障中快速恢复,通常在几分钟内。

Milvus 的显着能力之一在于它能够处理数十亿个向量,展示了其可扩展性和对大规模应用的适用性。 Milvus 利用消息队列,实现数据的实时插入和删除,保证高效的数据管理。

Milvus 与目前流行的 AI 生态进行了集成,包括 OpenAl、Langchain、Huggingface 和 PyTorch,提供与流行框架和库的无缝兼容。 此外,它还提供了一套全面的生态工具,例如 GUI、CLI、监控和备份功能,为用户提供了强大的工具包来管理和优化 Milvus 部署。

综上所述,Milvus 提供了分布式、云原生向量数据库解决方案,在可扩展性、容错性以及与不同 AI 生态的集成方面表现出色。 其微服务设计与其广阔的生态系统工具相结合,使 Milvus 成为管理大规模 AI 应用程序的强大工具。

张志——开发中模型量化相关的技术实践

张志,商汤模型量化框架工程师, 深入探讨了广泛应用的神经网络量化技术。 演讲重点讨论了大型语言模型中使用的各种量化技术,例如仅权重量化和分组 kv 缓存量化。 讨论了这些技术的应用场景和性能优势,并对服务器上的模型部署、性能优化以及降低存储和计算成本提供了见解。

模型量化和压缩对于部署大型语言模型至关重要,尤其是在资源受限的设备(例如边缘设备)上。OpenPPL团队研发的 PPQ 等工具可以量化神经网络,以减小其尺寸和计算成本,使它们能够在更广泛的硬件上运行。这次演讲干货满满,讲到了很多实际的大模型量化技术细节,张老师的视频发布在B站上后得到了热烈的好评和欢迎。

茶歇提供了披萨和水果:

总结

对于对云原生和人工智能技术无比热情的与会者来说,这次聚会是一次激动人心的活动。 演讲者围绕大型语言模型,深入探讨了作用于大模型的不同开源项目,包括轻量级 AI 应用开发、大型模型联邦学习、向量数据库、模型量化和 LLM 评估。参会的开发者可以获得对这些技术的复杂细节的宝贵见解,使大家能够利用开源云原生和人工智能项目和应用程序之间的协同作用。

总的来说,这次聚会强调了开源技术如何帮助组织构建和应用大型语言模型。 通过共享知识和协作,人工智能和云原生社区可以共同应对推进和产品化新一代人工智能系统所涉及的挑战。

管理 Node.js 版本)

)

,Java)

进行训练及测试))

模型(model)汇总)