引言

今天带来今年的一篇文本嵌入论文GTE, 中文题目是 多阶段对比学习的通用文本嵌入。

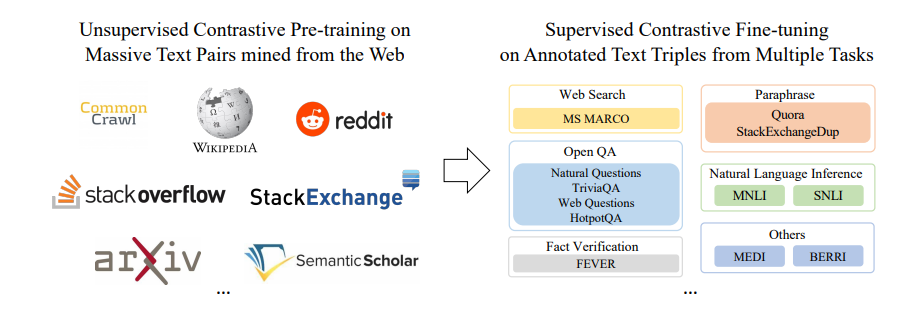

作者提出了GTE,一个使用对阶段对比学习的通用文本嵌入。使用对比学习在多个来源的混合数据集上训练了一个统一的文本嵌入模型,通过在无监督预训练阶段和有监督微调阶段显著增加训练数据量,可以在现有的嵌入模型上取得显著的性能提升。

总体介绍

最近大语言模型(LLM)的兴起引发了对基于文本嵌入模型的检索增强系统的广泛关注。这些模型集成了LLM的推理和理解能力。

开发一个统一的模型来处理多种下游任务的追求一直存在,预训练语言模型的出现进一步为训练这样一个通用模型打开了可能性。然而,在文本表示研究领域中,先前的文本嵌入模型主要集中在特定任务上,它们的训练策略或模型对单一的任务进行了定制,可能在其他情境中表现不佳。例如,SimCSE文本表示模型训练在对称文本对上,对于文本检索任务显示出了局限性。类似地,某些专为稠密检索任务涉及的文本表示模型在句子相似性任务中没有表现出稳健的性能。

近期,研究重点转向于通过无监督对比预训练利用大量无标签网页数据来开发更全面的文本表示模型,结合特定任务的数据、提示或指令来在微调过程中减轻任务冲突。此外,引入了注入大规模文本嵌入基准MTEB,为评估文本表示模型的普适性奠定了坚实基础。

本篇工作作者提出了一个直接的途径来构造一个通用文本嵌入模型,仅在开放数据上使用对比学习,如图所示。<

-23)

![[Linux]文件路径名称含有‘/‘以及‘.‘的书写规则](http://pic.xiahunao.cn/[Linux]文件路径名称含有‘/‘以及‘.‘的书写规则)

)

-纹理材质高级操作)